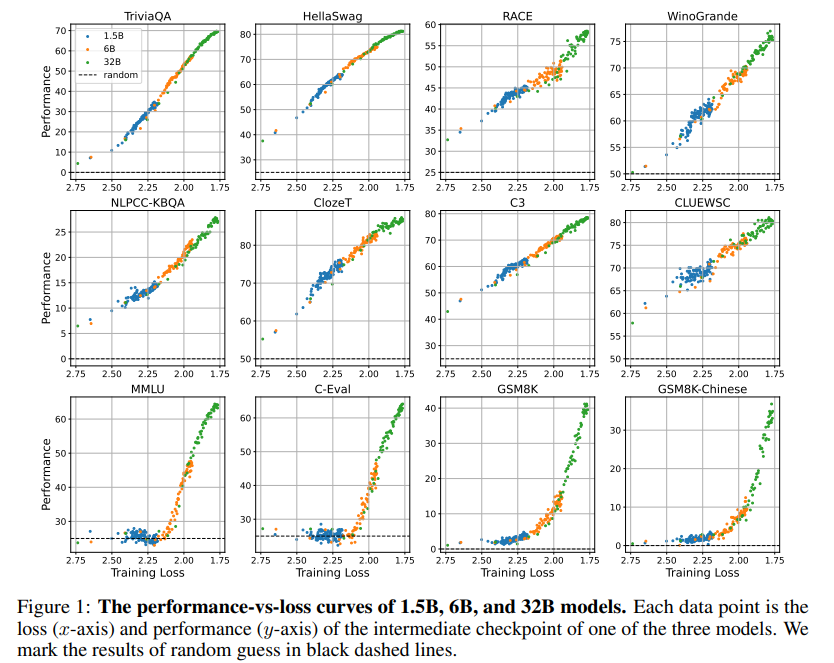

如今的很多研究都表明小模型也能出现涌现能力,本文的作者团队通过大量实验发现模型的涌现能力与模型大小、训练计算量无关,只与预训练loss相关。

作者团队惊奇地发现,不管任何下游任务,不管模型大小,模型出现涌现能力都不约而同地是在预训练loss降低到 2.2 以下后。

在 2.2 之前,模型的表现跟一般模型无异。在 2.2 之后,模型的性能显著上升。

数学建模

模型涌现能力与预训练loss的关系,公式化如下:

{ f ( L ) if L < η 0 otherwise \begin{cases}f(L) & \text { if } L<\eta \\ 0 & \text { otherwise }\end{cases} {

f(L)0 if L<η otherwise

f ( L ) f(L) f(L) 是个单调递减函数, L L L 越大,其值越小。 η \eta η 是个loss阈值,比如 2.2 。

预训练loss与模型大小 N N N 关系如下:

L ( N ) = L ∞ + ( N 0 N ) α N L(N)=L_{\infty}+\left(\frac{N_0}{N}\right)^{\alpha_N} L(N)

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

932

932

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?