在机器学习的世界里,如果要选出一个在表格数据上最具统治力的算法,XGBoost无疑是最有力的竞争者。从Kaggle竞赛的获奖常客,到工业界CTR预估、风控建模的核心引擎,XGBoost凭借其卓越的性能和工程友好性,成为了每个机器学习从业者都必须掌握的利器。

1 介绍

想象一下,你正在解决一个复杂的业务问题:预测用户是否会点击广告。数据包含上百个特征,从用户画像到广告内容,从历史行为到实时上下文。这时候,你需要一个既能处理复杂特征交互,又能快速训练部署的算法。XGBoostt(eXtreme Gradient Boosting)就是为这样的场景而生的。

- 卓越的性能表现:在Kaggle竞赛中,XGBoost帮助参赛者赢得了数百个比赛的冠军。在工业界,从阿里巴巴的广告系统到美国运通的信用评分,XGBoost都是核心算法。

- 工程友好性:原生支持并行计算、自动处理缺失值、内置正则化机制,这些特性让XGBoost在生产环境中更加稳定可靠。

2 从GBDT到XGBoost

要理解XGBoost,我们先从传统的梯度提升决策树(GBDT)说起。

GBDT的核心思想很简单:每次训练一棵新树来修正之前所有树的错误。传统GBDT的目标函数只考虑损失函数: L o s s = ∑ l ( y i , y ^ i ) Loss = \sum l(y_i, \hat{y}_i) Loss=∑l(yi,y^i)

传统GBDT就像一个经验型医生,每次病人来复诊,他根据上次治疗没解决的症状(残差)继续开药,哪里不舒服就对症下药,不问太多其他信息。这种方式通常有效,但容易出现药越开越多、治疗方案越来越复杂的问题。

2.2 XGBoost的改进

XGBoost对传统GBDT进行了三个关键改进,让算法变得更加聪明和稳健。

2.2.1 正则化学习目标

XGBoost的目标函数不仅考虑预测准确性,还加入了模型复杂度的惩罚:

O b j = ∑ l ( y i , y ^ i ) + ∑ [ γ T + 1 2 λ ∣ ∣ w ∣ ∣ 2 ] Obj = \sum l(y_i, \hat{y}_i) + \sum[\gamma T + \frac{1}{2}\lambda||w||^2] Obj=∑l(yi,y^i)+∑[γT+21λ∣∣w∣∣2]

γ \gamma γ控制树的叶子数量(防止树过于复杂), λ \lambda λ提供L2正则化(防止叶子权重过大)。这种结构使得XGBoost在训练过程中不仅追求降低损失函数值(即拟合训练数据),还主动控制模型规模和参数幅度,从而有效减缓过拟合风险。

2.2.2 后剪枝

GBDT通常采用预剪枝策略,即在树的生长过程中设置分裂条件(如最小样本数、最小增益阈值)来提前停止子树的扩展。这种方式虽然可以控制模型复杂度,但可能过早地终止了有效的分裂,影响模型拟合能力。

相比之下,XGBoost采用了后剪枝策略:先根据设定的最大深度或其他条件生成完整的候选树结构,然后再通过计算每个节点分裂所带来的增益进行筛选,决定是否保留该分裂。

G a i n = 1 2 [ G L 2 H L + λ + G R 2 H R + λ − G 2 H + λ ] − γ Gain = \frac{1}{2}[\frac{G_L^2}{H_L+\lambda} + \frac{G_R^2}{H_R+\lambda} - \frac{G^2}{H+\lambda}] - \gamma Gain=21[HL+λGL2+HR+λGR2−H+λG2]−γ

其中:

- G L G_L GL, G R G_R GR是左子树和右子树的梯度和

-

H

L

H_L

HL,

H

R

H_R

HR是对应的Hessian和

- Hessian是损失函数关于预测值的二阶导数,在XGBoost中用于刻画误差的变化趋势,帮助模型更精细地评估分裂点的优劣。

- G G G, H H H是父节点的梯度和与Hessian和

- λ \lambda λ 是L2正则项;

- γ \gamma γ 是最小分裂增益阈值。

当某一节点的分裂增益 G a i n < 0 Gain < 0 Gain<0时,表示该分裂不能带来足够的损失下降,将被剪除。这种策略允许模型在构建初期充分探索更丰富的结构,然后再通过统一评估进行简化,从而在表达能力与模型复杂度之间取得更优的平衡。

2.2.3 二阶优化

传统GBDT只使用损失函数的一阶导数(梯度)信息。XGBoost则使用二阶Taylor展开,同时利用一阶梯度 g i g_i gi和二阶梯度 h i h_i hi,就像一个既知道方向又知道地形陡峭程度的专业向导。

l ( y i , y ^ i ( t − 1 ) + f t ( x i ) ) ≈ l ( y i , y ^ i ( t − 1 ) ) + g i ⋅ f t ( x i ) + 1 2 h i ⋅ f t 2 ( x i ) l(y_i, \hat{y}_i^{(t-1)} + f_t(x_i)) \approx l(y_i, \hat{y}_i^{(t-1)}) + g_i \cdot f_t(x_i) + \frac{1}{2}h_i \cdot f_t^2(x_i) l(yi,y^i(t−1)+ft(xi))≈l(yi,y^i(t−1))+gi⋅ft(xi)+21hi⋅ft2(xi)

这种二阶信息让模型能够更精确地判断每一步该走多远,收敛更快,精度更高。

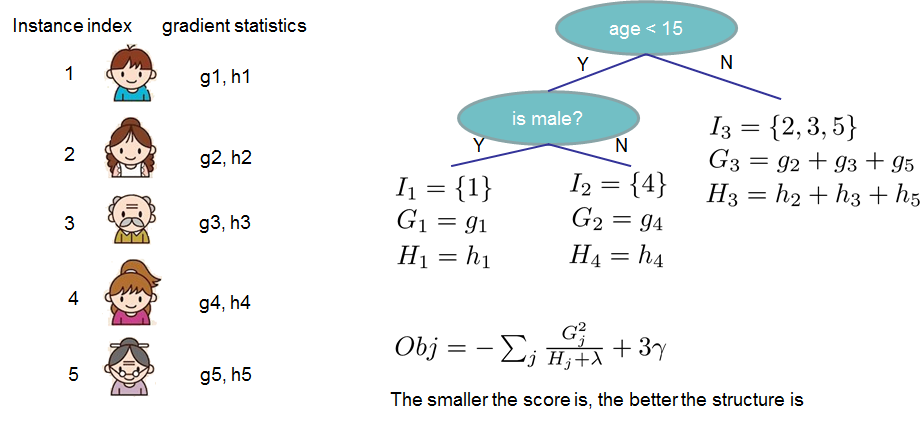

上图展示了XGBoost的核心创新:每个样本不仅提供梯度信息gi,还提供Hessian信息hi。在树的每个节点上,XGBoost通过计算梯度和G与Hessian和H来评估分裂质量,使用目标函数直接指导树的构建过程。这种基于统计量的优化方式是XGBoost相比传统GBDT的关键优势。

3 核心参数详解与调优策略

理解了XGBoost的理论基础后,掌握参数调优是实际应用的关键环节。接下来就了解一下XGBoost的参数体系和调优策略。

3.1 参数

XGBoost的参数可以分为四个核心类别,每个类别控制模型的不同方面:

| 参数类别 | 作用目标 | 核心参数 | 调优重点 |

|---|---|---|---|

| 树结构控制 | 控制单棵树的复杂度 | max_depth, min_child_weight, gamma | 防止过拟合,控制模型容量 |

| 学习过程控制 | 控制整体学习过程 | learning_rate, n_estimators | 收敛速度与最终性能平衡 |

| 正则化控制 | 防止过拟合 | reg_alpha, reg_lambda | 提升泛化能力 |

| 采样控制 | 增加训练随机性 | subsample, colsample_bytree | 提升模型鲁棒性 |

3.1.1 树结构控制参数

这类参数直接影响每棵决策树的形状和复杂度,是控制过拟合的第一道防线。

max_depth(树的最大深度):限制每棵树的最大深度,防止树过于复杂

-

取值建议:3-10,数据简单时用3-6,复杂场景用6-10;从6开始,过拟合时减小,欠拟合时增大

-

注意:

max_depth与max_leaves不能同时设置。max_depth限制深度,max_leaves限制叶节点数量。

min_child_weight(叶节点最小权重和):叶节点所需的最小样本权重和,控制叶节点的细粒度

- 含义:回归任务等同于最小样本数,分类任务中样本权重为1时也表示最小样本数

- 取值建议:1-10,数据量大时可以设更大值;过拟合时增大该值,让模型更保守

gamma(最小分裂损失):节点分裂所需的最小损失减少值,只有收益大于此值才分裂

- 取值建议:0-5,通常从0开始;模型过拟合时逐步增大

3.1.2 学习过程控制参数

这类参数控制多棵树之间的协作方式和整体学习节奏。

learning_rate(学习率):控制每棵树对最终预测的贡献度,相当于步长

- 取值建议:0.01-0.3,调优阶段用0.1-0.3,最终训练用0.01-0.05;较小的学习率需要更多树,但通常性能更好

n_estimators(树的数量):指定要构建的树的总数量

- 取值建议:100-10000,取决于学习率和数据复杂度;配合early stopping让模型自动确定最优树数

3.1.3 正则化参数

正则化参数通过惩罚模型复杂度来提升泛化能力。

reg_alpha(L1正则化系数):对叶节点权重施加L1正则化,产生稀疏模型

- 适用场景:高维特征且存在很多无关特征时

- 取值建议:0-10,通常从0开始

reg_lambda(L2正则化系数):对叶节点权重施加L2正则化,防止权重过大

- 取值建议:1-10,默认为1;过拟合时增大该值

3.1.4 采样参数

通过随机采样增加模型的多样性和鲁棒性。

subsample(行采样比例):每棵树训练时使用的样本比例,进行行采样

- 取值建议:0.5-1.0,通常设为0.8-0.9

- 效果:防止过拟合,增加模型随机性

colsample_bytree(列采样比例):每棵树训练时使用的特征比例,进行列采样

- 取值建议:0.5-1.0,通常设为0.8-1.0

- 效果:类似随机森林的特征采样,增加多样性

3.1.5 其他重要参数

| 参数名 | 作用 | 取值建议 | 使用场景 |

|---|---|---|---|

scale_pos_weight | 处理类别不平衡,给正样本赋予更高权重 | 负样本数/正样本数 | 二分类不平衡 |

max_delta_step | 限制每次权重更新的最大幅度 | 0-10,通常为1 | 极不平衡数据 |

colsample_bylevel | 每层节点的特征采样比例 | 0.5-1.0 | 增加随机性 |

colsample_bynode | 每个节点的特征采样比例 | 0.5-1.0 | 更细粒度控制 |

gpu_id | 指定使用的GPU设备ID | 0,1,2… | GPU训练 |

tree_method(树构建方法):'exact'(精确贪心)、'hist'(直方图)、'gpu_hist'(GPU直方图)

- 大数据集使用

'hist',速度更快且对稀疏数据友好;GPU环境建议首先尝试'gpu_hist',在1000万+样本上速度提升明显

n_jobs(并行线程数):指定训练时使用的CPU核心数

- 取值建议:-1(使用所有核心)或根据机器配置设定

eval_metric(评估指标):训练过程中监控的评估指标,常用选项包括'rmse'(回归)、'logloss'(分类)、'auc'(分类)

3.2 调优策略

3.2.1 参数调优流程

遵循三阶段策略:

第一阶段:粗调核心参数

- 固定

learning_rate=0.1,n_estimators=100 - 调优树结构参数:

max_depth(3-10),min_child_weight(1-6) - 调优正则化参数:

reg_alpha,reg_lambda

第二阶段:细调采样参数

- 基于第一阶段最优参数

- 调优采样参数:

subsample和colsample_bytree(0.6-1.0) - 针对特定问题调整

scale_pos_weight等专用参数

第三阶段:最终优化

- 降低

learning_rate至0.01-0.05 - 相应增加

n_estimators,配合early stopping - 进行最终的性能验证

graph TD

A[开始调优] --> B[第一阶段:粗调核心参数]

B --> B1[固定learning_rate=0.1]

B1 --> B2[调优max_depth, min_child_weight]

B2 --> B3[调优reg_alpha, reg_lambda]

B3 --> C[第二阶段:细调采样参数]

C --> C1[调优subsample, colsample_bytree]

C1 --> C2[调整特定场景参数]

C2 --> D[第三阶段:最终优化]

D --> D1[降低learning_rate至0.01-0.05]

D1 --> D2[增加n_estimators + early stopping]

D2 --> E[完成调优]

3.2.2 特征重要性评估

XGBoost提供三种特征重要性评估方式,各有侧重:

| importance_type | 含义 | 优势 | 适用/局限 |

|---|---|---|---|

gain(推荐) | 每个特征在所有分裂中平均带来的损失减少量 | 直接反映特征对模型预测能力的贡献 | 特征选择、业务解释 |

cover | 每个特征进行分裂时覆盖的样本数量 | 反映特征的影响广度 | 了解特征的使用范围 |

weight | 每个特征在所有树中被选择分裂的总次数 | 简单直观 | 不考虑分裂质量,可能高估简单特征 |

最佳实践:优先使用gain作为主要评估指标,结合cover了解特征影响范围。

4. 实战应用问题

掌握了参数调优的理论基础后,本章将结合具体的业务场景,介绍XGBoost的实战应用技巧和常见问题的解决方案。

4.1 典型应用场景

4.1.1 CTR预估场景

点击率(CTR)预估是XGBoost的经典应用场景,具有类别极不平衡、特征维度高且稀疏、需要处理大量类别特征等特点。

类别不平衡处理

在CTR预估中,正样本(点击)数量远少于负样本(未点击),XGBoost提供了几种关键的解决方案:

scale_pos_weight参数:给正样本赋予更高的权重,通常设置为负样本数量与正样本数量的比值。该参数会在计算梯度时让正样本在损失函数中获得更大的影响力。max_delta_step参数:限制每次权重更新的最大幅度,防止在极不平衡数据中出现权重异常值,通常设置为1。tree_method='hist':使用直方图算法进行树构建,对稀疏数据更加友好,训练速度也更快。

时间特征工程

时间特征在CTR预估中特别重要,需要重点关注:

- 基础时间特征:提取小时、星期几、月份等信息,捕获用户行为的周期性模式

- 周期性特征编码:使用正弦/余弦编码表示时间的周期性,如将24小时转换为圆形特征

- 业务时间特征:结合具体业务定义节假日、促销期等特殊时间段

4.1.2 排序任务场景

Learning to Rank是XGBoost在推荐系统、搜索引擎等场景的重要应用,关注样本间的相对顺序而非绝对值。

关键技术要点

- 数据组织方式:数据需要按查询(query)进行分组,通过

set_group方法指定每个查询包含的样本数量 - 目标函数选择

rank:pairwise:基于样本对的排序方法rank:ndcg:直接优化NDCG指标rank:map:优化MAP指标

- 评估指标:使用NDCG@K、MAP@K等关注排序质量的指标

实际应用注意事项

- 特征质量优先:重点关注能够区分不同相关性等级的特征,如文本匹配度、历史点击率等

- 样本不平衡处理:通过采样策略或权重调整处理不同相关性等级的样本不平衡问题

- 在线服务优化:需要在模型复杂度和预测精度之间做权衡,满足延迟要求

4.2 过拟合问题

4.2.1 问题识别

问题识别

- 训练集和验证集评估指标差距超过5%

- 训练集性能持续提升但验证集性能下降或停滞

解决策略

- 增加正则化:提高

reg_lambda和reg_alpha的值 - 降低复杂度:减小

max_depth,增大min_child_weight和gamma - 增加随机性:降低

subsample和colsample_bytree的值 - 早停机制:使用

early_stopping_rounds参数 - 特征选择:移除噪声特征和冗余特征

4.3 数据泄露问题

4.3.1 常见泄露场景

| 泄露类型 | 表现 | 原因 | 排查方法 |

|---|---|---|---|

| 目标编码泄露 | 验证集AUC异常高($>$0.95) | 用全量数据计算目标变量统计特征 | 检查是否在数据分割前进行特征工程 |

| 时间序列泄露 | 时间序列验证性能远低于随机验证 | 使用未来信息构造历史特征 | 确认所有特征构造时间窗口的合理性 |

| 统计特征泄露 | 某些统计特征重要性异常高 | 统计范围包含了测试集数据 | 验证统计特征的计算边界 |

4.3.2 预防措施

严格数据划分:在特征工程之前先进行数据划分

# 伪代码,省略导包与数据读取

import pandas as pd

# 正确的数据处理流程

def safe_feature_engineering(data, train_idx, test_idx):

# 1. 先分割数据

train_data = data.iloc[train_idx]

test_data = data.iloc[test_idx]

# 2. 仅在训练集上计算统计量

stats = train_data.groupby('category')['target'].agg(['mean', 'std'])

# 3. 分别应用到训练集和测试集

train_encoded = train_data.merge(stats, on='category', how='left')

test_encoded = test_data.merge(stats, on='category', how='left')

return train_encoded, test_encoded

时间序列验证:确保训练数据时间早于测试数据留出验证集:保留最终验证数据,不参与模型选择和特征工程

4.4 类别特征处理

4.4.1 编码方式选择

编码方式选择矩阵

| 特征特点 | 推荐编码 | 优势 | 注意事项 |

|---|---|---|---|

| 低基数有序 | 标签编码 | 简单高效 | 确保顺序合理 |

| 低基数无序 | 独热编码 | 避免虚假顺序 | 注意维度爆炸 |

| 高基数 | 目标编码 | 效果好 | 严防过拟合 |

| 超高基数 | 频率编码+分组 | 控制维度 | 合理设定分组阈值 |

4.4.2 高基数特征处理

- 频率编码:根据类别出现频次编码

- 分组编码:将低频类别合并为"其他"类别

- 嵌入编码:使用预训练嵌入向量表示类别

# 伪代码,省略导包与数据读取

import pandas as pd

def handle_high_cardinality(series, threshold=100):

"""处理高基数类别特征"""

value_counts = series.value_counts()

# 低频类别合并为'others'

low_freq_values = value_counts[value_counts < threshold].index

series_processed = series.copy()

series_processed[series_processed.isin(low_freq_values)] = 'others'

return series_processed

4.5 性能优化

4.5.1 内存优化

数据类型优化:根据数值范围选择合适的数据类型(int8、int16等)

# 伪代码,省略导包与数据读取

import pandas as pd

def optimize_dtypes(df):

"""自动优化数据类型,减少内存占用"""

for col in df.columns:

if df[col].dtype == 'int64':

if df[col].min() >= 0 and df[col].max() < 255:

df[col] = df[col].astype('uint8')

elif df[col].min() >= -128 and df[col].max() < 127:

df[col] = df[col].astype('int8')

# 继续其他整型优化...

return df

- 稀疏矩阵:对高维稀疏数据使用

scipy.sparse格式 - 分批处理:超大数据集采用增量学习或分批训练

4.5.2 训练速度优化

树构建方法:使用tree_method='hist'替代'exact'方法

# 伪代码,省略导包与数据读取

import xgboost as xgb

speed_params = {

'tree_method': 'hist', # 使用直方图算法

'grow_policy': 'lossguide', # 损失导向的树生长策略

'max_leaves': 255, # 限制叶节点数量

'n_jobs': -1 # 充分利用多核CPU

}

- 并行计算:合理设置

n_jobs参数利用多核处理器 - 特征预排序:对重复使用的数据集预先排序

- 减少评估频率:降低

eval_metric的计算频率

5 总结

XGBoost作为梯度提升决策树的代表性算法,通过二阶优化、正则化学习目标、后剪枝策略等创新,在理论和实践层面都实现了显著突破。在表格数据建模领域,XGBoost相比深度学习模型通常表现更好,训练速度更快,资源要求更低,部署更简单。

602

602

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?