最近在使用LGBM包的时候,发现没有办法使用。出现了bug。一查发现是因为我的PySpark是3.5.4,Scala是2.13版本,版本过高。需要分别降级到3.4.4和2.12。

首先,从官网下载对应的PySpark和Scala版本,下面的链接就是PySpark3.4.4和Scala2.12版本的安装包:

https://archive.apache.org/dist/spark/spark-3.4.4/spark-3.4.4-bin-hadoop3.tgz

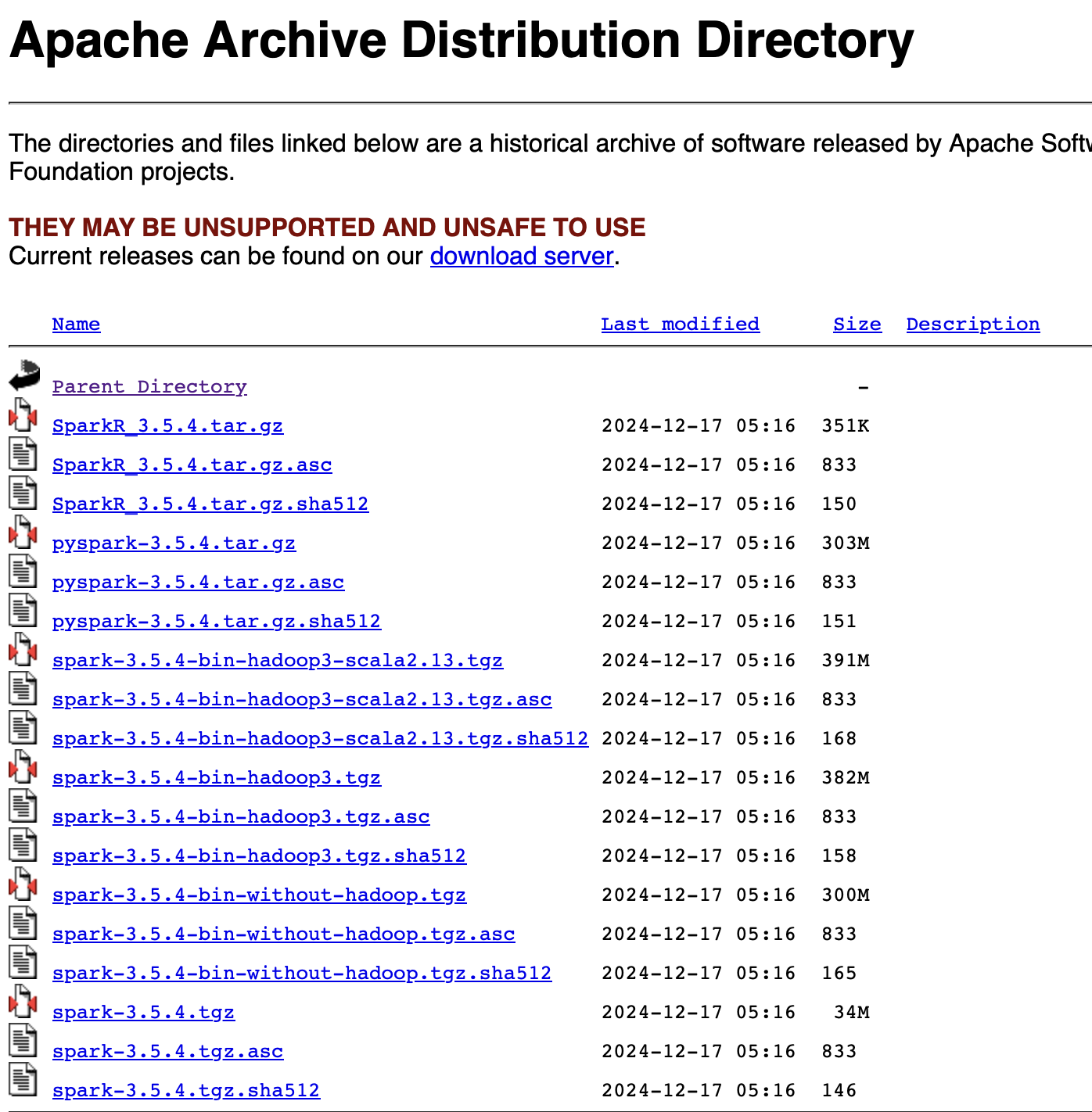

官网的图大概是这样:

需要注意,有的浏览器,比如Safari,在下载完成后,会自动把tgz解压,变为tar格式。我们不能让它这么做。后来我使用了从微信电脑版打开链接的方式,规避了这个问题。

下载完成后,把这个tgz移动到绝对路径/opt/module下面。

mv /data/lab/spark-3.5.4-bin-hadoop3-scala2.13.tgz /opt/module这里我用的是自己的路径。

然后删掉原来的文件夹:

rm -r spark-3.5.4-bin-hadoop3-scala2.13解压tgz:

tar -xzf spark-3.5.4-bin-hadoop3-scala2.13.tgzxzf分别表示解压(extract),通过gz解压,文件名(file name)。

722

722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?