笔者在ChatGPT初期就开始关注和使用大模型,在日常工作生活中也折腾了不少小玩具,使用的大模型主要是Openai的GPT系列和谷歌的Gemini-Pro以及一些国内厂商的模型。客观说,Openai的模型遥遥领先,而国内那帮的模型只能说挡性十足。但随着Openai开始大规模封禁不支持区域的账号后,笔者的两个账号也未能幸免,只能靠Gemini-Pro苦苦支撑,虽然可以将就着用,但总觉得别别扭扭。

看起来是开启一段新的AI之旅了。没错,笔者找到了一个更能打的方案:Ollama+LobeChat,完全基于个人PC平台,本地部署开源大模型,配合GUI客户端,体验值直接拉满!

🎭 Ollama&LobeChat简介

Ollama

Ollama是一个开源的大模型托管和服务平台,可以在Windows、macOS、Linux或Docker中安装,并提供便利的模型下载、推理等功能,简直把大模型的落地做到了0基础即可入手的地步。项目的Logo就是下面的这只可爱的小羊驼。

LobeChat

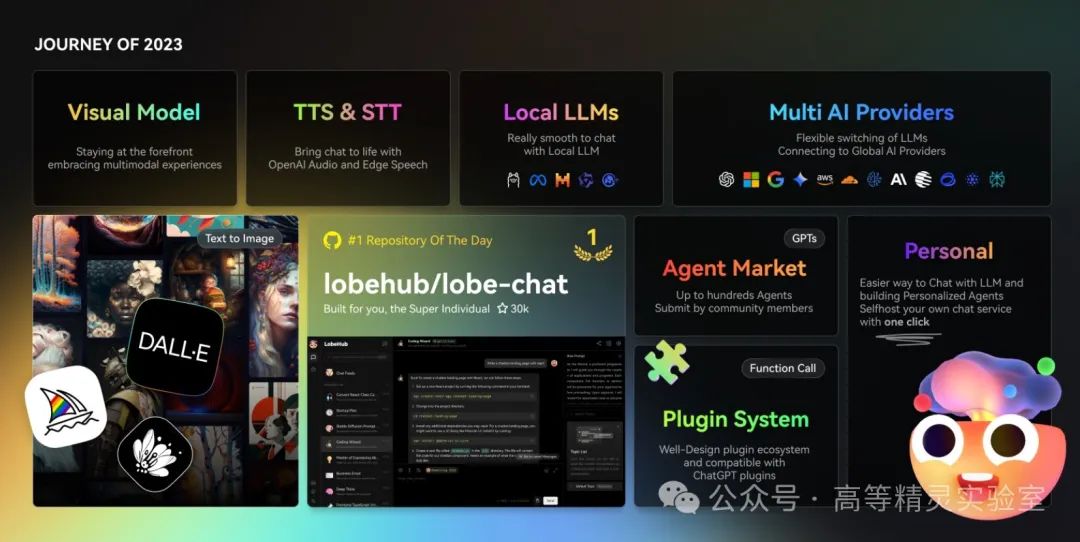

说起来LobeChat是与NextChat几乎同期起步的大模型客户端项目,二者也先后从开源走向商业化(除了开源,官方也提供商业服务),不过笔者个人感受下来,LobeChat在整体质感和功能特性方面更受一筹。UI上做的非常精细现代,功能上支持语音合成、多模态、插件,可以轻松多对接OpenAI/Gemini/Claude/Ollama等十数个平台。

🦀 Ollama安装和使用

Ollama非常容易安装,可在文末获取下载链接,下载安照下面的步骤开始安装和启动模型推理服务。

1️⃣ 安装

Windows和macOS直接双击安装即可

Linux平台需要使用命令安装

curl -fsSL https://ollama.com/install.sh | sh

也可以使用Docker进行安装,下面是一键启动命令:

docker run -d -v ./ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:latest

2️⃣ 下载大模型

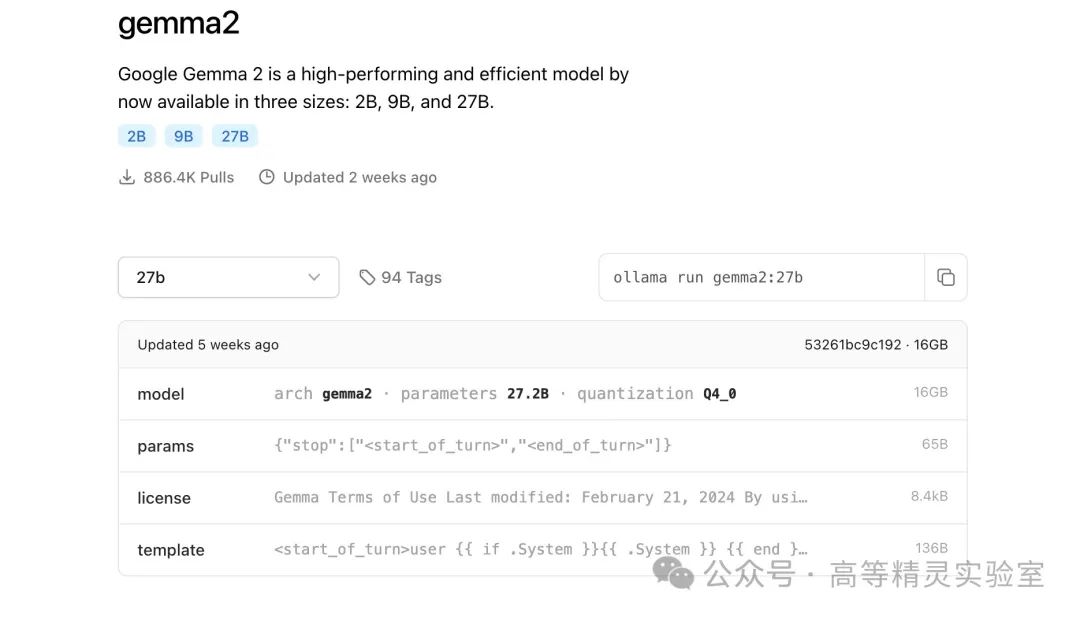

安装完成后就可以下载大模型啦,笔者推荐llama3.1、gemma2、qwen2等大模型,更多模型可在下面的网站搜索:

https://ollama.com/library

请根据自己的电脑或NAS配置情况,选择合适的模型和体量,体量越大模型文件的体积也越大,对CPU和显存的要求也越高。比如笔者选择的gemma2:27b,体积就有16GB。

输入下面的命令即可开始下载:

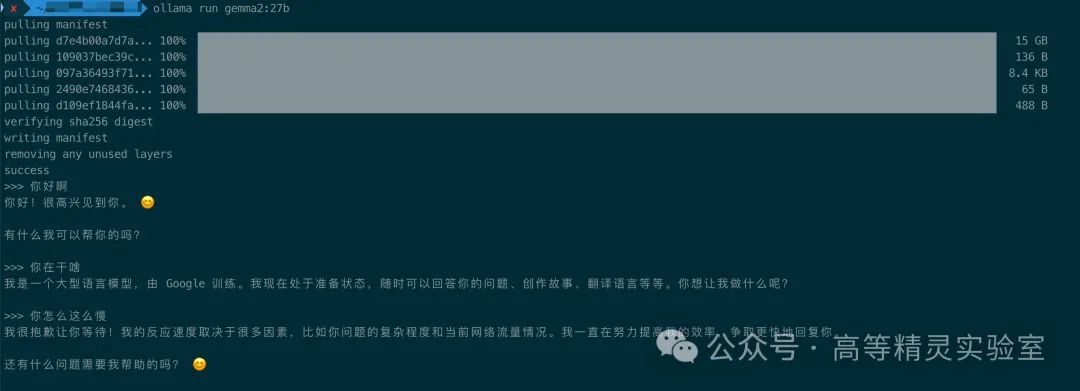

ollama run gemma2:27b

下载完成后,Ollama会自动启动模型推理服务,我们可以直接在终端中进行测试,笔者的M1芯片,没想到速度非常快!

最后,因浏览器安全限制,你需要为 Ollama 进行跨域配置后方可正常使用,在终端中输入下面命令然后重启Ollama即可。

launchctl setenv OLLAMA_ORIGINS "*"

🦀 LobeChat安装和使用

1️⃣ 安装LobeChat

LobeChat需要使用Docker来安装,下面是Docker和Docker Compose的指令,二选一即可。

Docker 指令部署

指令说明:

- 默认映射端口为 3210, 请确保未被占用或手动更改端口映射

- 设置访问密码为123456,请自行修改

- 使用你的 OpenAI API Key 替换上述命令中的 sk-xxxx ,如果不用OpenAI可以随便写。

Docker Compose 部署指令

创建一个compose.yml文件,将下面的内容贴近去:

然后在compose.yml文件所在目录下执行下面命令启动容器:

docker-compose up -d

2️⃣ 配置LobeChat

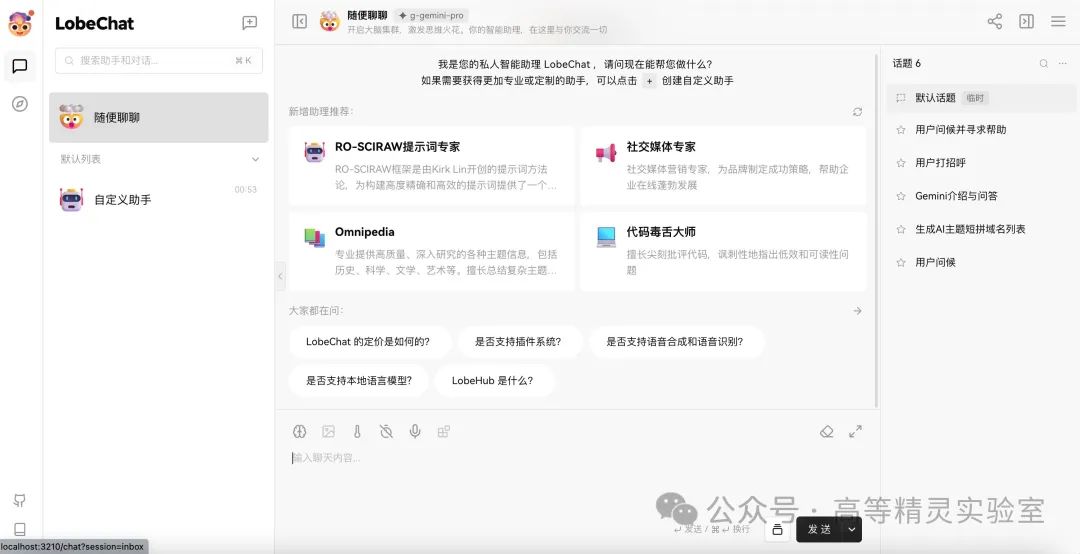

我们使用Docker启动LobeChat后,就可以在浏览器中使用localhost:3210打开LobeChat的WebUI了,界面看起来非常漂亮,首次打开后如果提示登录,输入上面安装命令中设置的ACCESS_CODE访问密码即可。

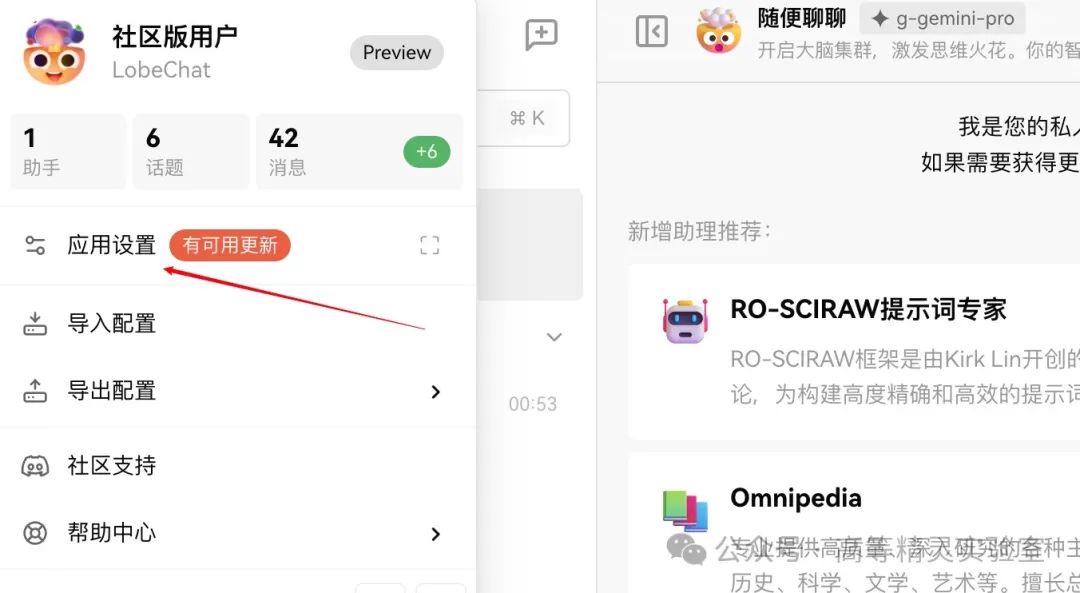

接着我们需要做一些简单的配置,以便可以与Ollama中的大模型进行对话。点击左上角的头像,在菜单中选择应用设置。

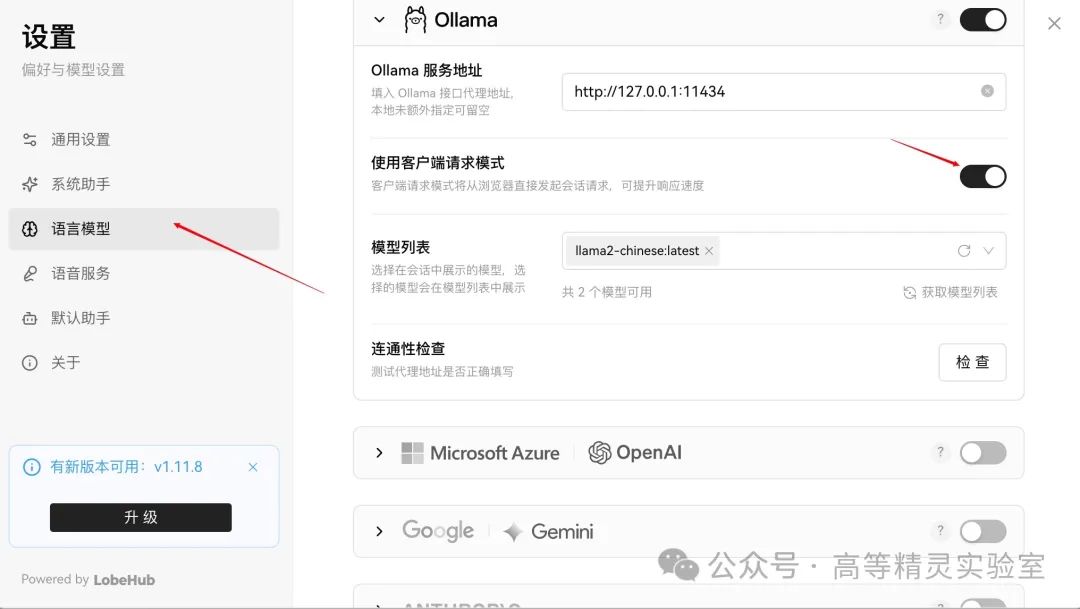

切换到语言模型,找到Ollama,打开右侧的开关。我们需要做以下设置:

- Ollama服务地址:如果是本地部署的,直接填http://127.0.0.1:11434

- 使用客户端请求模式:打开,否则Ollama服务地址的情况会比较复杂

- 模型列表:配置好Ollama服务地址后,这地方就会自动显示可用的模型,自行选择即可。

2️⃣ 与大模型对话

上述配置好之后,回到主页面,我们随便打开一个新的聊天界面,在顶部选择你想使用的大模型,就可以开始对话啦,速度和效果直接拉满!

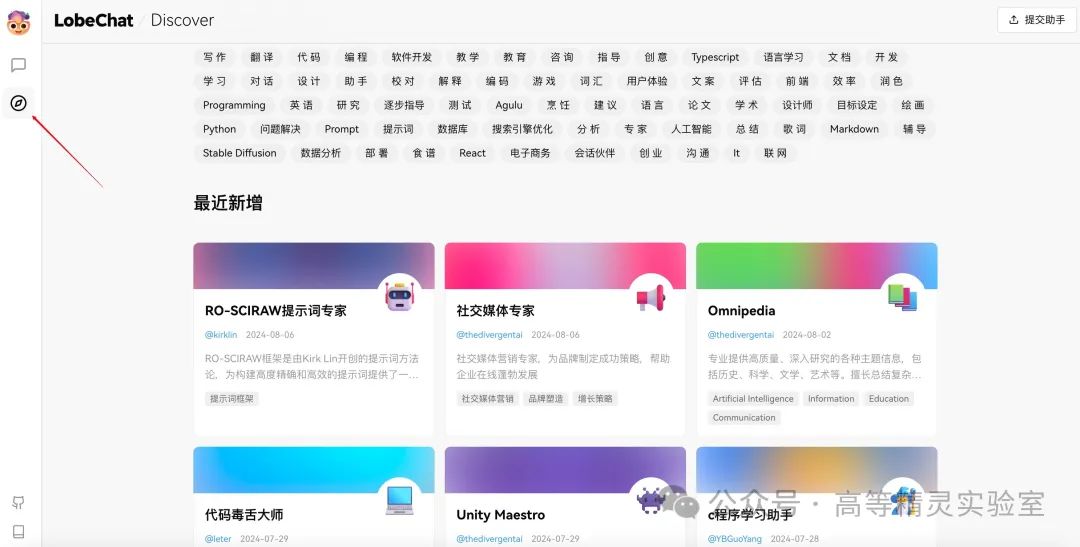

除此之外,LobeChat还内置了大量的预设助手,你可以根据自己的需要选择使用。

以上,就大功告成了。如果你有性能不错的服务器或NAS,也可以把Ollama和LobeChat都跑在上面,这样你就可以不受电脑的束缚,只需要打开浏览器(LobeChat支持PWA应用,对移动端适配的也不错)就可使用了。

AI大模型应用怎么学?

这年头AI技术跑得比高铁还快,“早学会AI的碾压同行,晚入门的还能喝口汤,完全不懂的等着被卷成渣”!技术代差带来的生存压力从未如此真实。

兄弟们如果想入门AI大模型应用,没必要到处扒拉零碎教程,我整了套干货大礼包:从入门到精通的思维导图、超详细的实战手册,还有模块化的视频教程!现在无偿分享。

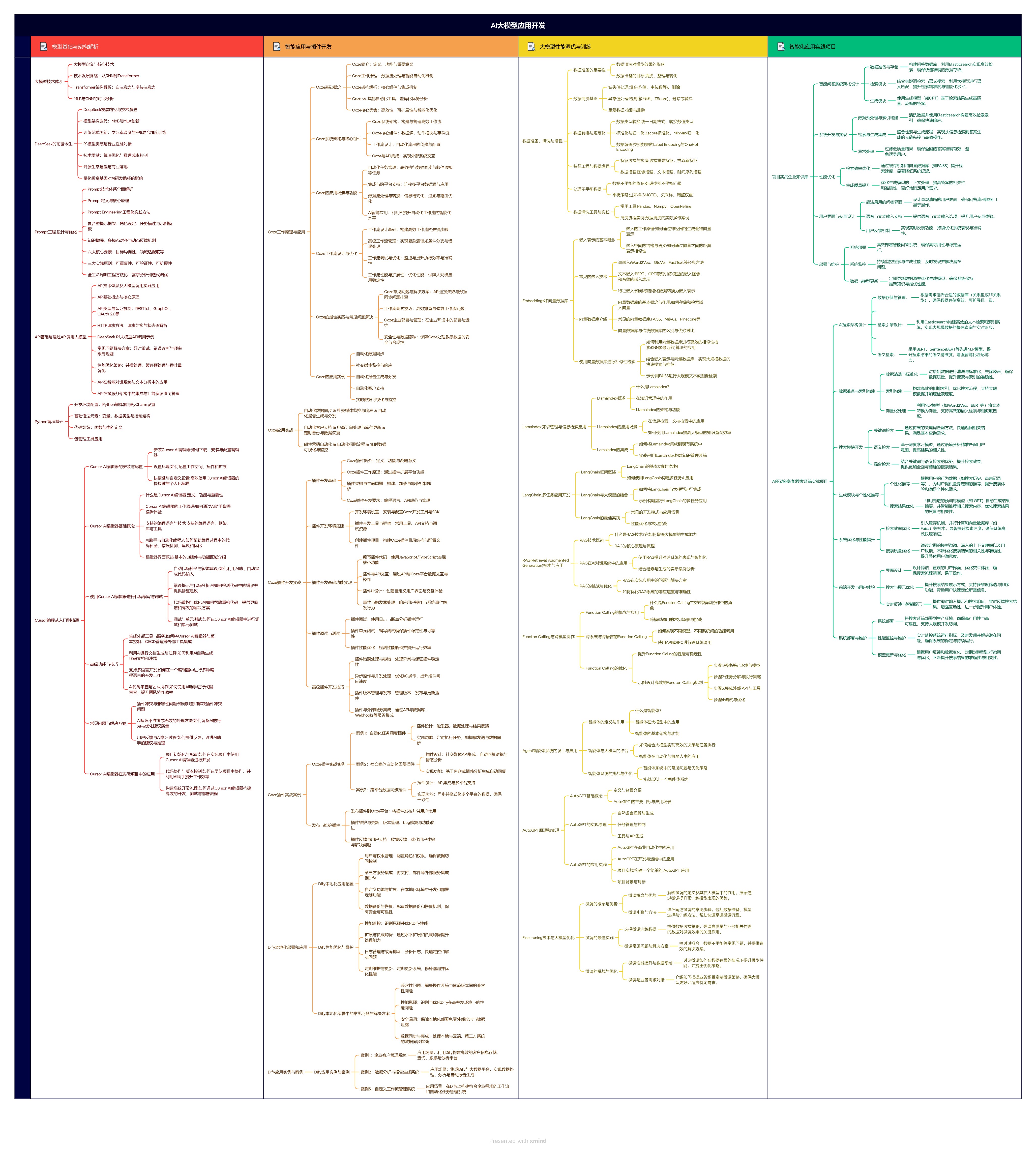

1.学习思维导图

AI大模型应用所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

2.从入门到精通全套视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

3.技术文档和电子书

整理了行业内PDF书籍、行业报告、文档,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

朋友们如果有需要全套资料包,可以点下面卡片获取,无偿分享!

1239

1239

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?