StyleCLIP: Text-Driven Manipulation of StyleGAN Imagery

摘要

受StyleGAN在各种领域中生成高质量逼真的图像的能力的启发,许多新工作集中在理解如何使用StyleGAN的潜在空间来操作生成的和真实的图像。然而,发现语义上有意的潜在操作通常涉及人类对多个自由度的仔细检查,或者为每个所需操作的图像的注释集合。在这项工作中,我们探索利用最新引入的对比语言-图像预训练(CLIP)模型的功能,以便为StyleGAN图像的处理开发基于文本的界面,而无需进行此类人工操作。我们首先介绍一种优化方案,该方案利用基于CLIP的算了来修改输入潜在矢量,以响应用户提供的文本提示。接下来,我们描述一个潜在映射器,该映射器针对给定的输入图像推断文本知道的潜在操作步骤,从而实现更快更稳定的基于文本的操作。最后,我们提出了一种在StyleGAN样式空间中将文本提示映射到与输入无关的方向的方法,从而实现交互文本驱动的图像处理。广泛的结果和比较证明了我们方法的有效性。

介绍

生成对抗网络彻底改变了图像合成,最近基于样式的生成模式拥有一些迄今为止最逼真的合成图像。此外,已经证明StyleGAN的学习中间潜在空间具有求解特征,这使得利用预训练的模型对合成图像和真实图像执行各种图像处理。

利用StyleGAN的表达能力需要开发简单直观的界面,以便用户轻松的实现他们的意图。现在的语义控制发现方法要么涉及手动检查,大量带注释的数据,要么涉及预训练的分类器。通过沿一个潜在空间中的方向移动来执行后续操作。使用参数模型如StyleRig中的3DMM或StyleFlow中的训练归一化流。

因此,现有控件智能沿预设的语义方向进行图像操作,从而严重限制了用户的创造力和想象力。每当需要附加的、未映射的方向时,就需要进一步的人工操作和/或大量的注释数据。

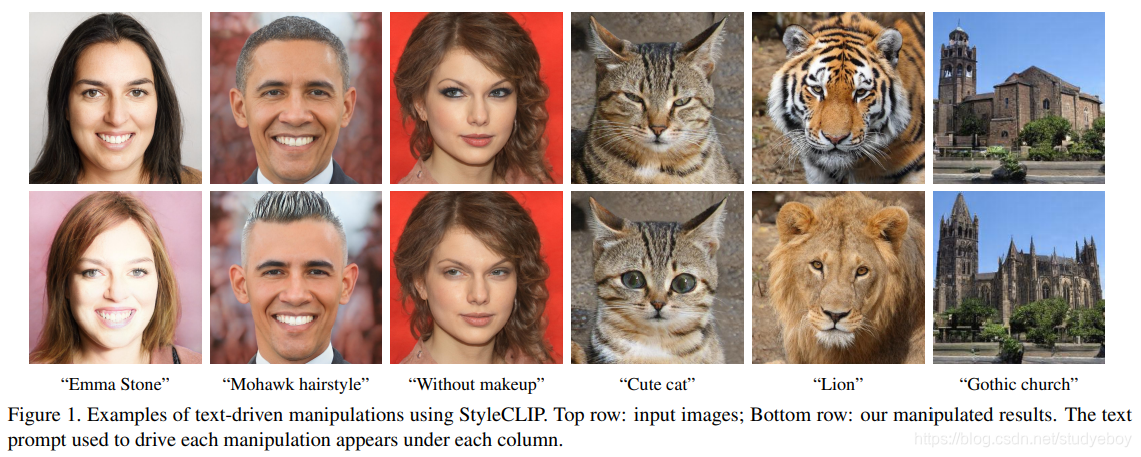

在这项工作中,我们将探索利用最新引入的对比语言-图像预训练(CLIP)模型的功能,以实现基于文本的直观语义图像操作,该操作不仅限于预设的操作方向,也不需要额外的人工来发现新空间。CLIP模型在从Web上获取的4亿个图像文本对上进行了预训练,并且由于自然语言能够表达更广泛的视觉概念,因此将CLIP与StyleGAN的生成功能相结合将为图像处理提供有趣的途径。图1显示使用我们的方法产生的独特操作的几个示例。具体而言,在本文中,我们研究了将CLIP与StyleGAN相结合的三种技术:

- 文本引导的潜在优化,其中CLIP模型用作损失网络。这是最通用的方法,但是需要几分钟的优化才能进行操作。

- 潜在残差映射器,针对特定的文本提示进行了训练,给定潜在空间中的起点(要处理的输入图像),映射器会在潜在空间中产生局部步长。

- 一种将文本提示映射到StyleGAN样式空间中的输入不可知(全局)方向的方法,可控制操纵强度和解开程度。

本文和补充材料中的结果展示了对人脸、动物、汽车和教堂图像的广泛语义操纵。这些操作的范围从抽象到特定,从广泛到细化。他们中的许多都没有通过以前的StyleGAN操作工作所证明,并且所有这些都是使用预先训练的StyleGAN和CLIP模型的组合很容易获得。

相关工作

视觉和语言

- 联合表示

多种工作学习跨模式的视觉和语言(VL)表示形式以完成各种任务,例如基于语言的图像检索,图像字幕和视觉问题解答。即BERT在各种语言任务中取得成功之后,最近的VL方法通常使用变换啦学习联合表示。一个基于对比语言-图像预训练的最新模型,学习了一种多模式嵌入空间,该空间可用于估计给定文本和图像之间的语义相似性。CLIP是在4一个文本图像对上进行训练的,这些文本图像对是从互联网上各种公开源收集的。CLIP所学的表示方法非常强大,可以对各种数据集进行最新的零镜头图像分类。可以参考OpenAI的Distill文章,其以广泛阐述和讨论CLIP所学的视觉概念。 - 文本引导的图像生成和处理

Reed等人的开拓性工作,通过训练条件GAN来处理文本引导的图像,条件GAN由从预训练的编码器获得的文本嵌入进行调节。张等人通过使用多尺度GAN改善了图像质量,AttnGAN在文本和图像特征之间纳入了一种注意力机制。其他工作中使用了额外的监督,以进一步提高图像质量。

一些研究集中在文本引导的图像处理上。一些方法使用基于GAN的编码器-解码器体系结构来解开输入图像和文本描述的语义。ManiGAN引入了一种新颖的文本-图像组合模块,可以产生高质量的图像。与上述工作不同,我们提出了一个单一框架,该框架将StyleGAN生成的高质量图像与CLIP所学的丰富的多域语义相结合。最近,DALL·E是GPT-3的120亿参数版本,其精度为16位,需要超过24GB的GPU内存,它在生成转换并将其应用于文本引导的图像时显示了多种功能。 相反,我们的方法甚至可以部署在单个商用GPU上。

与此同时TediGAN也使用StyleGAN进行文本引导的图像生成和操作。通过训练编码器将文本映射到StyleGAN潜在空间中,可以生成与给定文本相对应的图像。为了执行文本引导的图像处理,TediGAN将图像和文本都编码到潜在空间中,然后执行样式混合以生成相应的图像。在第7节中,我们演示了使用我们的方法实现的操作更好地反映了驱动文本的语义。

在最近的一篇在线文章中,Perez描述了一种文本到图像的方法,它以类似于第4节中潜在优化器的方式将StyleGAN和CLIP结合起来。我们的优化方案,以及本文中描述的其他两种方法,都侧重于图像处理,而不是从零开始合成图像。尽管文本到图像的生成是一个有趣且具有挑战性的问题,但我们认为,我们提供的图像处理功能对于创意艺术家的典型工作流程而言,是一种更有用的工具。

潜在空间图像处理

许多工作探索了如何利用预训练生成器的潜在空间进行图像处理。特别地,StyleGAN中的中间潜在空间已经被证明能够实现许多分离的和有意义的图像操作。一些方法通过训练将给定图像编码为潜在表示的网络来学会以端到端的方式执行图像操纵。其他方法旨在找到潜在路径,以便沿它们遍历会导致所需的操作。此类方法可以分类为:(i)使用图像注释查找有意义的潜在路径的方法,和(ii)在没有监督的情况下查找有意义的方向并且需要针对每个方向进行手动注释的方法。

虽然大多数作品在W或W +空间中执行图像处理,但Wu等人。 建议使用StyleSpace S,并表明它比W和W +更好地求解。 我们潜在的优化器和映射器在W +空间中工作,而我们检测到的与输入无关的方向是在S中。在这三个方面,操纵都是直接从文本输入中得出的,而我们唯一的监督来源是预先训练的CLIP模型。 由于CLIP已针对数亿个文本图像对进行了培训,因此我们的方法是通用的,可以在多个域中使用,而无需特定于域或特定于操作的数据注释。

StyleCLIP文本驱动的操作

在这项工作中,我们探索了文本驱动的图像处理的三种方法,所有这些方法将StyleGAN的生成能力与CLIP所学的丰富的联合视觉语言表示形式相结合。我们从第4节开始,介绍一个简单的潜在优化方案,通过最小化CLIP空间中计算的损失来优化StyleGAN W +空间中图像的给定潜在代码。针对每个(源图像,文本提示)对执行优化。因此,尽管用途广泛,但一次操作仍需花费几分钟,因此该方法可能难以控制。在第5节中介绍了一种更稳定的方法,训练映射网络以推断潜在空间中的操作步骤,一次向前通过。训练需要几个小时,但每个文本提示只能进行一次。操作步骤的方向可能会根据W +中的开始位置(对应于输入图像)的不同而有所不同,因此我们将此映射器称为“局部”。

我们在本地映射器上进行的实验表明,尽管起点不同,但对于各种各样的操作,操作步骤的方向通常彼此相似。此外,由于操作步骤是在W +中执行的,因此难以以解的方式获得细粒度的视觉效果。因此,在第6节中,我们探讨了第三种文本驱动的操作方案,该方案将给定的文本提示转换为不可知的输入(即,潜在空间中的全局)映射方向。全局方向是在StyleGAN的样式空间S中计算的,与W +相比,该样式空间更适合细粒度和非整齐的视觉处理。

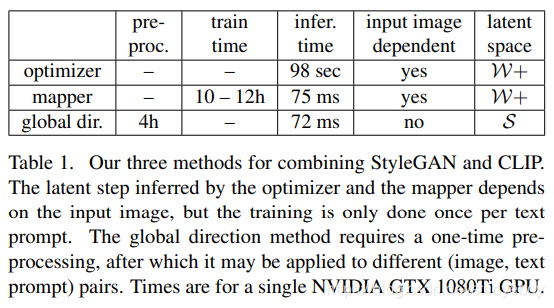

表1总结了上述三种方法之间的差异,而以下部分介绍了可视化结果和比较结果。

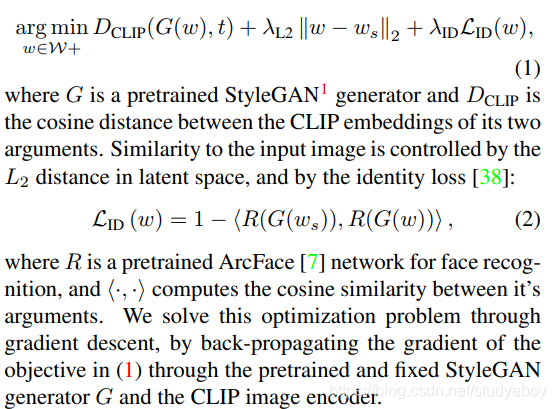

潜在优化

利用CLIP指导图像处理的一种简单方法是直接进行潜在代码优化。具体来说,给定源潜在代码 w s ∈ W + w_s \in W + ws∈W+,并使用自然语言的指令或文本提示 t t t,我们解决了以下优化问题:

在图3中,我们提供了200-300次迭代后使用此优化方法获得的一些编辑。输入图像被e4e反转。 请注意,视觉特征可以通过指示真实或虚构的人(碧昂丝,特朗普,艾尔莎)来显式控制(胡须,金发)或隐式控制。

本文介绍了一种基于CLIP的创新方法,用于StyleGAN图像处理,通过文本指令实现直观的语义操作,无需大量注解。研究了三种技术:潜在优化、局部映射器和全局方向控制,展示了在人脸、动物等领域的广泛应用。

本文介绍了一种基于CLIP的创新方法,用于StyleGAN图像处理,通过文本指令实现直观的语义操作,无需大量注解。研究了三种技术:潜在优化、局部映射器和全局方向控制,展示了在人脸、动物等领域的广泛应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2721

2721

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?