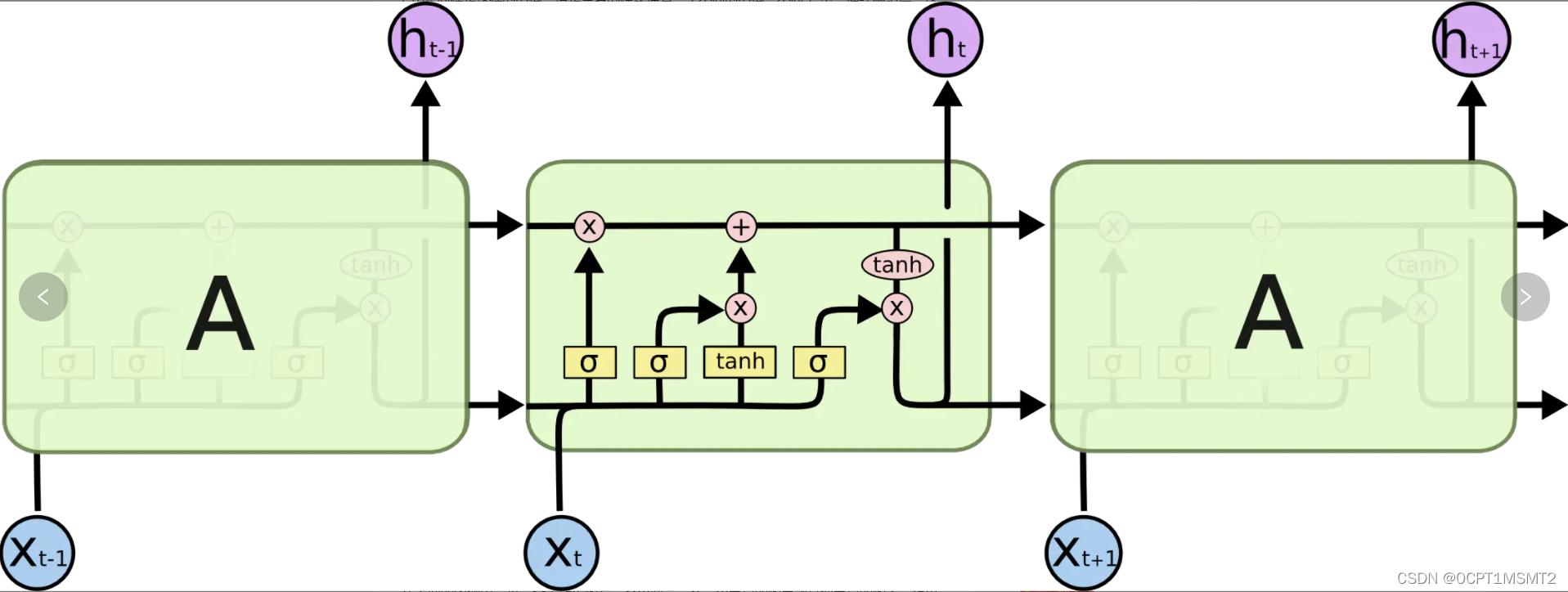

单层LSTM模型流程图(多层时,利用前一层的每一个h输出态作为当前层的流输入即可):

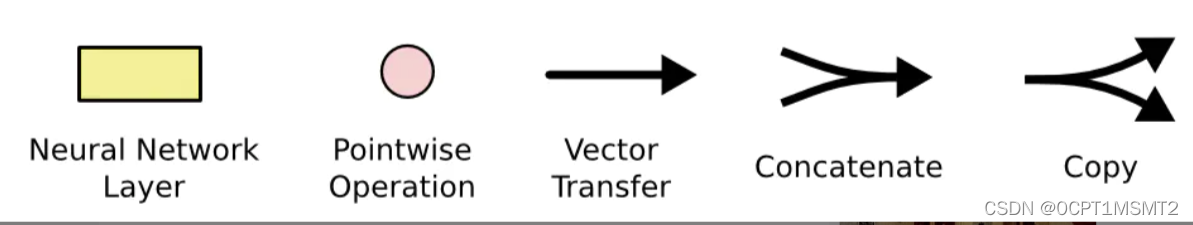

不必担心这里的细节。我们会一步一步地剖析 LSTM 解析图。现在,我们先来熟悉一下图中使用的各种元素的图标

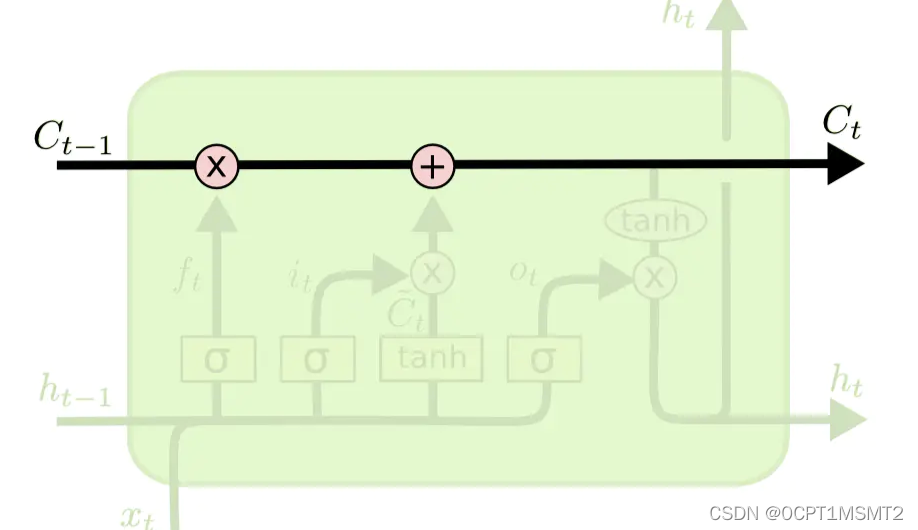

其中记忆状态ct又叫细胞状态,cell_state

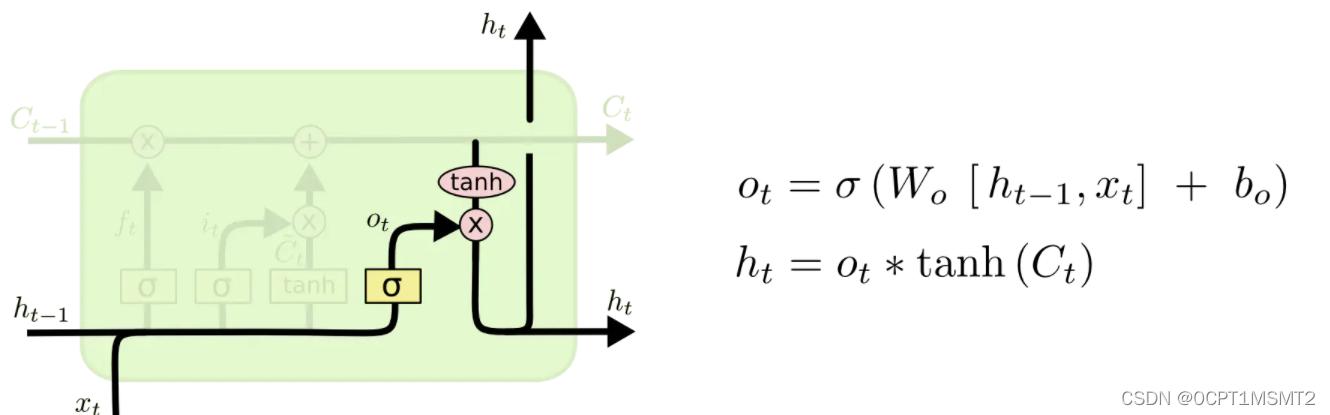

隐藏状态ht

在此过程中,有一个是记忆状态:

同样对应的中间输出状态为Ht

接下来,介绍和tf.keras.layers.LSTM中的关系,

1、go_backwards参数,决定输入的序列是正序输入到lstm还是倒序输入到lstm,通过次参数,就可以构造双向lstm

2、return_sequences=true时,返回序列输入时,每一次迭代对应的(h1,...,ht-1,ht),如果为false是,返回ht结论:

通常,在需要将各个隐层的结果作为下一层的输入时,选择设置

本文深入解析LSTM模型的工作原理,涵盖单层、多层LSTM结构,以及如何在Keras中配置go_backwards、return_sequences和return_state等关键参数。讲解了双向LSTM结构,并列举了常见混淆点及实例应用。

本文深入解析LSTM模型的工作原理,涵盖单层、多层LSTM结构,以及如何在Keras中配置go_backwards、return_sequences和return_state等关键参数。讲解了双向LSTM结构,并列举了常见混淆点及实例应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

446

446

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?