这里实现的是一个比较偏的upsample,是朋友问我的,顺手记录下来。

实现的效果如下:

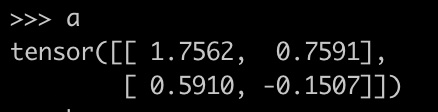

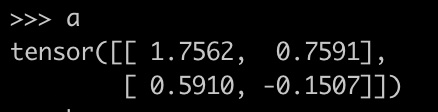

输入:

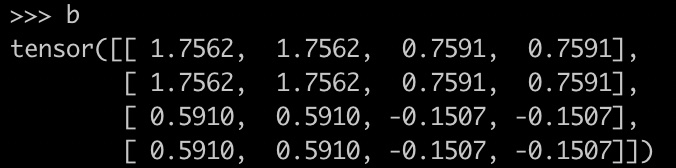

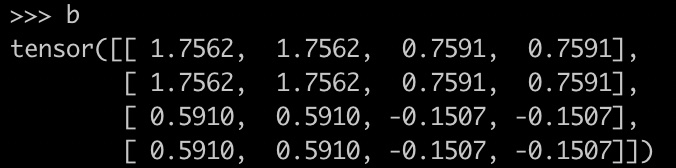

输出:

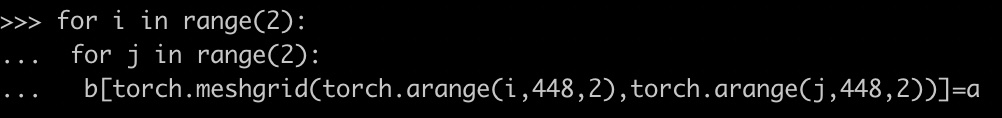

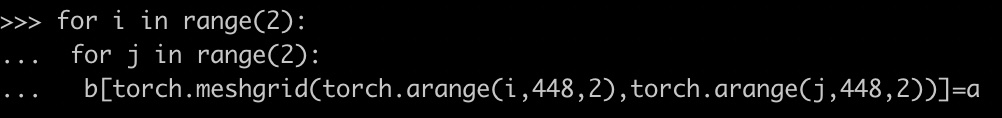

实现的是按相同值内插。实现方法是meshgrid,这个函数很好用,可以在输入x坐标和y坐标的情况下,返回由其组成的所有可能坐标组合。具体实现如下:

使用meshgrid实现特定上采样

使用meshgrid实现特定上采样

本文介绍了一种利用meshgrid函数实现的特殊上采样方法,通过内插相同值来完成坐标组合的生成,适用于图像处理和数据扩充场景。

本文介绍了一种利用meshgrid函数实现的特殊上采样方法,通过内插相同值来完成坐标组合的生成,适用于图像处理和数据扩充场景。

这里实现的是一个比较偏的upsample,是朋友问我的,顺手记录下来。

实现的效果如下:

输入:

输出:

实现的是按相同值内插。实现方法是meshgrid,这个函数很好用,可以在输入x坐标和y坐标的情况下,返回由其组成的所有可能坐标组合。具体实现如下:

1416

1416

1327

1327

5542

5542

2157

2157

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?