发表时间:NeurIPS 2024

论文链接:https://readpaper.com/pdf-annotate/note?pdfId=2517084963921814272¬eId=2519032879246930432

作者单位:MIT CSAIL(Kaiming开始做具身了)

Motivation:Previous robot learning methods often collect data to train with one specific embodiment for one task(不够通用), which is expensive and prone to overfitting.

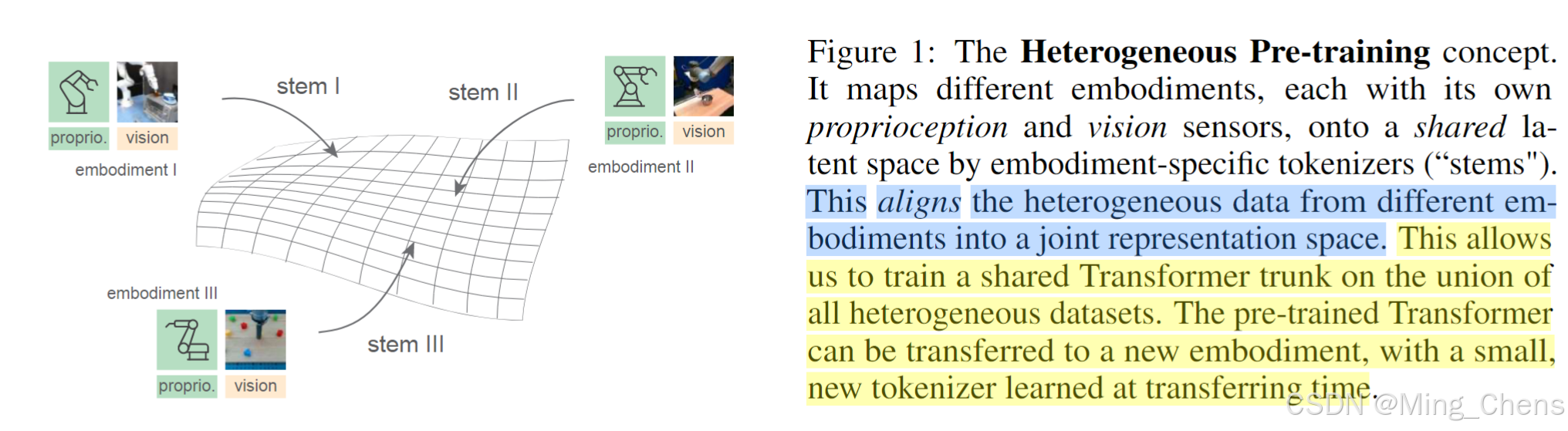

解决方法:This work studies the problem of learning policy representations through heterogeneous pretraining on robot data across different embodiments and tasks at scale.

实现方式:提出Heterogeneous Pre-trained Transformers (HPT), which pre-train a large, shareable trunk of a policy neural network to learn a task and embodim

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1142

1142

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?