随着人工智能、大数据和图形计算领域的飞速发展,对高性能计算资源的需求日益增长。GPU实例作为加速计算的重要工具,成为云计算服务的重要组成部分。丹摩平台(Dummy Platform)通过提供多种GPU实例规格,为不同计算需求提供灵活、高效的解决方案。本文将从GPU实例的规格、价格与能力三大维度展开,探讨如何在丹摩平台上进行最优的GPU实例选择。

一、GPU实例规格详解

1. GPU型号与架构

丹摩平台的GPU实例涵盖了市场上多种主流型号和架构,包括 NVIDIA T4、RTX 3090、A10、A100 和最新的 H100。这些型号基于 NVIDIA 的 Turing、Ampere 和 Hopper 架构,能够满足从推理到训练、从小型任务到大规模分布式计算的多样化需求。

- NVIDIA T4:

- 架构:Turing

- 显存:16GB GDDR6

- 特点:低功耗,适合推理任务与轻量级训练。

- 适用场景:实时推荐系统、小型深度学习模型、视频处理。

- NVIDIA RTX 3090:

- 架构:Ampere

- 显存:24GB GDDR6X

- 特点:高显存、高计算性能。

- 适用场景:中型深度学习训练、3D渲染、科学计算。

- NVIDIA A100:

- 架构:Ampere

- 显存:40GB/80GB HBM2e

- 特点:专为大规模深度学习优化,支持多实例 GPU(MIG)。

- 适用场景:大型模型训练(如 GPT、BERT)、分布式计算。

- NVIDIA H100:

- 架构:Hopper

- 显存:80GB HBM3

- 特点:新一代计算卡,具备更高的算力和带宽。

- 适用场景:超大模型训练、高性能计算(HPC)。

2. 实例规格

丹摩平台将不同型号的 GPU 实例划分为多种规格,从单GPU实例到支持多卡并行的实例,规格的灵活性能够满足多样化需求。以下是几个典型规格:

- 单卡实例:适合中小型任务,如 T4 和 RTX 系列。

- 多卡实例:适合大规模分布式训练,如 2xA100 或 4xA100。

- 共享实例:适合预算有限的用户,通过 MIG 技术分割 GPU 资源(如 A100 的共享模式)。

3. 弹性与扩展性

丹摩平台支持 GPU 实例的按需部署和自动扩展,用户可以根据任务需求动态调整计算资源。例如,在模型训练阶段,可以启动多卡大规格实例进行加速;在推理部署阶段,则切换到小规格实例,降低成本。

二、GPU实例价格分析

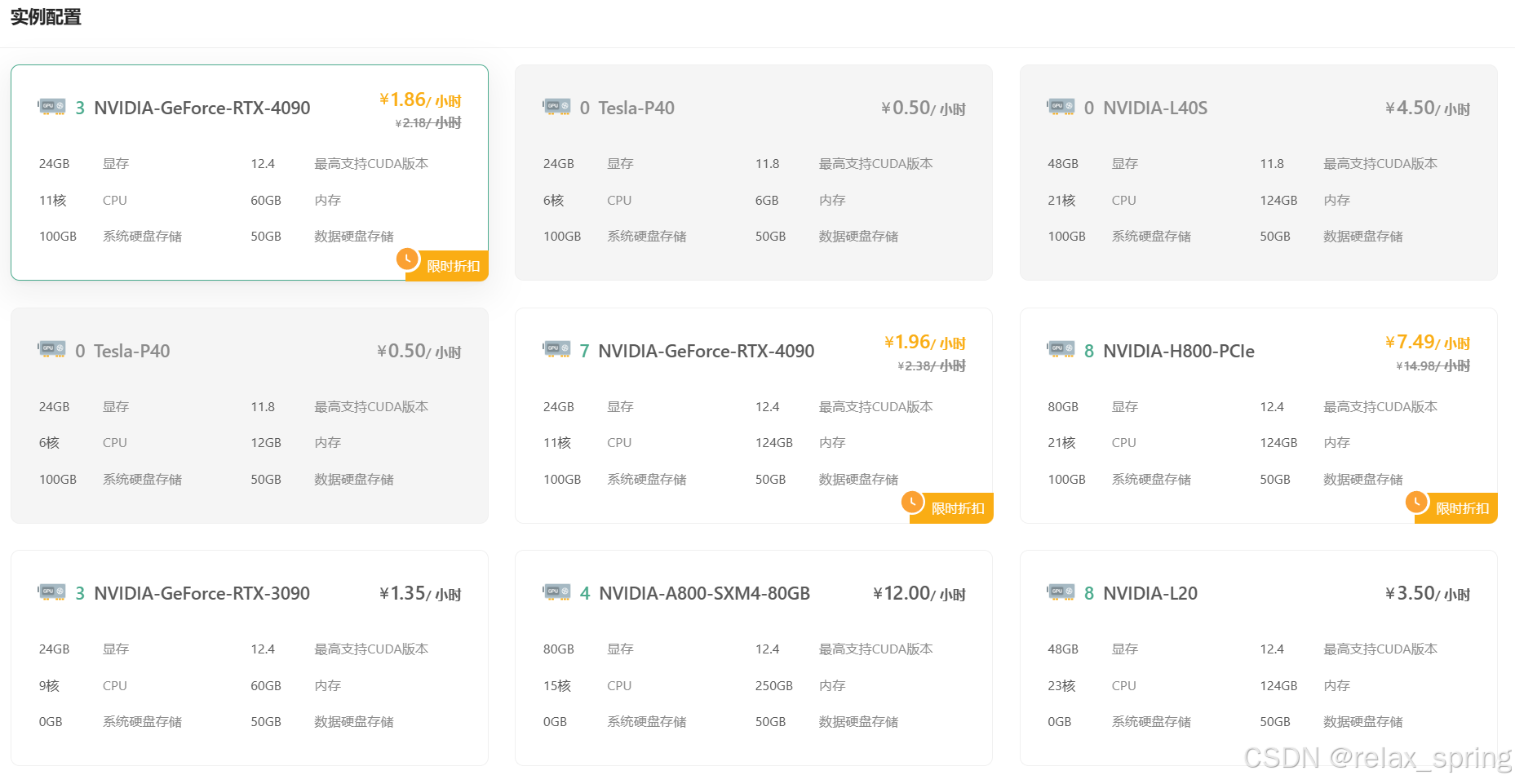

价格是选择 GPU 实例时的重要考量因素。丹摩平台的 GPU 实例价格基于型号、规格和使用模式(按需、预留或竞价实例)进行定价。

1. 价格模型

- 按需实例:适合短期任务,无需长期承诺。

- 价格较高,但灵活性强。

- 预留实例:适合长期任务,通过提前预订锁定低价。

- 价格比按需实例低 30%-50%。

- 竞价实例:适合不连续的任务(如模型测试)。

- 价格最低,但有中断风险。

2. 成本优化策略

通过合理选择 GPU 实例的使用模式,可以有效降低成本:

- 短期测试或开发:选择 T4 按需实例,成本低且灵活。

- 长期训练:选择 A100 的预留实例,获得高性能和稳定性。

- 预算有限但需高算力:选择 RTX 3090 竞价实例,性价比高。

三、GPU实例能力对比

选择 GPU 实例时,不仅要考虑价格,还需分析其计算能力是否满足任务需求。

1. 计算性能

GPU 的核心指标包括:

- 单精度浮点运算性能 (TFLOPS):

- T4:8.1 TFLOPS

- RTX 3090:35.6 TFLOPS

- A100:312 TFLOPS

- 双精度性能(用于科学计算):

- A100 和 H100 性能最强。

- 并行计算能力:

- A100 和 H100 支持 NVLink 和 InfiniBand,实现多节点高效通信。

2. 内存与带宽

高显存对大模型训练尤为重要:

- T4 的 16GB 显存适合轻量级任务。

- RTX 3090 的 24GB 显存适合中等规模训练。

- A100 和 H100 提供 40GB~80GB HBM,带宽高达 1.6 TB/s,能高效处理超大模型。

四、如何选择最优GPU实例?

1. 基于任务类型

- 小型任务:T4 和 RTX 3060。

- 中型任务:RTX 3090 和 A10。

- 大型任务:A100 和 H100。

2. 基于显存需求

- 显存需求 ≤16GB:选择 T4 或 RTX 3060。

- 显存需求 ≤24GB:选择 RTX 3090。

- 显存需求 ≥40GB:选择 A100 或 H100。

3. 基于预算

- 高预算:A100 按需实例。

- 中等预算:RTX 3090 预留实例。

- 低预算:T4 竞价实例。

五、总结

在丹摩平台选择 GPU 实例时,应综合考虑 GPU 的规格、价格和能力。针对不同的计算需求,合理分配资源能够显著提升效率并优化成本。从低成本的 T4 到顶级性能的 H100,丹摩平台为用户提供了广泛的选择空间。

最后,感谢观看。

250

250

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?