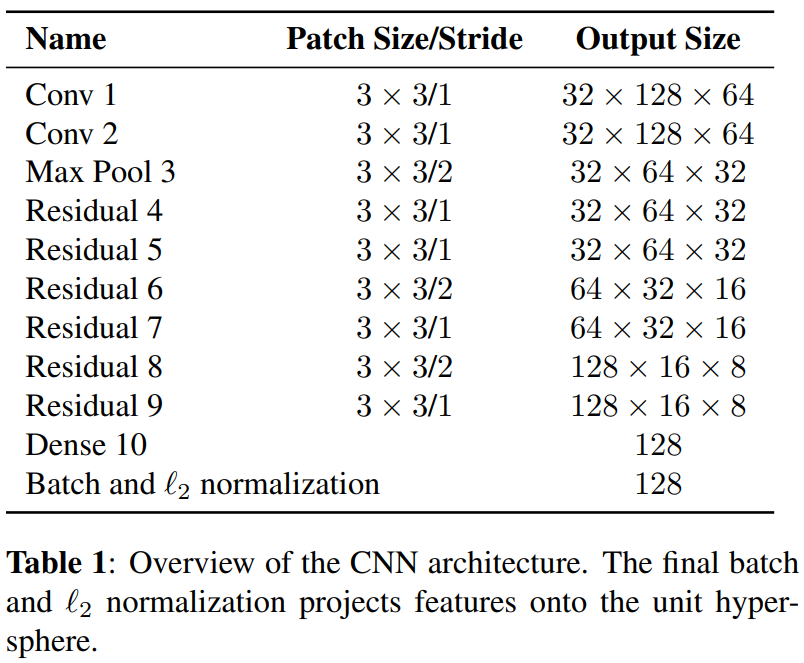

1.conv1 conv2 是卷积层,卷积层的作用主要在于提取图像特征,卷积核(滤波器)的大小(Patch Size)是3x3 ,步长(Stride,滤波器滑动的间隔)为1。

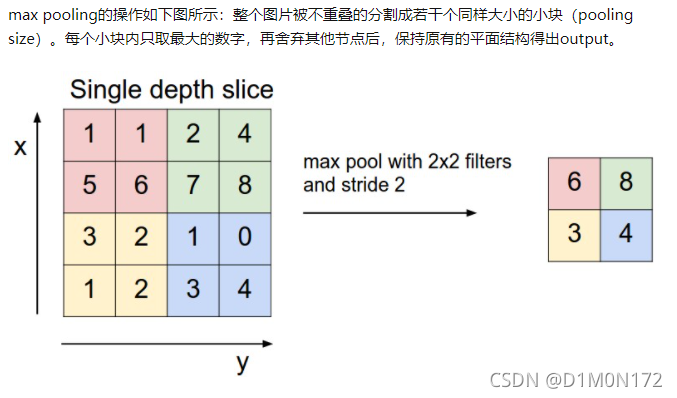

2.max pool3 指的是在卷积之后还有一个 pooling(汇集)的操作

参考:Yjango请问CNN 中的 maxpool 到底是什么原理,为什么要取最大值,取最大值的原理是什么?谢谢。 - 知乎

3. 残差(residual) 防止网络层数过多造成的梯度消失和梯度爆炸, 6个残差块, 一层是由多个残差单元组成。

4.Dense全连接层 通常在CNN的尾部进行重新拟合,减少特征信息的损失。全连接层是最原始,出现最早的神经网络结构,能够无损的传递特征信息,但是网络参数多,计算量大,训练较慢。

5.batch and l2 normalization 就是对每一批数据进行归一化,主要是在一定程度上缓解了深层网络中“梯度弥散”的问题,从而使训练深层网络模型更加容易稳定。

本文介绍了卷积神经网络(CNN)中卷积层的作用,卷积层通过3x3大小的滤波器进行特征提取,步长为1。接着讨论了maxpooling操作,用于降低数据维度并保持关键信息。残差网络(ResNet)通过残差块解决了深层网络的梯度消失问题,允许更深层次的网络训练。最后,提到了全连接层(Dense)在模型末端的重要性,用于特征的重新拟合,并且介绍了Batch Normalization如何增强模型的稳定性。

本文介绍了卷积神经网络(CNN)中卷积层的作用,卷积层通过3x3大小的滤波器进行特征提取,步长为1。接着讨论了maxpooling操作,用于降低数据维度并保持关键信息。残差网络(ResNet)通过残差块解决了深层网络的梯度消失问题,允许更深层次的网络训练。最后,提到了全连接层(Dense)在模型末端的重要性,用于特征的重新拟合,并且介绍了Batch Normalization如何增强模型的稳定性。

924

924

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?