Abstract:多模态情感分析(MSA)旨在通过多模态数据理解人类情感。大多数MSA的研究都假设模态是完整的。然而,在实际应用中,一些实际因素导致模态的不确定缺失,这会严重降低模型的性能。为此,我们提出了一种在不确定缺失模态情况下进行MSA任务的关联解耦知识蒸馏(CorrKD)框架。具体而言,我们提出了一种基于样本级对比蒸馏机制,该机制传递包含跨样本关联的综合知识,以重建缺失的语义。此外,我们引入了一种类别引导的原型蒸馏机制,通过类别原型捕捉跨类别关联,进而对齐特征分布并生成有利的联合表示。最终,我们设计了一种响应解耦一致性蒸馏策略,通过响应解耦和最大化互信息来优化学生网络的情感决策边界。通过在三个数据集上的综合实验,我们的框架在与多个基线方法的对比中取得了显著的改进。

一、关键点

1.关联解耦知识蒸馏框架(CorrKD)

关联解耦知识蒸馏框架(CorrKD) 是一种为了解决多模态情感分析(MSA)任务中不完全模态带来的问题而提出的框架。在实际应用中,由于各种原因(如数据缺失、传感器故障或不完整的输入),多模态数据的模态可能会缺失,这会导致传统的多模态情感分析方法性能显著下降。为了应对这一挑战,CorrKD框架通过解耦和蒸馏机制,在不完全模态条件下仍能有效地进行情感分析。

CorrKD的关键组成部分:

-

样本级对比蒸馏机制(Sample-level Contrastive Distillation, SCD)

该机制利用对比学习方法,捕捉跨样本的关联信息。通过对比样本之间的相似性和差异性,SCD能够从已有的模态数据中提取有价值的信息,并将其转移到缺失模态的数据中,从而帮助模型重建缺失的语义信息。 -

类别引导的原型蒸馏机制(Category-guided Prototype Distillation, CPD)

该机制利用类别原型来捕捉跨类别的关联信息。通过学习类别原型,CorrKD能够在多模态数据中对不同类别的情感信息进行对齐,从而生成更加鲁棒和准确的联合表示。原型蒸馏有助于模型更好地理解和处理来自不同模态的情感信息,并提高情感分析的准确性。 -

响应解耦一致性蒸馏策略(Response-disentangled Consistency Distillation, RCD)

这一策略旨在通过解耦不同模态的响应,优化学生网络的情感决策边界。RCD通过最大化相同响应类别之间的互信息,确保不同模态的响应在情感决策上保持一致性。该策略有效地避免了多模态数据中不同模态间的干扰,增强了模型在模态缺失情况下的鲁棒性。

二、引言

在现实世界中,背景噪声、传感器约束和隐私问题等因素可能会导致不确定的模态缺失问题。模态缺失会显著损害基于完整模态的训练有素的模型的有效性。如下图

目前研究存在的问题:

(i)基于单个样本的交互不足,缺乏对整体结构语义的挖掘。(ii)未能对跨类别相关性进行建模会导致情感相关信息的丢失和类别之间的分布混乱。(iii)粗略的监督忽略了语义和分布的一致性。

三、相关工作

1. 多模态情感分析(MSA)

多模态情感分析的研究通常聚焦于结合语言、视觉和音频等多种模态的信息来增强情感分析的准确性。传统的情感分析方法通常依赖于单一模态(如文本或语音)进行情感分类,但由于不同模态能够提供互补的情感信息,近年来的研究开始转向多模态情感分析,即融合多个模态的数据来获得更为丰富和准确的情感表征。

多模态情感分析的挑战在于处理缺失模态的情况。在实际应用中,可能因为多种原因(如设备问题或网络传输问题)导致某些模态缺失,这会显著影响模型的表现。现有的多模态情感分析方法通常假设所有模态是可用的,但缺少应对模态缺失或不完整数据的机制。

2. 模态缺失问题与相关方法

由于模态缺失是实际应用中的常见问题,许多研究尝试通过不同方式解决这一挑战。例如,部分工作通过模态补全技术来填补缺失的模态,但这些方法的效果通常受到缺失模态类型和数量的限制,且无法有效处理完全缺失模态的情况。

另一些方法则侧重于通过自监督学习或迁移学习来提高模型在缺失模态情况下的鲁棒性,但这些方法在模态缺失的极端情况下仍然难以取得理想效果。

3. 知识蒸馏(Knowledge Distillation)

知识蒸馏是深度学习中的一种有效技术,通过将一个复杂的教师模型的知识转移给一个较小的学生模型,从而提高学生模型的性能。在多模态学习中,知识蒸馏已被应用于不同模态之间的知识传递,尤其是当一个模态的数据不可用时,教师网络可以向学生网络传递其他模态的信息。

跨模态知识蒸馏的方法试图解决不同模态之间的语义差异,并使得学生网络能够利用其他模态的信息补充缺失模态。这些方法通常依赖于教师模型提供的有用信息来提高学生网络的表现,尤其在某些模态缺失的情况下。

4. 当前工作与现有方法的对比

现有的基线方法通常假设多模态数据是完整的,但这并不适应实际应用中的模态缺失问题。尽管有一些方法通过自监督学习和迁移学习等手段提升了在缺失模态情况下的性能,但这些方法在处理极端模态缺失或跨模态融合时依然存在局限。

CorrKD框架与这些方法的不同之处在于其创新性地引入了关联解耦知识蒸馏,通过样本级对比蒸馏、类别引导的原型蒸馏和响应解耦一致性蒸馏策略来提高在缺失模态情况下的情感分析性能。CorrKD的设计能够更有效地捕捉模态间的相关性,同时增强模型的鲁棒性,从而显著改善多模态情感分析在模态缺失情况下的效果。

四、方法

框架图:

教师网络和学生网络采用一致的结构,但具有不同的参数。在训练阶段,我们的CorrKD程序如下:(i)我们用完整的模态样本训练教师网络,然后冻结其参数。(ii)给定视频片段样本S,我们使用模态随机缺失(MRM)策略生成缺失模态样本S。MRM同时执行模态内缺失和模态间缺失,缺失部分的原始特征被零向量替换。S和ˆS分别馈入初始化的学生网络和训练好的教师网络。iii)我们将样本S和ˆS输入模态表示融合模块,以获得联合多模态表示Ht和Hs。(iv)利用样品级对比蒸馏机制和类别引导原型蒸馏机制来学习Ht和Hs的特征一致性。(v) 这些表示被馈送到任务特定的全连接层和softmax函数中,以获得网络响应Rt和Rs。(vi)应用响应解纠缠一致性蒸馏策略来保持响应分布的一致性,然后使用Rs进行分类。在推理阶段,测试样本仅被输入到学生网络中用于下游任务。

1.模态表示融合

模态表示融合(Modality Representation Fusion)部分主要介绍了如何通过学生网络提取和融合不同模态的表示,以解决多模态情感分析中的模态缺失问题。模态表示融合是整个框架中的核心部分,它通过对各个模态的特征进行有效的融合,来增强学生网络在处理缺失模态时的鲁棒性和准确性。

每种模态(语言、视觉、音频等)都经过独立的表示提取过程。首先,输入的每个模态数据(例如文本、图像、音频)通过一个1D的时间卷积层进行处理,卷积核的大小为3×3。接着,位置嵌入(Positional Embedding, PE)被加到每个模态的初步表示中,形成每个模态的初步特征表示,记为 F^ms(其中 m 表示模态类型,m∈{L,A,V},分别对应语言、音频和视觉模态)。

每个模态的初步表示 F^ms 被输入到一个 Transformer 编码器(Transformer Encoder)中,通过自注意力机制(self-attention)来捕捉模态之间的动态关系和长期依赖性。经过Transformer编码后,得到每个模态的表示 Ems,其维度为 Ems=Fϕs(Fms),其中 Fms是经过卷积和位置嵌入处理后的模态表示。

为了得到一个融合了所有模态信息的综合表示,首先将各个模态的表示 Ems进行串联操作,形成一个多模态表示 Zs。具体来说,三种模态的表示被按顺序串联起来,即

其中,ELs、EAs 和 EVs 分别是语言、音频和视觉模态的表示, Tm 是时间序列长度,d 是每个模态的特征维度。

将串联后的多模态表示 Zs输入到 全局平均池化(Global Average Pooling, GAP) 层中。GAP层的作用是通过对每个模态的表示进行池化操作,从而进一步强化和精炼多模态的特征。这一步骤有助于获取每个模态在整个时间序列中的全局信息,生成一个维度为 Hs∈R3d 的 联合多模态表示。

教师网络同样也经过类似的处理流程,生成相应的 联合多模态表示 Ht∈R3d。这些表示将在后续的蒸馏过程中,用于指导学生网络的学习。

2.样品级对比蒸馏

样品级对比蒸馏的目标是通过对比学习来优化学生网络的学习过程,特别是在教师网络拥有完整模态信息而学生网络缺失某些模态的情形下。传统的知识蒸馏方法多聚焦于将教师网络的知识通过某种方式转移给学生网络,但这些方法往往只考虑单一样本的特征传递,忽视了不同样本之间以及同类样本之间的内在关联性。样品级对比蒸馏通过对比学习增强了网络之间的跨样本学习,进一步提升了学生网络的学习效果,尤其是在处理模态缺失时。

在样品级对比蒸馏中,假设给定一个迷你批次 B={S0,S1,…,SN},其中包含 N个样本。对于每个样本,教师网络和学生网络都会计算其对应的多模态表示。假设教师网络和学生网络分别输出样本的表示为 Hw={H1w,H2w,…,HNw},其中 w∈{t,s} 分别表示教师网络和学生网络,Hiw表示第 i个样本在网络 w 中的表示。

样品级对比蒸馏的核心思想是对比学习:对同一输入样本,要求教师和学生网络的表示尽可能相似,而对不同样本,要求教师和学生网络的表示尽可能不同。通过这一机制,学生网络能够从教师网络中学习到更多有效的情感分析知识。

样品级对比蒸馏通过定义一个对比损失函数来实现上述目标。损失函数的形式如下:

该损失函数包含两部分:

同样本对的损失:对于同一输入样本,教师和学生网络的表示应该尽量接近,因此计算 D(Hsi,Hti) 的平方,推动它们之间的距离减小。

不同样本对的损失:对于不同样本,教师和学生网络的表示应该尽量保持区分,因此对 D(Hsi,Htj)的距离进行最大化。为了避免过度优化,设定了一个距离边界 η,如果距离已经足够大,损失函数将不再惩罚这个对。

3.类别导向原型蒸馏

在多模态情感分析(MSA)任务中,常常面临两个问题:

类别间相似性高:不同类别的特征在某些模态下可能具有较高的相似性,这使得模型难以区分它们。

类别内差异性大:同一类别的样本在不同模态中可能有很大的差异,导致模型在缺失模态时无法有效捕捉到情感相关的语义信息。

传统的基于知识蒸馏的方法通常只关注样本级别的知识传递,未能充分利用类别间和类别内的特征变异来改进学生网络的表现。因此,作者提出了基于类别引导的原型蒸馏(CPD)方法,旨在通过类别原型来帮助学生网络理解类别之间的关联以及同一类别内样本的差异,从而提升情感分析的性能。

类别原型的定义

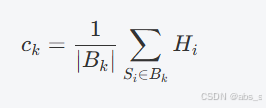

在类别引导的原型蒸馏中,每个类别 k 都有一个对应的类别原型 ck,该原型表示该类别的“中心”,即该类别所有样本在特征空间中的均值。类别原型的计算公式如下:

- Bk 表示属于类别 k的样本集合,

- Hi 是样本 Si 的特征表示。

类别原型 ck是类别 k 内所有样本的特征向量的均值,反映了该类别的典型特征。

类别内与类别间特征变异

通过类别原型,模型能够捕捉到类别内和类别间的特征变异。具体来说,给定样本 Si 和类别原型 ck,可以计算出样本 Si 相对于类别原型的相似度或变异性,定义为:

如果样本 Si属于类别 k,则 Mk(i) 反映的是类别内的特征变异,即样本与该类别原型的相似度。

如果样本 Si不属于类别 k,则 Mk(i) 表示类别间的特征变异,即样本与其他类别的相似度。

这种变异度的计算有助于模型理解每个样本与其类别原型的关系,进而增强分类的准确性,尤其是在缺失某些模态的情况下。

类别引导的原型蒸馏损失

为了将教师网络的知识传递给学生网络,类别引导的原型蒸馏机制通过计算学生网络和教师网络在原型层的相似度来进行蒸馏。具体地,定义教师网络和学生网络的原型相似度矩阵为 Mt 和 Ms,然后通过最小化两者的差异来实现知识转移。蒸馏损失 LCPD 被定义为:

K 是类别数,

Msk(i)和 Mtk(i)分别表示学生网络和教师网络在类别 k下对样本 Si的相似度。

通过最小化这个损失,学生网络能够学习到教师网络中的类别原型信息,从而更好地处理不同类别的情感分析任务。

4.响应解耦一致性蒸馏

在传统的知识蒸馏方法中,教师网络和学生网络的知识传递主要依赖于网络的中间层特征或最终预测结果(即响应)。然而,在许多情感分析任务中,模型的响应(预测结果)包含了更高层次的语义信息。因此,响应级别的蒸馏被认为是一种更有效的知识传递方式。

然而,响应级别的蒸馏方法存在一个问题:响应的耦合性。具体来说,在传统的知识蒸馏中,目标类别(Target Category Response, TCR)和非目标类别(Non-Target Category Response, NTCR)往往会产生耦合效应。高置信度的目标类别响应会压制非目标类别响应,从而限制了知识的有效传递。为了有效地解决这一问题,本文提出了响应解耦一致性蒸馏(Response-disentangled Consistency Distillation, RCD)方法,通过解耦响应的不同部分,优化知识传递的效果。

响应的解耦

在传统的蒸馏方法中,网络的最终响应(即预测结果)是由所有类别的预测概率构成的,这些预测概率包含了对目标类别和非目标类别的理解。为了减少目标类别与非目标类别之间的相互影响,本文将响应分解为两个部分:

目标类别响应(TCR, Target Category Response):表示目标类别的预测,反映了模型对目标类别的信心。

非目标类别响应(NTCR, Non-Target Category Response):表示非目标类别的预测,反映了模型对其他类别的相对置信度。

通过解耦目标类别和非目标类别的响应,RCD方法能够更好地处理它们之间的关系,避免高置信度的目标类别响应对其他类别的压制,从而促进更有效的知识转移。

一致性蒸馏机制

为了确保教师网络和学生网络在响应上的一致性,RCD提出了一种响应解耦一致性蒸馏损失函数,要求教师网络和学生网络在各自的响应(TCR和NTCR)上保持一致。具体来说,RCD的损失函数可以写为:

![]()

其中:

LTCR:目标类别响应一致性损失,鼓励学生网络在目标类别上的响应与教师网络保持一致。

LNTCR:非目标类别响应一致性损失,鼓励学生网络在非目标类别上的响应与教师网络保持一致。

标类别响应一致性(TCR)

目标类别响应一致性损失要求学生网络的目标类别预测与教师网络的目标类别预测保持一致。这可以通过最小化目标类别预测概率的差异来实现。例如,如果教师网络预测目标类别为 yt,学生网络预测目标类别为 ys,则损失函数可以表示为:

其中,Ps(yi)和 Pt(yi)分别是学生网络和教师网络在目标类别 yi上的预测概率。

非目标类别响应一致性(NTCR)

非目标类别响应一致性损失要求学生网络的非目标类别预测与教师网络的非目标类别预测保持一致。具体来说,非目标类别响应指的是对其他类别的预测概率。该损失函数鼓励学生网络不仅在目标类别上与教师网络一致,也要在其他类别上保持一致,以避免过度强调目标类别的响应,忽略其他类别的重要信息。

通过同时考虑目标类别和非目标类别的响应一致性,RCD方法确保学生网络能够全面地学习到教师网络的知识,从而提高情感分析的准确性。

五、实验

本文的实验部分旨在验证提出的多模态情感分析框架的有效性,尤其是在面对模态缺失时,提出的CorrKD(Correlation Knowledge Distillation)策略的优势。实验涉及多个数据集、不同的缺失模态情况以及与现有方法的对比。以下是实验部分的总结:

1. 实验设置与数据集

本文进行了广泛的实验,使用了三个常用的多模态情感分析数据集:

MOSI(Multimodal Opinion Sentiment Intensity):包含视频数据,结合了文本、音频和视觉模态,用于评估情感分析模型。

MELD(Multimodal EmotionLines Dataset):基于对话的情感分析数据集,包含文本、音频和视觉信息。

EmoReact:另一个情感分析数据集,结合了文本、音频和视觉模态。

2. 实验任务

实验的核心任务是评估多模态情感分析模型在不同模态缺失情况下的表现,重点关注以下两个方面:

模态缺失的影响:通过模拟不同模态的缺失情况,评估模型在缺失单一模态(例如缺失语言、视觉或音频模态)时的性能。

模型鲁棒性:在模态缺失的情况下,验证CorrKD方法对学生网络的知识转移效果,以及其在多模态情感分析中的优势。

3. 缺失模态的设置

为了模拟现实中可能出现的模态缺失问题,实验采用了以下两种模态缺失方式:

内模态缺失(Intra-modality missingness):某一模态内的信息丢失,例如音频或视觉数据缺失。

跨模态缺失(Inter-modality missingness):不同模态之间信息丢失,例如只有文本模态可用,音频和视觉模态缺失。

4. 对比基线

为了验证提出方法的有效性,本文与多个基线方法进行了对比:

传统的单模态和多模态模型:包括基于文本、音频和视觉单独进行情感分析的模型,以及常见的多模态情感分析方法。

基于知识蒸馏的模型:与传统的知识蒸馏(KD)方法进行对比,评估在模态缺失的情况下,CorrKD方法的优势。

自监督学习和多任务学习方法:为了进一步验证方法的普适性,本文也对比了一些自监督学习和多任务学习框架。

5. 实验结果

实验结果表明,CorrKD方法在模态缺失情况下显著优于其他基线方法,具体表现如下:

在完整模态的情况下,CorrKD的表现已经优于传统的多模态学习方法,尤其是在准确率和F1得分等指标上。

在单一模态缺失的情况下,CorrKD展现出了强大的鲁棒性,能够有效地补充缺失模态带来的信息丢失,尤其是在缺失视觉或音频模态时,文本信息能够较好地补偿缺失的信息。

在跨模态缺失的情况下,即只有文本模态可用时,CorrKD依然能够通过知识蒸馏和类别引导原型蒸馏策略,显著提升学生网络的性能,甚至在某些情况下超过完整模态的表现。

与知识蒸馏方法对比,CorrKD在模型鲁棒性和稳定性上有明显的优势。特别是在面对模态缺失时,传统知识蒸馏方法的效果不如CorrKD,后者能够更好地学习跨模态的共性特征。

6. 消融实验

为了验证CorrKD框架中各个组件的必要性,本文进行了消融实验,主要探讨以下几个方面:

去除响应解耦一致性蒸馏(RCD):当去掉RCD时,模型在模态缺失情况下的性能显著下降,表明RCD对于保持学生网络和教师网络的响应一致性至关重要。

去除类别引导原型蒸馏(CPD):没有CPD时,模型在分类性能上有所下降,尤其在处理缺失模态时,无法有效地捕捉类别间的特征差异。

去除样本级对比蒸馏(SCD):如果去掉样本级对比蒸馏,模型在不同模态缺失情况下的鲁棒性明显变差,说明SCD对于在缺失模态情况下恢复语义信息非常重要。

7. 定量与定性分析

定量分析:通过标准的评估指标,如准确率(Accuracy)、宏平均F1分数、加权F1分数等,CorrKD在所有数据集和各种模态缺失情况下均表现出色。

定性分析:通过可视化学生网络和教师网络的中间层特征,发现CorrKD在模态缺失时能够更好地捕捉到情感特征,尤其是在复杂情感类别的分类上。

8. 结论

实验结果表明,CorrKD框架在多模态情感分析中具有显著优势,尤其是在模态缺失的情况下。其通过响应解耦一致性蒸馏(RCD)和类别引导原型蒸馏(CPD)策略有效地提升了学生网络的情感推理能力,增强了模型的鲁棒性。相比其他基线方法,CorrKD能够更好地处理模态缺失问题,最终提升情感分析任务的性能。

六、结论

在本文中,我们提出了一个关联解耦知识蒸馏框架(CorrKD),旨在解决多模态情感分析(MSA)任务中多种模态缺失问题。具体来说,我们提出了一种基于样本级对比蒸馏机制,该机制利用对比学习捕捉并传递跨样本关联,以精确重建缺失的语义。此外,我们还提出了一种类别引导原型蒸馏机制,通过类别原型学习跨类别关联,从而优化与情感相关的语义,并提升联合表示的质量。最终,我们提出了一种响应解耦一致性蒸馏方法,以促进教师网络和学生网络之间的分布对齐。大量实验验证了我们框架的有效性。

156

156

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?