1. K均值聚类

1.1 算法介绍

先来看看官方的定义:

Kmeans算法是最常用的聚类算法,主要思想是:在给定K值和K个初始类簇中心点的情况下,把每个点(亦即数据记录)分到离其最近的类簇中心点所代表的类簇中,所有点分配完毕之后,根据一个类簇内的所有点重新计算该类簇的中心点(取平均值),然后再迭代的进行分配点和更新类簇中心点的步骤,直至类簇中心点的变化很小,或者达到指定的迭代次数。

OMG,头都大了,不复杂的东西硬生生的弄得让人搞不明白。

这个图很好的展现了什么是Kmeans方法。通俗点讲,算法就是将相似的的样本聚合在一起,例如说170-180的人为一个团体,180-190的人一个团体。这个团体就是定义中所说的簇,给定K值就是我们需要分k个团体,怎样,这样解释是不是一下就豁然开朗了呢。

大家可能会想,不就是分类么,为什么不叫Kmeans分类呢,让我们解读一下两者的定义。

分类:类别是已知的,通过对已知分类的数据进行训练和学习,找到这些不同类的特征,再对未分类的数据进行分类。属于监督学习。

聚类:事先不知道数据会分为几类,通过聚类分析将数据聚合成几个群体。聚类不需要对数据进行训练和学习。属于无监督学习。

聚类是需要我们手动设置数据分为几个群体,也不需要对数据进行训练与学习,这也就是Kmeans的关键点所在。

1.2 算法原理

既然是分类,那么总会需要一个分类标准,Kmeans中的分类标准就是要找到组的簇,类似于一个组的大哥,剩下的样本就是小弟,与大哥离得越近,这些小弟就被分在了最近大哥的组。这样形容已经将算法本质给讲出来了,就是距离,聚类簇质心越近,我们就将这些样本分为一类。

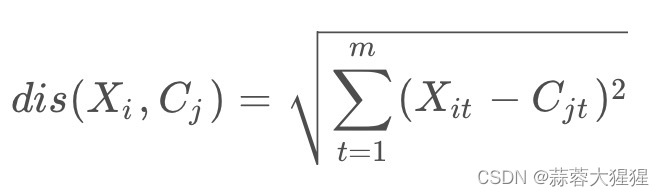

根据每个样本的特征与质心的特征计算之间的差值,谁离得近大家就能在一起抱团。

问题来了,既然要跟着老大抱团,谁是老大?

每个样本谁也不服谁,老大的位置总该定个规矩:集众家之所长的人是老大。

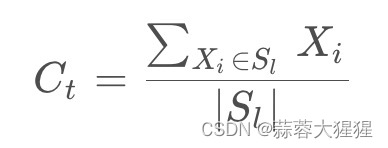

在最开始,选取样本任意k个点作为老大(质心),结成不同的组,在内部推举,根据组内每个点的加总取平均找到新的质心,再重复进行上述操作,直到质心不再改变为止。

总结一下Kmeans的过程就是:

1.将数据分为K类;

2.随机选取K个数据作为初始的聚类中心,计算每个数据与各个聚类中心之间的距离,把每个数据分配给距离它最近的聚类中心。

3.聚类中心以及分配给它们的数据就代表一个聚类。每分配一个数据,聚类的聚类中心会根据聚类中现有的数据被重新计算。这个过程将不断重复直到满足某个终止条件。

4.终止条件可以是没有(或最小数目)数据被重新分配给不同的聚类,没有(或最小数目)聚类中心再发生变化,误差平方和局部最小。

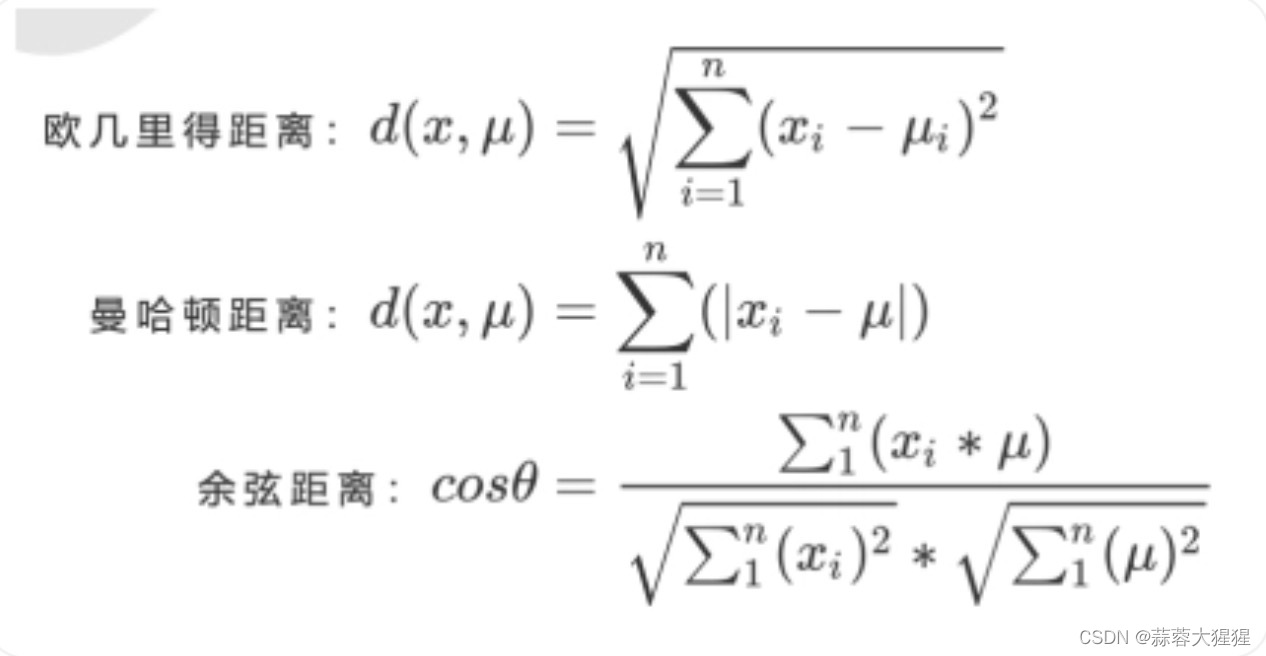

1.3 距离标准

样本点到质心的距离有多种方式进行计算:

2. 手写代码实现

def distEclud(vecA,vecB): #距离算法

return np.sqrt(np.sum(np.power(vecA - vecB,2),1))

def randCent(dataSet,k):

n = np.shape(dataSet)[1] #特征数量

centroids = np.mat(np.zeros((k,n)))

for j in range(n):

minJ = min(dataSet[:,j]) #特征中的最小值

rangeJ = float(max(dataSet[:,j]) - minJ) #最大值与最小值的差

centroids[:,j] = minJ + rangeJ * np.random.rand(k,1) #生成最小值与最大值之间中间的值

return centroids在实现算法之前我们先将辅助函数定义,distEclud计算样本到质心的欧几里得距离。

第二个函数随机产生k个质心点。

#K-均值聚类算法

def kMeans(dataset,k,distMeans=distEclud,createCent=randCent):

m = np.shape(dataset)[0] #获得样本个数

clusterAssment = np.mat(np.zeros((m,2))) #存放样本的分类信息

centroids = createCent(dataset,k) #随机生成簇

clusterChanged = True #判断质心是否改变

while clusterChanged:

clusterChanged = False

for i in range(m): #对于每个样本

minDist = 10000; minIndex = -1 #默认最小句无穷大,最小簇为 -1

for j in range(k): #样本对于每个簇

distJI = distMeans(centroids[j,:],dataset[i,:]) #向量运算,保存每个样本与簇之间的距离

#print(distJI)

if distJI < minDist: #保存样本距离最小的质心

minDist = distJI #替换最小

minIndex = j #最小距离的簇

if clusterAssment[i,0] != minIndex: clusterChanged = True #如果最小距离的簇发生了改变

clusterAssment[i,:] = minIndex,minDist**2 #存放该样本的簇,最小距离的平方

#print(centroids)

for cent in range(k): #对于每个簇进行更新

ptsInClust = dataset[np.nonzero(clusterAssment[:,0].A==cent)[0]] #clusterAssment中与簇相同的取出

centroids[cent,:] = np.mean(ptsInClust,axis=0) #对于每个簇中的每个特征取均值

return centroids,clusterAssment通过不断的计算迭代,最终得到我们的k个簇。

3. 调包实现

from sklearn.cluster import KMeans

Kmeans = KMeans(n_clusters=4)

Kmeans.fit(X)

y_kmeans = Kmeans.predict(X)4. K均值聚类算法优点与局限性

4.1 优点

1. 高效:算法收敛速度快,通常几次迭代后就能达到收敛状态。

2. 适用性广泛: 在许多实际应用中表现良好,例如图像压缩,文本分类与市场细分

4.2 局限性

1. 需要预先指定k值:通常需要通过实验或其他方式来选择合适的k值。

2.对初始值敏感:结果对初始质心的选择非常敏感,不同初始质心可能导致不同的聚类结果。

3. 无法处理不同大小和密度的簇:对于不同大小或密度的簇,K均值可能无法正确聚类。

5. 聚类度量

5.1 轮廓系数(Silhouette Coefficient)

在K-Means均值聚类中,如果我们不断去增加蔟的数量,SSE会不断去减少,因此每一个点会变成独立的蔟,这是不合理的。

所以在此引入轮廓系数,帮助我们去定量地去评估每个数据点在当前蔟中适应程度,同时考虑其与最邻蔟之间的相似度。

轮廓系数s(i):衡量数据点i对其蔟的适应程度:

簇内紧密度(a(i)):即数据点 i与同簇中其他所有点的平均距离:

簇间分离度(b(i)):即数据点 i 与距离其他簇中所有点的平均距离,选择最近的一个蔟:

轮廓系数的值范围在-1到1之间,越接近于1,说明数据点很适合当前蔟,且与其他的蔟有明显的分离,若小于0,说明当前的蔟分配可能是错误的,应该移动到其他的蔟。

总轮廓系数:

整个聚类的质量可以通过所有数据点的轮廓系数的平均值来衡量:

通过比较不同的蔟数量下的总轮廓系数,挑选最适合的蔟的数量。

代码实现

from sklearn.metrics import silhouette_score

import numpy as np

range_n_clusters = [2, 3, 4, 5] #定义聚类数目

for n_clusters in range_n_clusters: #try different numbers of clusters

km = KMeans(n_clusters=n_clusters, random_state=324)

cluster_labels = km.fit_predict(X)

#report average Silhouette score

silhouette_avg = silhouette_score(X, cluster_labels) #计算该模型的轮廓系数的平均值

print("For n_clusters ={},".format(n_clusters)+" the average silhouette_score is :{}".format(silhouette_avg))sklearn库中为我们直接提供了轮廓系数的方法,为其传入两个参数,第一个为我们训练集,第二个就是训练集中样本所对应的真实标签。

6. 应用前景

1. 图像处理和计算机视觉:

-图像压缩:将图像的像素聚类到K个簇,每个簇的质心表示簇内所有像素,达到压缩的效果。

-图像分割:聚类到不同簇,识别和分割图像中的不同对象。

2. 市场营销:

-客户细分与产品推荐。

3. 交通与物流:

-路线优化: 对地理位置数据进行聚类,优化运输路线与物流配送。

-交通流量分析: 对交通流量数据进行聚类,识别出交通拥堵区域和高峰时段。

4. 生物信息学:

-基因表达分析: 将基因表达数据聚类,以此识别具有相似表达模式的基因。

-蛋白质结构分类: 根据蛋白质的特征进行聚类。

5. 文本分析和自然语言处理:

-文本分析: 将相似的文本或文档聚类在一起,用于新闻分类。

-情感分析: 通过对文本进行聚类,识别出不同的情感或者观点。

7. 参考资料

《机器学习实战》

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?