课程九学习笔记: 自监督ViT算法:BeiT和MAE

自监督+ Transformer

1. SSL在NLP中的应用:

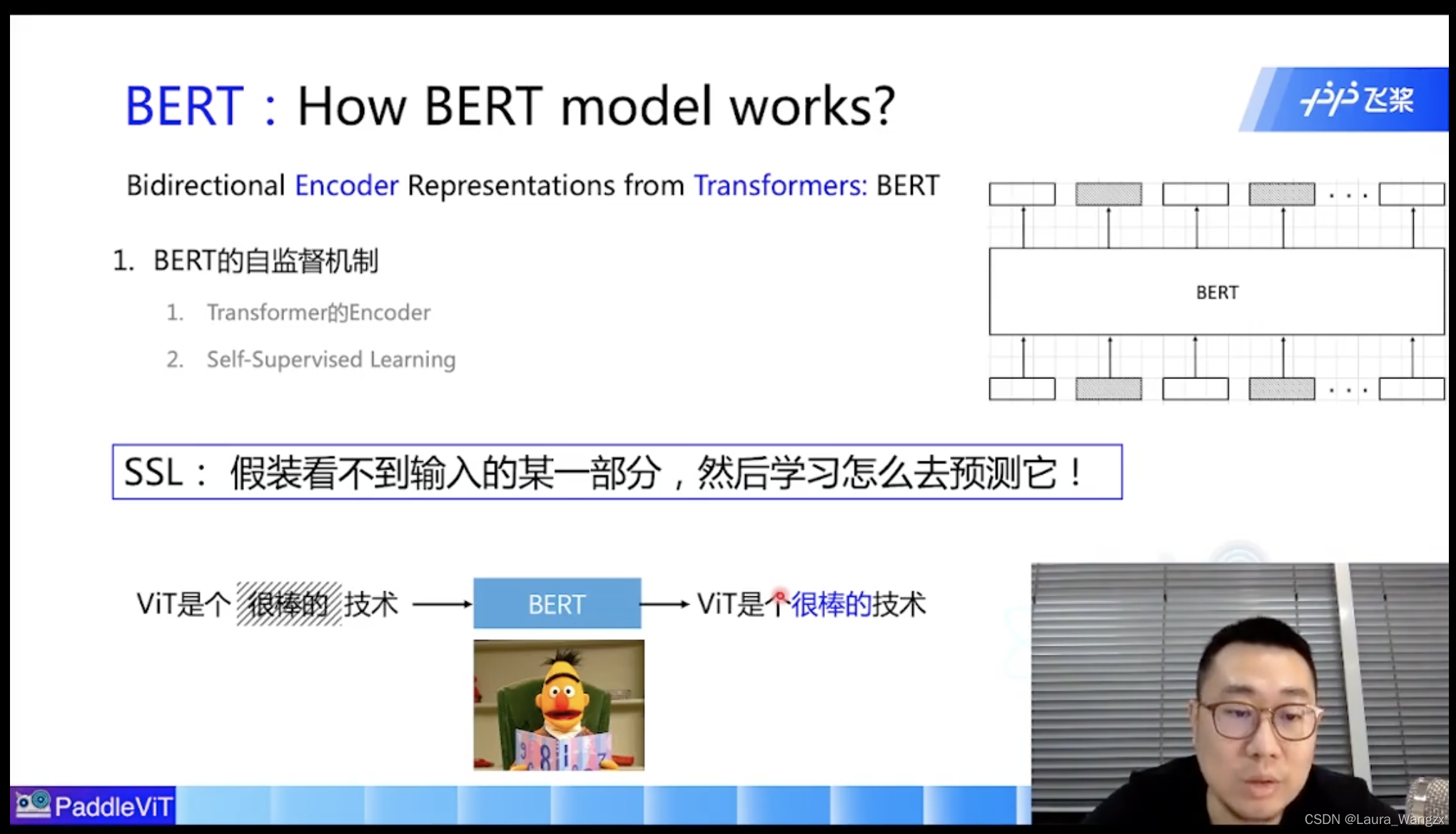

- Self-Supervised Learning (SSL):通过自己“监督”自己的方式学习通用特征表达,用来作为下游任务的预训练或者backbone。(自监督学习SSL:假装看不到输入的某一部分 ,然后学习怎么去预测它!)

- Bidirectional Encoder Representations from Transformers :(BERT)

(1)Transformer的Encoder

(2)Self-Supervised Learning ( SSL )

2. Bert

Bert:学习通用的表征。

Bert训练目标:

1.Masked Token Prediction + Next sentence prediction ( joint training )

该博客探讨了Self-Supervised Learning (SSL)在自然语言处理中的应用,并介绍了BERT的训练目标。接着,文章引入了将自监督学习应用于图像任务的BEiT模型,以及Masked Autoencoders for Scalable Vision Learning (MAE)的工作原理,包括预训练和下游任务的训练策略。此外,还讨论了在实践中如何管理和配置实验参数。

该博客探讨了Self-Supervised Learning (SSL)在自然语言处理中的应用,并介绍了BERT的训练目标。接着,文章引入了将自监督学习应用于图像任务的BEiT模型,以及Masked Autoencoders for Scalable Vision Learning (MAE)的工作原理,包括预训练和下游任务的训练策略。此外,还讨论了在实践中如何管理和配置实验参数。

订阅专栏 解锁全文

订阅专栏 解锁全文

381

381

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?