课程六学习笔记:Swin Transformer-1

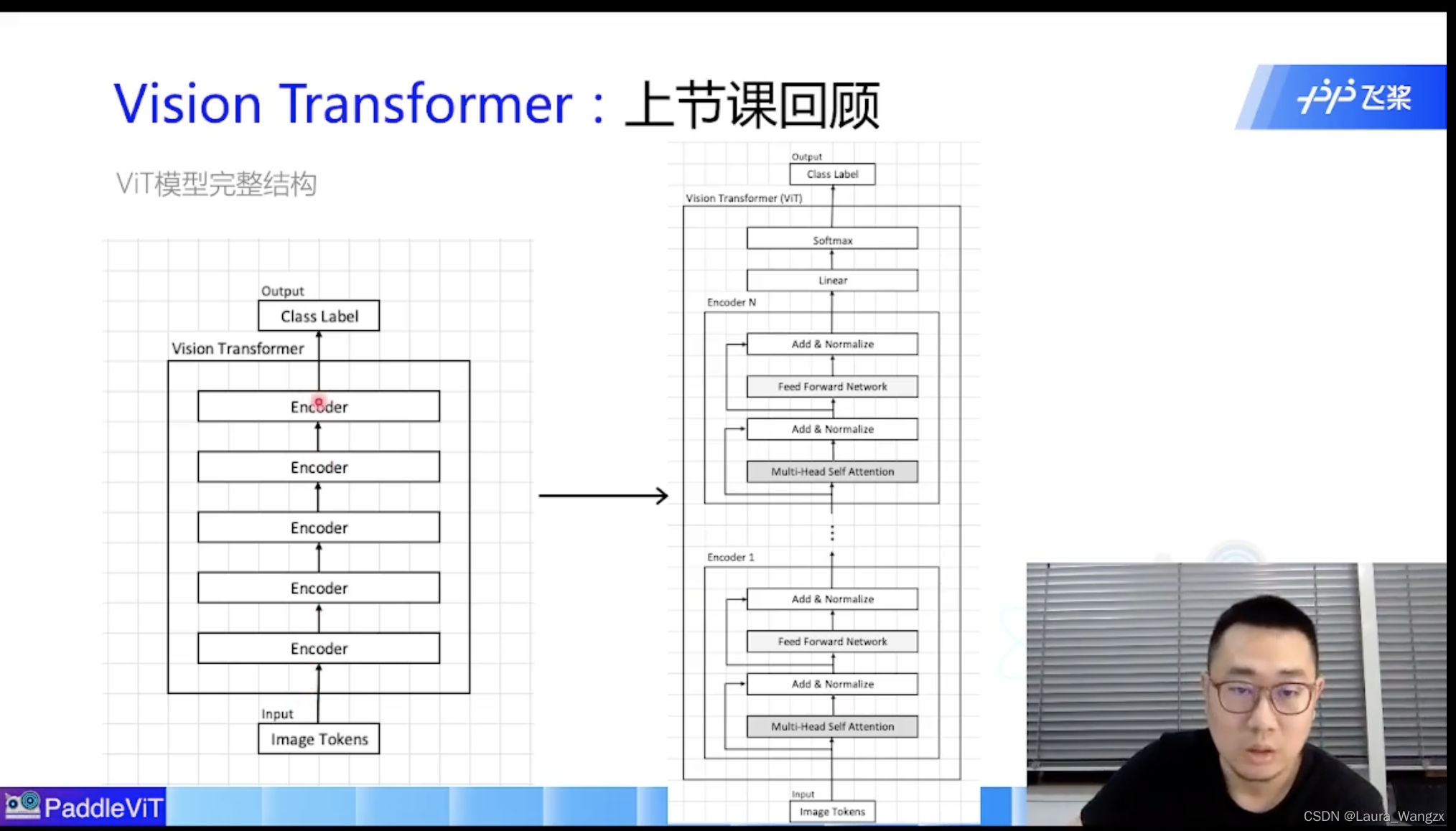

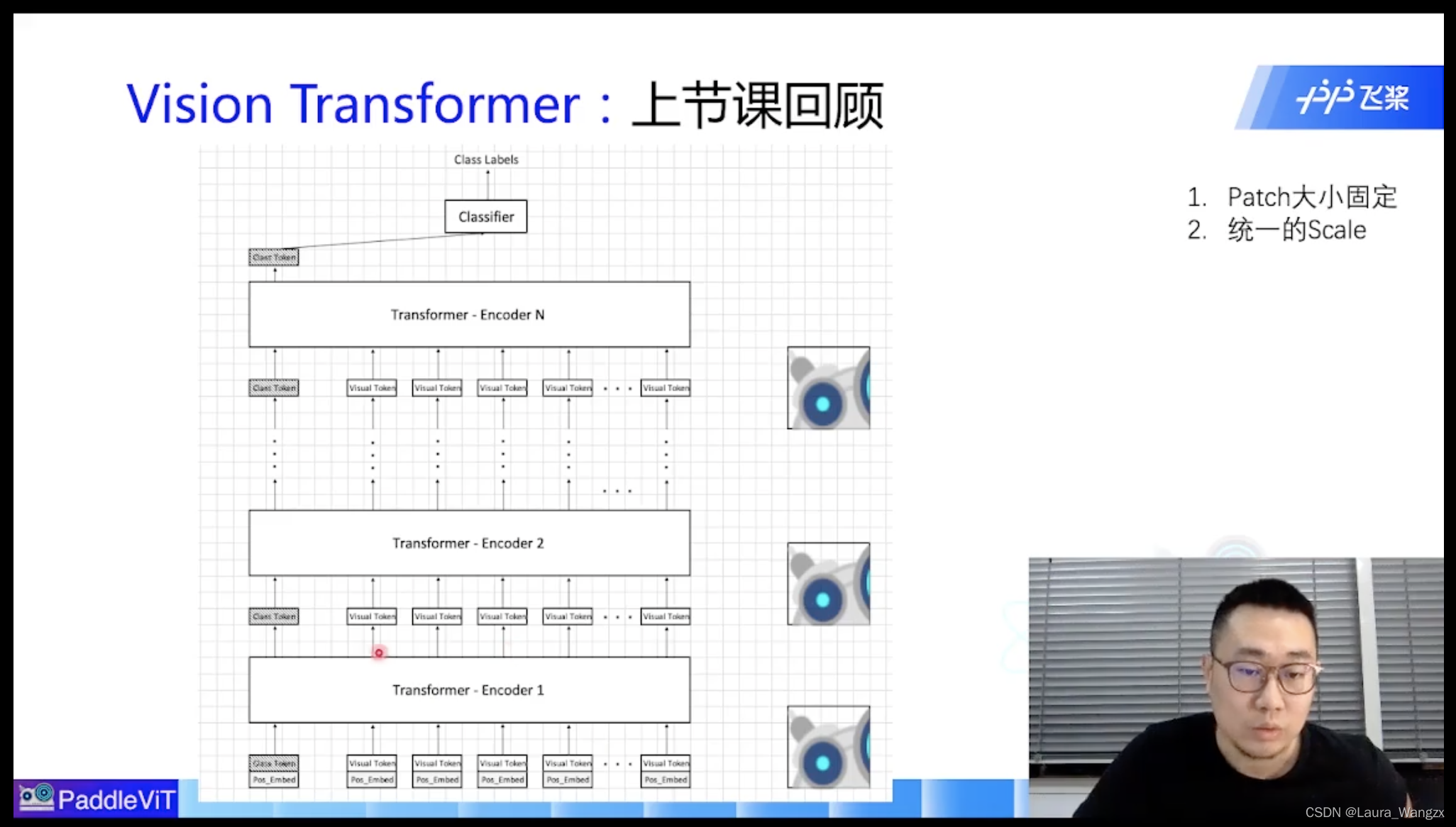

1. Vision Transformer回顾

即使添加了Class-Token,实际上也保持着相同的Patch大小。

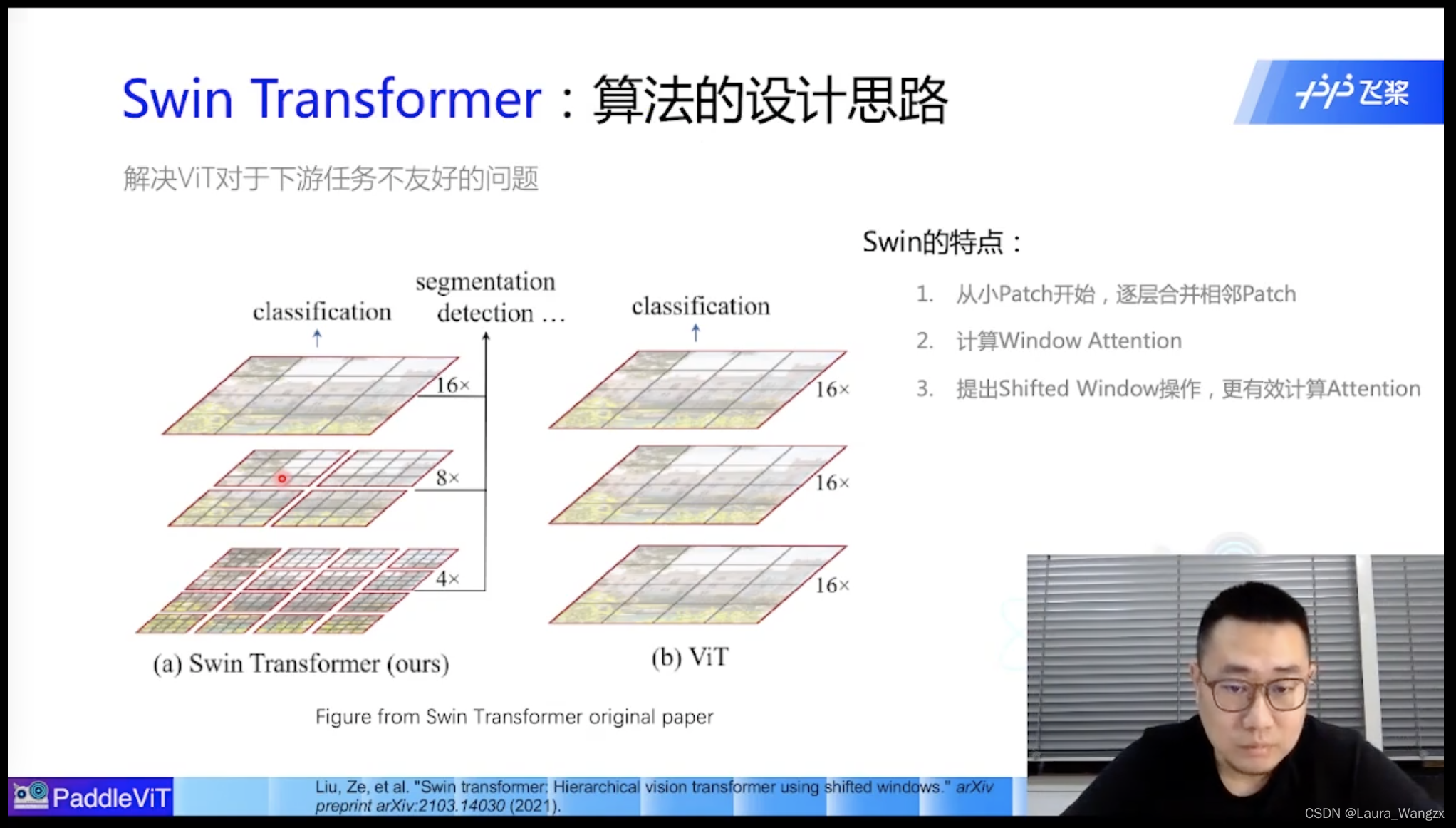

而对于一张图而言,做分类的话,Patch大一点,可以捕捉到很多的信息;但是做目标检测等其他任务而言,我们需要更小的粒度(调节Patch的大小),Patch很小,可能会带来计算量的问题;Patch正常可能会不能很好的做下游任务。——————Swin Transformer诞生

2. Swin Transformer

Swin的特点: 1.从小Patch开始 ,逐层(Transformer Encoder)合并相邻Patch 2.计算Window Attention 3.提出Shifted Window操作,更有效计算Attention

1.网络结构操作:

Patch Merging:每过一层将P

本文详细介绍了Swin Transformer的设计思想和结构,包括从大块补丁开始,逐步合并邻近补丁的过程,以及通过窗口注意力机制提高计算效率。Swin Transformer在视觉任务中提供了一种更细粒度的注意力模型,降低了计算复杂度,提高了性能。

本文详细介绍了Swin Transformer的设计思想和结构,包括从大块补丁开始,逐步合并邻近补丁的过程,以及通过窗口注意力机制提高计算效率。Swin Transformer在视觉任务中提供了一种更细粒度的注意力模型,降低了计算复杂度,提高了性能。

订阅专栏 解锁全文

订阅专栏 解锁全文

375

375

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?