机器学习和深度学习

文章平均质量分 65

一些算法知识

hellobigorange

她是一只善良、正直爱吃橙子的大橙子

展开

专栏收录文章

- 默认排序

- 最新发布

- 最早发布

- 最多阅读

- 最少阅读

-

Tensorflow

目录一、Tensorflow优点和基础架构二、Tensorflow核心概念1、计算图2、操作节点3、变量4、会话三、Tensorflow 实现原理一、Tensorflow优点和基础架构1、优点2、基础架构二、Tensorflow核心概念计算图、运算操作、变量、会话1、计算图1) 什么是计算图?2) 计算图的构造流程2、操作节点3、变量1) 变量的创建2)变量的初始化3)变量的保存和恢复4、会话三、Tensorflow 实现原理...原创 2020-06-02 19:08:35 · 909 阅读 · 0 评论 -

mnist_softmax_xla分析

目录一、ArgumentParser二、tf.ConfigProto() 和 XLA JIT编译三、RunOptions和RunMetadata和Timeline四、代码一、ArgumentParser二、tf.ConfigProto() 和 XLA JIT编译三、RunOptions和RunMetadata和Timeline四、代码from __future__ import absolute_importfrom __future__ import divisionfro原创 2020-06-14 20:01:21 · 376 阅读 · 0 评论 -

权值初始化,batch,epoch,iterations

权值初始化权值初始化原创 2020-06-08 21:51:26 · 223 阅读 · 0 评论 -

梯度优化方法:BGD,SGD,mini_batch, Momentum,AdaGrad,RMSProp,Adam

文章目录目标函数三种梯度下降优化框架1、BGD、SGD、mini_batch2、**优缺点对比:**3、**问题与挑战:**优化梯度下降法1、动量梯度下降法(Momentum)2、Nesterov Accelarated Gradient(NAG)3、Adagrad4、RMSprop5、Adaptive momentum estimation(Adam)目标函数最优化:得到使目标函数J(θ)J(\theta)J(θ)最小的θ\thetaθ的值。三种梯度下降优化框架1、BGD、SGD、mini原创 2022-03-25 16:05:50 · 1668 阅读 · 15 评论 -

生成对抗网络(GAN)

GAN基础1、GAN本质及组成2、GAN数学原理3、GAN优缺点,可能改进方式二、深度GAN(DCGAN)三、条件GAN(cGAN)文字约束文字加位置约束图片约束四、Info GNN五、WGNN...原创 2020-05-06 21:06:15 · 505 阅读 · 0 评论 -

推荐算法

文章目录简介1、推荐系统实验方法2、评测指标协同过滤算法用户行为数据简介简介推荐系统应用都是由前台的展示页面、后台的日志系统以及推荐算法系统3部分构成的基于用户行为推荐算法,用户推荐好友,基于位置的服务打包销售以从用户的历史行为中习得用户的兴趣模型1、推荐系统实验方法在推荐系统中,主要有3种评测推荐效果的实验方法,即离线实验(offline experiment)、用户调查(user study)和在线实验(online experiment)。2、评测指标1)用户满意度2)预原创 2020-06-29 17:27:05 · 644 阅读 · 0 评论 -

CNN_AlexNet,VGG,GoogLeNet,ResNet,DeepFace

一、AlexNet(现代神经网络起源)1)解决问题:ImageNet Challenge:1000类别图片,每类图片有1000张2)AlexNet结构3)参数计算主要是全连接层的参数多4)影响深度学习开始标志卷积网络的基本构成:卷积层+池化层+全连接层第一个 base model:花朵种类,鸟类种类识别二、VGG(AlexNet增强版)VGG结构与AlexNet对比...原创 2020-01-16 09:47:13 · 323 阅读 · 0 评论 -

迁移学习

定义:将一个场景中学习到的知识迁移到另一个场景中应用。迁移学习顾名思义就是把已经训练好的模型的参数迁移到新的模型来帮助新模型的训练。考虑到大部分的数据或任务是存在相关性的,所以通过迁移学习我们可以将已经学习到的模型参数,通过某种方式来分享给新的模型,从而加快优化模型的学习效率不用像大多数模型那样从零开始。例子:为什么需要迁移学习?使用深度学习技术解决问题的过程中,最常见的障碍在于,因为模型有大量的参数需要训练,因此需要海量训练数据作支撑。在面对某一领域的具体问题时,通常可能无法得到构建模型所原创 2020-05-10 19:58:39 · 848 阅读 · 0 评论 -

keras中文文档

keras中文文档转载 2021-09-13 13:58:55 · 662 阅读 · 0 评论 -

深度学习_总体介绍

机器学习和深度学习的区别:应用无人驾驶无人超市自动翻译个人助手(NLP+语音识别)优点学习能力强覆盖范围广,适应性强可移植性好缺点计算量大,便携性差模型设计复杂框架TensorFlow,Pytorch,Caffe...原创 2020-01-11 13:38:42 · 303 阅读 · 0 评论 -

深度学习_神经网络

一、线性回归橙子的线性回归:最小二乘&梯度下降二、神经网络1、常用非线性激励函数(梯度损失概念)由于梯度损失问题(sigmoid 和tanh求导大部分值小于1),我们深度学习中一般只有最后一层用sigmoid,深度学习往往用ReLu作为非线性激励函数2、为什么要用非线性激励,没有线性回归网络吗?正向传播+反向计算(链式法则)3、损失函数(Loss)1)softm...原创 2020-01-12 22:17:40 · 271 阅读 · 0 评论 -

深度学习_CNN

CNN反向推导链式法则链式法则求导示例卷积神经网络也是这样一层一层从后到前传递梯度的,有了梯度后,就可以更新参数。上图中max模拟了池化过程,此时部分神经元失活。CNN—卷积层注意若卷积层为3*3的则,上图卷积输出为30*30*1,因为边缘不作为卷积核中心计算。n个卷积核产生n个输出(n个激励特征图)(如下图)。卷积核基本概念:同输入数据进行计算的二维(一维,三维)算子大小...原创 2020-01-14 18:31:07 · 596 阅读 · 0 评论 -

CPPN、孪生网络、强化学习

一、CPPN二、孪生网络孪生网络孪生网络是一种监督学习,用于度量学习。它的特点是它接收两个图片作为输入,而不是一张图片作为输入。Triplet 网络3、(~~)没听懂4、强化学习(~~我是懵的)...原创 2020-05-11 13:07:14 · 1047 阅读 · 0 评论 -

递归神经网络_RNN、LSTM、Word2Vec

一、RNN原理RNN的目的使用来处理序列数据。在传统的神经网络模型中,是从输入层到隐含层再到输出层,层与层之间是全连接的。序列数据往往前后时刻是相关的,因此用RNN。RNN特点1、权值共享,图中的W全是相同的,U和V也一样。2、每一个输入值都只与它本身的那条路线建立权连接,不会和别的神经元连接。前向传播st=tanh(Wst−1+Uxt)s_t=tanh(Ws_{t-1}+U...原创 2020-04-20 19:53:54 · 708 阅读 · 0 评论 -

RNN和CNN的结合

一、应用图片标注、视频行为分类、图片/视频问答(VQA)二、对比CNN和RNN三、图片自动标注补充(找出感兴趣区域,详细标注)四、视频行为识别问题定义:视频中正在发生什么3. RNN+CNN五、图片/视频问答纯文字问答和图片问答对比模型改进...原创 2020-05-04 10:29:37 · 2838 阅读 · 0 评论 -

专家系统学习

文章目录一、专家系统基础知识知识概述知识表达技术-规则基于规则的专家系统的结构前项链接和后项链接推理技术冲突消解元知识总结二、基于python的动物识别专家系统系统主要逻辑:一、专家系统基础知识知识概述知识是对于一个主题或者一个领域在理论或实践上的理解,也是所有已知的总和。拥有某一部分知识的人称为专家,他们是所在组织中重要的人物。知识表达技术-规则任何规则都包括两个部分:IF部分和ELSE部分。IF部分是前项(前提或者条件),THEN部分是后项(结论或者行为)。一般来说,前提之间可以使用关键词原创 2021-05-08 17:07:47 · 3472 阅读 · 0 评论 -

异常检测——孤立森林IsolationForest、PCA+马氏距离

孤立森林理论简介,和参数说明理解:最早被树分离出去(树的长度最短)的数据点,可能为异常点。不需要标准化,不需要PCA降维python实例import requestsimport matplotlib.pyplot as pltfrom sklearn.ensemble import IsolationForestimport numpy as npfrom sklearn import preprocessingfrom sklearn.decomposition import PCA原创 2021-08-26 14:36:18 · 2455 阅读 · 4 评论 -

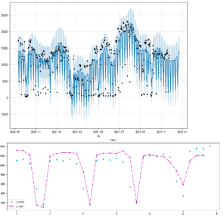

随机序列模型

文章目录一、随机序列1、平稳序列2、非平稳随机序列二、ARMA模型1、自回归模型2、滑动平均模型3、自回归滑动平均模型一、随机序列1、平稳序列2、非平稳随机序列二、ARMA模型1、自回归模型2、滑动平均模型3、自回归滑动平均模型时间序列平稳性_ADF检验...原创 2021-05-24 09:28:23 · 1922 阅读 · 0 评论 -

sklearn+机器学习

文章目录一、KNN1.1 KNN实现分类1.1.1 二分类1.1.2 多分类1.2 回归二、线性回归4.1 正则化4.1.1 岭回归4.1.2 Lasso回归五、随机森林5.1参数说明5.2 随机森林应用5.3 随机森林做回归六、SVR6.1 参数说明6.2 SVM的优势和不足6.3 房价预测示例七、MLP7.1 参数7.2 优缺点7.3 调参经验八、数据预处理、降维、特征提取、聚类8.1 数据预处理8.1.1 StandardScaler数据预处理8.1.2 MinMaxScaler 数据预处理8.1.3原创 2021-04-02 16:45:18 · 2026 阅读 · 0 评论 -

时序数据的预测

文章目录时间序列分割TimeSeriesSplit时间序列分割TimeSeriesSplit机器学习中时间序列数据的训练集、验证集、测试集处理问题时间序列分割TimeSeriesSplit原创 2021-03-26 16:13:52 · 5194 阅读 · 0 评论 -

Word2Vec

word2vec将词转变为词向量。从而进行词之间的相似性度量。# etc/bin/python# -*- encoding: utf-8 -*-from time import timefrom gensim.models import Word2Vecclass LoadCorpora(object): def __init__(self, s): sel...原创 2020-01-07 08:43:20 · 372 阅读 · 0 评论 -

机器学习_HMM

HMM是一种结构简单的贝叶斯网络,主要用于时序数据建模,在语音识别,自然语言处理等领域有广泛应用。一、HMM概述1、HMM模型的网络结构上图为HMM模型的结构,其中[z1,z2,....,zn][z_1,z_2,....,z_n][z1,z2,....,zn]是不可观测的状态序列;[x1,x2,...,xn][x_1,x_2,...,x_n][x1,x2,...,xn]为观测序...原创 2019-12-10 17:44:16 · 365 阅读 · 0 评论 -

机器学习_主题模型LDA

1、LDA应用方向:2、与朴素贝叶斯文本分类的对比 D->T->W3、Γ\GammaΓ函数Γ\GammaΓ函数原创 2019-12-07 10:14:53 · 315 阅读 · 0 评论 -

机器学习_贝叶斯网络、朴素贝叶斯分类器

贝叶斯网络贝叶斯网络(Bayesian network),又称信念网络(belief network)或是有向无环图模型(directed acyclic graphical model),是一种概率图型模型。贝叶斯网络的关键在于网络结构和条件概率表。下列为一个简单的贝叶斯网络:有了网络结构和概率表就可以得到任意变量的联合概率分布。例题:通过贝叶斯网络确定条件独立朴素贝叶斯分类器...原创 2019-12-05 18:07:53 · 750 阅读 · 0 评论 -

机器学习_EM算法

Jesen不等式若f是凸函数(如f(x)=x2f(x)=x^2f(x)=x2),则f(Ex)≤E(f(x))f(Ex)\leq E(f(x))f(Ex)≤E(f(x))一、EM算法现实生活中,很多样本可能含有隐变量,这时候用似然法求模型参数是不现实的,我们考虑用EM算法。利用当前参数θ\thetaθ的估计值,来计算似然函数的期望;在计算使期望最大的θ\thetaθ值,反复迭代,至收敛。1、...原创 2019-12-02 11:52:07 · 380 阅读 · 0 评论 -

机器学习_鸢尾花数据集_python

数据集iris.data里面储存的鸢尾花特征和类别数据每一列的含义如下图所示SVM#!/usr/bin/python# -*- coding:utf-8 -*-import numpy as npimport pandas as pdimport matplotlib as mplimport matplotlib.pyplot as pltfrom sklearn im...原创 2019-11-28 15:01:22 · 4978 阅读 · 0 评论 -

机器学习-GB、GBDT、XGboost、Adaboost

概念argmin 的含义是什么?最通俗的理解:表示使目标函数取最小值时的变量值算法梯度提升决策树XGBoost与GBDT算法的区别:传统的GBDT在优化的时候只用到了一阶导数信息,而XGBoost则对代价函数进行了二阶泰勒展开,得到一阶和二阶导数,并且XGBoost在代价函数中加入了正则项,用于控制模型的复杂度。另外XGBoost还支持线性分类器,通过在代价函数中加入正...原创 2019-11-22 21:48:49 · 3496 阅读 · 0 评论 -

机器学习_决策树和随机森林

一、 熵1、信息熵:度量随机变量不确定性的标准,熵越大,信息量越大,不确定性越高,越混乱。2、条件熵:XXX已知的情况下,YYY的不确定性。3、相对熵:可以度量两个随机变量的距离。(KL散度)4、互信息:两个随机变量X,YX,YX,Y的互信息,定义为:X,YX,YX,Y的联合分布P(X,Y)P(X,Y)P(X,Y) 与边缘分布的乘积P(X)P(Y)P(X)P(Y)P(X)P(...原创 2019-11-14 11:59:58 · 520 阅读 · 1 评论 -

机器学习_线性回归

1、损失函数的推导过程高斯分布噪声服从高斯分布最大似然估计写出噪声的联合概率分布,求对数,求似然解最小二乘法得到L(θ)L(\theta)L(θ)最小时的最小二乘损失函数。线性回归一般形式:线性回归的向量写法:2、正则化加正则化项后,为了使损失函数最小,则需要让正则化项越小越好,从而使θ\thetaθ的值变小,甚至为零。λ\lambdaλ越大,为使J(θ)J(\...原创 2019-11-04 12:10:13 · 415 阅读 · 0 评论 -

PCA降维

1、赔率2、公交车堵车模型fuzzywuzzy-Levenshein distance(边际距离) 一个包,用于字符串的模糊查询与替换3、PCA引入PCA降维的原因是由于“维数灾难”,在机器学习中,过多的特征有时会使分类结果更差;或者是该特征是冗余特征。“维数灾难”是指计算量急剧增加,而分类精度下降。PCA降维,就是将高维特征(n维)投影到低维子空间(k维),从而实现特征的融合。1)...原创 2019-10-30 12:11:07 · 1671 阅读 · 0 评论 -

机器学习_高数(方向导数梯度、凸函数、Gamma函数、斯特林公式、泰勒公式)

...原创 2019-10-25 10:20:00 · 1720 阅读 · 0 评论 -

机器学习——导论

大数据和机器学习区别大数据做的是基本的数据存储和统计计算,机器学习是从大数据里面挖掘有价值的数据。项目描述:电信日志分析系统是以电信用户上网所产生的数据进行分析和统计计算,数据主要来源于用户的上网产生的访问日志和安全日志,通过Hadoop大数据平台完成日志的入库、处理、查询、实时分析、上报等功能,达到异常IP的检测、关键词过滤、违规违法用户的处理等,整个项目数据量在1T-20T左右,集群数量...原创 2019-10-16 09:53:00 · 308 阅读 · 0 评论 -

机器学习_聚类

1.观察距离最近样本点是否分类准确import numpy as npdef find_closest_centroids(X, centroids): K = centroids.shape[0] m = X.shape[0] idx = np.zeros(m) #用来存放每一个样本点的索引号 # ===================== Your Co...原创 2019-05-28 22:17:26 · 1629 阅读 · 1 评论 -

机器学习——线性模型

一个离散属性的机器学习问题,转为分类或线性模型的关键就是怎么把这些离散值属性,如高矮,红绿用数值表现出来。通常来说,对于有序的属性,如{高、矮、胖},我们可以用{1,0.5,0}表示。若属性中不存在有序关系,我们用向量来表示,如“西瓜”,“黄瓜”,“南瓜”可以转化为(1,0,0),(0,1,0),(0,0,1)。线性模型y1=x11w1+x12w2+...+x1dwdy2=x21w1+x22w...原创 2019-01-16 21:42:43 · 246 阅读 · 0 评论 -

吴恩达机器学习作业——ex1(Python)

用梯度下降法处理一元线性回归问题原创 2019-03-03 17:53:51 · 978 阅读 · 0 评论 -

吴恩达课后作业ex2——logistic regression(Python)

可以用梯度下降法或最优化方法寻找使J(theta)取得最小值时的theta值。这里附上python的最优化的代码。// An highlighted block%%%t是theta的位置,J(.)是编写的代价函数,返回值为代价cost和梯度graddef cost_func(t): return J(t, X, admmitor, dataset)[0]def grad_func...原创 2019-03-11 22:49:50 · 516 阅读 · 0 评论 -

吴恩达ex3 多分类逻辑回归与简单的神经网络(python)

写完ex3后,发现ex2的代价函数和梯度写的好傻帽, 这次完全采用向量化的写法。1.2 Visualizing the dataX是(5000,400)的维度,共5000组样本,每组样本有400个特征,对应输出样本Y(5000,1).// 这里的思路就是先任取100行,将这100个//样本的400个像素点reshape成(20,20)的array,//方便显示。每一副图占的位置要拼好了拼...原创 2019-04-10 18:14:29 · 815 阅读 · 3 评论 -

吴恩达——ex4神经网络的反向传播(Python)

快枯了,在枯之前终于写出来了。一、前向传播和代价函数我们可以看出,神经网络最终输出层hθh_{\theta}hθ为(5000,10),意思是5000个样本,它们对应分到(0,9)的概率大小,每一横行(i)代表对应的第i个样本输出为(0,9)的概率。这里的代价函数的含义与logistic regression里的是一样的,由于Y是(5000,1),且输出为0-9,故为计算J(θ)J_{(...原创 2019-04-23 22:22:12 · 928 阅读 · 0 评论 -

吴恩达——机器学习ex5(Regularized Linear Regression and Bias v.s. Variance)

1.1 Visualizing the datasetimport matplotlib.pyplot as pltimport scipy.iodata = scipy.io.loadmat('data/ex5data1.mat')# print(data.keys())'''绘制training data'''a = data['X']b = data['y']plt.s...原创 2019-05-07 09:33:06 · 970 阅读 · 0 评论 -

机器学习_SVM

1.常数C的作用从下面三张图可以看出SVM是大间距分类器,C越大,越容易考虑异常点,因而越容易过拟合。1.2 SVM with Gaussian Kernels1.2.1 Gaussian Kernel高斯核函数求f1,核函数其实就是样本点和标记点之间的一种相似性度量标准。1.2.2 Example Dataset 2...原创 2019-05-27 15:23:42 · 548 阅读 · 0 评论

分享

分享