https://en.wikipedia.org/wiki/Sum_of_normally_distributed_random_variables

wiki上讲的很清楚,特别是利用特征函数来证明的,证明非常简洁,主要是我最开始碰到复高斯的时候,没有想清楚

X

∼

C

N

(

0

,

σ

2

)

\boldsymbol X \sim {CN}(0,\sigma^2)

X∼CN(0,σ2)

a

=

e

+

1

j

∗

f

a = e+1j *f

a=e+1j∗f,

X

=

x

+

j

y

\boldsymbol X = x +j y

X=x+jy

然后我认为;

a

X

=

(

e

x

−

f

y

)

+

1

j

∗

(

e

y

+

f

x

)

a \boldsymbol X = (ex-fy) + 1j*(ey+fx)

aX=(ex−fy)+1j∗(ey+fx)

不再服从瑞利因为实部和虚部分布虽然独立,但分布不同

但是 实际上

E

(

a

X

)

=

a

E

(

X

)

=

0

\mathbb E(a \boldsymbol X ) =a \mathbb E(X) =0

E(aX)=aE(X)=0

方差就是

就是

E ( a X X H a H ) − E 2 ( a X ) = a 2 σ 2 \mathbb E(a \boldsymbol X \boldsymbol X ^H a^H) - \mathbb E^2(a\boldsymbol X) = a^2 \sigma^2 E(aXXHaH)−E2(aX)=a2σ2

直观上理解 a X = ( e x − f y ) + 1 j ∗ ( e y + f x ) a \boldsymbol X = (ex-fy) + 1j*(ey+fx) aX=(ex−fy)+1j∗(ey+fx),就是因为期望是0,而且方差的话,就是相加,所以还是同分布的,如果x,y期望不是0的话,应该就不是瑞利了,不过瑞利本来就是均值为0,的独立同分布高斯随机变量的 平方和,所以整个就是我自己没有理解到位

结论就是 复高斯也满足线性可加的性质,跟瑞不瑞利没啥关系

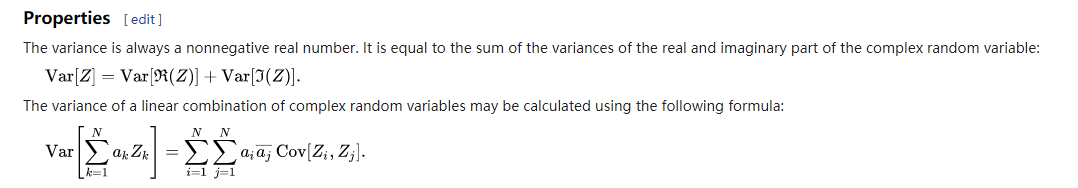

本文探讨了复高斯随机变量在线性组合下的性质,特别关注其期望和方差的变化,证实了即使在复数域内,高斯随机变量依然保持良好的线性可加性。

本文探讨了复高斯随机变量在线性组合下的性质,特别关注其期望和方差的变化,证实了即使在复数域内,高斯随机变量依然保持良好的线性可加性。

777

777

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?