<think>好的,我现在需要解决用户的问题,即编写Python代码来计算分类模型在训练集和测试集上的准确率、精确率、召回率、F1分数和AUC值,并绘制ROC曲线。同时,用户还希望得到相关的解释。我得仔细思考如何一步步实现这些指标的计算,并确保代码正确无误。首先,用户提到的几个指标都是分类任务中常用的评估指标。我需要回忆每个指标的计算方法和所需的库。准确率是正确预测的比例,精确率是正例预测中真实正例的比例,召回率是真实正例中被正确预测的比例,F1是精确率和召回率的调和平均。AUC值则需要计算ROC曲线下的面积,而ROC曲线是以假正率为横轴,真正率为纵轴绘制的曲线。

接下来,我需要考虑使用哪些Python库。通常,scikit-learn(sklearn)提供了这些指标的计算函数,比如accuracy_score、precision_score、recall_score、f1_score、roc_auc_score,以及绘制ROC曲线所需的roc_curve。此外,可能需要matplotlib来绘图。然后,我需要确保用户已经有了训练好的分类模型。假设用户已经将模型训练好,并且对训练集和测试集进行了预测,得到了概率预测结果(如y_train_pred_prob和y_test_pred_prob)。通常,为了得到精确率等指标,需要将概率转换为类别标签,比如通过设置阈值(默认0.5)来决定正类和负类。

接下来,代码的结构应该是这样的:1. 导入必要的库。

2. 使用模型对训练集和测试集进行预测,得到预测标签和预测概率。3. 分别计算各个指标,对训练集和测试集分别处理。

4.绘制ROC曲线,需要计算每个数据集的fpr和tpr,然后使用matplotlib绘图。

需要注意的问题包括:

- 确保预测概率是正类的概率,通常roc_auc_score需要传入正类的概率。

-处理多分类问题时可能需要调整参数,但用户的问题可能默认是二分类,所以假设是二分类的情况。- 在计算精确率、召回率时,如果数据不平衡,可能需要指定average参数,比如average='binary'或者'micro'等,需要根据情况调整。这里假设二分类,使用默认的average参数。

现在,编写代码的大致步骤:

首先,导入所需的库:

from sklearn.metrics import accuracy_score, precision_score,recall_score, f1_score, roc_auc_score, roc_curve

import matplotlib.pyplot as plt然后,假设model是已经训练好的分类器,X_train, X_test是训练和测试特征,y_train, y_test是真实标签。

对训练集和测试集进行预测:y_train_pred =model.predict(X_train)

y_train_pred_prob = model.predict_proba(X_train)[:, 1] #获取正类的概率y_test_pred= model.predict(X_test)

y_test_pred_prob = model.predict_proba(X_test)[:,1]

然后,计算各个指标:对于训练集:train_accuracy =accuracy_score(y_train, y_train_pred)

train_precision= precision_score(y_train, y_train_pred)

train_recall = recall_score(y_train, y_train_pred)

train_f1 = f1_score(y_train, y_train_pred)

train_auc= roc_auc_score(y_train, y_train_pred_prob)

同样地,测试集的计算类似。

接下来,绘制ROC曲线,需要分别计算训练集和测试集的fpr和tpr:

fpr_train, tpr_train, _ =roc_curve(y_train, y_train_pred_prob)fpr_test,tpr_test,_ = roc_curve(y_test, y_test_pred_prob)

然后使用plt绘图,添加图例、标题等。

最后,将所有的指标打印出来,或者以表格形式展示。但是,用户可能需要将训练集和测试集的指标分开显示,所以可能需要分别处理。

现在,将这些步骤整合成代码。需要注意的是,有些模型可能没有predict_proba方法,比如SVM默认没有,需要设置probability=True。但用户的问题中可能使用的是逻辑回归等有概率输出的模型。假设这里模型支持predict_proba。

现在,编写完整的代码示例:

```pythonfrom sklearn.metrics import accuracy_score, precision_score,recall_score, f1_score, roc_auc_score, roc_curve

import matplotlib.pyplot as pltdef evaluate_model(model, X_train,y_train, X_test, y_test):

#训练集预测y_train_pred= model.predict(X_train)

y_train_prob = model.predict_proba(X_train)[:,1]# 测试集预测

y_test_pred = model.predict(X_test)y_test_prob= model.predict_proba(X_test)[:, 1]#计算训练集指标train_metrics = {'Accuracy': accuracy_score(y_train,y_train_pred),'Precision': precision_score(y_train, y_train_pred),

'Recall': recall_score(y_train, y_train_pred),'F1':f1_score(y_train, y_train_pred),

'AUC': roc_auc_score(y_train, y_train_prob)}

#计算测试集指标

test_metrics = {'Accuracy':accuracy_score(y_test, y_test_pred),

'Precision': precision_score(y_test, y_test_pred),'Recall': recall_score(y_test,y_test_pred),'F1': f1_score(y_test, y_test_pred),'AUC':roc_auc_score(y_test,y_test_prob)}# 打印结果print("训练集指标:")for metric,value in train_metrics.items():print(f"{metric}: {value:.4f}")print("\n测试集指标:")for metric,value in test_metrics.items():print(f"{metric}: {value:.4f}")# 绘制ROC曲线plt.figure(figsize=(8,6))# 训练集ROCfpr_train,tpr_train,_ = roc_curve(y_train, y_train_prob)

plt.plot(fpr_train,tpr_train,label=f'TrainAUC = {train_metrics["AUC"]:.2f}')# 测试集ROC

fpr_test, tpr_test, _= roc_curve(y_test,y_test_prob)plt.plot(fpr_test, tpr_test, label=f'Test AUC= {test_metrics["AUC"]:.2f}')

plt.plot([0,1], [0, 1], 'k--') #绘制对角线plt.xlabel('FalsePositive Rate')plt.ylabel('TruePositive Rate')plt.title('ROCCurve')

plt.legend(loc='lower right')plt.show()# 示例使用:

# 假设model是已训练好的分类器,X_train, y_train等数据已准备好

# evaluate_model(model, X_train, y_train, X_test,y_test)

```解释代码:

-evaluate_model函数接受模型和训练测试数据,计算各项指标。

-使用model.predict得到预测标签,model.predict_proba得到概率。

-计算各指标并存储到字典中,便于打印。- 绘制ROC曲线时,分别计算训练集和测试集的FPR和TPR,并绘制曲线,同时显示AUC值。

-绘制对角线作为参考线,表示随机猜测的效果。

需要注意的是,如果数据中存在多分类的情况,上述代码可能需要调整,比如在计算precision、recall等指标时指定average参数。例如,对于多分类问题,可能需要使用average='macro'或其他选项。但用户的问题中可能默认是二分类,所以暂时按二分类处理。相关问题可能涉及这些指标的含义、如何处理多分类、不同模型对概率输出的支持情况,或者如何调整阈值来影响这些指标等。</think>以下是计算分类模型评估指标并绘制ROC曲线的Python代码实现:

```python

from sklearn.metrics import (accuracy_score, precision_score, recall_score,

f1_score, roc_auc_score, roc_curve)

import matplotlib.pyplot as plt

def evaluate_model(model, X_train, y_train, X_test, y_test):

# 训练集预测

y_train_pred = model.predict(X_train)

y_train_proba = model.predict_proba(X_train)[:, 1]

# 测试集预测

y_test_pred = model.predict(X_test)

y_test_proba = model.predict_proba(X_test)[:, 1]

# 训练集指标计算

train_metrics = {

'Accuracy': accuracy_score(y_train, y_train_pred),

'Precision': precision_score(y_train, y_train_pred),

'Recall': recall_score(y_train, y_train_pred),

'F1': f1_score(y_train, y_train_pred),

'AUC': roc_auc_score(y_train, y_train_proba)

}

# 测试集指标计算

test_metrics = {

'Accuracy': accuracy_score(y_test, y_test_pred),

'Precision': precision_score(y_test, y_test_pred),

'Recall': recall_score(y_test, y_test_pred),

'F1': f1_score(y_test, y_test_pred),

'AUC': roc_auc_score(y_test, y_test_proba)

}

# 打印指标结果

print("训练集评估指标:")

for metric, value in train_metrics.items():

print(f"{metric}: {value:.4f}")

print("\n测试集评估指标:")

for metric, value in test_metrics.items():

print(f"{metric}: {value:.4f}")

# 绘制ROC曲线

plt.figure(figsize=(10, 6))

# 训练集ROC

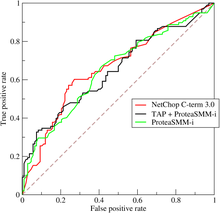

fpr_train, tpr_train, _ = roc_curve(y_train, y_train_proba)

plt.plot(fpr_train, tpr_train, label=f'Train ROC (AUC = {train_metrics["AUC"]:.2f})')

# 测试集ROC

fpr_test, tpr_test, _ = roc_curve(y_test, y_test_proba)

plt.plot(fpr_test, tpr_test, label=f'Test ROC (AUC = {test_metrics["AUC"]:.2f})')

plt.plot([0, 1], [0, 1], 'k--', label='Random Guessing')

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic (ROC) Curve')

plt.legend(loc='lower right')

plt.show()

# 使用示例(需要替换为实际模型和数据):

# from sklearn.linear_model import LogisticRegression

# model = LogisticRegression().fit(X_train, y_train)

# evaluate_model(model, X_train, y_train, X_test, y_test)

```

代码解释:

1. `accuracy_score`:计算正确预测样本占总样本的比例

2. `precision_score`:计算预测为正类的样本中实际为正类的比例

3. `recall_score`:计算实际为正类的样本中被正确预测的比例

4. `f1_score`:精确率和召回率的调和平均数

5. `roc_auc_score`:计算ROC曲线下方面积值

6. `roc_curve`:计算绘制ROC曲线所需的FPR和TPR值

7. 函数最终会输出表格形式的评估指标和可视化的ROC曲线

1330

1330

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?