宝子们👋,在机器学习的江湖里,各种算法就像不同门派的武功秘籍📜,各有各的绝招。今天咱就来好好唠唠机器学习算法里最常见的四大门派——监督学习、无监督学习、半监督学习和强化学习,让你们轻松掌握它们的精髓😎!

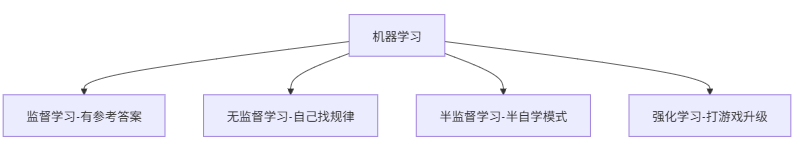

一、机器学习“班级”全景图

学习前我们先看一下机器学习“班级”全景图,让我们看下班级中有哪些学生吧~

简答说班级中主要有四类学生:

- 监督学习 👉 有参考答案,老师手把手教解题(给输入+标准答案)

- 无监督学习 👉 让学生自己解题,找规律

- 半监督学习 👉 老师只批改部分作业,给少量答案,大量题目,学生自学

- 强化学习 👉 打游戏攒经验值(做对加分/做错扣血)

下面我们详细介绍下这四种分类。

二、监督学习:有“老师”指导的乖乖学生🧐

1、主要任务

监督学习就像有个贴心的“老师”在旁边指导👩🏫,它的主要任务是根据输入的数据和对应的标签(也就是“答案”),学习出一个模型,然后用这个模型去预测新的数据的标签。简单来说,就是“有样学样”,根据已知的例子来预测未知的。

2、关键元素

- 训练数据:这是一堆带有标签的数据,就像老师给学生准备的例题和答案。比如,要训练一个识别猫和狗的模型,训练数据就是各种猫和狗的图片,并且每张图片都标注好了是猫还是狗。

- 特征:这是描述数据的特点,就像例题的解题思路。对于图片数据,特征可以是颜色、形状、纹理等等。

- 标签:就是数据的“答案”,在识别猫和狗的例子中,标签就是“猫”或者“狗”。

- 模型:这是通过训练数据学习出来的“解题方法”,它可以根据输入的特征来预测标签。

3、常见场景

- 图像分类:比如识别手写数字、人脸识别等。

- 语音识别:把语音转换成文字。

- 回归预测:比如预测房价、股票价格等。

# 示例代码:使用线性回归进行房价预测(监督学习)

import numpy as np

from sklearn.linear_model import LinearRegression

# 生成一些模拟数据(房屋面积和对应的房价)

X = np.array([[100], [150], [200], [250], [300]]) # 房屋面积(特征)

y = np.array([300, 450, 600, 750, 900]) # 房价(标签)

# 创建线性回归模型

model = LinearRegression()

# 训练模型

model.fit(X, y)

# 预测新的房屋面积对应的房价

new_X = np.array([[180]])

predicted_price = model.predict(new_X)

print(f"预测的房价为: {predicted_price[0]}")

三、无监督学习:自己“找乐子”的探索者🤔

1、主要任务

无监督学习就像一个没有老师指导,自己“找乐子”的探索者🧐。它的主要任务是对没有标签的数据进行聚类、降维等操作,发现数据中的潜在结构和模式。也就是说,它要从一堆没有“答案”的数据中,自己找出规律来。

2、关键元素

- 无标签数据:这是一堆没有标注“答案”的数据,就像一堆没有解题思路的题目。

- 聚类算法:用于把相似的数据点归为一类,就像把相似的题目放在一起。

- 降维算法:用于减少数据的维度,就像把复杂的题目简化成更简单的形式。

3、常见场景

- 客户细分:把客户按照购买行为、消费习惯等进行分类。

- 异常检测:比如检测信用卡欺诈交易、网络入侵等。

- 数据可视化:把高维的数据可视化成二维或三维的图形,方便观察数据的分布。

# 示例代码:使用K-Means聚类算法进行客户细分(无监督学习)

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

# 生成一些模拟的客户数据(消费金额和购买次数)

X = np.array([[100, 5], [200, 8], [300, 12], [400, 15], [500, 20], [600, 25], [700, 30]])

# 创建K-Means聚类模型,假设分为3类

kmeans = KMeans(n_clusters=3)

# 训练模型并进行聚类

kmeans.fit(X)

labels = kmeans.labels_

# 可视化聚类结果

plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis')

plt.xlabel('消费金额')

plt.ylabel('购买次数')

plt.title('客户细分聚类结果')

plt.show()

四、半监督学习:“半吊子”的聪明学生😕

1、主要任务

半监督学习就像一个“半吊子”的聪明学生😕,它既有少量的有标签数据,又有大量的无标签数据。它的主要任务是利用这些少量的有标签数据和大量的无标签数据来训练模型,提高模型的性能。

2、关键元素

- 少量有标签数据:这是用来给模型“打基础”的数据,就像老师给学生讲的一些重点例题。

- 大量无标签数据:这是用来辅助模型学习的数据,就像学生自己做的练习题。

- 半监督学习算法:用于结合有标签数据和无标签数据来训练模型。

3、常见场景

- 文本分类:比如对大量的网页文章进行分类,但只有少量的文章有标签。

- 图像识别:比如识别一些罕见的动物图片,只有少量的图片有标签。

五、强化学习:爱“打游戏”的智能体🎮

1、主要任务

强化学习就像一个爱“打游戏”的智能体🎮,它的主要任务是在一个环境中,通过不断地尝试和反馈来学习最优的行为策略,以获得最大的奖励。就像在游戏里,智能体要不断地尝试不同的操作,看看哪个操作能获得更高的分数。

2、关键元素

- 智能体:这是进行学习和决策的主体,就像游戏里的角色。

- 环境:这是智能体所处的外部世界,就像游戏里的场景。

- 状态:描述智能体在环境中的当前情况,就像游戏里角色的位置、血量等。

- 动作:智能体在环境中可以采取的行为,就像游戏里角色的移动、攻击等操作。

- 奖励:智能体采取动作后,环境给予的反馈,就像游戏里角色获得的分数或惩罚。

3、常见场景

- 机器人控制:比如让机器人学会走路、抓取物体等。

- 游戏:比如训练人工智能玩围棋、象棋、电竞游戏等。

- 自动驾驶:让汽车学会在不同的路况下做出最优的驾驶决策。

# 示例代码:使用Q-Learning算法训练智能体玩简单的游戏(强化学习简化版)

import numpy as np

# 定义游戏环境的状态和动作

states = ['S1', 'S2', 'S3', 'S4']

actions = ['A1', 'A2']

# 初始化Q表

Q = np.zeros((len(states), len(actions)))

# 定义奖励矩阵和转移概率矩阵(简化版)

rewards = np.array([[0, 10], [5, 0], [0, 5], [10, 0]]) # 到达不同状态的奖励

next_states = [[1, 2], [0, 3], [1, 3], [2, 2]] # 采取动作后到达的下一个状态索引

# 学习参数

alpha = 0.1 # 学习率

gamma = 0.9 # 折扣因子

episodes = 100 # 训练轮数

# Q-Learning算法

for episode in range(episodes):

current_state = 0 # 初始状态

while True:

# 选择动作(这里简单使用随机选择)

action = np.random.randint(len(actions))

# 获取下一个状态和奖励

next_state_idx = next_states[current_state][action]

reward = rewards[current_state][action]

# 更新Q表

Q[current_state, action] = Q[current_state, action] + alpha * (reward + gamma * np.max(Q[next_state_idx]) - Q[current_state, action])

# 更新当前状态

current_state = next_state_idx

# 如果到达终止状态(这里假设S3和S4是终止状态),结束本轮

if current_state == 2 or current_state == 3:

break

print("训练后的Q表:")

print(Q)

六、总结📌

宝子们,今天咱们一起了解了机器学习算法里的四大门派——监督学习、无监督学习、半监督学习和强化学习😃。监督学习就像有老师指导的学生,无监督学习是自己探索的探索者,半监督学习是“半吊子”的聪明学生,强化学习则是爱“打游戏”的智能体。它们在不同的场景下都有各自的优势和应用。

希望这篇文章能让你对机器学习算法有更清晰的认识🤗。如果你还有其他关于机器学习的问题,欢迎在评论区留言讨论哦👏!咱们下期再见啦👋!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?