Dify 中 Function Calling 与 MCP(Model Context Protocol)使用不同使用场景对比解析

一、Function Calling(函数调用):大模型的「外部能力接口」

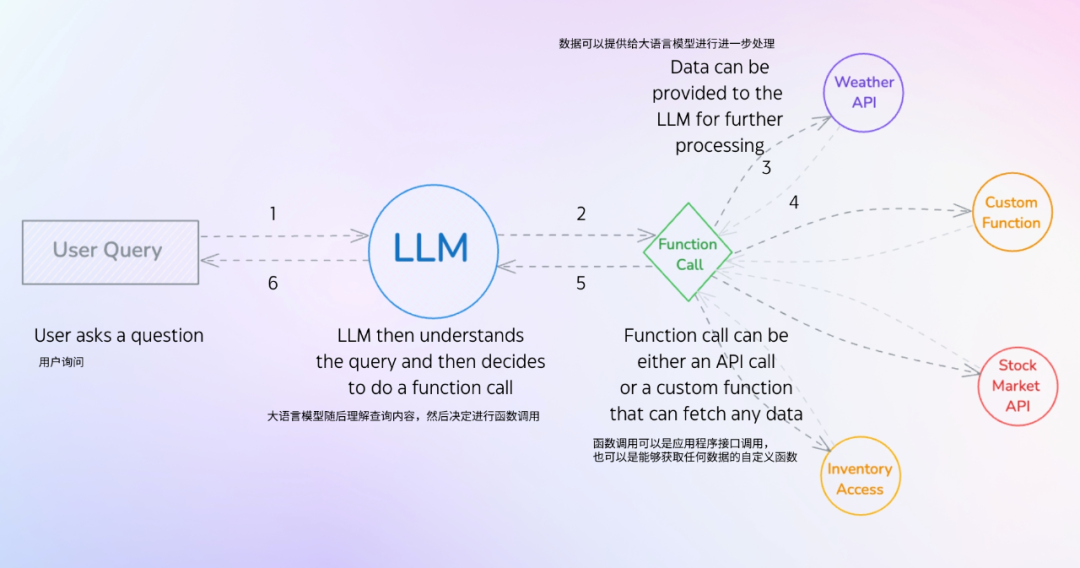

Function Calling 是大语言模型与外部工具交互的核心机制,允许模型在处理任务时主动触发外部工具(如 API、本地服务、数据库),并将工具返回结果整合到响应中。其本质是通过标准化协议(如 JSON 格式指令)打通「模型决策」与「工具执行」的闭环,解决模型无法直接完成的实时数据获取、专业计算、文件操作等任务。

核心逻辑拆解:

-

触发条件:当模型判断任务需要外部数据或能力(如查询天气、计算税率)时,自动生成工具调用指令;

-

协议规范:Dify 要求工具调用参数符合 JSON Schema,例如调用天气 API 时需指定城市参数:

JSON

{

3. 流程闭环:用户提问 → 模型生成调用指令 → 工具返回数据 → 模型解析数据并生成自然语言回答。

典型应用场景:

-

实时数据查询

:调用股票 API 返回当前股价;

-

格式转换

:调用 PDF 解析工具提取文档内容;

-

专业计算

:调用税务工具计算企业所得税。

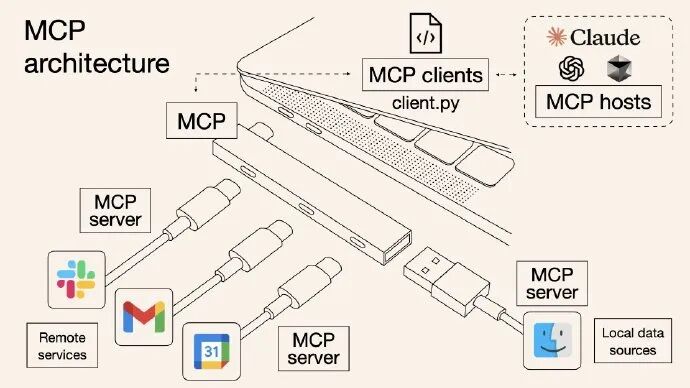

二二、MCP(Model Context Protocol,模型上下文协议):多轮对话的「状态管理者」

MCP 是一种定义模型上下文传递规则的协议,专注于管理多轮对话中的状态信息(如历史对话、用户偏好、中间计算结果),确保模型在多轮交互中保持上下文一致性。其核心价值在于:

-

上下文结构化存储

:将对话历史、工具调用结果等信息按协议格式(如 JSON 对象)封装,避免长文本对话导致的上下文丢失;

-

跨轮次参数传递

:在多轮对话中传递关键参数(如用户 ID、订单号),支持后续工具调用或模型推理;

-

上下文裁剪与优化

:根据对话长度自动裁剪无效历史,避免上下文过长导致模型性能下降。

Dify 中 MCP 的实现细节:

-

上下文格式

:采用键值对结构存储状态,例如: json

JSON

{

-

上下文管理策略

:支持自定义上下文保留时长、关键参数置顶等功能,例如电商场景中始终保留用户收货地址。

三三、Function Calling 与 MCP 的核心差异:能力外延 vs 状态维系

| 维度 | Function Calling(函数调用) | MCP(模型上下文协议) |

|---|---|---|

| 本质目标 | 扩展模型的外部执行能力(调用工具完成具体任务) | 维护模型的内部状态一致性(管理多轮对话上下文) |

| 解决问题 | 模型缺乏实时数据、专业工具等「能力短板」 | 多轮对话中上下文丢失、参数传递混乱等「状态问题」 |

| 交互对象 | 外部工具 / 服务(API、本地函数) | 模型自身的对话状态(历史记录、中间参数) |

| 数据流向 | 模型 → 工具 → 模型(单向能力调用) | 轮次间上下文传递(双向状态维护) |

| Dify 实现 | 通过工具注册接口与 SDK 完成单次调用 | 通过上下文管理模块实现跨轮次状态存储与传递 |

四

四、场景对比:何时选择 Function Calling 或 MCP?

场景一:机票预订助手

-

Function Calling 应用

:用户询问 “北京到上海明天的机票价格”,模型调用航班查询 API 获取实时票价,属于单次工具能力调用;

-

MCP 应用

:用户完成航班查询后继续说 “帮我预订该航班”,MCP 自动传递前序查询的航班号、价格等上下文参数,避免用户重复输入。

场景二:财务报表分析

-

Function Calling 应用

:模型调用数据库接口查询企业营收数据,再调用图表生成工具可视化数据;

-

MCP 应用

:用户追问 “对比去年同期数据” 时,MCP 保留前序查询的时间范围参数,自动传递给下一次数据库查询,确保上下文连贯。

场景三:医疗咨询机器人

-

Function Calling 应用

:根据患者描述调用医学知识库 API 生成诊断建议;

-

MCP 应用

:患者多轮咨询时,MCP 记录病史、症状等上下文,避免重复询问关键信息。

五五、Dify 中两者的协同实践:构建闭环智能应用

在实际开发中,Function Calling 与 MCP 常需协同工作。以电商客服为例:

-

用户提问

:“我买的商品什么时候到货?”

-

MCP 作用

:从上下文中提取用户订单号(如通过历史对话获取);

-

Function Calling 作用

:调用物流查询 API,传入订单号获取物流状态;

-

结果整合

:模型解析物流数据,结合上下文生成回答:“您的订单(单号:ORD123)目前在上海分拣中心,预计明天送达。”

协同关键点:

- MCP 为 Function Calling 提供必要的上下文参数(如订单号、用户偏好);

- Function Calling 的结果可作为新的上下文存入 MCP,支持后续对话延续。

六、总结:能力边界与状态基石的双重驱动

Function Calling 是大模型突破 “知识茧房” 的「破局利器」,通过外部工具扩展能力边界;而 MCP 是保障多轮交互体验的「基础设施」,通过上下文管理让模型具备 “记忆能力”。在 Dify 平台中,前者解决 “模型能做什么” 的问题,后者解决 “模型如何记住怎么做” 的问题。开发者需根据业务需求灵活组合:若需调用外部工具,优先设计 Function Calling 接口;若涉及多轮对话或状态依赖,需通过 MCP 构建上下文管理体系,最终实现从 “单次功能调用” 到 “全流程智能交互” 的升级。

大模型算是目前当之无愧最火的一个方向了,算是新时代的风口!有小伙伴觉得,作为新领域、新方向人才需求必然相当大,与之相应的人才缺乏、人才竞争自然也会更少,那转行去做大模型是不是一个更好的选择呢?是不是更好就业呢?是不是就暂时能抵抗35岁中年危机呢?

答案当然是这样,大模型必然是新风口!

那如何学习大模型 ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。但是具体到个人,只能说是:

最先掌握AI的人,将会比较晚掌握AI的人有竞争优势。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

但现在很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习路线完善出来!

在这个版本当中:

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型路线+学习教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

1212

1212

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?