Coze Studio 是字节跳动开源的低代码 AI Agent 开发平台。通过可视化工具,开发者无需或只需少量代码即可快速构建、调试智能体、应用和工作流,大幅降低开发门槛,是构建定制化 AI 产品的理想选择。其基于 Golang (后端) 和 React + TypeScript (前端),采用微服务与 DDD 架构,提供高性能、高扩展性和易于二次开发的框架。

目前开源 Coze Studio 版本支持以下功能:

本文将手把手带您从零开始,在您的本地计算机上部署 Coze Studio 开源版,并配置本地 Ollama 和 OpenRouter 上的模型服务。

1. 安装 Ollama:拥有你的私人大模型

Ollama 是一个轻量级、可扩展的本地大语言模型运行框架。它让在个人电脑上运行强大的语言模型(如 DeepSeek-R1, Qwen 3, Gemma 3 等)变得前所未有的简单。

你不再需要依赖任何第三方的云服务,可以在完全离线的环境中,利用 AI 处理你的私有数据,安全且免费。

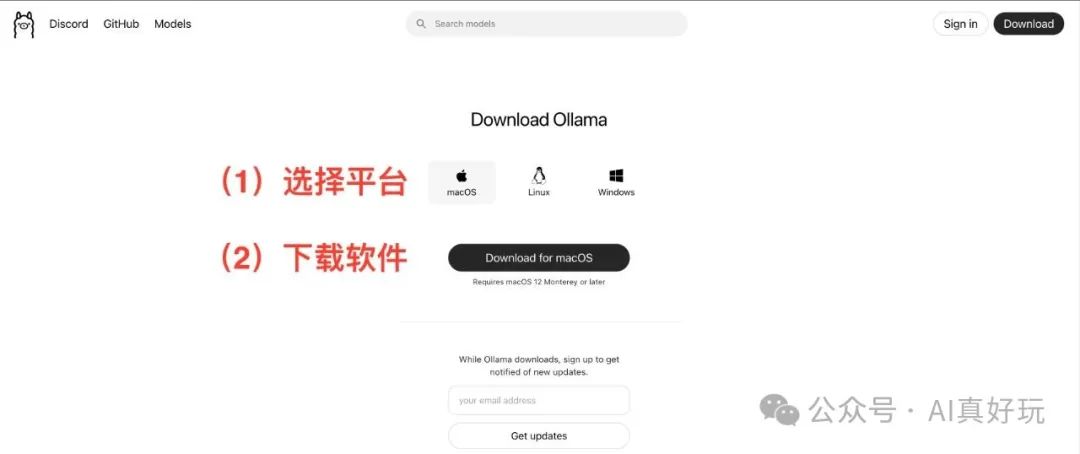

访问 https://ollama.com/,根据你的操作系统(macOS, Linux, Windows)下载并安装对应的客户端。安装过程非常直观,一路点击 “下一步” 即可。

拉取模型

安装完成后,我们需要从 Ollama 的模型库中下载一个模型到本地。以广受欢迎的 Qwen 3 模型为例。

Ollama Qwen3 提供的模型列表如下图所示,如果你想要下载量化模型,可以点击 View all 链接:

(图片来源:https://ollama.com/library/qwen3)

不同大小的模型对内存的要求不同:

-

7B 模型:需要约 8-16GB RAM

-

14B 模型:需要约 16-32GB RAM

-

32B 模型:需要约 32-64GB RAM

-

70B+ 模型:需要 64GB+ RAM

打开你的终端(Terminal 或命令提示符),输入以下命令:

ollama run qwen3:8b

# or

ollama run qwen3:14b

# or

ollama run qwen3:32b

这个命令会自动从云端下载并解压 Qwen 3 模型。下载速度取决于你的网络状况,请耐心等待。

2. 安装 Docker:应用部署的瑞士军刀

Docker 是一种容器化技术,它可以将应用程序及其所有依赖项打包到一个标准的、可移植的“容器”中。通俗地说,Docker 就像一个标准化的集装箱,而 n8n 就是货物。我们把 n8n 放进这个集装箱里,就可以轻松地在任何支持 Docker 的机器上运行它,而不用担心复杂的环境配置和依赖冲突问题。

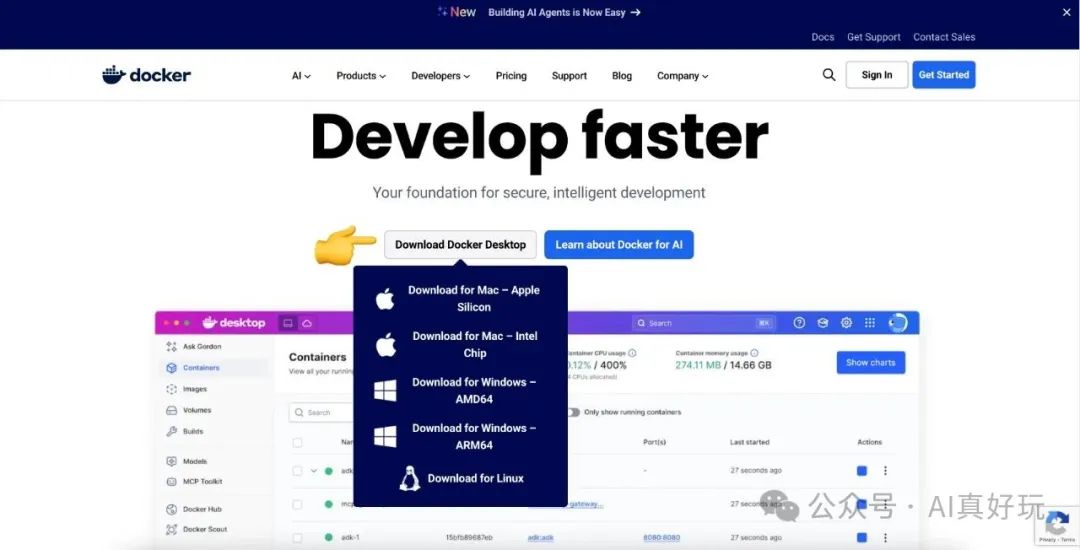

访问 https://www.docker.com/,下载并安装 Docker Desktop。它同样为 macOS, Linux 和 Windows 提供了图形化的安装界面。

3. 本地部署 Coze Studio

3.1 环境要求

-

在安装 Coze Studio 之前,请确保您的机器满足以下最低系统要求: 2 Core、4 GB

-

提前安装 Docker、Docker Compose,并启动 Docker 服务。

3.2 获取 Coze Studio 源码

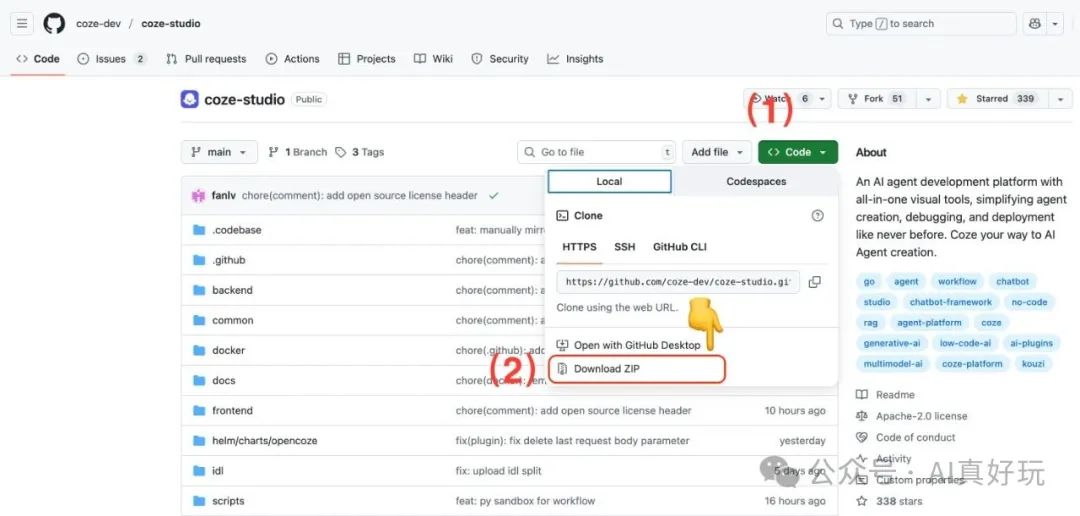

使用 git clone 命令前,需要确保本机已安装 Git。

git clone https://github.com/coze-dev/coze-studio.git

如果本机未安装 Git,你也可以通过以下方式下载源码:

3.3 为 Coze Studio 配置模型

Coze Studio 支持的模型服务如下:

-

Ark(火山方舟)

-

OpenAI

-

DeepSeek

-

Claude

-

Ollama

-

Qwen

-

Gemini

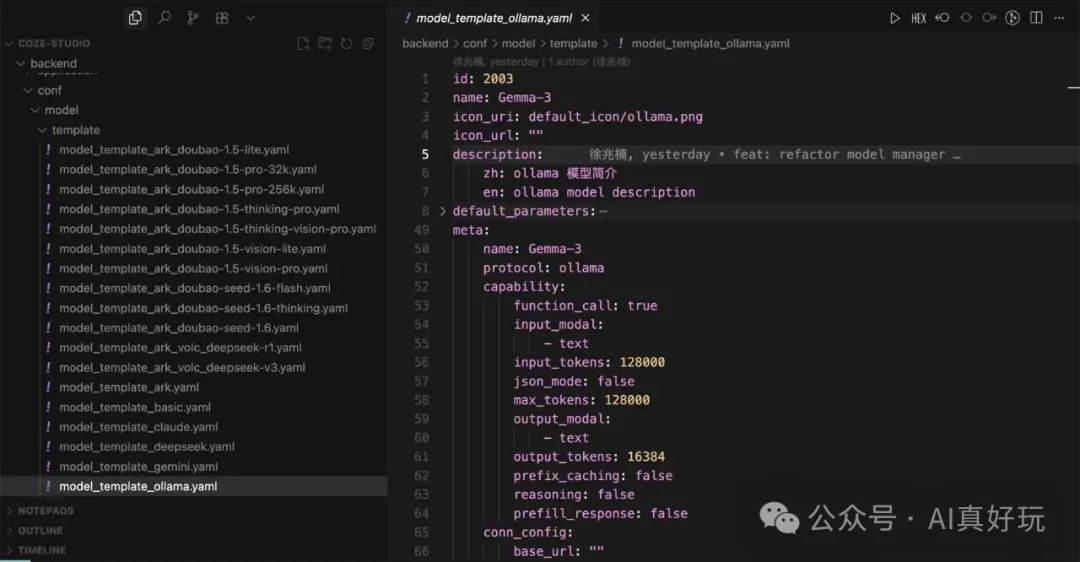

使用你平常使用的 IDE 打开 coze-studio 项目,在 backend/conf/model/template 目录下,选择需要使用的模版,并复制到 backend/conf/model 文件夹下。

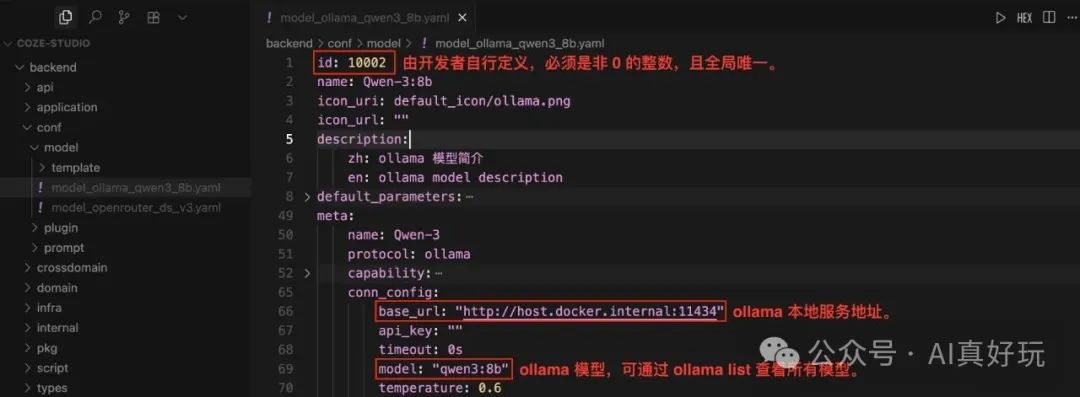

这里我们复制 model_template_ollama.yaml 模版,并重命名为 model_ollama_qwen3_8b.yaml。我们以 qwen3:8b 为例,配置本地的 ollama 服务:

需要注意的是,id 字段,由开发者自行定义,必须是非 0 的整数,且全局唯一。对于已上线的模型,请勿修改模型 id,否则可能导致模型调用失败。在配置模型时,你可以运行 ollama list 查看本地已安装的模型。

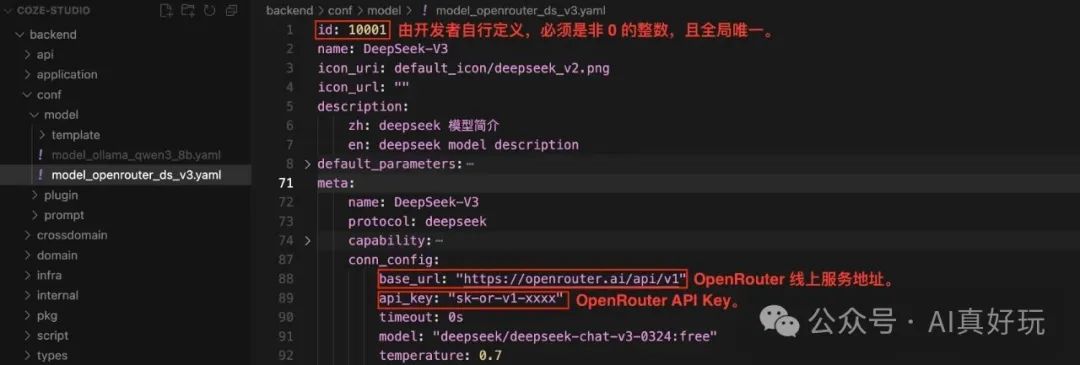

配置完本地的 ollama 服务,我们来继续配置 OpenRouter 提供的线上服务。这里我们复制 model_template_deepseek.yaml 模版,并重命名为 model_openrouter_ds_v3.yaml。我们以DeepSeek-V3 服务为例,配置线上的 OpenRouter 服务。

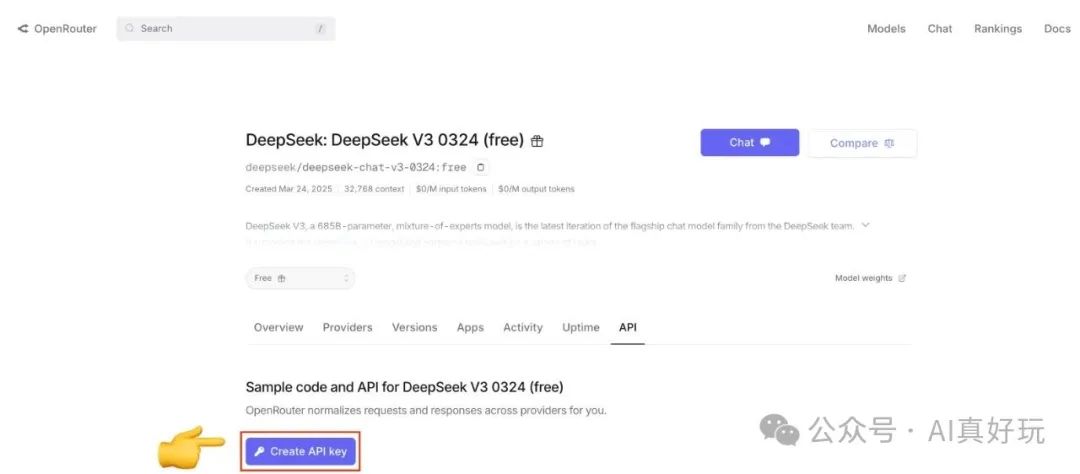

如果你还没有 DeepSeek-V3 的 api_key,可以访问 https://openrouter.ai/deepseek/deepseek-chat-v3-0324:free/api 地址,通过 Create API Key 按钮创建新的 API Key。

3.4 部署并启动服务

配置好模型之后,运行以下命令,即可在本地部署 Coze Studio:

cd docker

cp .env.example .env

docker compose --profile '*' up -d

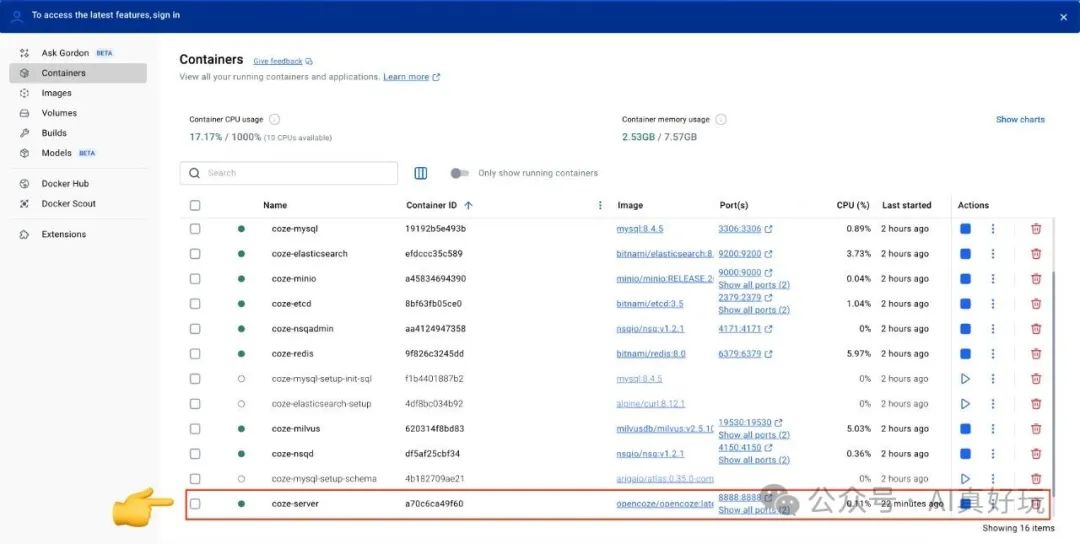

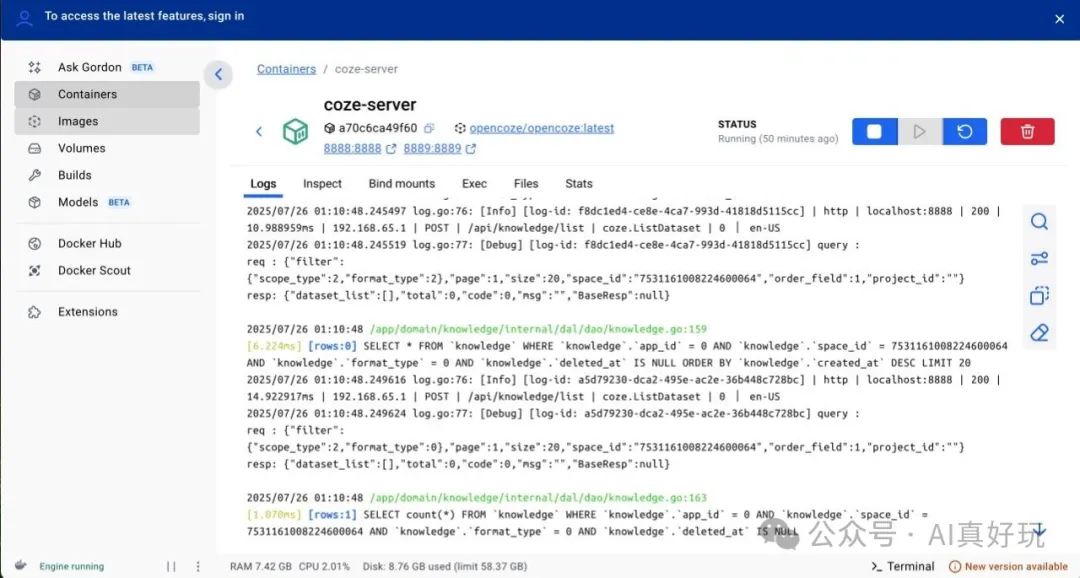

首次部署并启动 Coze Studio 需要拉取镜像、构建本地镜像,可能耗时较久,请耐心等待。在 Docker Desktop 中,可以看到 Coze Studio 所有服务的状态。当 coze-server 的服务状态变成绿色,表示 Coze Studio 服务已成功启动。

当你修改配置文件之后,需要执行以下命令重启服务,使配置生效。

docker compose --profile '*' restart coze-server

3.5 使用 Coze Studio

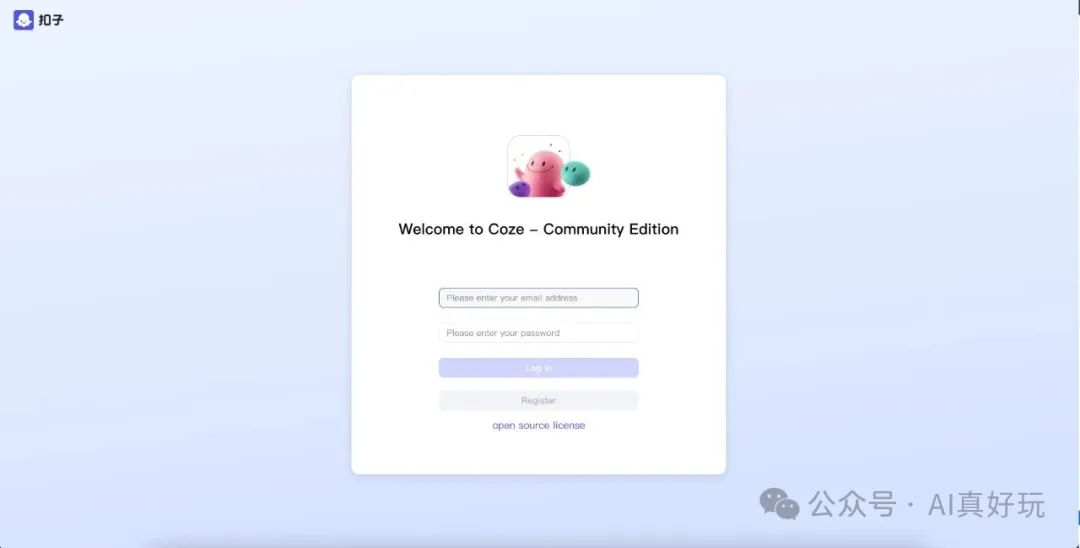

启动服务后,通过浏览器访问 http://localhost:8888/ 即可打开 Coze Studio。

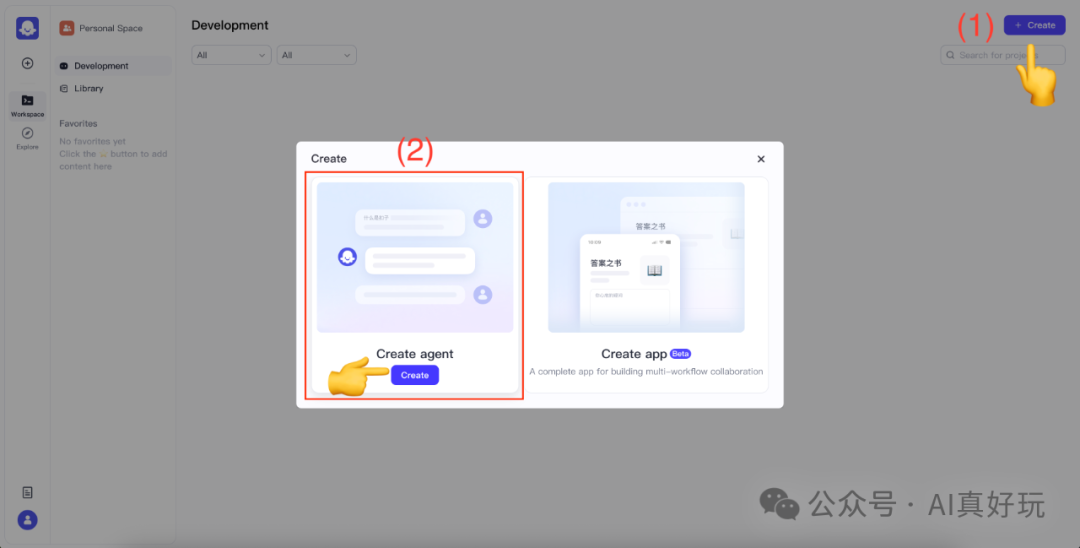

首次使用时,输入邮箱和密码,点击 Register 注册新的用户。成功注册之后,点击右上角的 Create 按钮,然后选择 Create agent 选项,具体如下图所示:

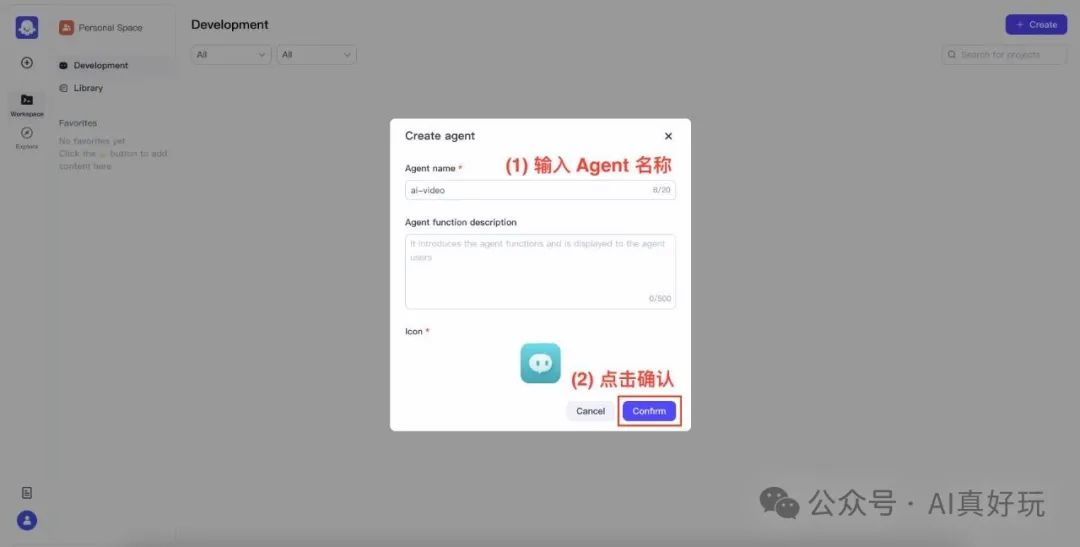

接着,输入 Agent 名称,再点击确认:

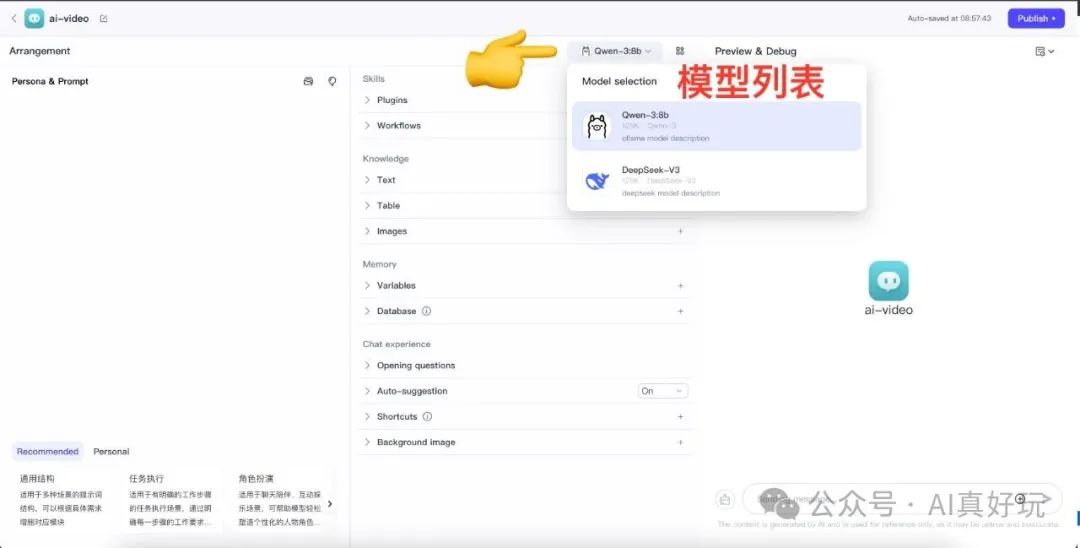

进入 Agent 设计界面之后,点击模型列表,即可查看 Coze Studio 已配置的模型。

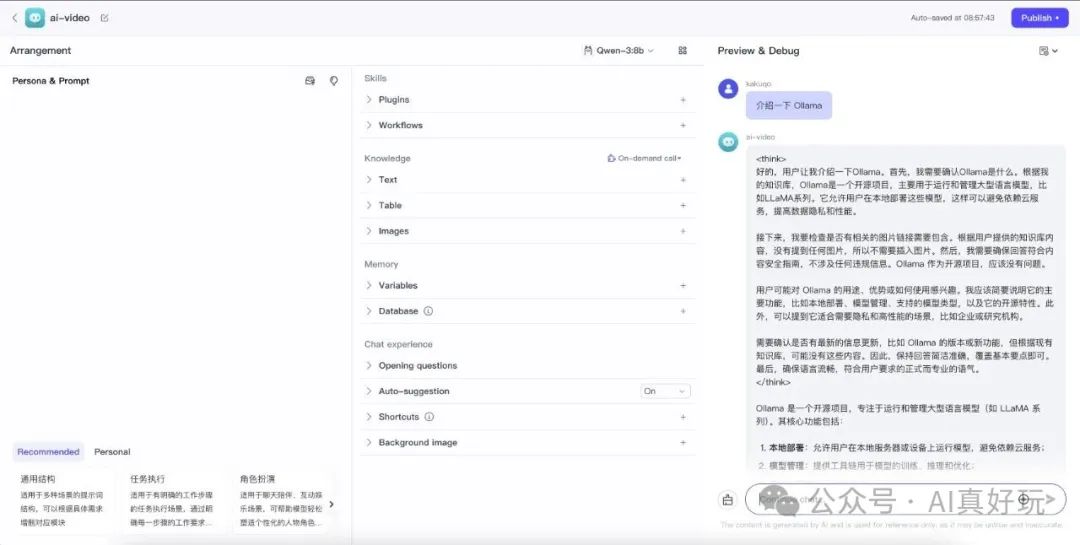

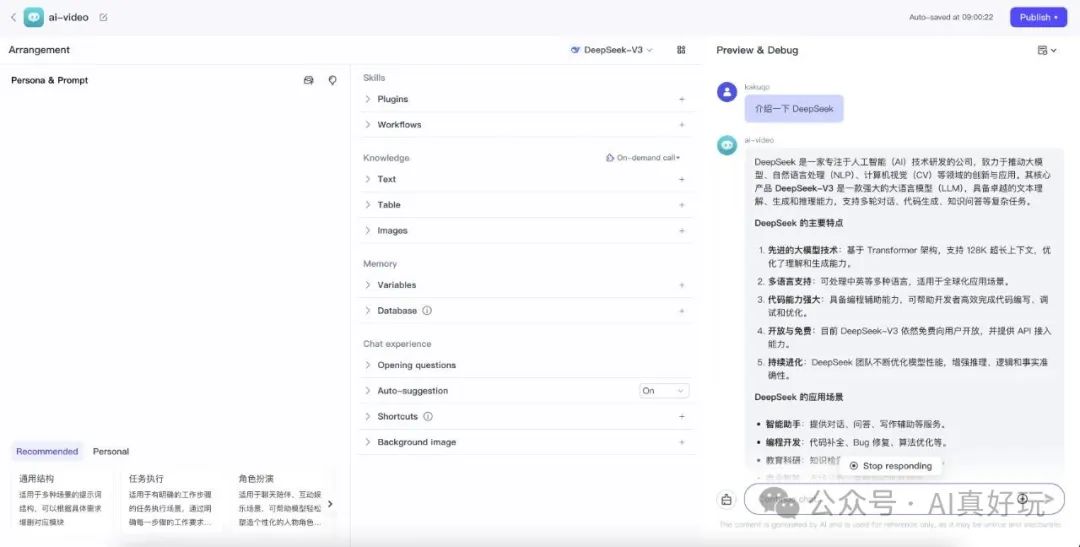

通过右侧底部的 Chat 输入框,你可以测试模型是否能正常工作:

1. 测试本地 Ollama qwen3:8b 服务

2. 测试线上 OpenRouter DeepSeek-V3 服务

由上图可知,前面已配置的大语言模型服务,都能正常工作。如果出现异常,你可以通过查看 coze-server 的日志,来排查异常:

至此,你已经成功在本地搭建 Coze Studio,尽情发挥你的想象力去创造 AI Agent 吧!

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此,我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包,现在将这份 LLM大模型资料 分享出来: 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

669

669