访问ollama官网https://ollama.com/,下载OllamaSetup.exe并安装,ollama会默认添加到环境变量中

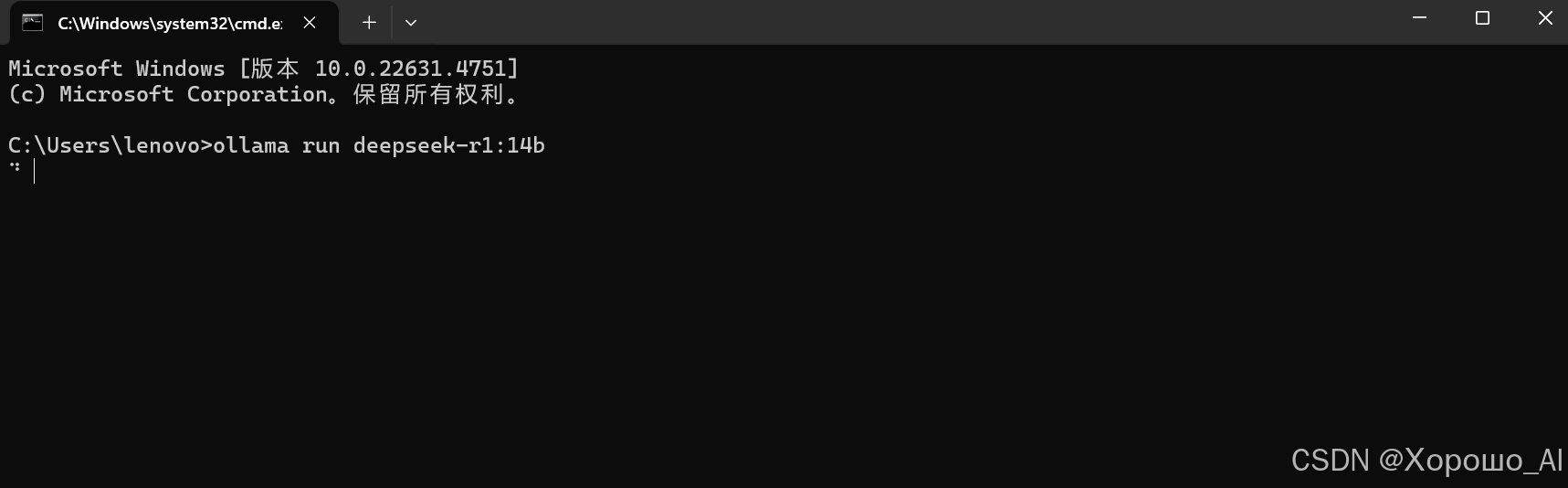

可以在cmd中通过以下命令安装和运行大模型

通过以下命令可以查看已安装的模型列表

ollama list在这里,我们使用deepseek-r1:14b和llama3做演示

下载需要的库

pip install langchain_community1.创建三个python脚本,‘llm1.py’载入deepseek模型,‘llm2.py’载入llama3模型,‘main.py’用来同步运行前两个脚本

2.在目录中创建‘llm1输出.txt’和‘llm2输出.txt’用来实现两个模型之间的对话读取,创建'log.txt'记录对话

以下是‘llm1.py’的源代码

from langchain_community.llms import Ollama

import os

# 先在'llm1输出.txt'中写入问候,便于llama3读取

with open('llm1输出.txt','w',encoding='utf-8') as file:

file.write('你好,我是Deepthink')

file.close()

# 载入deepseek模型

ollama = Ollama(model="deepseek-r1:14b",

temperature=0,

)

# 这里给模型添加流式输出

def stream_generation(prompt) 本地部署DeepSeek与Llama3实现交互对话

本地部署DeepSeek与Llama3实现交互对话

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2840

2840