Amazon EC2 P6-B300实例现已可用,这是由NVIDIA Blackwell Ultra GPU驱动加速的下一代GPU系统。

相比上一代实例,Amazon EC2 P6-B300实例网络带宽提升2倍,GPU内存容量增加1.5倍,为大规模AI应用构建了一个更均衡更高效的运行系统。

得益于这些优化,P6-B300实例成为大规模训练和部署AI模型的理想之选,尤其适用于采用混合专家模型(MoE)、多模态处理等复杂技术的场景。对于需要处理万亿参数模型,并需要借助数千块GPU进行分布式训练的机构而言,该实例在计算能力、内存容量与网络性能方面实现了完美平衡。

相较于上代产品的升级点

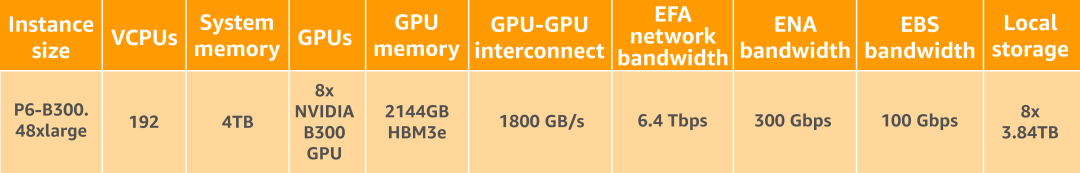

P6-B300实例可提供6.4Tbps的Elastic Fabric Adapter(EFA)网络带宽,支持大型GPU集群间的高效通信。该实例配备2.1TB的超大GPU内存容量,可让大模型完整部署在单个NVIDIA NVLink域内,从而大幅减少了模型分片处理的需求与通信过程中产生的开销。

此外,结合EFA网络以及Amazon Nitro系统的先进虚拟化与安全功能,P6-B300实例能够为AI工作负载提供前所未有的速度、规模与安全性。

P6-B300实例规格参数如下表所示:

须知事项

在持久化存储方面,AI工作负载会根据性价比考量,综合采用多种高性能持久化存储选项,包括:

Amazon FSx for Lustre

Amazon S3 Express One Zone

Amazon EBS

举例而言,P6-B300实例搭载的专用300Gbps ENA,使其能够借助Amazon S3 Express One Zone,实现高吞吐量热存储访问,为大规模训练工作负载提供支持。

若您使用Amazon FSx for Lustre,现在可结合EFA与NVIDIA GPUDirect Storage(GDS),在P6-B300实例上以高达1.2Tbps的吞吐量,访问Lustre文件系统,从而快速加载模型。

现已可用

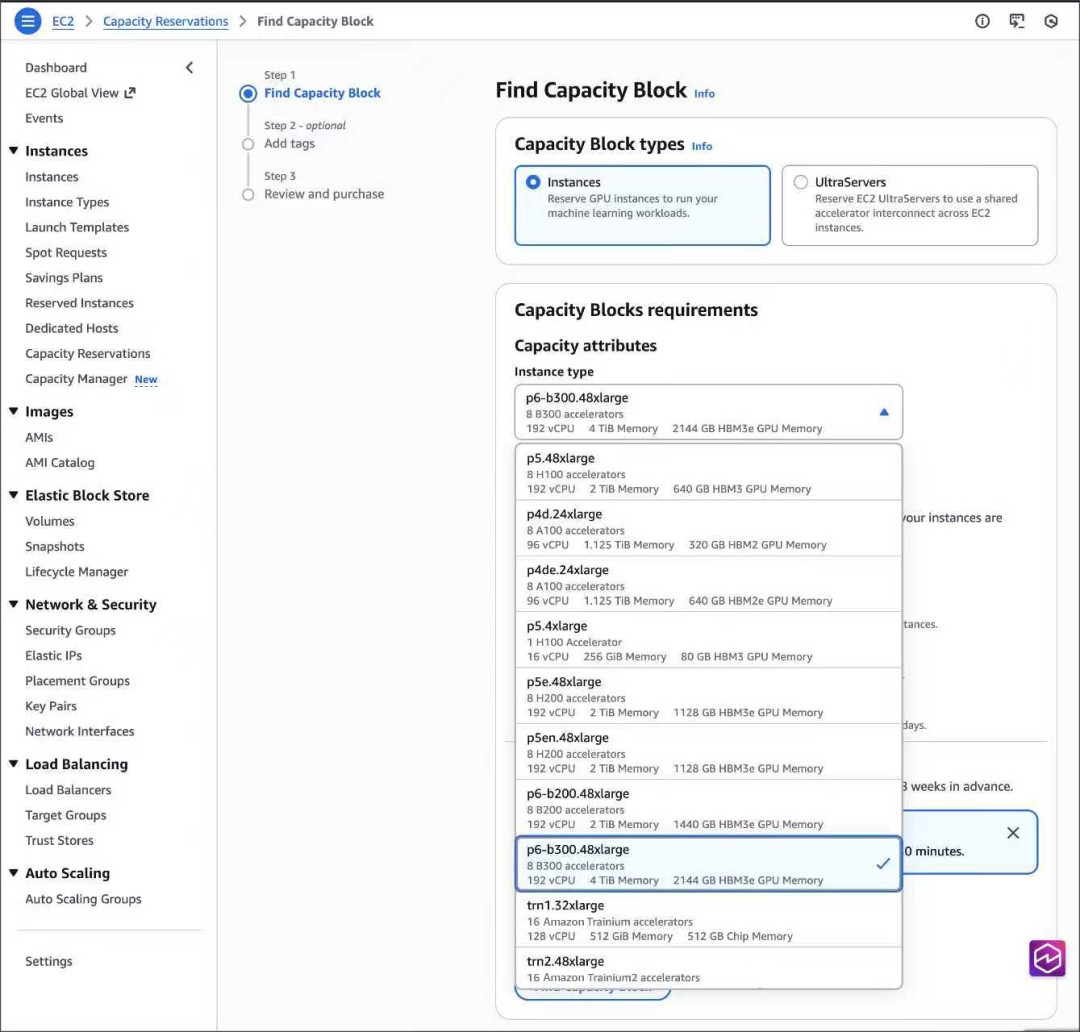

Amazon EC2 P6-B300实例现已在美国西部(俄勒冈州)的亚马逊云科技区域开放使用,可通过Amazon EC2 Capacity Blocks for ML和Savings Plans使用该实例。

本篇作者

Veliswa Boya

高级开发者布道师,常驻南非,与撒哈拉以南非洲地区的构建者社区紧密合作。她在技术领域担任过多种角色,从开发者到分析师、从架构师到云工程师,再到现在作为一名开发者布道师。Veliswa热衷于与技术领域新手以及初步接触亚马逊云科技服务的入门者合作。

我们正处在Agentic AI爆发前夜。企业要从"成本优化"转向"创新驱动",通过完善的数据战略和AI云服务,把握全球化机遇。亚马逊将投入1000亿美元在AI算力、云基础设施等领域,通过领先的技术实力和帮助“中国企业出海“和”服务中国客户创新“的丰富经验,助力企业在AI时代突破。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?