文章目录

- 前言

- 一、相关简介

- 1.DeepSeek

- 2.Ollama

- 二、安装教程

- 1.安装Ollama

- 2.修改模型保存位置

- 3.下载DeepSeek-R1

- 总结

前言

随着大语言模型在各个领域的广泛应用,本地部署成为许多开发者和企业的首选。本地部署不仅可以保护数据隐私,还能减少对云服务的依赖,提升响应速度。DeepSeek-R1作为一种高性能的推理模型,已经在多个任务中展现出卓越的性能。本文将详细介绍如何使用Ollama在本地部署DeepSeek-R1模型。

一、相关简介

1.DeepSeek

DeepSeek,全称杭州深度求索人工智能基础技术研究有限公司,是一家成立于2023年7月的中国人工智能公司。公司专注于开发先进的大语言模型(LLM)及相关技术,致力于突破认知智能的边界。

2.Ollama

Ollama 是一个开源框架,旨在简化大型语言模型(LLM)在本地机器上的部署和运行。它提供了一个轻量级且易于扩展的框架,支持多种操作系统(如 macOS、Windows、Linux)以及 Docker 环境。

二、安装教程

教程总体流程为:安装Ollama,并且使用Ollama拉取deepseek-r1模型到本地并且使用。

1.安装Ollama

Ollama官网:https://ollama.com/

1、下载对应操作系统的安装包。

2、双击安装文件并按照提示完成安装

3、在终端中运行ollama version命令,确认Ollama已正确安装。

ps:这里默认安装C盘,建议不变,模型保存位置可以改,后面介绍。

出现下图即表示安装成功

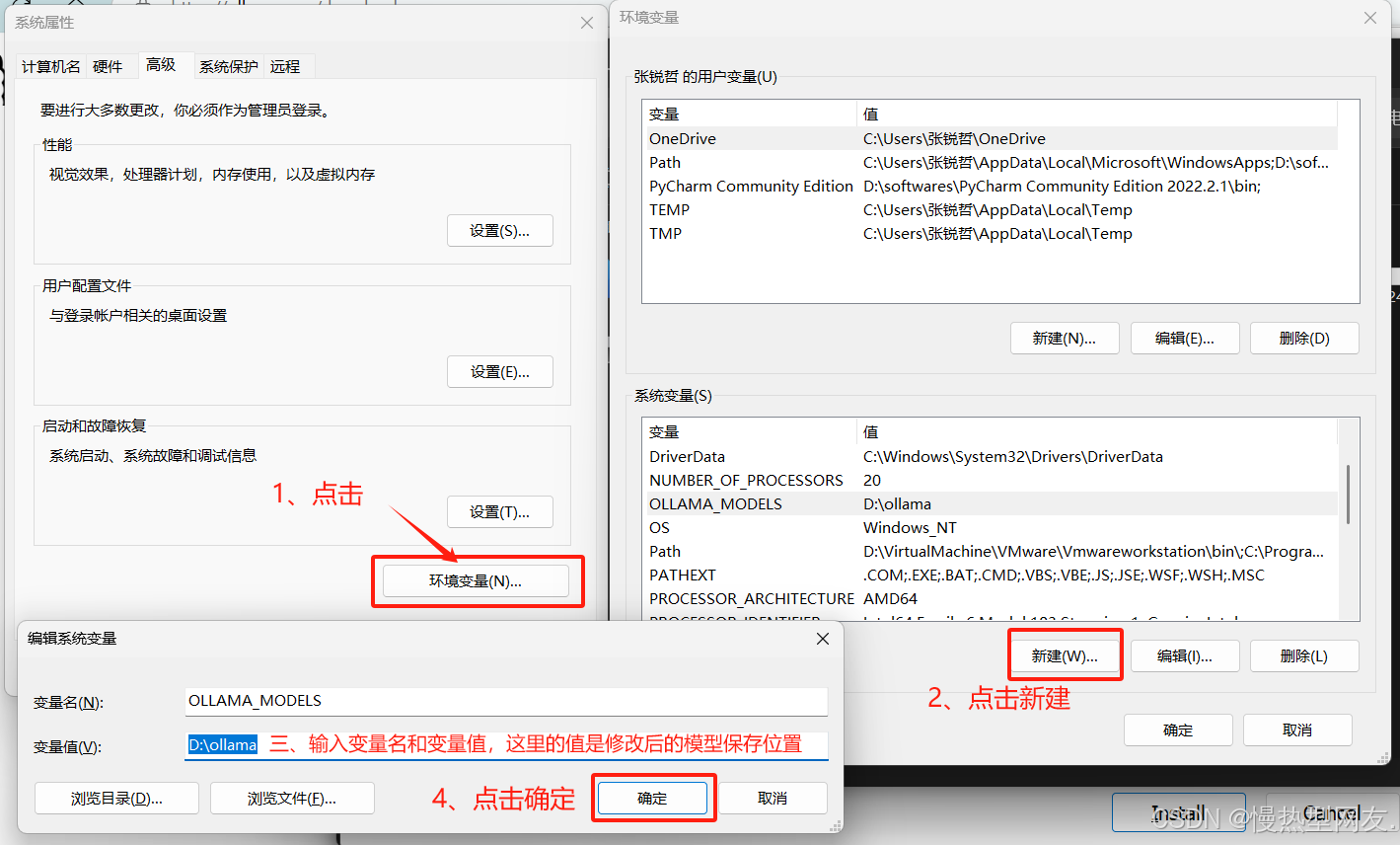

2.修改模型保存位置

新建系统变量中的用户变量,变量名为OLLAMA_MODELS。

3.下载DeepSeek-R1

1、点击Ollama官网左上角“Models”

2、点击相应的大语言模型。

3、根据自身需求选择部署的规模。

ds提供多种蒸馏版本,如1.5B、7B、8B、14B等,满足不同硬件条件下的使用需求。

根据硬件条件选择合适的DeepSeek-R1模型版本。例如,7B或8B版本适合大多数中高端设备

本次演示选择1.5b版本

4.在cmd中粘贴上一步所复制的命令并运行,该语言模型开始下载,下载完成后显示如下。

此时,模型会进入交互模式,用户可以通过终端与模型进行对话。

ollama run deepseek-r1:1.5b

总结

通过本文,读者可以快速掌握如何在本地使用Ollama部署DeepSeek-R1大模型的全过程。目前,虽然我们已经能够通过命令行实现模型的下载、安装和交互,但这种方式较为生硬,用户体验不够友好。为了进一步提升交互体验,未来计划结合一些开源的可视化工具来优化这一过程。

例如,Chatbox 是一款支持Ollama的可视化交互界面,能够显著提升用户体验。用户可以通过访问Chatbox官网并使用API Key连接Ollama,从而在图形界面中与DeepSeek-R1模型进行交互。此外,Page Assist 浏览器插件也可以连接到本地Ollama服务,通过网页界面与模型进行交互。

未来,我们还计划探索更多可视化工具,如Gradio,它可以为本地运行的DeepSeek-R1模型提供一个简单的Web界面,支持多模态内容的交互。通过这些工具的结合,我们将能够为用户提供更加直观、便捷的交互体验,让DeepSeek-R1模型的本地部署和使用变得更加高效和人性化。

2243

2243

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?