对抗性攻击对基于机器学习的智能医疗系统的影响

摘要

医疗数据的日益普及要求对疾病诊断、进展和实时监测进行准确分析,以向患者提供改进治疗。在此背景下,机器学习(ML)模型被用于从高维且异构的医疗数据中提取有价值的特征和洞察,以在智能医疗系统(SHS)中检测不同疾病和患者活动。然而,近期研究表明,应用于不同领域的机器学习模型易受对抗性攻击的影响。本文提出一种新型对抗性攻击,旨在利用智能医疗系统(SHS)中所使用的机器学习分类器。我们考虑一个具备数据分布、SHS模型及机器学习算法部分知识的攻击者,实施定向与非定向攻击。利用这些对抗性能力,我们篡改医疗设备读数,以改变SHS输出中的患者状态(如患病、正常状况、活动等)。我们的攻击采用五种不同的对抗性机器学习算法(HopSkipJump、快速梯度法、构建决策树、Carlini & Wagner、零阶优化),在智能医疗系统(SHS)上执行多种恶意行为(例如数据投毒、错误分类输出等)。此外,根据攻击者在训练与测试阶段的能力,我们在智能医疗系统(SHS)上实施白盒与黑盒攻击。我们在不同的智能医疗系统设置和医疗设备环境下评估了本方法的性能。大量评估结果表明,我们所提出的对抗性攻击可显著降低基于机器学习的智能医疗系统(SHS)在正确识别疾病和患者正常活动方面的性能,最终导致错误治疗。

Index Terms— 智能医疗系统,智能医疗设备,对抗性机器学习

一、引言

每年,医疗行业产生的数据量都以惊人的速度增长,预计到 2025[1]年将达到1,656泽字节。如果能够对这些医疗数据进行适当分析以提取重要特征,它们将具有临床、财务和运营价值。在此背景下,机器学习(ML)可以成为管理医疗数据的有效工具。

近年来,已提出多种基于机器学习的医疗应用,用于实现不同的医疗功能,如疾病检测、早期诊断、治疗方案制定和解毒剂发现 [2],[3]。将机器学习应用于识别和分析临床参数,无疑提高了医疗服务的效率和质量。通过机器学习从目标数据集中提取特征的特性,可实现个性化治疗和支持,最终有助于降低医疗成本并建立更好的医患关系。医疗行业中机器学习解决方案的全球市场预计到 2025[4]年将达到340亿美元。

机器学习在医疗行业中发挥着至关重要的作用,例如新医疗程序的开发、处理患者数据以及慢性疾病的治疗。与此同时,机器学习模型在训练分布之外表现出不可预测且过度自信的行为,而对抗样本是这一更广泛问题的子集。对抗样本的发现揭示了最先进的机器学习系统[5]–[7]中的漏洞。对抗样本是指经过精心设计以导致机器学习算法发生错误分类的输入。事实上,由于当前机器学习模型可能存在的局限性,对抗性机器学习在医疗领域受到了广泛关注。例如,攻击者可能向医疗机器学习模型中添加新的对抗性数据,从而错误地将甲状腺功能减退患者[8]进行分类。研究人员还报告了多起针对医学图像处理中机器学习模型的对抗性攻击,通过添加噪声来改变结果,并以高置信度将良性痣错误分类为恶性 [9],[10]。然而,医疗系统正在积极采用机器学习模型以提高疾病检测和患者治疗水平,却未明确应对这些已报道的对抗性攻击。

本文提出了一种新型的对抗性攻击,用于检测智能医疗系统(SHS)中基于机器学习的应用所存在的缺陷。在SHS中,多个医疗设备可以相互连接,共享患者的生命体征,并通过关联各种身体功能来检测正常活动和疾病相关活动。我们的攻击针对的是SHS中用于威胁检测、疾病识别和正常活动识别的底层机器学习模型。在该攻击中,攻击者利用最先进的对抗性攻击方法(HopSkipJump、快速梯度法、Carlini & Wagner、决策树、零阶优化)对基于机器学习的SHS实施白盒和黑盒攻击[11]。我们证明,所提出的攻击即使仅利用机器学习模型的部分知识,也能成功错误分类患者的状况,并将结果操控至特定状态。为了评估该攻击的效果,我们考虑了一个SHS,该系统关联了从8种不同的智能医疗设备收集的患者生命体征,并使用不同的机器学习模型检测11种良性场景,其中包括6种正常活动和5种疾病相关活动。我们的评估结果显示,所提出的攻击在未定向和定向攻击中分别可实现32.27%的准确率下降和20.43%的成功率,从而导致SHS中的正常用户活动和疾病相关场景被错误分类。

贡献:

总之,我们的贡献有三个方面:

- 我们提出了一种基于对抗性机器学习的数据驱动攻击方法,用于识别智能健康系统中底层机器学习模型的缺陷。我们考虑了两种不同的攻击:训练阶段攻击(投毒)和测试阶段攻击(逃避)。

- 我们利用五种不同的对抗性机器学习算法实现了四种白盒攻击和一种黑盒攻击。

- 我们针对由8种不同智能医疗设备组成的基于机器学习的智能健康系统评估了所提出的攻击。我们的广泛评估表明,该攻击能够成功降低智能健康系统中机器学习模型的准确率。

组织结构:

我们在第二节中概述了医疗系统中的对抗性攻击。第三节详细介绍了智能健康系统以及对抗性机器学习。在第四节中,我们解释了考虑攻击者目标、能力和方法论的威胁模型。在第五节中,我们探讨了在各种智能医疗系统场景下攻击的可行性。第六节对本文进行了总结。

II. 相关工作

在本节中,我们讨论现有的针对智能医疗系统的对抗性攻击,并解释我们的攻击模型与现有模型的不同之处。

近年来,研究人员报告了多起针对机器学习模型的对抗性攻击事件,其中攻击者通过操纵输入数据分布,导致模型输出出现错误分类。大多数对抗性攻击旨在修改输入数据分布,以改变训练数据并对输出进行错误分类[8],[12]。此外,在测试时,不同的机器学习模型(如神经网络、深度神经网络等)容易受到输入数据微小修改的影响,攻击者可利用这一点通过注入污染的测试数据来操纵数据分布[13]。在基于机器学习的医疗系统中,攻击者通常试图改变多层机器学习分类器中的数据分布,从而改变预测疾病[9]。医疗领域中的大多数攻击都针对医学影像数据,以改变预测疾病。米尔斯基等人展示了攻击者如何利用三维条件生成对抗网络(GAN)在体绘制(三维)医学扫描中添加或删除疾病证据[14]。塔加纳基等人测试了两种最先进的深度神经网络(DNN)在胸部X光图像上的表现,面对十种不同的对抗性攻击,结果表明用于医学图像分类的DNN易受对抗性攻击影响[15]。

金等人提出,可通过向医学图像添加细微的通用对抗性扰动,以高置信度改变预测标签[16]。在最近的一项研究中,研究人员提出了一种新方法,用于生成对抗样本以攻击基于卷积神经网络(CNN)的医学图像分割模型[17]。另一种对抗性攻击可在电子健康记录(EHR)上实施,以改变患者的未来治疗方案。崔等人使用GAN学习真实世界多标签离散电子健康记录的分布,并生成对抗性患者记录[18]。孙等人提出一个框架,利用对深度预测模型的对抗性攻击,识别时间序列医疗记录中的易感位置[19]。

与现有攻击的差异:

我们的威胁模型是一种针对基于机器学习的智能医疗系统的全新攻击方法。虽然大多数研究考虑的是单个医疗设备数据或存储的医疗数据来实施对抗性攻击,但在我们的工作中,我们考虑的是一个利用机器学习模型进行疾病和正常活动识别的多设备互联智能健康系统。现有攻击与我们方法之间的主要差异如下:

1. 大多数先前的研究集中在离线模式下操纵机器学习模型的数据分布。而本文考虑的是实时基于机器学习的智能医疗系统,并对输入进行操控。

2. 现有攻击侧重于生成多标签离散电子健康记录[18],而我们检测在智能健康系统中被攻破的医疗设备的最小数量以发起攻击。

3. 我们不依赖训练模型和机器学习算法数据分布的完全知识,而是考虑在部分了解数据范围的情况下,通过数据注入阈值实现成功攻击 [12]。

4. 与识别离线医疗记录中的易感位置不同,我们的攻击针对实时智能医疗系统中的关键设备进行对抗性攻击,对患者状态和整体治疗产生更大影响[19]。

5. 不同于对医学图像的对抗性攻击[15],[9],[16],[17],我们将基于机器学习的智能医疗系统作为攻击目标/平台。

III. 背景

在本节中,我们讨论了智能健康系统的组件以及在攻击中所考虑的不同设计假设。此外,我们还探讨了对抗性机器学习在智能健康系统背景下的影响。

A. 智能互联医疗系统概述

智能健康系统(SHS)可由单个或一组智能医疗设备(例如可穿戴设备、无线设备、植入式设备等)组成,用于采集患者身体数据,以提供改进治疗和实时监测[20]。SHS综合考虑不同的医疗参数(患者生命体征)和非医疗参数(例如身体状态、患者位置等),以全面了解患者的状况,并实现实时监测。智能医疗设备将生命体征作为模拟信号接收,将其转换为数字信号,并通过无线技术(蓝牙、Zigbee等)以网络数据包的形式发送至个人数字助理(PDA),PDA可以是智能手机、笔记本电脑或智能手表。PDA作为用户界面,将数据转发至数据库(例如云服务器、本地服务器等)。数据库将数据发送至中央数据处理单元(CDPU),CDPU使用机器学习模型从数据集中选择和提取特征。

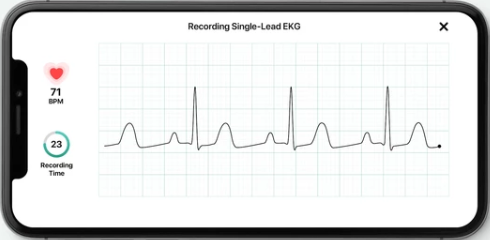

CDPU运行机器学习模型以检测患者的疾病状态、正常活动以及智能健康系统中的威胁。随后,系统执行自动化操作(例如推送新剂量药物、更改用药等),为患者提供改进治疗,并将分析后的数据发送给授权实体(医院或医生)。最后,医生向患者发送与其健康状况相关的更新治疗方案通知。图1展示了一个智能健康系统的示例,其中多个智能医疗设备(例如脑电图(EEG)、心电图(ECG)、脉搏血氧仪等)连接到患者身体,用于采集不同生命体征(例如血氧、神经活动、心率等)的数据。

B. 智能健康系统中的对抗性机器学习

为了理解对抗性机器学习在智能健康系统中的工作原理,我们假设一个机器学习模型M是在输入对(X,y)上训练的,数据分布 µ采用随机性为r的随机化训练过程(例如,随机权重初始化、丢弃法等)。此处,输入(X,y)是收集并预处理后的智能医疗设备数据,然后输入模型运行。模型参数 θ表示如下:θ=train(M, X, y, r)。在对该机器学习模型的白盒攻击中,攻击者完全了解用于分类的模型(M)以及训练中使用的算法。他能够获取训练数据分布(µ),并可识别模型易受攻击的特征空间。

在黑盒攻击中,攻击者不了解模型,但会利用有关设置或过去输入的信息来分析该机器学习模型的漏洞。

IV. 威胁模型

在本节中,我们讨论了所提出的攻击中考虑的对抗目标和攻击者能力。我们还描述了针对使用案例场景的攻击假设,并解释了基于机器学习的智能医疗系统中的攻击方法论。

A. 对抗目标

攻击者试图向基于机器学习的智能医疗系统提供输入,以改变机器学习分类器的决策,并操纵智能健康系统的自动化决策。我们根据对分类器输出完整性的影响,将攻击者的目标分为以下三类:

- 无目标攻击(UA) :攻击者试图改变智能健康系统中机器学习分类器的输出,使其偏离实际输出。例如,高血压患者可能被错误预测为患有其他疾病,从而导致恶意治疗方案。

- 有目标攻击(TA) :攻击者试图篡改机器学习分类器的输入数据,以将输出更改为特定类别。例如,通过操纵高血压患者的数据显示为异常氧水平的特定状况。

- 目标设备攻击 :攻击者试图找出在基于机器学习的智能医疗系统中发动攻击所需攻破的最少设备数量。例如,要将一名压力过大患者的状况更改为心脏病发作,可能只需攻破血氧饱和度设备。

B. 对抗能力

为了理解我们研究的攻击范围,我们假设一名患者(P)因呼吸问题(异常血氧水平)入住医院(图2)。为进行紧急监测,该患者配备了一个智能健康系统(SHS),其中包括心电图设备、血压计、脉搏血氧仪和脑电图仪,分别用于心脏、血压、血氧水平和神经活动的监测。该智能健康系统采用基于机器学习的分类器来预测疾病并对患者进行实时监测。我们假设这些设备工作正常,系统中不存在被攻破的设备。在此,我们提出一种新型对抗性攻击,能够利用智能健康系统并改变患者的疾病状态,从而导致错误治疗。为了对机器学习模型实施对抗性攻击,我们考虑攻击者具备以下能力:

- 数据分布 :由于不同的智能医疗设备生成的数据范围不同,攻击者可能了解这些设备的部分数据分布。基于此,攻击者可能在特定阈值内操纵某个数据值,以改变患者的疾病状态或正常活动模式。

- SHS架构 :攻击者可能了解智能健康系统的完整或部分架构,包括设备数量、设备相关性等,以实施攻击。

- 输出标签 :攻击者可能知晓机器学习模型的输出标签(例如疾病状态和正常活动模式),从而发起攻击。

- 机器学习模型 :不同的机器学习模型(例如决策树、随机森林等)被用于疾病和用户活动检测。攻击者可能知晓用于分类患者状态的底层机器学习模型。

C. 攻击方法

基于机器学习的智能医疗系统(ML‐based SHS)可被视为一种数据处理流程,其中采集自患者的生理体征数据被用于分析、诊断疾病并提供必要的治疗。图2展示了智能健康系统(SHS)的主要操作流程。设备数据收集模块从不同的智能医疗设备中收集代表患者生命体征和状态的数据,并将其转发至数据预处理模块。数据预处理模块根据相应的采样频率对数据进行采样,并将其保存为数组形式。例如,心率监测设备以每分钟一次的频率监测患者的心率,而心电图设备则每10秒监测一次患者的心血管状态。所采集的样本数据用于训练智能健康系统的机器学习模型,以实现疾病检测和实时监测功能。训练数据被标注了不同的疾病和良性状态(如高血压、低血糖等),以便识别不同场景下的数据模式。在测试阶段,通过已训练好的机器学习模型分析从患者处收集的生理数据,以检测患者是否存在不同疾病或良性状态。

在此背景下,我们的攻击方法可定义为针对该数据处理流程的攻击。攻击者试图操纵数据的采集或处理过程,以破坏机器学习模型,从而改变其原始输出。我们将智能健康系统中的攻击分为以下两类:

投毒攻击:

此类攻击发生在智能健康系统(SHS)中机器学习的训练阶段(图2)。在此类攻击中,攻击者会精心操控训练数据,以破坏整个学习过程。如第四节-B所述,攻击者可能了解机器学习模型的数据分布,并可将输入数据的值更改为特定阈值。在此情况下,攻击者可使用数据注入、数据修改和逻辑损坏等方法来操控训练数据。在数据注入中,攻击者无法访问训练数据和算法,但可以向训练集中添加新的数据。在数据修改中,攻击者通过在数据用于训练目标模型之前直接修改数据,从而对训练数据进行投毒。在逻辑损坏中,攻击者具有篡改机器学习模型的能力。利用这些能力,攻击者可以影响智能健康系统中机器学习模型的整体学习过程,导致测试数据被误诊,进而可能引发对患者的误治。

逃避攻击:

在逃避攻击中,攻击者试图通过在测试阶段引入对抗样本以欺骗智能健康系统。攻击者对训练数据没有任何影响,但可以访问机器学习模型以获取足够信息。因此,其攻击机器学习模型并操纵该模型对智能健康系统中的患者状态进行错误分类。通常,逃避攻击分为两类:白盒攻击和黑盒攻击。

(1) 白盒攻击:

在白盒攻击中,攻击者对智能健康系统(SHS)所使用的机器学习模型具有完全的了解(例如神经网络的类型及其层数)。攻击者知晓训练阶段所使用的算法,并能够访问训练数据分布。此外,攻击者还知道完全训练的架构的参数。我们在智能健康系统(SHS)的机器学习模型上实施HopSkipJump、快速梯度法、Carlini & Wagner以及基于决策树的攻击。

- HopSkipJump攻击 :HopSkipJump是一种高效的查询算法,也是一种强大的基于决策的对抗样本生成器,其利用距离向量作为超参数[24]。在我们的攻击中,通过使用切比雪夫距离获得了最优解,该距离通过计算向量中每个元素的最大幅值来确定对抗样本与原始样本之间的距离。

- 快速梯度法(FGM)攻击 :快速梯度法利用基础模型的梯度来寻找对抗样本[5]。通过对原始输入沿梯度方向添加或减去一个小误差,以改变学习模型的行为。在我们的模型中,我们将攻击者能力(阈值)视为沿梯度方向添加一个小误差,以篡改模型的分类。

- Carlini & Wagner(C&W)攻击 :这是一种最先进的白盒攻击,其中将定向对抗攻击视为一个优化问题,以利用机器学习模型的内部配置[25]。在我们的模型中,我们发现欧几里得距离在计算对抗样本与原始样本之间的差异时是最优的。

- 构造决策树攻击 :在此,攻击者利用决策树分类器模型[26]的底层树结构。对于给定的样本和一棵树,攻击者会搜索与该样本在决策树中的原始预测所对应的叶节点邻域内具有不同类别的叶节点。我们执行了此攻击,以枚举发起攻击所需攻破的最少设备数量。

(2) Black-Box Attack:

在黑盒攻击中,攻击者不了解智能健康系统中的机器学习模型,并利用有关设置或过去输入的信息来分析该型号的漏洞。我们在智能健康系统中执行零阶优化攻击作为一种黑盒攻击。

- 零阶优化(ZOO)攻击 :ZOO攻击基于坐标下降法,仅使用零阶 oracle(无需梯度信息),可有效攻击黑盒机器学习模型。这被称为最先进的黑盒攻击[27]。

V. 探索各种攻击场景

为了证明我们所提出攻击的可行性,我们成功地对基于机器学习的智能医疗系统实施了投毒攻击和规避攻击。我们考虑了若干研究问题来评估所提出的对抗性攻击。

- RQ1 在智能健康系统中执行投毒攻击后,所提出攻击的影响是什么?(第 V-B节)

- RQ2 在执行非针对性攻击以找到最重要的设备后,我们的攻击会产生什么影响?(第V-C节)

- RQ3 所提出的白盒和黑盒攻击对底层机器学习模型有何影响?(第V-D节)

- RQ4 基于阈值的攻击对智能健康系统中的机器学习模型性能有何影响?(第V-E节)

A. 环境设置与方法论

我们考虑一个由八种不同设备组成的智能健康系统(SHS),用于检测五种不同的疾病状态和六种不同的常规活动。我们从多个公共医疗数据库中收集了来自八种不同智能医疗设备的数据,这些数据提供了十种生命体征:心率(心电图)、血压(BP)、血糖(GL)、血氧(OX)饱和度、血红蛋白(HG)、呼吸频率(BR)、酒精水平(AL)、神经活动(NA)、人体运动(HM)和睡眠监测(SM)(表I)。这些生命体征由十五个不同的特征表示,这些特征之间的相关性如图3所示。我们将人体不同生命体征(如心率、血压等)的正常范围视为正常状态。我们所考虑的智能健康系统(SHS)利用不同的机器学习算法,基于采集的设备数据来检测五种不同的疾病场景(高血压、高胆固醇、过度出汗(SW)、异常血氧水平、异常血糖)以及六种常规用户活动(睡眠、行走、锻炼、压力、心脏病发作和中风情况)。设备与活动之间的相关性见表II。

| 设备监测类型 | 型号 | 特征参数值 | 数据库 |

|---|---|---|---|

| 心率和血压 | QuadioArm | 60‐100次/分钟,收缩压(120 毫米汞柱)和舒张压(80毫米汞柱) | 胎儿心电图合成数据库,Data.Gov |

| 血糖 | MiniMed™ 670G胰岛素泵系统 | 70‐130 毫克/分升 | UCI 糖尿病机器学习数据库 |

| 血氧 | iHealth Air 无线脉搏血氧仪 | 血氧饱和度 ≥94% | 血氧饱和度变异性模式分析 |

| 呼吸和出汗率 QuardioCore | 每分钟12‐20次呼吸, 0.5µ/分钟/cm² | BIDMC 光体积描记图和呼吸数据集 | |

| 血液酒精 | Scram 连续酒精监测 (CAM) | 0.08克/分升 | StatCrunch 数据集 |

| 血红蛋白 | 格曼尼艾姆斯特里普Hb血红蛋白检测仪 | 12.3‐17.5 克/分升 | DHS调查中的血红蛋白数据 |

| 神经活动 | Emotiv Insight | 德尔塔波(0.5‐4赫兹),θ波(4‐8赫兹),α波 (8‐12赫兹),β波(16‐24赫兹) & 脑电图数据 | 脑电图数据 |

| 睡眠与人体运动 | Fitbit Versa智能手表 | 快速眼动与非快速眼动睡眠周期 | CAP睡眠数据库 |

作为智能健康系统(SHS)的底层机器学习模型,我们考虑了四种不同的机器学习算法(随机森林(RF)、决策树(DT)、人工神经网络(ANN)、逻辑回归(LR)),因为我们的数据集包含多分类和层次模式。我们收集了17,000个健康人和患病人员的数据实例,并将数据分为两部分,其中70%的收集数据用于训练机器学习模型,30%的收集数据用于测试[30]。我们通过模拟第四节中描述的攻击方法论中的逃避和投毒攻击,在该SHS上实施攻击。对于投毒攻击,我们假设攻击者在能够访问机器学习模型的情况下对训练数据进行了污染。在此情况下,攻击者会操纵患者的输出状态,以改变检测到的疾病,或将正常用户活动篡改为疾病状态。为了实施逃避攻击,我们假设攻击者在测试阶段调整恶意样本。对于逃避攻击,我们还通过对SHS的机器学习算法实施基于梯度、基于决策边界和基于坐标的攻击,进行了白盒和黑盒攻击。我们在MATLAB中使用数字信号处理工具箱和对抗鲁棒性工具箱[31] (Python库)构建了SHS的仿真环境,以模拟不同的白盒和黑盒攻击。我们使用Keras和Scikit-Learn库在 Google Colab平台上对数据集进行训练和测试。

| 基础算法 | 准确率 | 10%投毒 | 20%投毒 | 30%投毒 |

|---|---|---|---|---|

| RF | 95.37 | 1.65 | 2.03 | 2.15 |

| DT | 90.16 | 4.31 | 15.88 | 27.31 |

| ANN | 91.42 | 10.28 | 13.14 | 27.32 |

| LR | 88.11 | 9.28 | 18.93 | 28.21 |

表III:数据投毒攻击的性能。

在评估中,我们使用智能健康系统机器学习模型的实际准确率与原始准确率之间的准确率下降作为性能指标。准确率反映了机器学习模型识别不同患者状态的有效性,而对抗样本会导致机器学习模型的准确率下降。对于定向攻击,由于我们在整个数据集的特定部分执行定向攻击,因此我们采用攻击者成功率作为指标。

B. 使用被操纵的训练数据进行评估

在智能健康系统(SHS)中,攻击者可以在训练阶段访问计算数据处理单元(CDPU),并将恶意数据注入到底层机器学习模型的训练池中。在这种情况下,攻击者可以了解训练模型,并通过注入恶意数据(投毒攻击)来操控SHS的决策。在我们的投毒攻击实验中,我们篡改了10%、20%和30%的训练数据的生命体征状态,以破坏SHS的模型性能。表III展示了在SHS中投毒攻击的效果。我们使用随机森林(RF)、决策树(DT)、人工神经网络(ANN)和逻辑回归(LR)作为底层机器学习算法进行训练。

智能健康系统。该智能健康系统使用随机森林检测不同患者状态时达到最高准确率为95.37%。在训练数据集被投毒后,当数据投毒比例为30%时,智能健康系统的准确率下降了2.15%。我们还可以观察到,如果底层机器学习模型是逻辑回归,则在20%和30%数据投毒情况下,我们的方法分别实现了最高准确率下降18.93%和28.21%。对于人工神经网络,在10%数据投毒的情况下,最高准确率下降为10.28%。

C. 不同攻击中的重要设备识别

aSHS利用不同医疗设备之间的相关性来识别患者的不同生命体征状态。我们利用这种相关性进行构建决策树的无目标攻击,以识别智能健康系统中的最重要设备(表IV)。我们考虑了无目标攻击,因为它使用整个训练样本来生成对抗样本。我们可以观察到,在将疾病状态从中风变为异常血氧水平的无目标攻击中,血红蛋白设备被攻破。类似地,在将疾病状态从高胆固醇变为中风时,血糖设备受到影响。总之,对底层机器学习模型(决策树)实施无目标攻击时,血糖、心率和血氧饱和度设备是受影响最严重的设备。

| 攻击 | 当前状态 | 最终状态 | 受影响的设备 | 设备数量 |

|---|---|---|---|---|

| 未定向 | 高胆固醇 | 中风 | 葡萄糖 | 1 |

| 未定向 | 高血压 异常血氧水平 中风 葡萄糖, | 中风 心率 2 中风 异常血氧水平 | 葡萄糖 葡萄糖,血红蛋白 2 | 1 |

| 未定向 | ||||

| 未定向 | ||||

| 未定向 | 睡眠 | 醉酒 | 酒精 | 1 |

| 未定向 | 压力 | 心脏病发作 | 血氧 | 1 |

表IV:为无目标攻击构建决策树。

图4a展示了设备减少对无目标攻击性能的影响。我们可以观察到,减少设备数量会显著降低所提出攻击的成功率。在移除一个设备(葡萄糖)和两个设备(葡萄糖、血氧)的情况下,使用 C&W攻击分别达到了最高的14.59%和12.24%的成功率。在移除三个设备(葡萄糖、氧气、心率)的情况下,HopSkipJump能达到最高的8.23%成功率。对于无目标攻击(图4b),在从 SHS中移除1、2和3个设备时,HopSkipJump和快速梯度法分别实现了最高和最低的准确率下降。总之,对抗性攻击在SHS中随着设备减少而性能下降。

D. 不同攻击算法的评估

为了评估所提出对抗攻击的性能,我们在aSHS中使用不同的对抗算法进行了白盒与黑盒攻击。从表V可以看出,HopSkipJump在无目标攻击中实现了最高的准确率下降(32.27%),而在定向攻击中实现了最高的成功率(15.68%)。相反,快速梯度法实现的准确率下降和成功率最低,而基础模型为逻辑回归。对于黑盒,我们进行了未定向和定向的 ZOO攻击,分别获得了12.29%的准确率下降和8.22%的成功率,其中基础模型为随机森林。

| 攻击者能力 | 攻击算法 | 底层学习模型 | 实际准确率 | 准确率下降(UA) | 攻击成功率(TA) |

|---|---|---|---|---|---|

| 白盒 | HopSkipJump | DT | 90.16 | 32.27 | 15.68 |

| 白盒 | C&W | ANN | 85.14 | 24.14 | 20.43 |

| 白盒 | FGM | LR | 88.11 | 3.02 | 0.26 |

| 黑盒 | ZOO | RF | 90.21 | 12.29 | 8.22 |

表V:白盒和黑盒攻击的性能。

E. 考虑不同阈值的评估

我们执行了第IV节中描述的基于阈值的攻击。从图5a可以看出,对于定向攻击,HopSkipJump和快速梯度法在基于10%阈值的攻击中均未能取得任何成功率。ZOO攻击在智能健康系统的三种基于阈值的攻击中均取得了最高的成功率。在无目标攻击期间(图5b),ZOO攻击算法在10%和20%阈值下均具有8.28%的相同准确率下降。FGM在所有三种攻击中的准确率下降最低。总之,HopSkipJump在基于阈值的攻击中实现了最高的准确率下降。

VI. 结论

医疗行业正在为患者生成大量数据,机器学习被用于分析这些数据,以支持早期疾病诊断、改进治疗方案、实时患者监测等不同应用。然而,用于不同医疗应用中的机器学习模型在不可预测性以及训练分布之外的数据方面存在缺陷。为解决这些不足,本文提出了一种新的基于对抗机器学习的攻击方法,以识别智能健康系统底层机器学习模型中的缺陷。我们在智能健康系统的不同对抗设置和医疗环境中评估了所提出的攻击。广泛的评估表明,该攻击在无目标和有目标攻击中均能取得非常理想的结果,可导致智能健康系统中的正常用户活动和疾病影响场景被错误分类。

VII. 致谢

本工作部分得到了美国国家科学基金会CAREER项目 CNS‐1453647的支持。此处的观点仅为作者个人观点。

对抗性攻击对医疗系统影响

对抗性攻击对医疗系统影响

1009

1009

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?