Hossain, M. A., Liu, W., & Ansari, N. (n.d.). Computation-Efficient Offloading and Power Control for MEC in IoT Networks by Meta Reinforcement Learning. IEEE Internet of Things Journal, PP(99), 1–1. https://doi.org/10.1109/JIOT.2024.3355023

在物联网(IoT)网络中,基于元强化学习的计算高效卸载和能量控制用于边缘计算(MEC)。

摘要

由于设备的大量普及和计算服务器的可用性,移动边缘计算(MEC)在执行各种计算任务方面变得越来越受欢迎。MEC在网络边缘提供计算服务,为用户设备(UE)提供其应用程序的降低延迟。然而,在考虑到无线资源分配和功耗管理的情况下,确定适当的UE在MEC中的卸载策略是计算密集型的。此外,该问题是NP难的,使得在合理的时间范围内找到最优解变得具有挑战性。在这项工作中,我们提出了一种基于元强化学习(MRL)的计算任务卸载和功率控制机制,用于处理MEC网络中UE的资源受限环境的NP难度问题。我们首先制定一个优化问题,通过最小化MEC网络中UE的本地计算和上行传输功耗来最大化UE的计算效率。我们在系统中提出了使用二进制卸载(完全卸载或完全本地计算)和部分卸载方案。我们提出的MRL算法可以在短时间内找到适当的UE卸载策略。与传统的深度强化学习算法不同,我们的方法可以解决在新环境中获得适当解决方案的问题。大量的模拟结果证明了我们提出的方法的可行性。

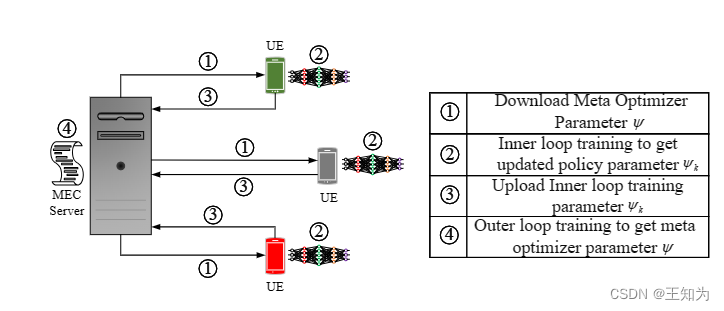

图1. 基于元强化学习的MEC网络中计算高效卸载和功率控制的系统架构。

本文提出一种基于元强化学习的策略,解决物联网网络中移动边缘计算(MEC)的计算任务卸载和功率控制问题,通过优化本地计算和上行传输功耗,有效应对UE资源受限环境下的NP难题。与传统方法相比,该算法能在新环境下快速找到合适的卸载策略,经仿真验证其可行性。

本文提出一种基于元强化学习的策略,解决物联网网络中移动边缘计算(MEC)的计算任务卸载和功率控制问题,通过优化本地计算和上行传输功耗,有效应对UE资源受限环境下的NP难题。与传统方法相比,该算法能在新环境下快速找到合适的卸载策略,经仿真验证其可行性。

598

598

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?