“在自动驾驶应用中,Feature Aware Re-weighting (FAR) 在鸟瞰视角中用于激光雷达 3D 目标检测”

自动驾驶车辆感知的关键要素是3D目标检测。LiDAR传感器通常用于感知周围环境,生成点云形式的场景稀疏表示。目前的趋势是使用能够预测3D边界框的深度学习神经网络架构。绝大多数架构直接处理LiDAR点云,但由于计算和内存限制,它们在某个阶段将输入压缩到2D鸟瞰视角(BEV)表示。在这项工作中,我们提出了一种新颖的2D神经网络架构,即特征感知重新加权网络(Feature Aware Re-weighting Network),通过注意机制利用局部上下文进行BEV中的特征提取,以提高基于LiDAR的检测器的3D检测性能。在五种最先进的检测器和三个基准数据集(KITTI、Waymo和nuScenes)上进行的大量实验证明了所提方法在检测性能和最小增加的计算负担方面的有效性。我们在 https://github.com/grgzam/FAR 上发布了我们的代码。

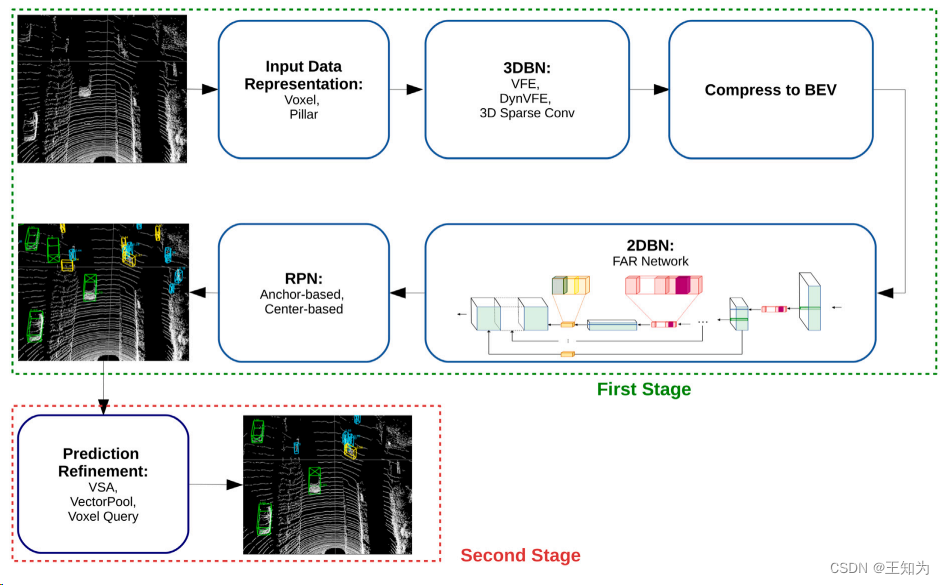

图1. 基于单级和双级LiDAR的3D目标检测器的标准流程。在我们的工作中,我们使用一个 FAR 网络作为2DBN架构。

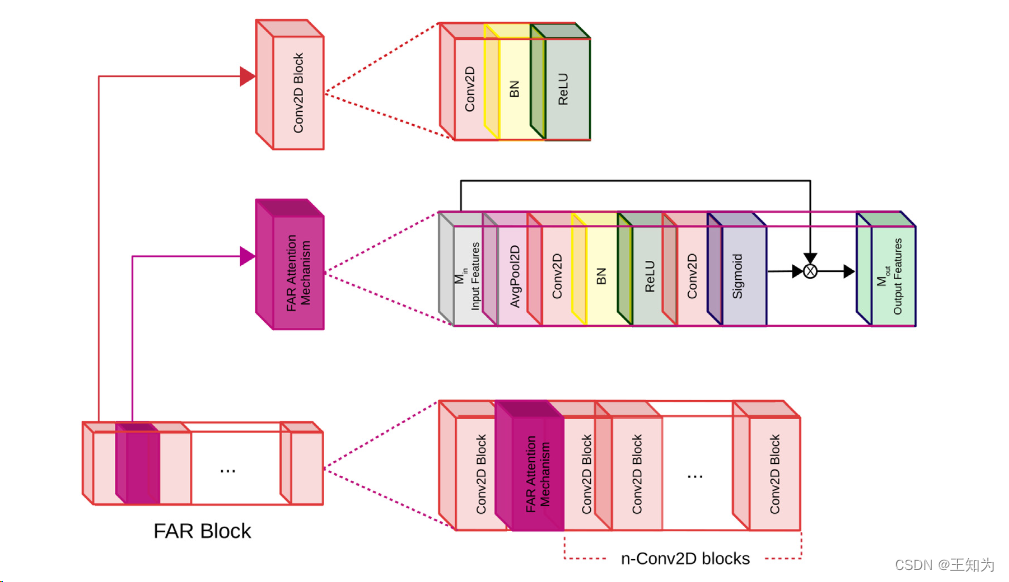

图2 FAR的结构图

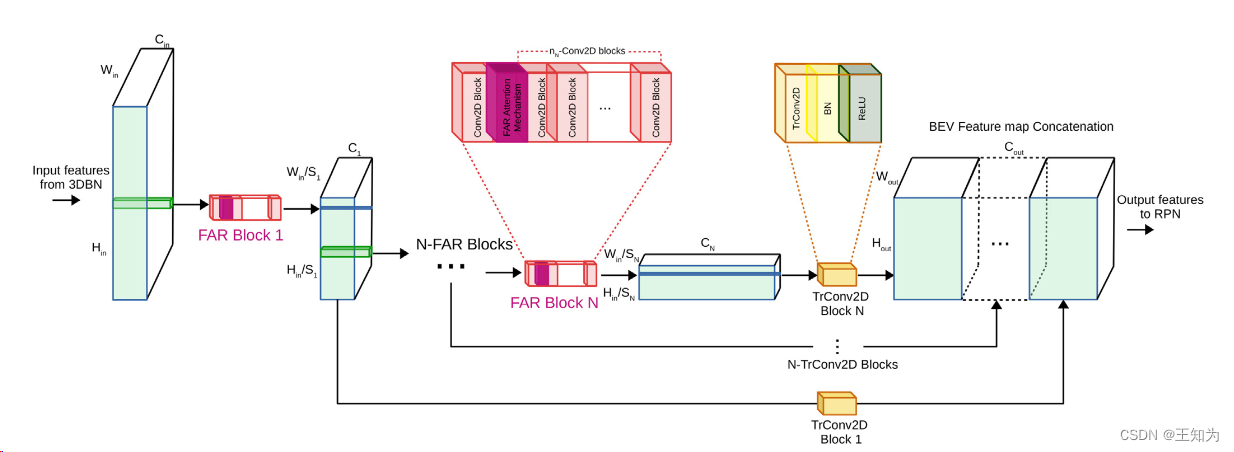

图3 FAR网络的结构

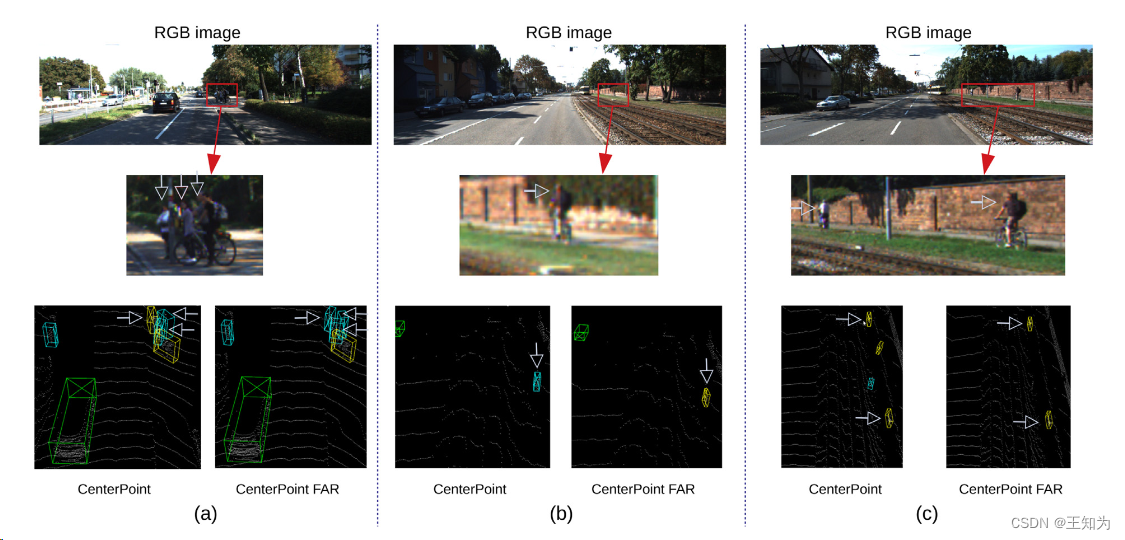

图4. FAR网络在KITTI数据集的CenterPoint上的定性评估。 (a)–(b): 误分类案例。 ©: 假阳性案例。

本文介绍了一种新颖的2D神经网络架构FeatureAwareRe-weightingNetwork(FAR),通过注意力机制优化BEV中的特征提取,以增强LiDAR基的3D目标检测性能。实验结果在多个先进检测器和基准数据集上证实了其在性能提升和计算效率上的优势。

本文介绍了一种新颖的2D神经网络架构FeatureAwareRe-weightingNetwork(FAR),通过注意力机制优化BEV中的特征提取,以增强LiDAR基的3D目标检测性能。实验结果在多个先进检测器和基准数据集上证实了其在性能提升和计算效率上的优势。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?