目录

3.1 Transformer:把对话建模推向可规模化的统一表示

3.2 预训练—微调范式:从“对话任务模型”到“通用语言底座再适配”

3.4 多轮对话大模型的研究地图:从“模型”到“系统”的综述化转向

4.3 多智能体协作与“对话的社会性”:从单一助手到群体互动

4.4 架构层面的再分类:传统TOD、LLM对话、Agentic Conversational AI

5.4 语音对话的实时性与轮次控制:turn-taking与全双工交互

6.1 任务型对话:从“模型堆分”到“可比、可复现的系统基线”

6.2 Persona与长期对话:规模化人设数据与长期记忆的工程化

6.3 对话对齐与反馈学习:从turn-level偏好到session-level全局反馈

6.5 语音与多模态对话:从级联系统到voice-native LLM

7.2 长期记忆、个性化与主动性:对话式智能体的“社会关系”问题

7.4 评测标准化与可复现:对话研究的“方法学红利”仍未吃尽

1 引言

对话式AI(Conversational AI)[1-2]之所以在过去几年成为人工智能最具“可见度”的形态,并不只是因为它把自然语言生成(NLG)做得更流畅,而是因为它把一系列长期被拆散处理的能力——语言理解、知识检索、规划与执行、交互记忆、个性化与安全约束——重新拉回到“以人类对话为中心的系统工程”框架中,迫使研究者同时面对语言、行动与治理三类问题的耦合。2025年前后,多篇综述与观点性文章明确指出:随着大语言模型(LLM)[3-4]具备更强的指令遵循、工具使用与任务规划能力,传统任务型对话系统(Task-Oriented Dialogue, TOD)中的经典流水线范式正在发生“范式迁移”,对话系统不再只是“回答问题”,而被重新定义为能够做决策并执行动作的“对话式智能体”(Conversational Agents / Agentic Conversational AI)。IEEE Signal Processing Magazine 在2025年的专题文章中就把这一迁移描述为:LLM使得具备工具使用和任务规划能力的AI代理成为焦点,TOD的方法与系统形态因此发生显著变化。

如果说2010年代的对话研究主线是“如何让系统更像会说话的接口”,那么2022年后则更像是“如何让系统在对话中承担任务、遵循规则并保持可控”。2025年的综述《A Desideratum for Conversational Agents》进一步尝试把“下一代对话式智能体应具备什么”系统化,提出以 Reasoning(推理)、Monitor(监控/自我与用户状态跟踪)与 Control(工具使用与策略遵循)三维度组织能力版图,并强调现实评测、长期多轮推理、自我演化、多智能体协作、个性化与主动性等仍是关键缺口。 这一“能力—评测—治理”三角关系,也正是本文综述希望抓住的主线:我们不是把对话式AI当作单一模型问题,而是把它视作一个在数据、模型、推理、检索、执行、评测与合规之间不断重构的系统生态。

2 对话式AI的范式演进:从“会话接口”到“可行动系统”

2.1 早期规则系统与符号主义传统

对话式AI的起点往往被概括为早期规则驱动的聊天程序:它们通过模式匹配、模板生成和有限的知识库来维持“看似自然”的互动。这一阶段的核心价值并不在于语言能力本身,而在于提出了对话交互的基本工程问题:如何处理轮次(turn-taking)、如何维持上下文一致性、如何在缺乏真实语义理解的情况下让用户愿意继续说下去。规则系统把“对话”近似为一组可触发的脚本,从而形成了对话管理(dialogue management)的早期直觉:对话并非孤立句子,而是带状态的过程。然而,它们很快暴露出可扩展性差和脆弱性高的问题:脚本规模一旦增长,维护成本呈指数上升;面对用户的语言变体和意外意图,系统很难泛化。

从今天回看,规则系统在科研路径上的真正意义,是把对话作为“交互式序列决策问题”引入计算机科学,并为后续统计学习与强化学习思路铺垫了概念基础:对话状态、动作、奖励与策略的抽象,使得后来的任务型对话可以被形式化为带不确定性的决策过程。虽然本文后续重点将放在数据驱动方法,但必须承认:直到2025年的对话式智能体讨论中,许多“控制与约束”的问题仍在用类似符号主义的方式回归,例如把工具调用看作离散动作,把系统安全策略看作硬约束或可解释规则,这一点也在2025年的“对话式智能体能力框架”中得到强调。

2.2 统计学习与模块化任务型对话:流水线成为主流工程形态

随着语料库语言学与统计学习在2000年代成熟,对话研究逐渐从脚本转向数据驱动。尤其在客服、订票、订餐等明确目标场景中,任务型对话系统形成了长时间占主导地位的模块化流水线:ASR(语音场景)/NLU(意图识别与槽位填充)→ 对话状态跟踪(DST)→ 策略学习(policy)→ NLG(回复生成)。这一结构的优势在于可解释与可控:每个模块都可以用专门数据训练并单独评测;业务规则也能直接注入策略层,从而满足工业落地的稳定性需求。但同时,它也导致了“误差级联”和“数据稀缺”两大瓶颈:上游识别错误会一路传递;每个新领域都需要重新标注意图、槽位和对话状态,形成高昂的人力成本。

这一阶段的研究推动,和公开数据集的出现高度相关。以MultiWOZ为代表的多领域任务型对话语料,将此前高度碎片化的小规模标注数据推到“万级对话”的量级,并包含对话信念状态与对话动作等结构化标签,从而使DST与端到端学习都可以在统一基准上比较。MultiWOZ的官方资料与论文存档中明确给出其对话数量为10,438。 这一规模在当时被认为至少比此前多数任务型标注语料大一个数量级,从而直接改变了社区对“可学得的对话策略”与“数据规模阈值”的判断。

2.3 神经网络端到端与开放域对话:生成能力与可控性的张力

2015年前后,序列到序列(seq2seq)与注意力机制推动端到端对话生成成为热点。开放域聊天不再局限于固定意图与槽位,而是试图让系统在更宽的主题空间中保持连贯与有趣。与此同时,任务型对话也开始尝试把多个模块压缩成端到端神经模型,以减少手工特征与模块接口。端到端路线的吸引力在于“数据驱动统一建模”:模型可以在同一损失下同时学习理解与生成,理论上避免模块化的误差级联。然而现实中,开放域生成出现了大量“安全但空泛”的回复模式,任务型端到端模型则常常在结构化一致性(如槽位值正确性)上不如显式DST模块稳定,这导致社区在相当长时间内维持“模块化工程更稳、端到端更灵活”的并行格局。

这种张力在大模型时代并没有消失,只是被重新包装:2025年的观点文章与综述普遍指出,LLM使得端到端生成的表达与泛化能力大幅提升,但可控性与评测仍是难题,尤其当系统不仅要“说得像人”,还要“做得对、做得安全”时,传统TOD的结构化约束与对齐机制又重新成为关键。

表1 关键里程碑与范式迁移

| 时间段 | 主导范式 | 代表性节点(示例) | 对后续发展的关键影响 |

|---|---|---|---|

| 早期—2000s | 规则/符号系统 | 模式匹配与脚本对话 | 建立“对话=状态过程”的工程直觉 |

| 2000s—2010s | 统计学习+模块化TOD | NLU/DST/Policy/NLG流水线 | 可控、可解释、易落地,但数据与维护成本高 |

| 2015—2019 | 神经端到端与多轮生成 | 端到端生成、神经DST、多任务学习 | 统一建模但出现空泛回复与结构一致性问题 |

| 2017—至今 | Transformer与预训练 | Transformer架构提出并成为主流底座 | 使规模化预训练成为可能,推动能力跃迁 |

| 2022—至今 | 指令微调/偏好对齐 | InstructGPT/RLHF体系化 | 把“对齐用户意图”引入训练流程 |

| 2025 | 对话式智能体化 | TOD→Agentic Conversational AI 的系统迁移 | 强调工具使用、规划、监控与控制维度 |

表1的节点与概括性判断主要参考了2024年以来对LLM与对话系统关系的系统综述,以及2025年关于“对话式智能体”能力框架与系统形态变化的讨论。

3 预训练与大模型时代:对话能力如何成为“底座能力”

3.1 Transformer:把对话建模推向可规模化的统一表示

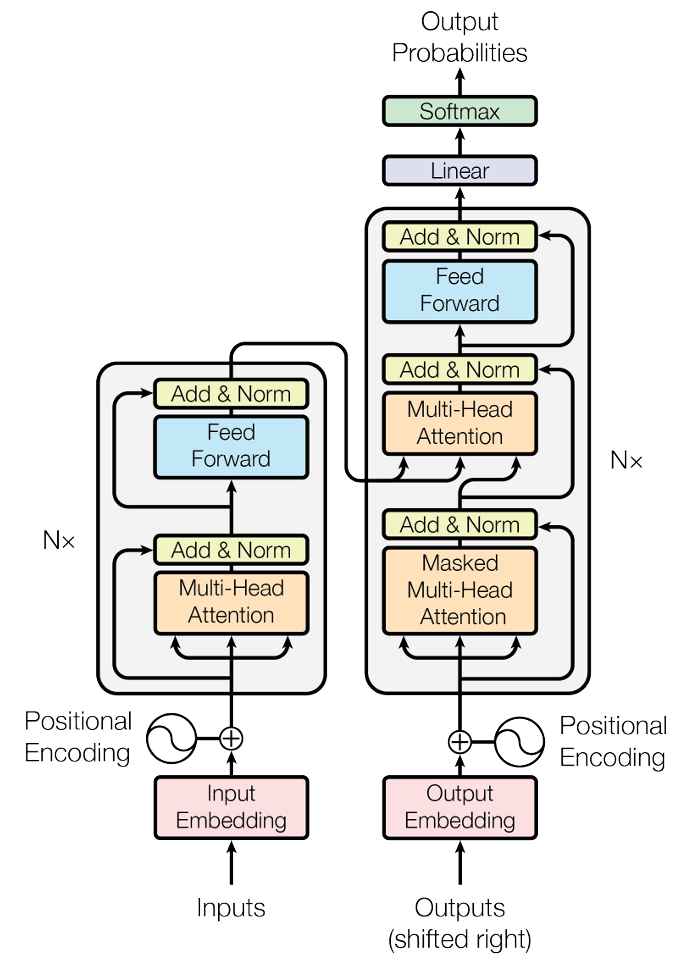

对话式AI的能力跃迁,与其说来自某个单点算法,不如说来自“架构—数据—算力”三者在Transformer框架下的协同。Transformer以自注意力为核心,抛弃了循环与卷积的序列依赖限制,使训练可以高效并行化,从而为更大规模的预训练创造了工程可行性。Vaswani等人在论文中给出了Transformer总体结构,并明确指出编码器与解码器的堆叠自注意力与前馈层构成其主要架构,相关结构示意在论文Figure 1中展示。 这一点对对话尤其关键:对话上下文天然是长程依赖的序列,且包含多轮交互、指代与话题迁移,Transformer的全局注意力机制在表示层面提供了更自然的建模方式。

Transformer往往被当作“所有后续工作的起点”,但对话领域的实际路径更微妙:一方面,Transformer使得语言模型可以更好地拟合大规模文本分布,从而在开放域对话中显著提升流畅度与知识覆盖;另一方面,对话并不是纯文本生成任务,它还包含交互策略、用户状态与外部世界知识的动态变化。因此,Transformer更像是把“语言生成”变成可扩展的底座,而把“对话系统”变成系统工程:如何把检索、工具、记忆与安全控制嵌入到一个统一的交互循环里。2025年IEEE SPM文章对这种系统层面的迁移做了非常明确的描述:LLM让代理式决策与动作执行变得突出,推动TOD范式变化。

图1:Transformer总体结构,编码器在左、解码器在右

3.2 预训练—微调范式:从“对话任务模型”到“通用语言底座再适配”

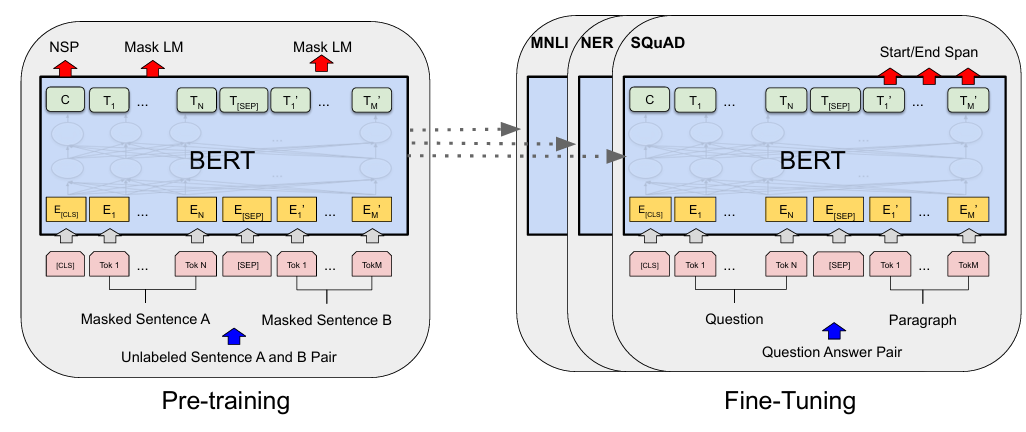

在Transformer架构之上,预训练—微调(pre-train & fine-tune)范式把模型训练分成两个阶段:先在大规模无标注文本上学习通用语言表示,再在下游任务上用较少标注数据进行适配。BERT是这一范式在编码器方向的标志性工作,它强调通过双向上下文学习深层表示,并能在不同任务上以“少量任务特定输出层+整体微调”实现迁移。BERT论文报告了其在GLUE、MultiNLI、SQuAD等多个基准上的显著提升,例如GLUE分数提升到80.5%、MultiNLI准确率到86.7%、SQuAD v1.1测试F1到93.2等。 对对话研究而言,BERT及其后续工作改变的不是“生成能力”,而是“理解能力与表示质量”:意图识别、槽位填充、对话状态跟踪等任务在强表示的加持下显著受益,并逐渐把流水线中的若干模块推向“预训练表示+轻量任务头”的范式。

与此同时,BERT论文中对整体预训练与微调流程的示意图也在综述写作中经常被用来解释“通用底座+任务适配”的思想:同一套预训练参数可以被不同下游任务以不同输出层方式适配,而微调阶段通常对全部参数进行更新。 这为后续“指令微调”与“对话式对齐”提供了概念桥梁:对话可以被视作一类特殊下游任务,但随着指令数据与偏好数据规模化,微调本身也开始从“单任务适配”转向“对齐与能力塑形”。

图2:BERT预训练与微调总体流程示意

3.3 指令微调与偏好对齐:把“会聊天”变成可训练目标

如果说预训练解决的是“模型懂语言”,那么指令微调与偏好对齐试图解决“模型懂用户”。Ouyang等人提出的InstructGPT路线把对齐过程拆解为可操作的数据与优化流程:先收集人工示范进行监督微调(SFT),再收集输出排序训练奖励模型(RM),最后用强化学习从人类反馈(RLHF)进一步优化模型,使其在广泛任务上更符合用户意图。 这一思路对对话式AI具有直接影响,因为对话质量本质上高度依赖人类偏好(有用、礼貌、无害、符合语境、不过度幻觉),而这些往往难以仅靠似然训练捕获。RLHF的引入等于把“对话是否令人满意”从难以形式化的主观评价,部分转化为可收集、可学习的偏好信号,从而把对话系统的优化目标从“预测下一个词”推向“满足用户意图并遵循约束”的更高层目标。

值得注意的是,偏好对齐并不等价于对话系统“完全可控”,它更像是一种在开放域条件下提升平均表现的统计机制:奖励模型本身会继承标注者偏好结构,也可能在分布外场景失效,因此评测与治理问题会在大模型时代以更尖锐的形式回归。2025年的“对话式智能体”综述也强调了控制维度的重要性:工具使用与策略遵循需要更系统化的机制,而不仅是生成式模型的隐式行为。

3.4 多轮对话大模型的研究地图:从“模型”到“系统”的综述化转向

在对话研究社区内部,近两年出现了一个明显趋势:综述文献开始把对话系统描述为“LLM驱动的多轮交互系统”,并以系统组件、数据构建、评测范式与安全治理为主要脉络,而不再只围绕模型结构做分类。2025年8月更新的综述《A Review of Recent Advances in Large Language Model-based Multi-turn Dialogue Systems》就以“LLM用于多轮对话”的关键问题为核心组织材料:包括如何把LLM用于任务型与开放域对话、如何处理长期上下文与记忆、如何引入外部知识与工具、如何进行更可靠的评测与安全对齐等。 这类综述的出现反映出一个事实:对话式AI的技术瓶颈越来越少是“能不能生成”,越来越多是“能不能在交互中稳定地做对的事,并能被客观评估”。

4 系统工程视角:检索增强、工具调用与多智能体对话

4.1 知识接入与可溯源对话:从知识驱动数据集到RAG系统

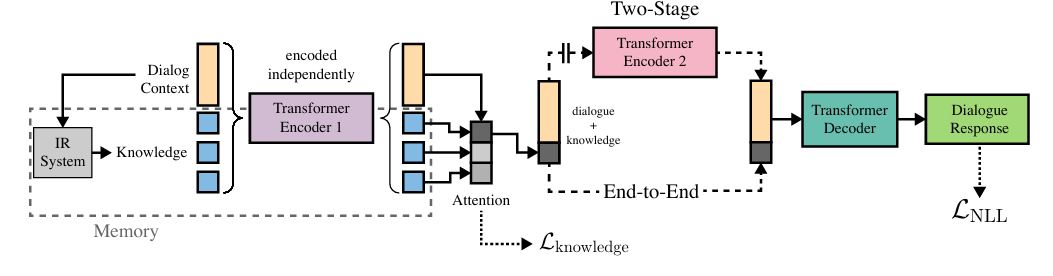

对话式AI长期面临的一个根本矛盾,是开放域对话需要广覆盖知识,而模型参数化记忆又难以保证可更新与可溯源。知识驱动对话数据集的价值,恰在于把“对话内容”与“外部知识证据”绑定,从而让系统在训练与评测时可以区分“会说话”和“有根据地说话”。Wizard of Wikipedia(WoW)就是典型例子:该数据集的核心设置是“wizard”一方在对话中可以访问检索到的Wikipedia段落并据此回复,而“apprentice”看不到这些证据,这使得对话生成天然带有知识依据与检索过程的影子。

图3:生成式Transformer记忆网络。一个信息检索(IR)系统从维基百科提供知识候选项。对话语境(对话上下文)和知识使用共享编码器进行编码。在两阶段模型中,在完成知识选择后,对话和知识会被重新编码。

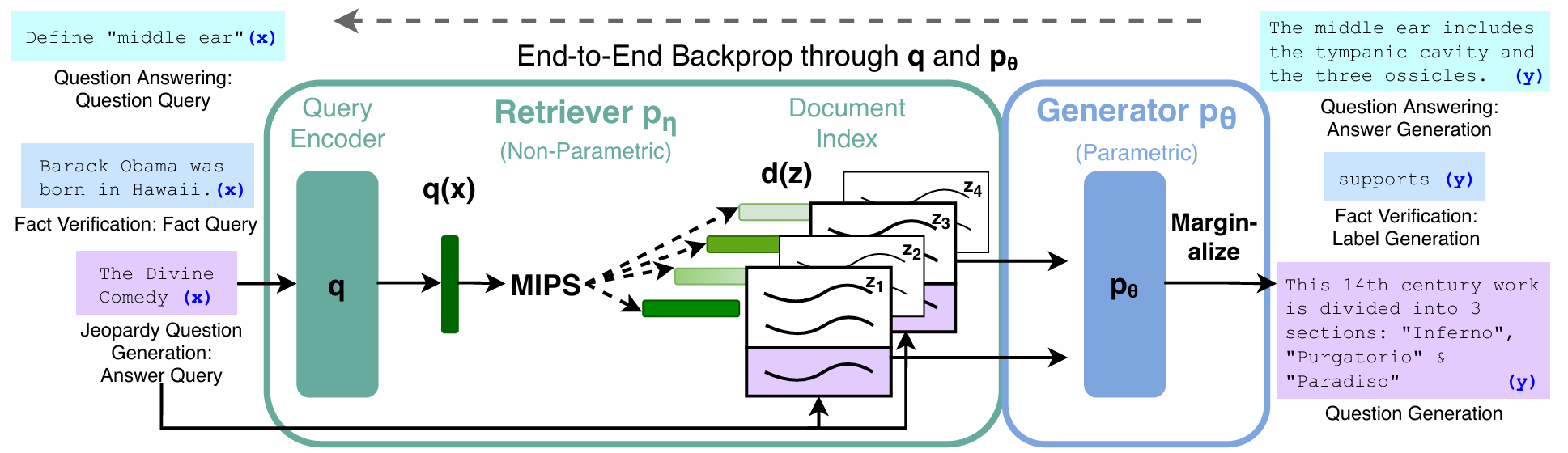

在模型层面,检索增强生成(Retrieval-Augmented Generation, RAG)可以被视作把“知识接入”系统化:模型在生成前先从外部检索器获得相关文档,再把文档作为条件输入进行生成或边生成边检索。Lewis等人在RAG论文中给出了模型总览图,用来说明检索器与生成器如何协同完成知识密集型任务。 这类架构对对话尤其关键,因为对话中的知识需求往往是动态出现的:用户可能在多轮交互中不断引入新实体与新约束,系统需要持续检索、更新并在回复中给出可验证信息。2025年NAACL的研究也在延续这一方向,例如针对“对话系统中的RAG”提出更适配多轮交互与用户语境的检索增强策略。

图4:RAG总体框架示意:检索器与生成器协同

4.2 推理—行动耦合:当对话不止是“回答”,而是“做事”

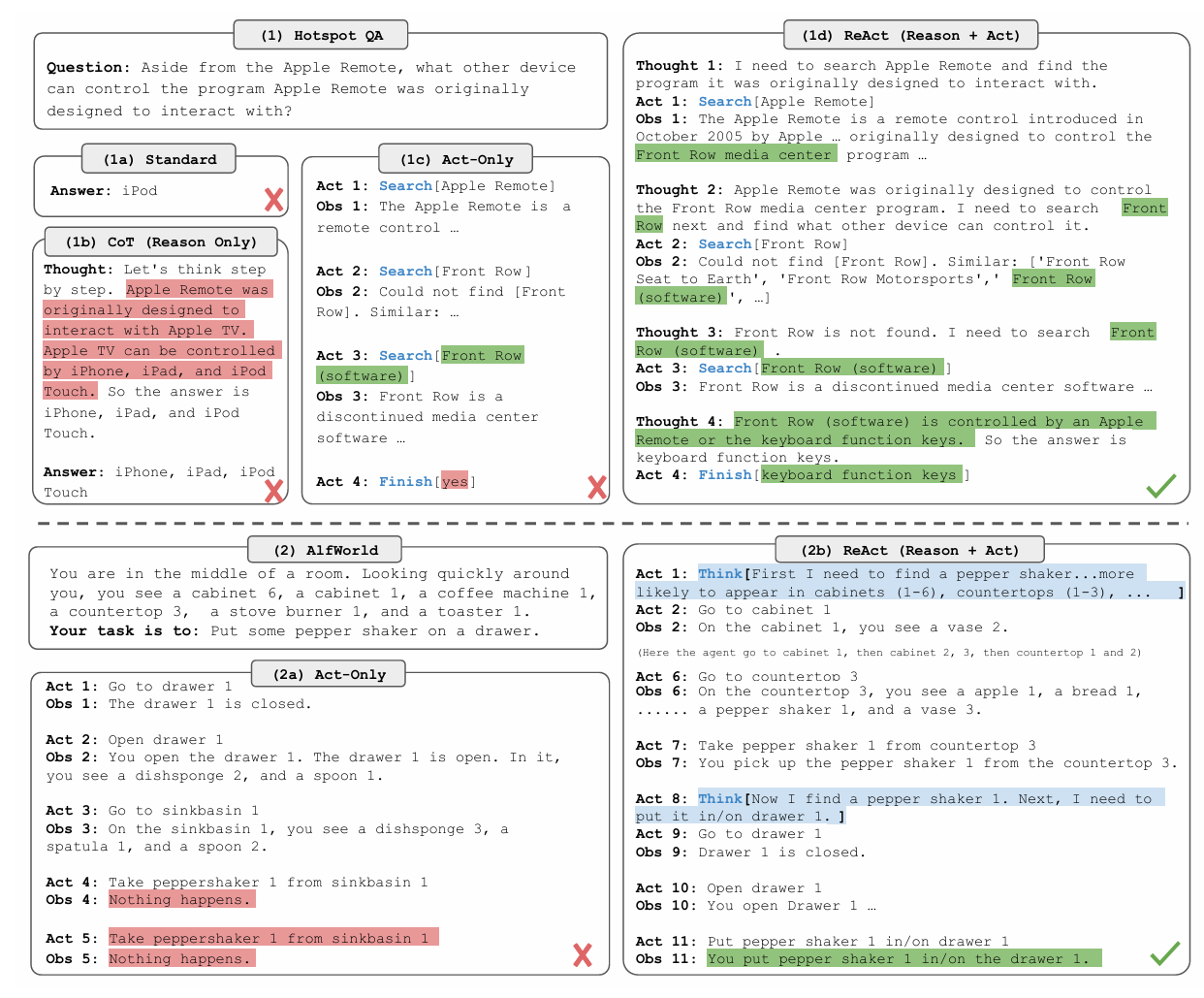

对话式AI成为“智能体”的关键跃迁,在于它需要在对话中完成外部行动:调用工具、访问数据库、操作界面、执行多步计划并在必要时自我纠错。与传统TOD把“API调用”作为对话策略层的显式动作不同,大模型时代一个突出的研究主题是:如何让语言模型在生成过程中显式展示推理轨迹并据此触发行动。ReAct框架提出把“Reasoning(推理)”与“Acting(行动)”交错组织在同一序列中:模型通过生成可读的思考步骤来决定下一步行动(如检索、调用工具),并把行动结果作为新的上下文继续推理与生成。

从系统工程角度看,ReAct类方法的贡献并不只是提示工程技巧,而是把“对话式决策”变成可插拔的循环:对话上下文 → 推理 → 行动(工具/检索/执行)→ 观察结果 → 更新上下文 → 再推理。这与2025年对话式智能体综述中强调的Control维度高度一致:系统要能遵循策略并有效使用工具,而推理—行动耦合为这种控制提供了可观测的中间态。

图5:展示React序列:推理与行动交替的提示示例

4.3 多智能体协作与“对话的社会性”:从单一助手到群体互动

当对话式AI开始承担复杂任务时,单一模型往往难以同时兼顾规划、执行、审校与安全约束,因此“多智能体协作”成为近两年的高频主题:通过让多个LLM代理分工协作(例如一个负责规划,一个负责检索,一个负责检查),系统可以在一定程度上提升可靠性与覆盖度。2025年的多智能体协作综述《Multi-Agent Collaboration Mechanisms: A Survey of LLMs》把这一方向系统化,强调从单模型走向协作型多代理,是Agentic AI的重要趋势,并试图用更结构化的机制框架总结协作方式。 与此同时,也出现了探讨“多代理规模是否带来类似模型规模的收益”的研究,例如ICLR 2025关于多智能体协作网络的工作就以“增加协作代理是否能提升性能”为问题意识展开。

更值得对话研究者关注的,是多智能体互动带来的“社会性现象”:当多个LLM代理在群体中反复沟通时,它们可能自发形成约定俗成的表达方式与规范,甚至出现集体偏置。Science Advances 2025的一项研究在LLM代理群体中展示了社会规范的自发涌现与集体偏差问题,论文指出在去中心化的LLM代理群体互动中可以出现被普遍采用的社会惯例,并可能在个体无偏时仍出现强集体偏置。 这意味着对话式AI的风险不再只来自单体模型的幻觉或不当输出,还可能来自“群体层面的协同偏差”:多个代理在相互强化中形成不符合人类价值的约定,从而在系统级产生新型失控路径。2025年的对话式智能体综述也把“协作与多智能体任务完成”作为关键研究缺口之一,恰与上述现象呼应。

4.4 架构层面的再分类:传统TOD、LLM对话、Agentic Conversational AI

为了把上述变化更系统地表达出来,有必要把“对话系统架构”从旧的“任务型/开放域”二分,扩展到“能否行动、能否控制、能否评测”的系统维度。2025年IEEE SPM文章讨论TOD范式迁移时,其实暗含一种新的分类方式:传统TOD强调结构化状态与显式策略;LLM驱动系统强调自然语言能力与泛化;对话式智能体则强调工具使用、规划与行动执行,并需要新的评测框架支撑。 与此同时,“desideratum”型综述把能力维度化(Reasoning/Monitor/Control),使我们可以在架构层面对齐:哪些组件在支撑推理?哪些机制在做监控(用户状态、系统自检)?哪些模块或约束在做控制(工具调用权限、策略遵循)?

表3 对话式AI系统架构的系统工程对比(面向能力维度)

| 架构类型 | 典型组成 | 推理/规划能力 | 监控与记忆 | 控制与约束 | 典型风险形态 |

|---|---|---|---|---|---|

| 传统模块化TOD | NLU+DST+Policy+NLG | 多为策略层显式(规则/强化学习) | 状态显式但多为短期 | 强:接口清晰、易加规则 | 误差级联、跨域扩展成本高 |

| 端到端神经TOD | 单模型或弱模块接口 | 有一定隐式推理但难解释 | 依赖上下文窗口/隐式表示 | 中:可加约束但不如显式状态 | 结构一致性不足、难调试 |

| LLM提示式对话 | LLM+提示/指令 | 强:可零样本推理 | 依赖上下文与外部记忆设计 | 弱到中:需外部策略护栏 | 幻觉与越权、评测困难 |

| LLM+RAG对话 | LLM+检索器+证据拼接 | 知识推理增强、可溯源潜力 | 需做证据管理与记忆压缩 | 中:可用证据约束输出 | 证据选择错误、引用漂移 |

| Agentic对话系统 | LLM+工具+规划循环+审校 | 强:可多步计划与执行 | 需要长期记忆、用户模型 | 必须强:权限、策略、审计 | 工具滥用、链式失败与系统级风险 |

表3的分类依据与讨论逻辑主要参考2025年IEEE SPM对“LLM推动TOD范式迁移”的系统描述,以及2025“desideratum”综述提出的能力维度化框架,同时结合RAG与ReAct等典型系统形态。

5 数据、评测与基准:对话式AI如何被“可靠测量”

5.1 数据集生态:规模、标注结构与任务定义的共同演化

对话式AI研究的一个基本规律是:系统形态往往被“可获得的数据结构”所塑造。任务型对话需要结构化状态与动作,因此MultiWOZ这类数据集把信念状态与对话动作标注出来;开放域对话强调个性一致性与主题连贯,因此PersonaChat把人格设定作为对话条件;知识驱动对话强调证据,因此Wizard of Wikipedia把检索到的Wikipedia段落纳入对话过程;情感与同理心对话则需要情绪场景与情感标签,因此EmpatheticDialogues以“情绪情境”为对话基底。 这些数据集并非只是训练材料,它们同时定义了社区“什么算对话能力”的隐含标准:能否完成目标、能否保持人设、能否引用知识、能否共情。

为了让“数据—能力—评测”的关系更直观,表2汇总了若干代表性公开数据集的规模信息。需要强调的是:本文只列出联网检索中能明确找到数量统计的条目,并在数据来源处给出可核验链接对应的引用标识,避免凭印象写数字。

表2 典型公开对话数据集的规模与特征(部分统计)

| 数据集 | 类型/侧重点 | 规模(对话/轮次数等) | 标注或结构特征 | 典型用途 |

|---|---|---|---|---|

| MultiWOZ | 多领域任务型TOD | 10,438 dialogues | 含belief states、对话动作等结构化标签 | DST、TOD生成、端到端TOD |

| DailyDialog | 开放域日常对话+情绪/意图 | 13,118 multi-turn dialogues | 人工标注对话行为流与情绪信息 | 多轮生成、情感/意图建模 |

| PersonaChat | 人设一致性对话 | 10,981 dialog pairs;164,356 utterances | 每方有persona profile,强调一致性 | 个性化生成、长期一致性 |

| EmpatheticDialogues | 共情对话 | 约25k conversations | 对话 grounded in emotional situations | 共情生成、情绪理解 |

| Topical-Chat | 主题对话/知识型闲聊 | 10,784 conversations;235,281 utterances;平均轮次21.8 | 围绕阅读材料/主题展开,多轮较长 | 主题迁移、知识型闲聊 |

| Wizard of Wikipedia | 知识驱动对话 | 22,311 dialogues;201,999 turns;2,437 topics | wizard可见Wikipedia证据,apprentice不可见 | 知识检索+生成、grounding |

表2中MultiWOZ对话数来自其官方数据存档说明;DailyDialog对话数来自其ACL Anthology论文PDF中的数据处理与统计描述;PersonaChat对话与utterances数量来自ACL 2018论文摘要/正文描述;EmpatheticDialogues规模来自ACL 2019论文摘要;Topical-Chat规模统计来自其开源仓库README中的数据统计;Wizard of Wikipedia统计来自公开实现项目对数据处理部分给出的规模信息,且与该数据集在社区中的常见引用口径一致。

5.2 自动指标的困境:对话质量不是“一个分数”

对话评测长期被诟病,原因在于它同时包含语言质量、任务成功、知识正确性、风格一致性与安全性等多个维度,而且这些维度之间常常互相牵制。仅以生成文本相似度为目标的自动指标,往往无法反映交互质量;而只做人工评测又成本高、可重复性差。2025年的DSTC12(Dialog System Technology Challenge 12)就以“对话评测”的难题为问题背景,提出了自动指标与人类偏好对齐的任务设置。其Track 1的概览文档中直接给出一个非常直观的数字:官方提供的baseline指标与人类偏好之间的Spearman相关系数只有0.1681,这在某种意义上把“自动指标与人类感受不一致”从经验判断变成了可量化证据。

这一数字之所以重要,是因为它提醒我们:当对话式AI走向“智能体化”之后,评测的对象不再只是“回复文本”,而是“系统在交互中的行为轨迹”。如果一个系统能生成漂亮的文字却频繁调用错误工具或泄露隐私,它在智能体语境下显然是失败的;相反,一个系统可能语言略显生硬,但能稳定完成任务并遵循政策约束,它在实际部署中可能更有价值。2025年关于对话式智能体的“desideratum”综述也明确把“现实评测与缺口”作为重点方向,强调评测必须覆盖推理、监控与控制维度。

5.3 系统级与交互式评测:从竞赛到统一框架

对话评测的另一条路径,是把评测从“单轮文本”提升到“多轮任务完成”,并把评测过程标准化,从而在不同系统形态之间获得可比性。2025年SIGDIAL论文提出的clem:todd框架就是这一思路的代表:它强调在一致条件下系统性评测LLM驱动的任务型对话系统实现,支持不同用户模拟器与对话系统组合的统一基准,从而避免“只评测某一种系统设计”的结果难以泛化的问题。 与此同时,EMNLP 2025也出现了关于“把预训练LLM当作TOD系统”的强基线研究,反映出社区在试图回答一个非常现实的问题:当LLM成为底座后,哪些“系统设计”是真正必要的增益,哪些只是工程复杂度?

从更宽的视角看,这类框架化评测与竞赛型评测(如DSTC)形成互补:竞赛推动社区集中攻克某类能力瓶颈,并提供统一测试平台;框架化评测则把多种系统形态纳入可重复的实验管线,使研究结论更具可迁移性。二者共同指向一个趋势:对话式AI的科研方法正在从“提出一个模型并在少数数据集上报告分数”转向“提出一套系统并在统一协议下评测其交互行为与安全边界”。

5.4 语音对话的实时性与轮次控制:turn-taking与全双工交互

当对话从文本走向语音与实时交互,问题会进一步复杂化:系统不仅要“回答对”,还要“插话时机对、延迟对、能被打断”。IWSDS 2025的一篇综述专门回顾了口语对话系统中的turn-taking建模方法,并给出一个令人警醒的观察:其统计发现,所回顾的工作中有72%并没有将方法与此前工作进行对比,这意味着该领域缺乏稳定基准来监控进展。 这对“语音对话式智能体”尤为关键,因为实时交互的体验高度依赖这些细节,而缺乏可复现比较会导致工程系统难以积累可靠经验。

2025年另一条值得关注的线索,是对“同步/全双工”语音对话的系统化综述:有研究把“允许同时说与听、允许重叠与打断”的全双工语音交互视为走向类人对话的重要里程碑,并尝试建立该方向的分类框架。 与此同时,EMNLP 2025也出现了关于“Spoken Conversational Agents with Large Language Models”的教程与材料,强调从传统级联ASR/NLU走向更端到端、更检索与多模态融合的语音对话系统路线。 这些材料共同表明:对话式AI的下一波体验升级,可能不在文本能力,而在实时语音交互与多模态整合。

表4 对话式AI评测维度、典型方法与2025相关动向

| 评测维度 | 为什么难 | 常见离线评测方式 | 更接近真实的评测方式 | 2025相关线索 |

|---|---|---|---|---|

| 有用性/任务成功 | 需要跨轮累计效果 | 任务成功率、slot准确 | 交互式用户模拟/真人AB | clem:todd统一评测框架 |

| 自然性/连贯性 | 多参考答案 | 人工打分、对话一致性 | 长会话真人体验 | DSTC12对话评测任务 |

| 事实性/可溯源 | 需要证据链 | 基于知识库的正确率 | RAG+证据引用评测 | NAACL 2025对话RAG方向 |

| 安全/合规 | 规则复杂且动态 | 安全测试集、红队 | 在线审计+策略执行 | 对话式智能体强调Control维度 |

| 实时交互体验 | 延迟与轮次控制 | 延迟统计、VAD/turn指标 | 全双工/可打断真人对话 | IWSDS turn-taking综述与缺乏基准问题 |

6 2025年研究前沿:代表性工作综合解读

6.1 任务型对话:从“模型堆分”到“可比、可复现的系统基线”

2025年任务型对话研究出现了明显的“去神秘化”倾向:社区开始更认真地回答“LLM到底在TOD里带来了什么增益?传统模块的哪些功能还需要保留?”这一趋势的两条代表性线索,一条来自评测框架,另一条来自强基线。前者是SIGDIAL 2025提出的clem:todd,它将用户模拟器与对话系统实现纳入统一评测管线,强调在一致数据集、指标与计算约束下进行系统性比较,从而给出更可迁移的工程启示。 后者是EMNLP 2025关于“预训练LLM作为TOD系统”的强基线研究,它暗示如果基线足够强,许多“看似有效”的系统改进可能只是与弱基线比较时的假象,因此需要更严格的实验协议。

这两条线索共同反映出一个更深层的学术转向:当LLM把语言生成与理解提升到相对高的水平后,研究的差异化空间不再主要来自“更复杂的网络结构”,而来自“更合理的任务形式化、更可靠的评测协议以及更可控的系统设计”。这也与2025年对话式智能体综述强调的“现实评测缺口”一致:如果没有可复现、可解释的评测框架,智能体系统很难被严肃地改进。

6.2 Persona与长期对话:规模化人设数据与长期记忆的工程化

个性化与长期对话一直是开放域对话的核心难题:系统需要在长时间跨度上保持自我一致,记住用户偏好,并在不同会话之间迁移。2025年NAACL工业轨道论文提出利用大规模persona数据工程构建开放域persona对话系统PPDS,核心动机是现有人设对话数据规模与多样性不足,限制了人设一致性的鲁棒学习,因此希望通过更大规模的数据与生成式预训练提升一致性能力。 与此同时,也有研究专门关注“长期对话”的系统需求,例如针对“长期陪伴型聊天”提出需要事件总结与persona管理等机制,指出多数对话系统过度聚焦短会话而忽视真实场景的长期交互需求。

这类工作与传统PersonaChat等数据集的关系是连续而非替代:PersonaChat提供了较早的可控人设对话基准,但其规模与场景仍有限;2025年的工作则更像把人设一致性当作可规模化工程问题,通过数据工程与预训练策略把“人设一致”从小样本任务推向更广覆盖的能力维度。

6.3 对话对齐与反馈学习:从turn-level偏好到session-level全局反馈

对话对齐的难点之一,是高质量细粒度反馈昂贵:让标注者逐轮给出偏好、纠错与奖励信号成本极高。2025年EMNLP Findings提出的“LLM奖励分解”思路,尝试用冻结的LLM把一次会话级(session-level)的全局反馈分解为更细粒度的局部隐式奖励,再蒸馏成轻量奖励模型,用于基于RL的对话生成微调,并在文本与多模态(包含行为线索的自然语言描述)设置下做验证。 这类工作的重要性在于:它把对话对齐从“昂贵的人类逐轮标注”推向“用LLM推理补全信用分配”,使大规模对话对齐在成本上更可想象,同时也把“监控与自我评估”能力嵌入训练流程,与2025对话式智能体框架的Monitor维度形成呼应。

6.4 对话状态跟踪与真实交互:多方对话、噪声与可解释表示

DST在LLM时代出现一个看似矛盾的现象:LLM在零样本DST上表现强,但传统DST基准多是结构化的单用户—系统对话,难以代表真实多人互动与噪声环境。2025年EMNLP Findings有研究专门评估LLM在“多用户DST”场景下的鲁棒性,并通过生成第二用户话语的方式扩展现有DST数据集,以较低构建成本模拟真实多方对话复杂性。 同期也有研究尝试把DST从slot-value表示转向自然语言摘要表示,以提升可解释性与鲁棒性,例如提出用LLM生成对话状态的自然语言描述来替代传统表示。

这些方向共同指向一个判断:DST不会因为LLM强大而消失,它会从“分类/抽取任务”转向“可解释的交互记忆与约束表示”,并在多方对话与现实噪声条件下重新定义评测目标。换言之,LLM降低了DST的门槛,但把DST的真实难题(多方互动、含混意图、上下文漂移)推到了更前台的位置。

6.5 语音与多模态对话:从级联系统到voice-native LLM

2025年语音对话的关键关键词是“voice-native”:系统不再只是把语音转成文本再交给文本LLM,而是探索更端到端的语音—语言统一建模与更实时的交互控制。EMNLP 2025教程明确把路线描述为从级联ASR/NLU走向端到端、检索与视觉接地的系统,并讨论跨模态对齐、联合语音—文本训练与工程配方。 同时,全双工语音对话综述把“可重叠、可打断”的同步交互作为通往类人对话的重要里程碑,说明语音对话的挑战已经从“识别准确率”扩展为“交互节奏与社会对话行为”。

表5 2025年代表性研究工作(按主题整合)

| 主题 | 2025代表性工作 | 核心贡献 | 对系统形态的启示 |

|---|---|---|---|

| TOD统一评测 | clem:todd(SIGDIAL 2025) | 统一条件下系统性评测LLM-TOD组合 | TOD研究从“点状模型”走向“框架化可比” |

| TOD强基线 | EMNLP 2025强基线 | 强化“基线的重要性”,推动更严谨比较 | 许多改进需在强基线下重评 |

| Persona数据工程 | NAACL 2025工业轨道PPDS | 大规模persona数据预训练提升一致性 | 个性化从小任务变成数据规模问题 |

| 对话对齐与反馈 | EMNLP Findings 2025奖励分解 | session-level反馈→turn-level奖励推断 | 降低细粒度标注成本,强化Monitor维度 |

| 多用户DST鲁棒性 | EMNLP Findings 2025多用户DST评估 | 扩展基准模拟多方互动复杂性 | 真实交互需要超越单用户对话设定 |

| 语音对话系统路线 | EMNLP 2025教程与材料 | 级联→端到端→检索/视觉接地 | 体验升级来自实时性与多模态融合 |

| 对话RAG系统 | NAACL 2025对话RAG研究 | 更适配多轮语境的RAG设计 | 事实性与可更新性更依赖系统设计 |

7 挑战与未来方向:从“能聊”到“可信、可控、可持续”

7.1 事实性与知识更新:RAG不是银弹,但可能是工程主干

大模型对话系统的“幻觉”问题在知识密集场景中尤为突出,而对话场景又天然要求系统在多轮交互中保持一致与可追责。RAG与知识接地数据集提供了一条务实路径:把关键事实从参数记忆迁移到外部证据,使系统具备可更新性与可溯源性。 但RAG也引入新的失败模式:检索错误、证据选择偏差、证据与生成不一致、跨轮引用漂移等。因此未来方向不应简单表述为“加检索”,而是要把检索、证据管理、引用生成与评测协议作为一体化系统来优化,并在竞赛与框架层面形成稳定比较机制。DSTC12对自动指标与人类偏好相关性偏低的结果,也从侧面说明:如果评测协议不能体现“证据正确性与引用一致性”,系统就可能在指标驱动下走向错误优化。

7.2 长期记忆、个性化与主动性:对话式智能体的“社会关系”问题

随着对话式AI从工具走向陪伴与长期服务,个性化与长期记忆成为核心需求:系统既要记住用户偏好与历史事件,又要避免在隐私上越界;既要在长期互动中保持一致,又要能随用户变化而更新。2025年的persona数据工程工作与长期对话个性化研究,表明社区正在把这些需求转化为可训练与可评测的问题:通过更大规模的人设数据预训练增强一致性,通过事件总结与persona管理支持长期交互。 同时,“desideratum”综述把主动性(proactivity)作为重要方向,意味着未来系统可能需要在合适时机主动提出澄清问题、提醒风险或提供建议,而不仅是被动回答。 这将进一步放大监控与控制的重要性:主动性如果没有严格的策略边界,可能迅速演化为“打扰”甚至“操控”。

7.3 安全、合规与可审计:Control维度的工程化落地

当对话系统具备工具调用与动作执行能力后,安全问题的本质发生变化:风险不再只是“说错话”,而是“做错事”。这要求系统具备可审计的控制机制,包括权限管理、工具调用白名单、敏感操作确认、日志与追踪,以及对越权行为的实时阻断。2025年IEEE SPM文章强调LLM推动代理式决策与动作执行成为焦点,本质上意味着对话系统从“内容系统”走向“行为系统”,其治理逻辑必须升级。 2025“desideratum”综述也把Control作为核心维度之一,提示社区需要把策略遵循与工具使用纳入能力框架与评测体系。

更复杂的是,多智能体系统会引入群体层面的新风险:Science Advances 2025关于社会惯例自发涌现的研究表明,LLM代理群体可能形成集体偏差与自组织规范,这意味着安全治理不仅要约束单个模型的输出,还要考虑代理之间的互动机制、通信协议与协作分工是否会放大偏差。

7.4 评测标准化与可复现:对话研究的“方法学红利”仍未吃尽

对话式AI的另一个长期痛点,是研究结论难以复现、指标不稳定、数据分割与评测协议各自为政。IWSDS 2025对turn-taking研究的统计结果(72%工作不与既有方法对比)提醒我们:即便在相对成熟的子领域,缺乏统一基准也会让进展难以累积。 因此未来的重要方向之一,是在更多关键能力(工具使用、长期记忆、主动澄清、实时语音交互等)上形成类似DSTC、clem:todd那样可持续的评测生态:既有竞赛驱动的集中基准,也有框架化的系统性评测,使对话式智能体研究能在可复现的轨道上积累。

7.5 结语:对话式AI的下一阶段是一场系统工程与治理工程

综合本文回顾可以看到:对话式AI的发展并非线性从“规则→神经→大模型”那么简单,而是不断在“生成能力、结构约束、外部知识、行动执行、评测协议与治理机制”之间重新平衡。大模型把对话能力推到新高度,同时也把系统性难题集中暴露:如果没有可靠评测,改进难以验证;如果没有控制机制,能力越强风险越大;如果没有数据与协议的标准化,研究无法累积。2025年的综述与最新研究已经清晰地把未来路线指向“对话式智能体”:以推理、监控与控制为能力框架,以检索、工具与多智能体为系统形态,以竞赛与统一评测框架为方法学支撑。 这场迁移很可能决定对话式AI能否从“令人惊艳的聊天”走向“可依赖的交互基础设施”。

参考文献

[1] Acikgoz E C, Hakkani-Tür D, Tur G. Conversational Agents in the Era of Large Language Models [Perspectives][J]. IEEE Signal Processing Magazine, 2025, 42(3): 35-39.

[2] Acikgoz E C, Qian C, Wang H, et al. A desideratum for conversational agents: Capabilities, challenges, and future directions[J]. arXiv preprint arXiv:2504.16939, 2025.

[3] Yi Z, Ouyang J, Xu Z, et al. A survey on recent advances in llm-based multi-turn dialogue systems[J]. ACM Computing Surveys, 2024.

[4] Minaee S, Mikolov T, Nikzad N, et al. Large language models: A survey[J]. arXiv preprint arXiv:2402.06196, 2024.

[5] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. Advances in neural information processing systems, 2017, 30.

[6] Devlin J, Chang M W, Lee K, et al. Bert: Pre-training of deep bidirectional transformers for language understanding[C]//Proceedings of the 2019 conference of the North American chapter of the association for computational linguistics: human language technologies, volume 1 (long and short papers). 2019: 4171-4186.

[7] Ouyang L, Wu J, Jiang X, et al. Training language models to follow instructions with human feedback[J]. Advances in neural information processing systems, 2022, 35: 27730-27744.

[8] Lewis P, Perez E, Piktus A, et al. Retrieval-augmented generation for knowledge-intensive nlp tasks[J]. Advances in neural information processing systems, 2020, 33: 9459-9474.

[9] Yao S, Zhao J, Yu D, et al. React: Synergizing reasoning and acting in language models[C]//The eleventh international conference on learning representations. 2022.

[10] Budzianowski P, Wen T H, Tseng B H, et al. Multiwoz--a large-scale multi-domain wizard-of-oz dataset for task-oriented dialogue modelling[J]. arXiv preprint arXiv:1810.00278, 2018.

[11] Li Y, Su H, Shen X, et al. Dailydialog: A manually labelled multi-turn dialogue dataset[J]. arXiv preprint arXiv:1710.03957, 2017.

[12] Zhang S, Dinan E, Urbanek J, et al. Personalizing dialogue agents: I have a dog, do you have pets too?[J]. arXiv preprint arXiv:1801.07243, 2018.

[13] Rashkin H, Smith E M, Li M, et al. Towards empathetic open-domain conversation models: A new benchmark and dataset[C]//Proceedings of the 57th annual meeting of the association for computational linguistics. 2019: 5370-5381.

[14] Dinan E, Roller S, Shuster K, et al. Wizard of wikipedia: Knowledge-powered conversational agents[J]. arXiv preprint arXiv:1811.01241, 2018.

[15] Chalamalasetti K, Hakimov S, Schlangen D. clem: todd: A Framework for the Systematic Benchmarking of LLM-Based Task-Oriented Dialogue System Realisations[C]//Proceedings of the 26th Annual Meeting of the Special Interest Group on Discourse and Dialogue. 2025: 62-92.

[16] Castillo-López G, de Chalendar G, Semmar N. A Survey of Recent Advances on Turn-taking Modeling in Spoken Dialogue Systems[C]//Proceedings of the 15th International Workshop on Spoken Dialogue Systems Technology. 2025: 254-271.

[17] Chen Y, Yu H. From Turn-Taking to Synchronous Dialogue: A Survey of Full-Duplex Spoken Language Models[J]. arXiv preprint arXiv:2509.14515, 2025.

[18] Huck Yang A S, Heck L P. Spoken Conversational Agents with Large Language Models[J]. arXiv e-prints, 2025: arXiv: 2512.02593.

[19] Ashery A F, Aiello L M, Baronchelli A. Emergent social conventions and collective bias in LLM populations[J]. Science Advances, 2025, 11(20): eadu9368.

[20] Tran K T, Dao D, Nguyen M D, et al. Multi-agent collaboration mechanisms: A survey of llms[J]. arXiv preprint arXiv:2501.06322, 2025.

[21] Qian C, Xie Z, Wang Y, et al. Scaling large language model-based multi-agent collaboration[J]. arXiv preprint arXiv:2406.07155, 2024.

[22] Wang X, Sen P, Li R, et al. Adaptive retrieval-augmented generation for conversational systems[C]//Findings of the Association for Computational Linguistics: NAACL 2025. 2025: 491-503.

[23] Hong M, Zhang C J, Chen C, et al. Dialogue language model with large-scale persona data engineering[C]//Proceedings of the 2025 Conference of the Nations of the Americas Chapter of the Association for Computational Linguistics: Human Language Technologies (Volume 3: Industry Track). 2025: 961-970.

[24] Lee D W, Park H W, Breazeal C, et al. Aligning Dialogue Agents with Global Feedback via Large Language Model Multimodal Reward Decomposition[C]//Findings of the Association for Computational Linguistics: EMNLP 2025. 2025: 22755-22787.

[25] Song S, Choi J, Yun J M, et al. Beyond Single-User Dialogue: Assessing Multi-User Dialogue State Tracking Capabilities of Large Language Models[J]. arXiv preprint arXiv:2506.10504, 2025.

[26] Carranza R, Rojas M A. Interpretable and Robust Dialogue State Tracking via Natural Language Summarization with LLMs[J]. arXiv preprint arXiv:2503.08857, 2025.

[27] Steindl S, Kestler A, Schäfer U, et al. An Improved, Strong Baseline for Pre-Trained Large Language Models as Task-Oriented Dialogue Systems[C]//Findings of the Association for Computational Linguistics: EMNLP 2025. 2025: 11388-11398.

1649

1649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?