目录

参考文献:Chen, X., Hu, X., Huang, Y. et al. Deep learning-based software engineering: progress, challenges, and opportunities. Sci. China Inf. Sci. 68, 111102 (2025). https://doi.org/10.1007/s11432-023-4127-5

1 引言

随着人工智能技术的快速发展,深度学习作为机器学习的一个重要分支,已经在自然语言处理、计算机视觉、语音识别等领域取得了突破性进展。近年来,深度学习技术逐渐渗透到软件工程的各个环节,从需求分析、代码生成、软件测试到缺陷修复和开发者协作,都展现出强大的潜力和广阔的应用前景。软件工程作为一门研究如何系统化、规范化、可量化地开发和维护软件的学科,长期以来面临着代码复杂性增长、开发效率瓶颈、质量保障困难等挑战。传统软件工程方法依赖于人工制定的规则、启发式算法和静态分析技术,虽然在特定场景下取得了良好效果,但在处理大规模、高复杂度的现代软件系统时逐渐显现出局限性。深度学习技术凭借其强大的特征自动提取能力、非线性建模能力和端到端的学习机制,为解决软件工程中的诸多难题提供了全新的思路和方法。

深度学习在软件工程中的应用呈现出几个显著特点。首先,它能够自动化地捕捉软件制品中的深层语义信息。无论是源代码、需求文档还是缺陷报告,都蕴含着丰富的结构和语义信息,传统方法往往需要专家手工设计特征提取规则,而深度学习模型可以通过多层神经网络自动学习这些表示。例如,在处理源代码时,长短期记忆网络(LSTM)和门控循环单元(GRU)能够有效建模代码标记之间的长距离依赖关系,卷积神经网络(CNN)擅长捕捉局部语法模式,而图神经网络(GNN)则可以显式地利用抽象语法树(AST)、控制流图(CFG)等程序结构信息。其次,预训练语言模型(如BERT及其在代码领域的变体CodeBERT、GraphCodeBERT)的出现,使得模型能够从海量无标注代码数据中学习到通用的程序表示,再通过微调适应特定下游任务,极大地提升了模型性能和泛化能力。第三,深度学习推动了软件工程从传统的基于规则的方法向数据驱动的方法转变,许多过去被认为难以自动化的任务,如代码摘要生成、跨语言代码搜索、智能重构建议等,现在都取得了令人瞩目的成果。

然而,将深度学习技术成功应用于软件工程并非易事,面临着诸多独特挑战。软件工程数据具有高度异构性,包括结构化代码、半结构化文档和非结构化文本,如何统一表示这些数据并设计合适的神经网络架构是一个核心问题。此外,软件工程领域对模型的可解释性、可靠性和安全性要求极高,开发者需要理解模型做出特定预测或建议的原因,这在深度学习模型的"黑盒"特性面前构成了严峻挑战。数据质量与规模问题同样突出,高质量的标注数据获取成本高昂,而自动挖掘的数据又可能存在噪声和偏差。跨语言、跨项目的泛化能力也是制约深度学习模型实际部署的关键因素,不同编程语言的语法语义差异、不同项目的编码规范和架构风格多样性,都给模型的通用性带来了巨大障碍。本文旨在系统性地梳理深度学习在软件工程各个子领域的理论框架、技术方法、应用实践和面临挑战,为研究者提供全面的技术参考,为实践者揭示可行的应用路径,并展望未来的发展方向。

2 理论基础与技术框架

2.1 深度学习核心模型体系

深度学习在软件工程中的应用建立在若干基础神经网络架构之上,这些架构针对不同类型的软件制品和任务特性展现出各自的优势。循环神经网络(RNN)及其变体构成了处理序列化代码表示的基石。标准的RNN通过隐藏状态来捕捉序列中的时序依赖,但其面临梯度消失和梯度爆炸问题。长短期记忆网络(LSTM)通过引入输入门

、遗忘门

和输出门

三个门控机制,以及细胞状态

,有效解决了长距离依赖建模问题。双向LSTM(Bi-LSTM)通过前向和后向两个方向的隐藏状态拼接

,能够同时利用过去和未来的上下文信息,在代码补全和缺陷预测任务中表现优异。

卷积神经网络(CNN)在软件工程中主要用于捕捉代码的局部模式和结构特征。对于代码标记序列,一维卷积层通过滤波器在输入序列上滑动,计算局部特征映射

,其中 k 是卷积核大小,d 是词向量维度。多层卷积堆叠配合最大池化操作能够提取不同抽象层次的功能特征。在代码异味检测中,CNN被用于分析代码度量指标的时序演化模式,通过将多个版本的度量值视为二维矩阵输入,卷积核可以自动学习指示坏味道的模式。对于图结构数据,如图卷积网络(GCN)通过邻居聚合机制

$$h_v^{(l+1)} = \sigma(\sum_{u \in \mathcal{N}(v)} \frac{1}{\sqrt{d_ud_v}} W^{(l)} h_u^{(l)})$$

实现节点表示的更新,其中 N(v) 表示节点 v 的邻居集合,d_u 是节点 u 的度,这种结构非常适合处理抽象语法树和控制流图。

2.2 注意力机制与Transformer架构

注意力机制是近年来推动软件工程领域进步的关键技术,它允许模型在处理序列时动态地关注不同位置的重要性。自注意力机制的计算过程可以表示为:

$$

\text{Attention}(Q, K, V) = \text{softmax}(\frac{QK^T}{\sqrt{d_k}})V

$$

其中查询矩阵 Q 、键矩阵 K 和值矩阵 V 都是输入序列的线性变换,dk 是键向量的维度。多头注意力通过并行计算 h 个不同的注意力头并将结果拼接,使模型能够从不同子空间捕捉多样化的依赖关系。在代码摘要生成任务中,注意力权重能够揭示生成每个描述词时所依赖的代码片段,提供了一定的可解释性。

Transformer架构完全基于注意力机制,摒弃了循环结构,通过位置编码注入序列顺序信息。编码器层由多头自注意力和前馈网络组成,解码器则增加了编码器-解码器注意力。在软件工程中的应用表明,Transformer在处理长代码序列时比RNN更高效,且能够捕捉更复杂的跨模块依赖。CodeT5等模型在此基础上采用编码器-解码器统一框架,通过预训练目标如掩码语言建模(MLM)、标识符预测和代码-文本对比学习,获得了强大的代码理解和生成能力。这种架构支持从自然语言描述到完整函数体的端到端生成,以及跨语言的代码翻译任务。

2.3 程序表示学习理论

将源代码转换为适合神经网络处理的表示是深度学习应用于软件工程的首要问题。最基本的表示是标记序列(Token Sequence),通过词嵌入将每个标记映射为低维向量。然而,这种表示丢失了代码的结构信息。抽象语法树(AST)作为编译器中间表示,以层次化树结构精确描述语法结构。将AST线性化通过特定遍历策略(如结构基础遍历SBT)可以保留部分结构信息,而更先进的方法直接使用树结构作为输入,通过Tree-LSTM或图神经网络处理。

控制流图(CFG)表示程序执行路径,节点是基本块,边是跳转关系。数据流图(DFG)追踪变量定义-使用链。程序依赖图(PDG)结合控制依赖和数据依赖,能够精确表示语句间的依赖关系。这些图结构通过邻接矩阵或边列表输入图神经网络,使模型能够学习语义等价的代码变换。对于跨语言任务,统一抽象语法树(UAST)试图在不同语言间建立共享表示空间,通过学习语言无关的节点嵌入实现跨语言克隆检测和搜索。

字节码表示为低层次分析提供了可能,通过将字节码控制流图序列化并编码操作码序列,可以在无源码情况下进行漏洞检测和摘要生成。控制流图的线性化表示 G=(V,E) ,其中 V 是基本块集合,E⊆V×V 是控制转移边,每个基本块 b∈V 包含一系列指令。图神经网络通过消息传递机制学习每个节点的表示 $$h_v^{(l+1)} = \text{AGGREGATE}^{(l)}(\{h_u^{(l)}: u \in \mathcal{N}(v)\}),$$其中AGGREGATE函数可以是均值、最大池化或注意力加权求和。

2.4 预训练与微调范式

预训练语言模型在软件工程中的成功应用遵循"预训练+微调"范式。预训练阶段在大规模无标注代码语料上进行自监督学习,目标包括掩码语言建模(随机遮蔽部分标记并预测)、下一句预测(判断两个代码片段是否连续)、标识符预测等。CodeBERT采用双流架构,同时处理代码和自然语言,通过RoBERTa目标训练。GraphCodeBERT进一步融入数据流信息,边预测任务要求模型判断两个变量是否存在数据依赖,节点对齐任务对齐代码标记与数据流节点。

微调阶段在特定下游任务上使用标注数据调整模型参数。Adapter-based微调只训练少量新增参数而冻结主干网络,有效避免灾难性遗忘。Prompt-based微调将任务转换为填空形式,利用预训练模型的语言建模能力。例如,在缺陷检测任务中,将代码片段和疑问"这段代码是否存在安全漏洞?"拼接,让模型生成"是"或"否"的答案。这种范式减少了对大规模标注数据的依赖,提升了小样本场景下的性能。

3 需求工程中的深度学习技术体系

3.1 需求获取与分类的建模方法

需求获取是从用户反馈、论坛讨论、问题报告等非结构化数据源中自动提取需求信息的过程。深度学习方法在此领域的应用主要聚焦于意图识别和实体抽取。卷积神经网络通过捕捉句子中关键短语的局部特征,能够有效区分功能需求、性能需求、安全需求等不同类别。具体而言,对于输入的句子序列 ,首先通过嵌入层获得词向量

,然后应用多个不同宽度的卷积核进行特征提取,每个卷积核生成特征图

,最终通过最大池化获得句子级表示,输入全连接层进行分类。

双向LSTM在处理长距离依赖和上下文信息方面表现突出,特别是在分析用户故事和用例描述时,能够同时考虑前后文语境。基于注意力机制的需求分类模型进一步提升了性能,通过计算每个词对分类结果的贡献权重

$$\alpha_i = \frac{\exp(\text{score}(e_i))}{\sum_{j=1}^n \exp(\text{score}(e_j))},$$

使模型聚焦于需求描述中的关键术语。预训练语言模型如BERT的引入带来了革命性变化,通过在大规模需求文档上进行领域自适应预训练,模型能够理解需求领域的特定术语和表达方式,在少样本场景下仍能保持高准确率。

需求实体抽取旨在识别需求描述中的核心要素,如主体、动作、约束条件等。LSTM-CRF架构结合LSTM的序列建模能力和条件随机场的序列标注能力,能够有效捕捉BIO(Begin-Inside-Outside)标注约束。CRF层通过计算标签转移分数 T 和发射分数 P ,使用维特比算法解码最优标签序列,损失函数包含序列似然和标签转移约束两部分。迁移学习在此任务中发挥重要作用,利用通用领域预训练模型(如通用英语BERT),再在标注的需求数据集上微调,显著降低了对标注数据的需求。

3.2 需求追踪性链接构建

需求追踪性旨在建立需求与其他软件制品(设计文档、源代码、测试用例)之间的关联,是确保需求覆盖和变更影响分析的关键活动。深度学习方法将追踪性链接构建视为文本匹配或代码搜索问题。早期工作使用循环神经网络编码需求和设计文档的句子,通过曼哈顿距离或余弦相似度衡量语义相关性。然而,这种方法难以捕捉长文档的复杂结构。

基于BERT的追踪性模型通过精细化的预训练策略显著提升性能。TraceBERT采用三阶段训练流程:首先在源代码上预训练获得基础代码理解能力;然后在通用追踪性数据集上进行中间训练,学习"查询-提交"之间的匹配模式;最后在目标项目数据上微调。这种渐进式学习策略使模型能够有效迁移知识。在架构选择上,单体BERT架构在准确率上最优,而Siamese架构在训练效率上更具优势,通过共享参数的双塔结构分别编码需求和代码,然后计算相似度,适用于大规模检索场景。

多语言追踪性构建面临更大挑战,当需求文档和代码注释使用不同语言时,传统方法性能急剧下降。跨语言BERT模型(如 multilingual BERT)通过共享词汇表和注意力机制,在多种语言上联合训练,能够建立跨语言语义空间。研究表明,在英中双语项目中,TraceBERT在大规模项目上表现最佳,而基于图向量空间模型(GVSM)的IR方法在小项目上更有效,这表明深度学习方法的数据需求与项目规模密切相关。

3.3 缺陷需求检测与质量评估

缺陷需求检测关注识别需求文档中可能影响项目成功的潜在问题,如模糊性、不一致性、不完整性和隐私泄露风险。深度学习方法通过大规模学习正常需求的模式,自动发现偏离这些模式的异常需求。卷积神经网络在此任务中表现出色,通过检测局部文本模式识别隐私披露语句。具体而言,模型从短文本中提取特征,结合隐私词典构建用户故事隐私分类器,F1分数可达0.51,仅需15分钟人工标注工作,显著优于传统9小时的手动提取。

条件生成对抗网络(cGAN)被用于自动生成安全需求规格。生成器学习从关键词到完整需求语句的映射,判别器判断生成文本的真实性和安全性,通过对抗训练提升生成质量。这种方法能够根据领域本体注入关键词相关领域知识,确保生成需求的专业性和准确性。在解码阶段,采用需求语法约束解码技术,最小化候选文本与参考文本之间的语义和句法距离,生成符合规范的需求描述。

指代歧义是需求工程中的经典问题,深度学习模型通过上下文理解有效识别和解析指代关系。基于BERT的上下文模型编码需求文本,Word2Vec构建实体网络,融合两种表示后通过多层感知机判断两个实体是否共指。这种方法在语义消歧上显著优于传统基于规则的方法,因为预训练模型已经在大规模语料中学习到丰富的语言现象,包括各种指代模式。

4 代码生成的深度模型体系

4.1 结构感知生成模型

代码生成任务旨在根据自然语言描述自动生成可执行代码,是提升开发者生产力的关键技术。与纯文本生成不同,代码具有严格的语法结构和语义约束,因此结构感知生成模型成为研究热点。抽象语法网络(ASN)将代码生成视为AST的结构化预测问题,使用编码器-解码器BiLSTM配合层次注意力机制,在解码时不仅预测下一个标记,还预测AST的节点类型和结构。这种方法确保生成的代码语法正确且可执行,在Python代码生成任务上显著优于序列到序列基线。

序列到树(Seq2Tree)模型将生成过程解耦为两个步骤:首先生成AST的前序遍历序列,然后通过确定性解析恢复树结构。然而,标准前序遍历对于多分支节点并非最优。为此,研究者提出基于上下文的分支选择器,动态确定多分支节点的最佳扩展顺序。这种自适应遍历策略通过强化学习训练,奖励函数考虑生成代码的编译成功率和测试通过率,使模型能够学习到更符合语言特性的AST展开顺序。

结构感知的另一个重要方向是将AST信息显式注入序列生成过程。Hybrid-DRL方法结合处理代码序列的LSTM和处理AST的LSTM,通过注意力机制融合两种表示,然后使用演员-评论家强化学习框架优化生成策略。评论家网络评估部分生成代码的质量,指导演员网络调整生成概率,特别适用于需要长距离依赖的复杂代码生成任务。

4.2 多模态与特殊领域生成

多模态代码生成整合多种信息源以提升生成质量。CodeT5统一处理代码和自然语言,在编码器端融合标识符类型信息,解码器端通过指针机制复制稀有标记。其预训练目标包括标识符预测、掩码跨度预测和文本-代码匹配,使模型深刻理解代码语义。在生成过程中,关键采样策略允许模型根据示例单元测试的反馈自动重生成程序,直到通过测试或达到最大迭代次数,这种测试驱动生成范式极大提升了代码正确性。

特殊编程语言生成需要针对性建模。SQL生成面临表结构理解和语义匹配挑战,传统方法常产生包含不存在列名或不符合语法的查询。神经SQL生成器将问题词与表内容对齐,结合表结构模式和SQL语法约束进行解码。对于汇编代码生成,由于汇编与机器指令的一对一映射特性,模型需要学习指令序列的优化模式。基于 Transformer的架构在此任务上表现优异,能够捕捉指令间的长距离依赖和寄存器使用模式。

伪代码到实际代码的转换是另一个特殊场景,要求模型理解抽象算法描述并生成具体实现。SPoC方法采用检索增强的生成策略,先从大规模代码库中检索相似伪代码-代码对,然后基于检索结果进行生成。这种两阶段方法既保证了生成代码的可行性,又提升了与目标伪代码的语义一致性。对于测试代码生成,模型需要理解被测代码的接口和预期行为,通过分析现有测试模式生成新的测试用例。

4.3 代码补全的深层机制

代码补全是集成开发环境中最常用的功能之一,其实现机制经历了从基于频率统计到深度学习的演进。现代代码补全系统利用语言模型预测下一个标记的概率分布 。GPT-2架构在此任务上广泛应用,通过自回归方式逐标记生成,但在处理长度超过上下文窗口的序列时会丢失早期信息。为此,研究人员提出分层注意力机制,在不同抽象层次上建立注意力连接,使模型能够回溯到函数签名、类定义等关键上下文。

多任务学习框架同时预测多个相关属性以提升补全质量。例如,联合建模标记序列和AST结构,通过共享表示学习捕捉语法和语义一致性。具体架构包含两个解码器:一个生成标记序列,另一个预测AST节点类型,损失函数为两者的加权和。在训练时,两个任务相互正则化,使模型学习到的表示更加鲁棒。实验表明,这种联合训练在Java和Python上都显著优于单任务基线。

检索增强语言模型为领域自适应提供了有效途径。当通用代码补全模型应用到特定项目时,性能往往下降。通过在解码阶段动态检索相似代码片段并融入生成过程,模型能够利用项目特定知识提升准确率。检索过程基于密集向量相似度,使用预训练的代码编码器将当前上下文和代码库中的片段编码为向量,检索Top-K相似片段后通过注意力机制融合其信息。这种方法无需重新训练模型,仅通过插件形式即可显著提升补全质量,特别适用于大型私有代码库。

5 代码搜索的语义匹配理论

5.1 自然语言查询的深度解析

代码搜索的核心挑战在于桥接自然语言查询与编程语言实现之间的语义鸿沟。早期信息检索方法基于TF-IDF和向量空间模型,将查询和代码视为词袋,通过词汇重叠度衡量相似性。这种方法无法处理同义词、多义词和高层抽象概念。深度学习方法通过将查询和代码映射到共享的语义空间,实现基于含义而非字面匹配的检索。

DeepCS开创性地使用RNN编码方法名、API调用序列和代码标记,将这三种异质信息统一映射到高维向量空间。编码过程独立处理每个代码组件,最终通过加权求和得到代码整体表示。查询编码器同样使用LSTM,检索时计算查询向量与代码向量的余弦相似度。这种方法的局限在于代码表示固定,无法根据查询动态调整。后续工作引入注意力机制,在匹配阶段动态计算查询词与代码元素的对齐分数,显著提升了细粒度匹配能力。

多模态注意力网络(MMAN)进一步整合了代码的三种结构表示:序列标记、AST和控制流图。每种模态使用专门的编码器(LSTM、Tree-LSTM、GGNN)学习表示,然后通过模态融合层动态加权。融合权重由可学习的查询向量决定,使模型能够根据查询类型(如功能描述、API使用、性能优化)自动选择最相关的代码表示。例如,当查询涉及循环优化时,CFG表示会获得更高权重;当查询关注类结构时,AST表示更为重要。这种动态融合机制在SemanticCloneBench上取得了显著提升。

5.2 查询扩展与优化策略

查询扩展通过丰富原始查询词来提升召回率。传统方法使用WordNet等同义词词典,但软件领域术语往往具有特定含义。CodeHow识别查询中潜在的API调用,通过命名实体识别提取API名称,然后扩展查询包含这些API的文档描述。扩展后的查询使用布尔模型检索,同时考虑文本相似度和API匹配度。词嵌入技术也被用于扩展,通过计算查询词与代码标识符在向量空间中的相似度,自动发现相关术语。

基于搜索日志的查询重构利用历史查询-点击数据学习用户意图。Cao等人分析Stack Overflow的大规模搜索日志,发现查询重构模式(如添加语言标签、具体化API名称)。他们构建包含原始查询和重构版本的语料库,训练序列到序列模型生成候选重构查询。当用户输入新查询时,模型生成多个重构选项,按置信度排序推荐。这种方法的优势在于直接从真实用户行为中学习,生成的扩展更符合实际搜索习惯。

生成式扩展是更激进的方法,使用代码生成模型根据查询生成伪代码片段,然后将生成结果作为扩展。其动机是人类开发者在搜索前往往会在脑中构思解决方案草图。通过将生成代码与查询结合,检索系统能够更精确地匹配实现模式。这种方法的挑战在于生成质量不稳定,可能引入噪声。因此采用置信度加权,仅当生成代码通过语法检查时才用于扩展。

5.3 跨语言与二进制检索

跨语言代码搜索旨在找到不同语言中实现相同功能的代码,这在多语言系统和语言迁移场景中至关重要。主要挑战是语法和语义差异巨大,传统基于文本相似度的方法完全失效。COSAL采用非支配排序策略,基于AST结构和输入输出行为相似度进行排序。对于每个候选代码对,提取两组特征:AST路径相似度和执行轨迹相似度,使用Pareto前沿选择最优匹配。

神经方法通过学习语言无关的表示来解决跨语言问题。Bi-NN框架使用两个独立的神经网络分别学习源语言和目标语言的语义特征,通过共享的度量空间对齐两种表示。训练时使用对比损失,最大化相同功能代码对的相似度,最小化不同功能代码对的相似度。UAST方法构建跨语言的统一抽象语法树,将不同语言的特定语法结构映射到通用节点类型,然后在统一树上训练GNN,实现真正语言无关的表示。

二进制代码搜索面向无源码场景,如闭源软件分析、固件审计等。Gemini方法将二进制函数的控制流图转换为属性控制流图(ACFG),每个节点包含统计特征(如指令数量、字符串常量),然后使用Structure2vec图嵌入网络学习图表示。Clone-Slicer针对指针相关代码克隆,结合程序切片提取与指针操作相关的代码片段,减少图规模的同时保留语义关键信息。二进制代码可视化技术将二进制文件转换为图像,利用CNN的图像识别能力检测相似模式,这种方法快速但精度有限,适用于大规模初步筛选。

6 代码摘要生成的表示学习

6.1 序列到序列基础框架

代码摘要生成旨在为代码片段生成简洁的自然语言描述,帮助开发者快速理解功能。早期神经方法采用编码器-解码器框架,编码器将代码序列压缩为固定维度向量,解码器基于此生成摘要。CODE-NN首次将LSTM与注意力机制结合用于C#和SQL代码摘要,注意力权重揭示生成每个摘要词时关注的代码位置。然而,固定向量瓶颈限制了长代码片段的摘要质量。

Transformer架构的引入彻底改变了这一领域。编码器通过自注意力机制捕捉代码标记间的全局依赖,解码器通过编码器-解码器注意力动态关注相关代码部分。Fret模型结合Transformer和BERT,利用预训练模型的丰富语义表示,缓解长距离依赖问题。Copy机制被证明对处理标识符和API名称至关重要,通过指针网络直接从输入复制稀有标记,解决了词汇表外(OOV)问题。

检索增强摘要生成结合生成与检索的优点。Rencos首先训练标准的编码器-解码器模型,然后对输入代码检索语法和语义最相似的两个代码片段。在解码阶段,模型同时关注输入代码和检索到的参考代码,通过注意力机制融合多源信息。这种方法的优势是当检索到高度相关的代码时,可以直接借鉴其摘要模式;当检索不准确时,仍依赖生成能力。实验表明,检索增强在函数级摘要上提升显著,特别是在处理常见设计模式时。

6.2 树结构表示与层次编码

抽象语法树(AST)提供了代码的层次化语法结构,直接利用树结构能更好保留语法完整性。DeepCom采用结构基础遍历(SBT)将AST转换为序列,在节点前后添加括号标记结构边界,使模型能够还原树形结构。其编码器是双向LSTM,解码器是单向LSTM带注意力。SBT遍历解决了传统前序遍历无法有效恢复AST的问题,但生成的序列长度是原始AST的两倍以上,增加了计算开销。

Tree-LSTM扩展了标准LSTM以处理多子节点,节点隐藏状态通过子节点状态聚合得到

$$h_j = \sum_{k \in C(j)} h_k,$$

其中 C(j) 是节点 j 的子节点集合。这种方法在AST上自然应用,每个AST节点对应一个Tree-LSTM单元,子树语义自底向上传播。代码-RNN基于Tree-LSTM,使用代码-GRU进行解码,在生成注释时动态关注AST的不同子树。然而,Tree-LSTM的并行化困难,训练速度较慢。

AST-Trans将Transformer的自注意力机制应用于树结构,提出两种节点关系:祖先-后代关系和兄弟关系。对于每个节点,注意力权重计算限定在相关节点子集,大幅降低了计算复杂度。具体来说,对于节点 v ,其注意力只考虑祖先节点、后代节点和兄弟节点,而非全树节点。这种稀疏注意力模式在保留关键结构关系的同时,将时间复杂度从 O(n2) 降低到 O(nlogn) ,使Transformer能够处理大规模AST。

6.3 图神经网络增强摘要

图结构能够表示代码中复杂的依赖关系,如控制流、数据流和调用关系。将代码建模为图 G=(V,E) ,其中节点 V 代表语句或标记,边 E 代表依赖关系,图神经网络通过消息传递学习节点表示。CODESCRIBE引入三元位置编码,同时考虑节点在AST中的位置、在代码序列中的位置和数据流位置,通过三个位置向量拼接注入结构信息。然后使用图神经网络编码AST,Transformer编码代码标记序列,两个编码器的输出通过注意力融合层结合用于解码。

MMF3模型使用图卷积网络编码AST图嵌入,同时融合源代码特征序列。其关键创新是细粒度特征匹配模块,通过比较代码序列中每个标记的位置与AST叶节点的位置顺序,建立标记与AST节点的对应关系。这种显式对齐使模型能够精确关联自然语言描述与代码结构,在DeepCom数据集上比纯序列方法提升了约8个BLEU点。

对于代码变更摘要,CoDiSum提取变更的AST结构和语义信息,联合建模两种信息源。它将变更前后的代码分别解析为AST,计算节点级别的编辑脚本,然后将编辑脚本编码为图结构,图中节点是变更操作(插入、删除、更新),边是操作间的依赖关系。图神经网络学习操作的表示后,解码器生成描述变更意图的自然语言。这种方法在commitMessage数据集上显著优于仅基于文本差异的方法,因为它理解了代码的结构变更语义。

7 软件重构的智能检测与推荐

7.1 代码异味检测的深度架构

代码异味检测是自动化重构的第一步,旨在识别需要改进的代码结构。传统方法依赖手工定义的阈值和启发式规则,如方法行数超过100行视为"长方法"、类依赖过多外部类视为"特性依恋"。然而,这些规则难以捕捉复杂上下文,且阈值设置主观。深度学习方法通过学习大规模代码库中的重构模式,自动发现更准确的异味指示模式。

CNN在代码异味检测中广泛应用,因其能有效捕捉局部代码模式。对于特性依恋检测,模型输入包括代码度量矩阵和标识符嵌入。度量矩阵包含 n 个版本的 m 种度量(如耦合度、内聚度、复杂度),CNN在时间维度上滑动捕捉度量演化模式。标识符部分使用方法名、类名、被调用API名的嵌入序列作为输入,通过另一个CNN提取调用模式特征。两个CNN的输出拼接后输入全连接层,最终预测该方法是否应移动到另一个类。这种双路架构在自动生成的大规模训练数据上表现优异,准确率和召回率均超过85%。

图神经网络为代码异味检测提供了更自然的表示。将代码表示为图,方法作为节点,调用关系作为边,GNN学习节点表示后分类。对于"上帝类"检测,图中节点是类的方法,边是方法间的调用,节点特征包括方法复杂度、访问修饰符等。通过图卷积操作,每个节点聚合邻居信息,最终通过读出操作得到整个图的表示,用于判断是否为上帝类。这种方法捕捉了类内部的方法交互模式,比基于聚合度量的方法更精确。

7.2 重构机会的直接推荐

超越异味检测,深度学习方法可以直接推荐重构操作,甚至生成具体补丁。推荐重命名机会的方法通过分析代码演化历史,学习开发者重命名的模式。对于给定方法,首先使用BERT和TextCNN分别编码方法名和方法体,获得语义向量和

。然后训练多层感知机分类器预测该方法是否应该重命名。为了生成新名称,从相似方法中检索候选名称,使用束搜索生成最符合项目命名规范的新名称。

提取方法重构的自动化是长期挑战。ValExtractor通过轻量级静态分析验证提取表达式的副作用,识别可一起提取的表达式出现位置,避免引入语义变化。深度学习方法则通过学习提交历史中的提取模式来推荐重构。当开发者复制粘贴代码片段时,系统判断该片段是否应提取为新方法。输入是代码片段的AST子图,通过图神经网络编码后分类。训练数据从大规模代码提交历史自动挖掘,每个正例是实际执行的提取操作,负例是满足语法条件但未提取的代码片段。

对于微服务架构,深度学习方法推荐将单体应用中的类提取为独立微服务。将类表示为图中的节点,类间的调用关系作为边,节点的特征包括类的方法数、公开接口数、数据库访问次数等。使用图神经网络对节点聚类,目标是最大化类内聚合度、最小化类间耦合。最终,离群节点被推荐为候选微服务。这种方法的优势在于考虑了系统的运行时特征,而非仅静态结构。

7.3 大规模训练数据构建难题

深度学习方法在重构任务上面临的主要障碍是缺乏大规模高质量训练数据。手动构造重构数据集耗时且易错,而自动挖掘工具(如RefactoringMiner)存在大量误报。Liu等人提出一种创新的数据生成方法:针对特性依恋重构,随机将方法移动到满足前提条件的其他类中,将移动后的方法作为正例(应移回原类),未移动的方法作为负例。通过控制移动比例,可以精确调节正负样本比例,生成数十万个训练样本。

然而,这种人造数据的质量存疑。自动生成的异味可能显著不同于开发者无意引入的异味,导致模型只能识别"人造异味"。为此,Liu等人进一步提出改进的挖掘方法,通过启发式和机器学习分类器过滤误报,提升挖掘精度。他们使用决策树而非深度网络,因为深度网络需要更大规模数据。过滤后的真实重构数据用于微调深度模型,显著提升了在真实项目上的检测效果。ReExtractor实体匹配算法通过完全利用限定名、实现和引用信息,提高了版本间实体匹配的准确率,从而减少重构检测的假阳性和假阴性。

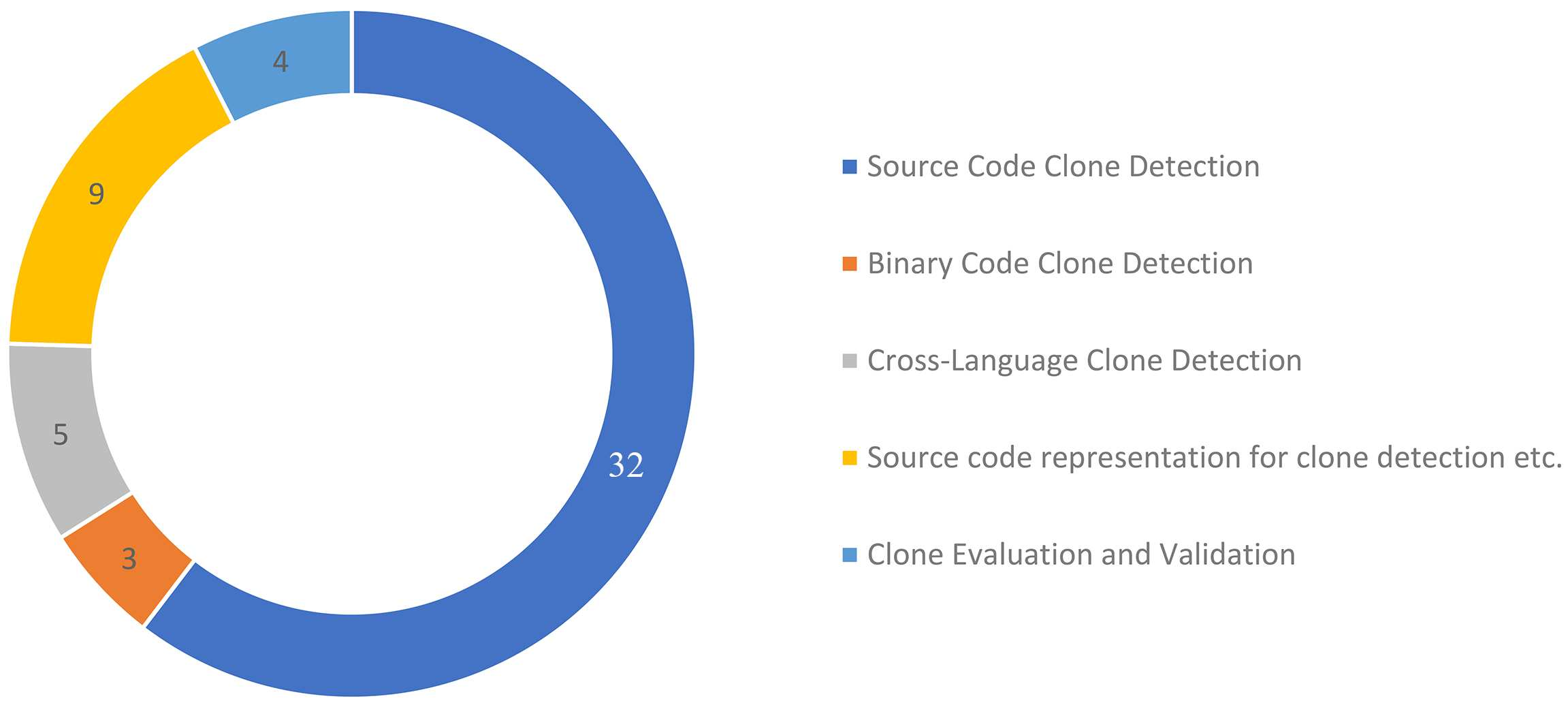

8 代码克隆检测的语义理解

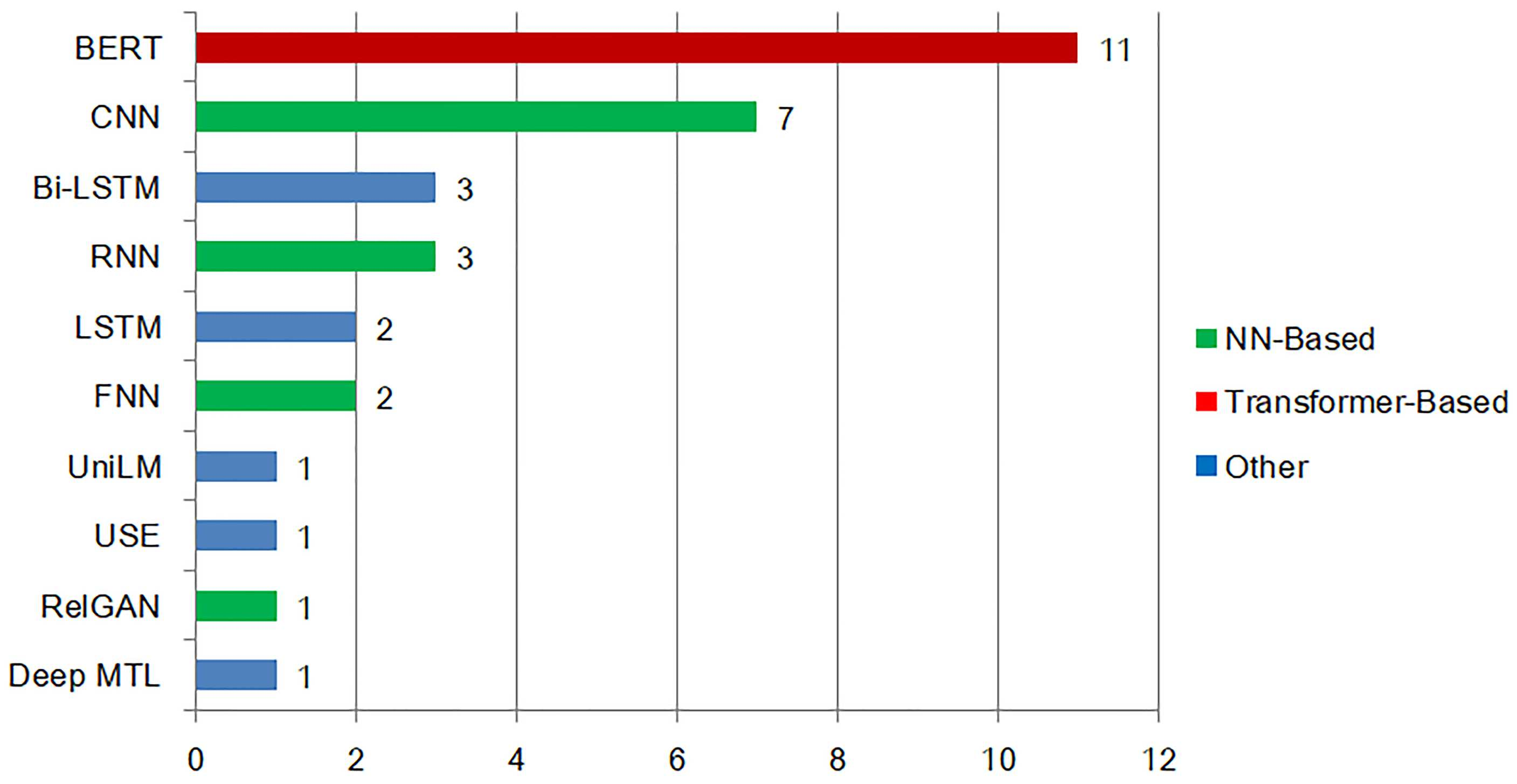

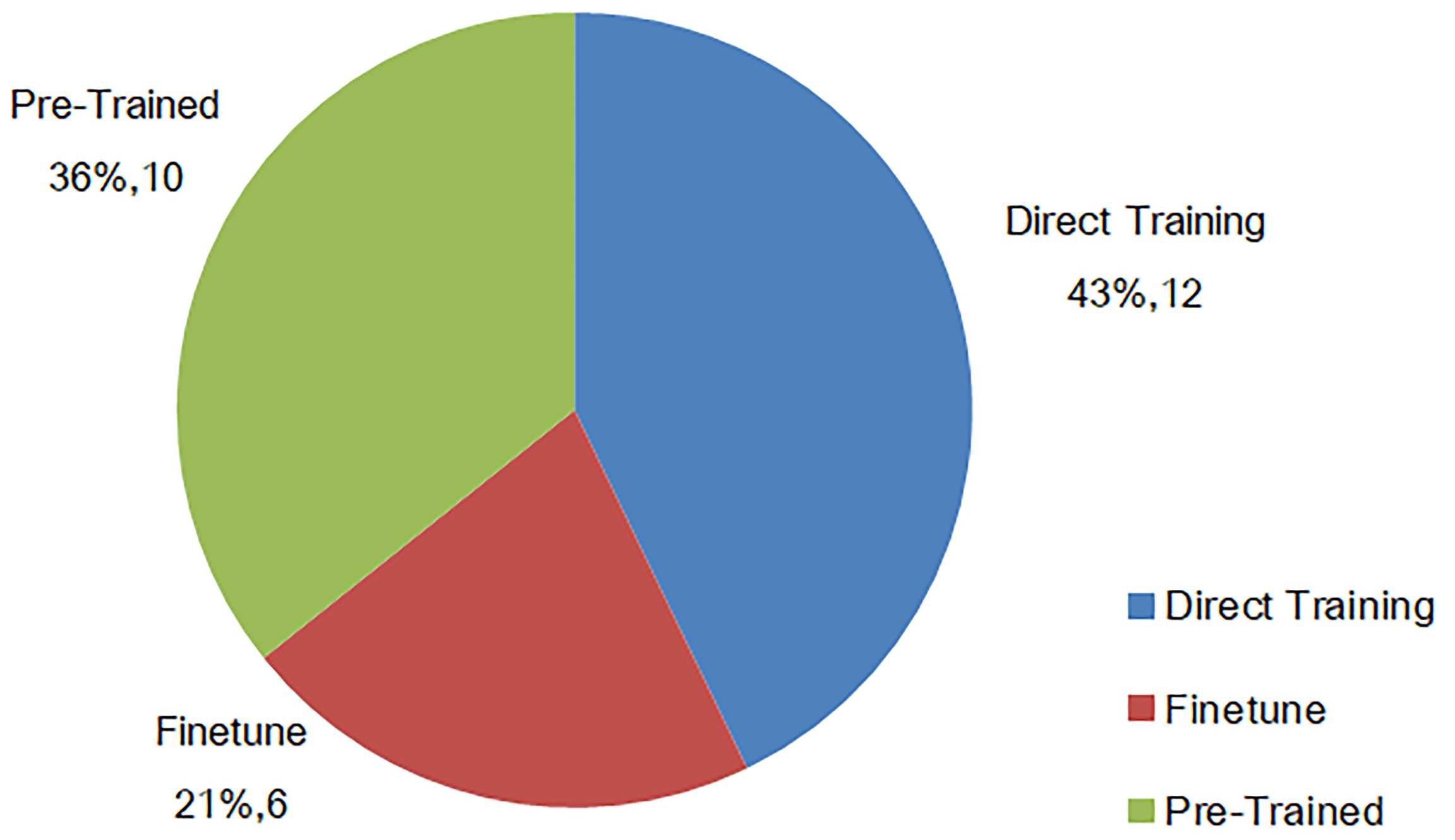

8.1 语义克隆的检测模型

代码克隆分为四种类型:Type-1(仅空白和注释不同)、Type-2(标识符和字面量不同)、Type-3(语句增减修改)、Type-4(语法不同但语义等价)。深度学习方法主要解决更具挑战性的Type-3和Type-4克隆。ASTNN将AST划分为多个语句级子树,每个子树通过递归神经网络编码,然后使用双向RNN编码语句序列,捕获语句间依赖。这种方法的优势在于既保留了局部语法结构,又建模了全局上下文。

TBCNN使用树卷积操作直接在AST上提取特征。设计固定深度的卷积核在树上滑动,每个核覆盖一个子树模式,生成特征图。通过最大池化获得对整个AST最具判别性的特征。这种方法类似于图像识别中的CNN,但卷积操作定义在树结构上,能够有效捕捉常见的代码模式。在BigCloneBench上,TBCNN的召回率比传统基于令牌的方法高出15-20个百分点。

图神经网络在捕获语义依赖方面表现卓越。Holmes构建程序依赖图(PDG),节点是语句,边是控制依赖和数据依赖。使用GNN学习节点表示,然后通过Siamese网络比较两个代码片段的图嵌入相似度。PDG的优势在于忽略无关的语法细节,聚焦于影响程序行为的依赖关系,因此特别适合检测经过混淆或代码格式化工具处理过的克隆。然而,PDG构建开销大,限制了其在大规模代码库上的应用。

8.2 表示学习的融合策略

单一表示往往难以全面捕捉代码特征,多表示融合成为趋势。FCCA同时使用令牌、AST和CFG三种表示,每种表示通过独立的RNN编码,然后通过注意力机制融合。注意力权重根据查询动态计算,使模型能够自适应地选择最相关的表示。在检测弱Type-3/Type-4克隆时,融合模型比单表示模型F1分数提升约5-7个百分点。

对比学习在代码表示学习中崭露头角。CrossCS设计跨模态对比学习目标,同时优化代码-代码和代码-查询的相似性。对于每个代码片段,通过数据增强(如标识符重命名、表达式等价替换)生成语义一致的正样本,其他随机代码作为负样本。损失函数包含模态内对比损失和模态间对比损失:

$$

\mathcal{L} = -\log \frac{\exp(\text{sim}(c, c^+)/\tau)}{\sum_{i=0}^K \exp(\text{sim}(c, c_i)/\tau)} - \log \frac{\exp(\text{sim}(c, q)/\tau)}{\sum_{j=0}^M \exp(\text{sim}(c, q_j)/\tau)}

$$

其中 τ 是温度超参数,控制分布平滑度。这种训练方式使表示空间更加结构化,相似语义代码在空间中聚集。

InferCode提出自监督学习方法,通过预测AST子树学习代码表示。对于每个代码片段,随机选择AST中的一个子树作为预测目标,编码器是TBCNN,解码器重建子树的节点序列。由于AST子树天然包含代码的局部语义,这种预测任务迫使模型学习捕获代码的层次化结构信息。在克隆检测、代码分类等下游任务上,InferCode的表示优于直接语言建模训练的表示。

8.3 跨语言与二进制克隆检测

跨语言克隆检测的核心是如何减少不同语言间的特征鸿沟。CLCDSA提取跨语言的语法特征(如控制流模式、API调用序列)和度量特征,使用深度神经网络学习这些特征的共享表示。Bi-NN框架分别学习两种语言的语义表示,通过对比训练对齐表示空间。在解码阶段,使用联合注意力机制同时关注两种语言的表示,判断它们是否语义等价。

UAST方法构建跨语言的统一抽象语法树,定义一组语言无关的节点类型(如循环、条件、函数调用)。通过在不同语言的解析器上添加适配层,将特定语言的AST节点映射到UAST节点,然后在统一树上训练神经模型。这种方法的优势在于一旦构建好UAST映射,就可以在所有支持语言上复用同一模型,极大降低了跨语言任务的开销。

二进制代码克隆检测在跨平台分析和漏洞挖掘中至关重要。Gemini将二进制函数的控制流图转换为数值特征向量,节点特征包括统计信息(指令数、立即数个数)和结构信息(后代节点数),边特征包括跳转类型。使用Structure2vec图嵌入网络学习图表示,然后计算图间相似度。Clone-Slicer针对指针相关代码,先进行后向切片提取与指针操作相关的指令序列,减少图规模的同时保留语义关键信息,再应用图匹配算法检测克隆。

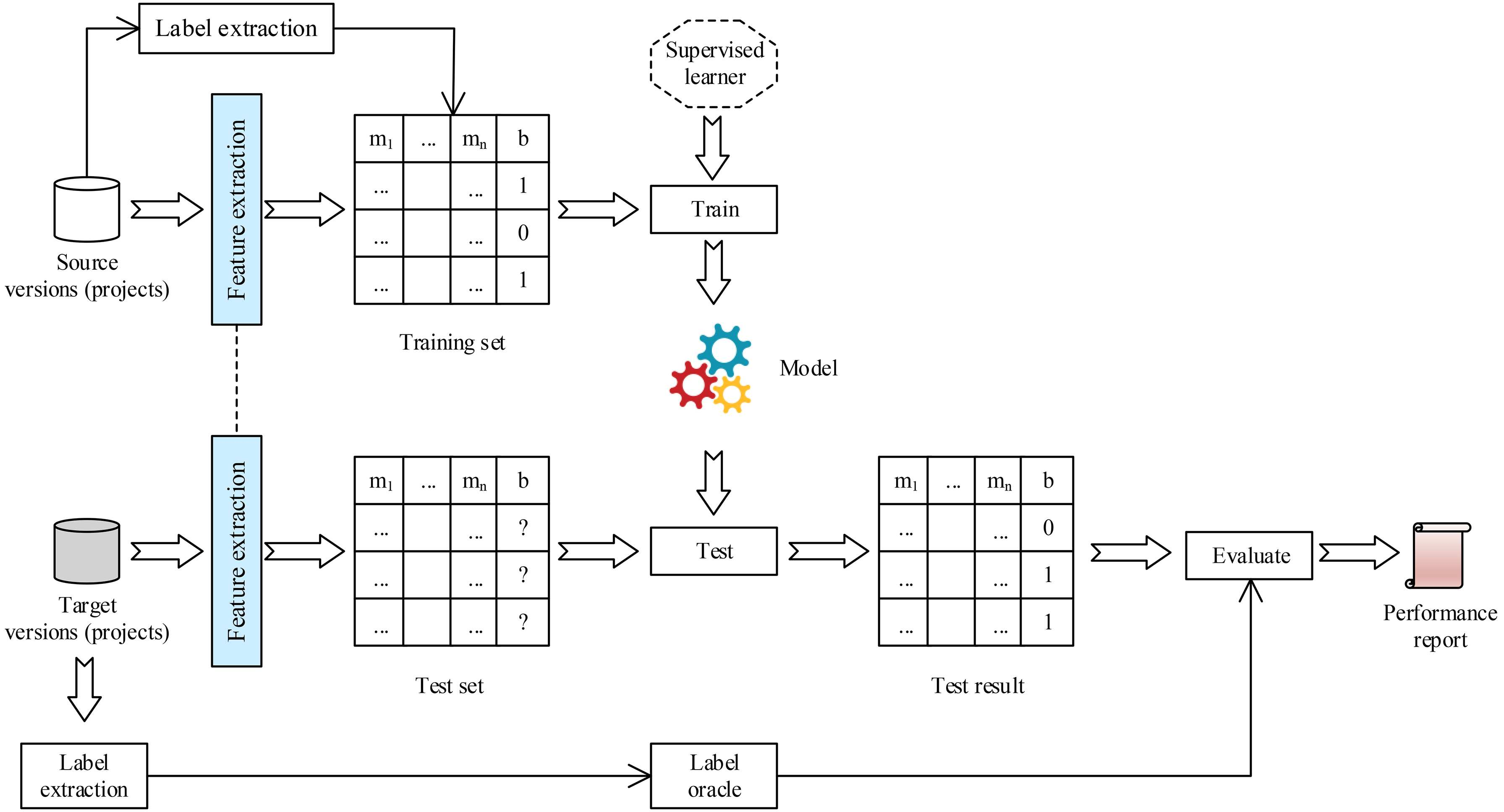

9 软件缺陷预测的表示学习方法

9.1 从手工特征到深度表示

传统软件缺陷预测依赖手工提取的度量特征,如代码行数、圈复杂度、类耦合度等。这些特征主要反映代码的语法属性,忽略语义信息,预测能力有限。深度学习方法通过自动学习高层语义特征,显著提升了预测精度。DBN(深度信念网络)被用于从初始变更特征生成更具表达力的表示,通过无监督预训练逐层学习特征层次结构,然后有监督微调预测缺陷倾向。

CNN在处理代码度量序列时表现出色。对于文件级缺陷预测,将代码文件视为标记序列,使用多层一维卷积提取局部模式,通过最大池化获得全局表示。更深层的模型使用图像化表示,将源代码渲染为二维图像,利用CNN的图像识别能力检测视觉模式。具体而言,将每个标记映射为像素,代码结构(如缩进、括号)自然形成视觉模式,缺陷代码往往呈现异常的视觉结构。在ISSRE数据集上,这种图像化CNN方法比传统度量方法AUC提升约0.1。

RNN及其变体(LSTM、GRU)擅长建模代码演化历史。将连续版本的度量值序列输入RNN,隐藏状态捕捉缺陷引入的动态模式。Bi-LSTM同时从前向和后向处理序列,能够识别导致缺陷的特定版本变更。对于变更级缺陷预测,将提交日志和代码变更一起编码,注意力机制自动识别与缺陷相关的提交信息,如"修复空指针异常"等关键词会获得更高权重。

9.2 跨项目缺陷预测的迁移机制

跨项目缺陷预测旨在利用源项目的知识预测目标项目的缺陷,解决新项目历史数据不足的问题。深度学习方法通过特征表示迁移实现这一目标。首先在大规模源项目上预训练深度模型学习通用缺陷模式,然后在目标项目的小数据集上微调。SSDAE(堆叠稀疏去噪自编码器)学习跨项目共享的特征表示,通过添加稀疏约束防止过拟合,使学到的特征更具通用性。

领域自适应技术进一步缩小源项目和目标项目之间的分布差异。对抗训练被引入缺陷预测,训练一个特征提取器使其生成的表示能够"欺骗"领域分类器,从而学习到领域不变的特征。具体损失函数包含两部分:缺陷预测损失和领域分类损失,通过梯度反转层优化,使特征提取器最大化混淆领域分类器,同时最小化缺陷预测误差。在AEEEM数据集上的实验表明,对抗自适应方法比简单微调准确率提升5-8个百分点。

多源项目联合训练是另一种有效策略。通过注意力机制动态加权不同源项目的贡献,模型自动学习与目标项目最相关的源项目特征。注意力权重基于项目间分布相似度计算,使用最大均值差异(MMD)或Wasserstein距离衡量。在预测时,模型更关注与目标项目风格相似的源项目数据,有效缓解了负迁移问题。此外,基于元学习的方法通过学习如何在少量样本上快速适应,为跨项目预测提供了新思路。

9.3 不同粒度的预测模型

缺陷预测可以在多个粒度进行,包括文件级、函数级、变更级和语句级。不同粒度对模型的要求不同。文件级和函数级预测可以使用完整的代码表示,如AST、CFG。语句级预测则需要更精细的上下文建模,因为单个语句的缺陷倾向高度依赖周围代码。HAN(层次注意力网络)被提出用于语句级预测,首先编码每个语句的标记,然后通过语句级注意力聚合得到函数表示,最后通过函数级注意力得到文件表示。这种层次结构使模型能够识别关键缺陷语句。

变更级预测关注代码提交的缺陷风险,需要同时分析代码变更和提交信息。DeepJIT模型将代码变更diff和提交信息分别编码,diff通过CNN捕捉变更模式,提交信息通过LSTM捕捉开发意图,两者拼接后预测缺陷概率。数据集构造使用JIT(Just-In-Time)方法,收集提交后是否引入缺陷的标签。由于变更数据量巨大,需要高效的采样策略,如基于缺陷密度的分层采样,确保训练集中缺陷样本比例合理。

图神经网络在文件级和函数级预测中展现优势。通过构建类依赖图(CDG)或函数调用图,GCN能够捕捉模块间的结构影响。一个文件的缺陷可能源于其依赖的库文件,GCN的消息传递机制能够传播这种影响。具体而言,每个节点初始化特征为其代码度量,通过多层图卷积,节点特征融合邻居信息,最终每个节点的表示包含其局部代码特征和全局结构上下文。在PROMISE数据集上,GCN-based方法比孤立预测每个文件的方法在F1分数上提升约12%。

10 缺陷查找的神经增强技术

10.1 静态分析的神经扩展

静态分析在不执行程序的情况下检查代码以发现缺陷,传统方法基于形式化规则和抽象解释,虽然精确但构建成本高、扩展性差。深度学习方法通过学习代码模式增强静态分析。Lint工具通过检查违反最佳实践的模式发现缺陷,但其规则固定且误报率高。神经Lint工具使用语言模型学习正常代码分布,将低概率代码模式标记为潜在缺陷。具体而言,预训练语言模型计算代码片段的对数似然 logP(c) ,设定阈值 τ ,当 logP(c)<τ 时视为异常。这种方法能够发现未在规则库中的新模式,如特定API的罕见使用方式。

在符号执行中,深度学习用于优化路径探索和约束求解。符号执行面临路径爆炸问题,学习模型预测路径的可行性,优先探索可能到达缺陷的路径。Learch使用机器学习模型预测程序状态在预算时间内最大化代码覆盖的潜力,通过上下文多臂赌博机算法选择下一个探索状态。Homi通过在线学习持续更新概率剪枝策略,基于累积测试数据识别有前景的状态。学习模型还用于预测路径约束的可满足性,避免对不可满足约束调用耗时的SMT求解器。实验表明,这些学习增强策略将符号执行效率提升30-50%。

API误用检测是静态分析的重要应用。APISan从大量代码中提取使用模式,通过参数语义和因果性分析,基于多数投票建立API使用参考。然而,多数投票可能错误,导致误报。深度学习方法学习更稳健的使用规范。COMMENT从Java注释中自动提取参数约束,验证代码实际抛出的异常是否与注释描述一致。QAssist构建问答系统,在需求分析阶段自动检测不完备性,通过检索相关文本段落并高亮可能答案,辅助利益相关者识别需求问题。

10.2 动态测试的智能策略

动态测试通过执行程序并监控行为发现缺陷,其有效性取决于测试输入的质量和覆盖率。模糊测试(Fuzzing)是主流动态测试技术,通过生成大量随机输入探索程序状态空间。传统模糊测试依赖人工设计的变异规则,难以适应不同程序。深度学习方法学习程序特定的输入模式,实现智能变异。

NEUZZ使用神经网络平滑程序行为,将离散的输入空间映射为连续函数。具体而言,训练一个多层感知机近似输入到分支覆盖的映射 f:X→C ,其中 X 是输入空间,C 是覆盖向量。然后使用梯度下降法优化输入以覆盖未探索的分支。由于梯度信息指导,变异更具方向性,相比随机突变效率大幅提升。然而,神经网络对复杂程序的近似能力有限,对于深度嵌套的条件判断可能失效。

语言模型指导的模糊测试利用预训练代码模型生成语法和语义有效的输入。Fuzz4All使用LLM生成模糊测试种子,通过提示工程让模型产生特定语言的测试程序。TitanFuzz直接利用LLM为深度学习库生成测试代码,结合差分测试比较不同框架的输出来发现缺陷。这种方法的优势是生成的输入更接近真实程序,能够测试复杂API组合。挑战在于LLM可能生成重复或过于简单的输入,需要设计多样性促进机制,如基于n-gram惩罚的采样策略。

对于特定领域测试,如GUI测试,深度学习的感知能力至关重要。Avgust从应用执行视频中自动提取使用场景,通过视频理解模型识别用户操作序列,然后生成对应的测试脚本。QTypist利用预训练语言模型根据GUI上下文生成文本输入,考虑输入字段的类型和约束。WebExplor使用好奇心驱动的强化学习生成Web应用测试动作序列,奖励函数鼓励探索未访问状态和触发新事件,有效提升了状态覆盖深度。

10.3 形式化验证的学习辅助

形式化验证旨在严格证明程序满足规范,是绝对可靠的缺陷查找方法,但面临状态空间爆炸和证明构建困难。深度学习方法为验证过程提供启发式指导,而非替代严格推理。在模型检验中,学习模型指导状态空间探索顺序,优先验证可能违反性质的路径。通过强化学习,智能体学习一个策略 π(s) 选择下一个要探索的状态 s ,奖励是发现的反例深度或证明进度。

定理证明是验证的核心活动,交互式证明助手如Coq、Isabelle需要人工构造证明。深度学习尝试自动化证明步骤生成。针对软件验证的定理证明与数学证明不同,其核心是不变式推断。不变式是描述程序点性质的逻辑公式,是构建归纳证明的关键。学习模型通过分析成功证明的案例,学习生成候选不变式。例如,针对循环程序,LSTM编码循环体和循环条件,解码器生成候选不变式模板,然后使用约束求解器验证。排名模型根据不变式的简洁性和覆盖性对候选排序,辅助证明者选择。

神经网络程序平滑将程序近似为可微函数,使梯度优化成为可能。这种方法将程序路径条件 P(x) 表示为关于输入 x 的连续函数,通过最小化

搜索满足条件的输入。虽然近似可能不精确,但为符号执行提供了良好的初始解,加速求解过程。PreFuzz结合资源高效的边选择机制和概率性字节选择机制,指导模糊测试覆盖难触发路径。其基于学习的选择策略比随机选择提升覆盖率25%以上。

11 故障定位的深层诊断机制

11.1 基于频谱的深度学习模型

故障定位旨在识别导致测试失败的代码位置。基于频谱的故障定位(SBFL)通过分析测试执行覆盖信息构建诊断模型。传统SBFL公式(如Ochiai、Tarantula)基于简单统计,忽略覆盖矩阵中的复杂模式。深度学习模型通过训练神经网络学习覆盖与测试结果的非线性关系。

深度信念网络(DBN)是最早应用于SBFL的深度模型之一。输入是每条语句的覆盖向量

$$\mathbf{c} = [c_1, c_2, ..., c_m]$$

其中 cj 表示语句 i 在第 j 个测试中的执行次数(0或1)。DBN通过无监督逐层预训练学习语句覆盖的层次化表示,然后使用标注的缺陷数据微调顶层分类层。实验表明,DBN能够发现高阶覆盖模式,如多条语句的组合覆盖与失败的关联,优于传统单语句统计方法。

卷积神经网络在SBFL中的应用源于覆盖矩阵的图像特性。将覆盖矩阵视为二维图像,行是语句,列是测试,元素值是覆盖标志。CNN捕捉覆盖矩阵中的局部模式,如某些语句组合在不同测试中的覆盖模式。覆盖矩阵的行对应语句,列对应测试。每个元素表示该语句在该测试中的覆盖情况(1表示覆盖,0表示未覆盖)。CNN的卷积核在矩阵上滑动,学习局部覆盖模式,如某几条语句总是同时被覆盖或同时不被覆盖。最大池化提取最显著的覆盖模式,全连接层将模式映射到可疑度分数。CNN-FL模型在Defects4J数据集上Top-1准确率比最佳传统方法提升12%。

11.2 数据增强与不平衡处理

故障定位数据面临严重类别不平衡,失败测试远少于通过测试,导致模型偏向多数类。数据增强技术通过生成合成失败测试来缓解这一问题。CLAFA使用词嵌入扩展代码标识符生成新测试,覆盖相似但不同的代码路径。SMOTE(合成少数类过采样技术)在特征空间中插值生成新样本。对于每个失败测试样本 x ,找到其K个最近邻失败样本,合成新样本

$$\mathbf{x}_{new} = \mathbf{x} + \delta \cdot (\mathbf{x}_i - \mathbf{x})$$

其中 δ∈[0,1] 是随机插值系数。

生成对抗网络(GAN)被用于生成更逼真的失败测试。生成器输入随机噪声和程序依赖图,输出合成覆盖向量,判别器区分真实和合成测试。通过对抗训练,生成器学会产生能够欺骗判别器的逼真失败测试。CGAN4FL进一步引入上下文感知,生成器不仅考虑覆盖模式,还学习失败上下文的程序依赖关系,生成的测试在统计特性上与真实测试难以区分。在Gzip项目的实验中,增强后模型MFR(平均首次排序)提升约30%。

主成分分析(PCA)和线性判别分析(LDA)也被用于数据增强。Aeneas使用修订的PCA将高维覆盖矩阵降维到紧凑特征空间,条件变分自编码器(CVAE)在降维空间生成失败测试样本。降维不仅提升效率,还去除噪声,使生成样本更纯净。Lamont使用修订的LDA最大化类间可分性,然后应用SMOTE生成平衡数据集。这些线性方法计算高效,适合大规模项目。

11.3 故障上下文建模

故障上下文指导致失败的相关语句集合及其依赖关系,建模上下文能显著提升定位精度。CAN(上下文感知网络)构建程序依赖图(PDG)表示失败上下文,节点是语句,边是数据依赖和控制依赖。GNN在PDG上传播失败信息,每个节点的表示聚合其前驱和后继节点的状态,最终可疑度分数包含上下文影响。对于多缺陷程序,CAN能够区分不同缺陷引起的失败,通过聚类失败执行轨迹分离缺陷。

FixLocator使用双任务学习同时定位方法和语句级别缺陷。方法级模型首先识别需要修改的方法,语句级模型在可疑方法内精确定位缺陷行。两个模型共享底层表示,通过多任务正则化提升泛化能力。层次定位符合开发者调试习惯,先定位到文件/方法,再细粒度检查。对于跨方法缺陷,模型能够识别需要协同修改的多个位置。

CBCFL基于上下文聚类识别偶然正确测试(CC测试),即虽然通过但执行了缺陷代码的测试。通过构建失败上下文的程序依赖图,提取影响失败输出的语句集合作为聚类特征,将CC测试重新标记为失败,再输入故障定位模型。这种数据清洗提升模型训练质量,在包含大量CC测试的项目上效果显著。实验表明,修正标签后Top-5准确率提升约18%。

12 程序修复的神经翻译范式

12.1 编译错误修复的序列建模

编译错误修复类似于机器翻译,将错误代码"翻译"为正确代码。深度学习方法将错误代码片段作为源语言,正确代码作为目标语言,训练序列到序列模型。DeepFix针对C语言学生程序中的常见语法错误,使用LSTM编码器-解码器架构,输入错误程序,输出修复后的程序。训练数据来自编程练习平台的数百万错误-正确程序对。模型完全修复27%的错误程序,部分修复19%,显著提升学生编程效率。

更先进的模型整合编译器反馈。TransRepair在Transformer架构中引入编译器反馈注意力,不仅关注错误代码上下文,还关注编译器错误信息。编码器分别编码代码和错误信息,解码器通过交叉注意力融合两者。对于类型错误,模型能够根据错误信息"expected type X but found Y"定位问题并生成正确类型转换。SynShine结合Roberta编码器和三阶段修复流程:错误定位、修复生成和修复选择,在黑盒数据集上达到75%的单行错误修复率。

图结构在此任务中也发挥作用。GGF方法将AST作为图输入,节点是语法单元,边是语法关系。使用图神经网络学习节点表示,解码器在图上进行信息传递,预测需要修改的节点和新的标记。这种方法的优势在于能够捕捉语法约束,生成的修复更可能通过编译。然而,图神经网络训练效率较低,对于大规模程序适用性受限。

12.2 运行时错误的上下文修复

运行时错误修复比语法错误更复杂,需要理解程序语义。基于搜索的修复方法通过变异候选补丁并验证测试来寻找正确修复,但搜索空间巨大。深度学习方法通过学习历史修复模式,直接生成高概率正确补丁。

Prophet是混合修复系统的典型代表,整合概率模型和搜索。首先使用Seq2Seq模型学习从错误代码到修复代码的翻译概率 P(p∣b) ,其中 p 是补丁,b 是错误代码。在搜索过程中,模型评分作为启发式函数,指导补丁优先级排序。这种神经引导搜索显著减少验证次数,在ManyBugs数据集上找到正确补丁的效率提升40%。

端到端生成方法跳过搜索,直接从错误代码生成修复。CoCoNuT使用CNN和NMT结合,处理多种语言的运行时错误。CNN捕捉局部变更模式,NMT建模全局语义转换。训练数据来自GitHub的Pull Request,每个PR的提交前版本视为错误代码,提交后版本视为修复。通过大规模数据训练,模型能够生成多行补丁,处理复杂逻辑错误。

SequenceR引入复制机制,允许解码器从输入复制标记,这对处理标识符和字符串字面量至关重要。模型基于Transformer,编码器使用相对位置编码,解码器使用指针网络。在Defects4J数据集上,SequenceR在67个错误上生成正确补丁,成功率约18%。虽然低于搜索方法,但速度提升千倍以上,适合快速提供修复建议。

12.3 特定领域的修复策略

不同应用领域有特定错误模式和修复规则,领域特定修复利用这些知识提升效果。在深度学习应用故障修复中,DeepDiagnosis将故障分为八类(如数据加载错误、模型结构不匹配),每类使用专门的修复模板和模型。对于数据加载错误,模型建议调整数据预处理步骤;对于维度不匹配,模型推荐修改层配置。通过领域特定分类,修复准确率提升至82%。

在智能合约领域,Security错误代价极高。SPVF结合AST、安全属性和注意力机制,学习安全相关的代码模式。安全属性包括重入防护、整数溢出检查等,作为额外输入指导修复生成。在检测整数溢出漏洞时,模型不仅定位问题代码,还生成添加SafeMath库调用的补丁。

对于构建脚本错误,HireBuild从历史构建失败数据中学习。Gradle构建脚本的常见错误包括依赖版本冲突、任务配置错误等。模型将错误构建日志和脚本作为输入,生成修改后的脚本。Styler针对代码风格违规,使用LSTM生成符合Checkstyle规则的格式化代码。这些领域特定模型利用领域知识的注入,在各自场景下取得比通用模型更好的效果。

12.4 修复数据集构建与评估

高质量修复数据集对训练和评估至关重要。Defects4J是Java修复领域最权威的基准,包含835个可复现错误,每个错误都有触发测试和人工修复补丁。然而,其规模对于深度模型训练仍显不足。Bugs.jar扩展了这一思想,从开源项目中自动挖掘1158个Java错误,通过静态分析验证补丁语义等价性,构建了更大规模数据集。

对于C/C++,ManyBugs和IntroClass提供编译错误和运行时错误样本。ManyBugs包含185个真实项目中的错误,IntroClass收集编程练习中的学生错误,适合不同难度级别的评估。Vul4J专门针对Java安全漏洞,包含79个可复现漏洞及POC测试,是评估漏洞修复能力的重要基准。

数据构建面临的关键挑战是如何确保补丁质量。人工编写的补丁通常是最小化且语义正确的,但自动挖掘的补丁可能包含无关变更。GrowingBugs通过自动化工具识别并排除与错误修复无关的代码变更,确保补丁纯净性。交叉验证修复正确性通常通过测试套件,但测试可能不充分。因此,一些数据集额外提供人工验证或形式化规范,如TEGCER使用符号执行验证补丁语义等价性。

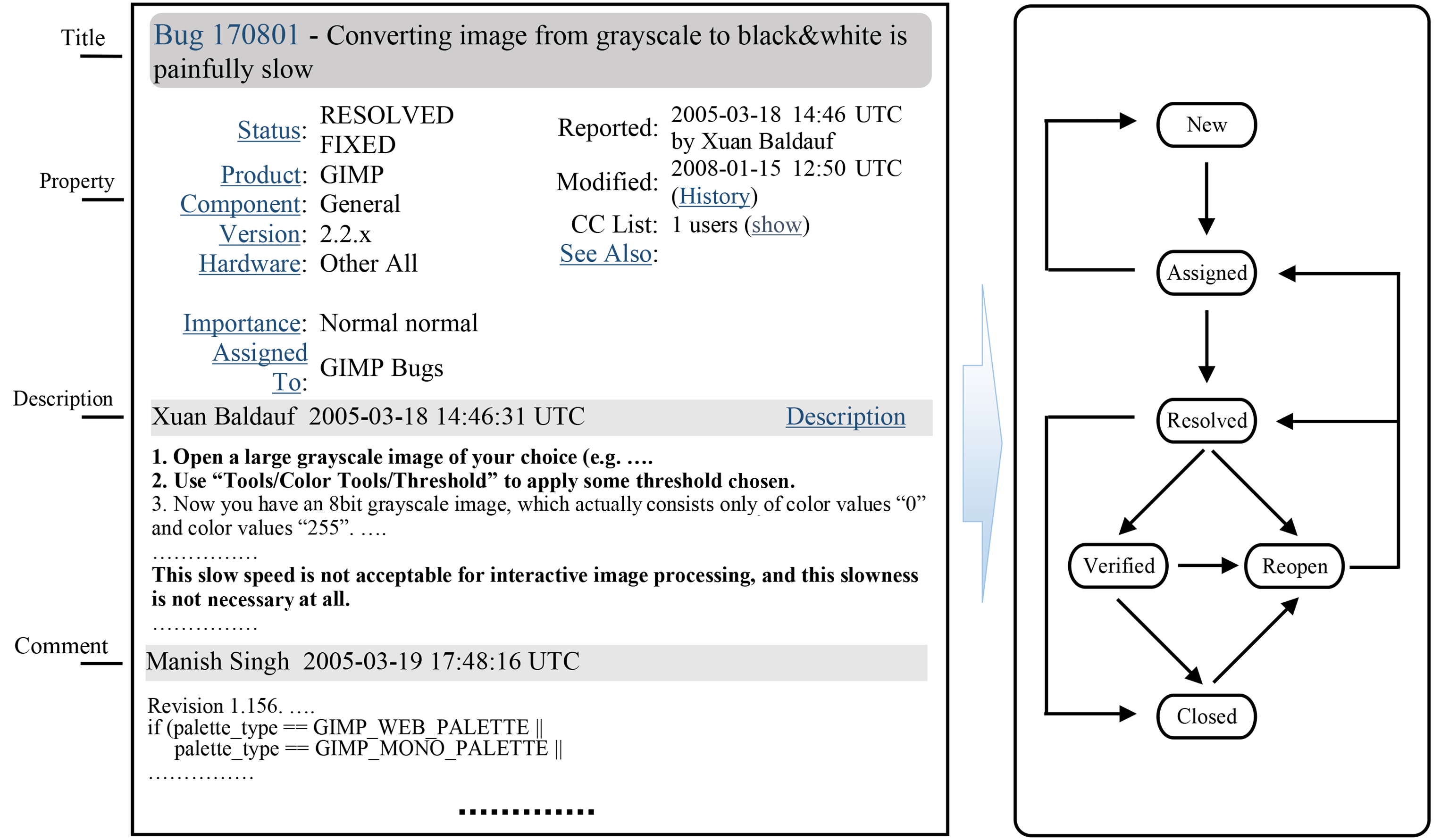

13 缺陷报告管理的智能化

13.1 报告质量增强与摘要

缺陷报告质量直接影响修复效率,但许多报告信息不完整或描述模糊。深度学习技术通过自动生成、扩展和摘要提升报告质量。报告摘要任务旨在从长报告中提取关键信息,帮助开发者快速理解问题。Li等人提出的自动编码器架构从报告中提取多个特征,包括文本内容、堆栈跟踪、重现步骤等,通过编码器-解码器框架生成简洁摘要。在Gnome项目数据上,ROUGE-L分数达到45.3%,摘要长度减少70%而信息保留率超过80%。

检索增强生成在报告质量提升中发挥作用。FIELDS系统从相似历史报告中提取补充信息,丰富当前报告。具体而言,对于新报告 r ,检索最相似的K个报告,提取它们的解决方案、相关文件和开发者评论,使用层次注意力机制融合这些信息生成增强报告。这种方法不仅补充缺失细节,还提供潜在修复思路,在Eclipse数据集上使开发者理解时间缩短35%。

报告标题生成是另一个重要任务。高质量标题应准确概括缺陷本质。HINDBR使用异构信息网络建模报告间关系,结合图注意力网络学习报告表示,解码器生成标题。模型考虑报告间的关联(如重复报告、相关组件),使生成标题更具信息性。在Mozilla数据集上,生成标题与人工标题的BLEU-4分数达到38.5%,显著优于仅基于内容的生成方法。

13.2 重复报告检测与聚类

大型项目每天接收大量缺陷报告,重复报告浪费开发资源。传统基于文本相似度的方法难以处理描述方式差异。深度学习方法学习语义表示,能够识别表面不同但描述相同问题的报告。CNN和LSTM被广泛用于编码报告文本,Siamese网络架构通过共享编码器学习报告对的相似度。对于报告对,编码器生成向量

,相似度分数

$$s = \sigma(\mathbf{v}_1^T \mathbf{W} \mathbf{v}_2 + b)$$

其中 W 是可学习的相似度矩阵。

BERT的出现显著提升了重复检测性能。USE+SVM架构使用通用句子编码器USE获得报告向量,SVM分类器判断重复性。NoRBERT使用领域自适应的BERT模型,在需求分类任务上微调后再用于重复检测。PRCBERT引入提示学习,设计特定模板如"这两个报告描述的是[MASK]问题",利用预训练模型的填空能力判断语义等价性。在OpenOffice数据集上,这些BERT-based方法F1分数达到89-92%,远超传统TF-IDF基线(约75%)。

聚类方法将相似报告分组,便于批量处理。深度嵌入聚类使用自编码器学习低维表示,然后通过K-means聚类。联合优化嵌入和聚类中心使表示更适合聚类任务。对于大规模报告流,在线聚类算法增量更新聚类中心,实时合并新报告到现有簇。在Firefox项目上,在线聚类将数千报告聚为200个簇,每个簇代表一个独立问题,极大简化了分类工作。

13.3 智能分派与优先级预测

缺陷分派将报告分配给合适开发者,传统方法基于组件映射或开发者近期活动。深度学习方法建模开发者专长与报告内容的匹配度。BT-RL使用深度强化学习,状态是报告特征和开发者当前负载,动作是分派决策,奖励是修复时间或质量。通过Q-learning,智能体学习最优分派策略,平衡负载和专业匹配。在Eclipse数据上,RL-based方法将平均修复时间缩短22%。

开发者推荐也使用异构信息网络建模。构建包含开发者、报告、组件、修复历史的网络,通过图嵌入学习每个节点的向量表示。推荐时计算报告向量与开发者向量的相似度,结合开发者当前工作量和成功率进行排序。HGRec使用超图建模复杂关系(多个开发者在同一报告上协作),超边连接相关节点,超图卷积传播信息,在GitHub项目上Top-5推荐准确率超过85%。

优先级预测帮助团队合理分配资源。Han等人使用浅层CNN自动从报告描述捕获判别特征,预测严重性等级(Blocker、Critical、Major等)。模型将文本视为词向量序列,卷积层提取n-gram特征,全局最大池化获得关键模式,全连接层分类。在Eclipse数据集上,准确率比传统SVM提升8个百分点。Gomes等人的综述确认深度学习方法在此任务上普遍优于传统ML,特别是处理长文本和模糊描述时。

14 开发者协作的智能支持

14.1 专业能力建模与演进

准确评估开发者技术能力是智能协作的基础。传统方法基于贡献度量(如提交次数、代码行数),但这些指标无法反映真实技能水平。深度学习方法通过学习开发者的代码、文档、交互数据构建能力画像。Expertise Browser挖掘变更管理系统数据,通过TF-IDF计算开发者在不同主题上的活跃度。然而,这种方法忽略代码质量和影响力。

Code2Vec等表示学习方法将开发者编码为向量,捕捉其技术栈和编程风格。具体过程是收集开发者提交的所有代码,训练Doc2Vec模型,使每个开发者ID关联其代码向量。这种向量表示可用于计算开发者相似度、推荐合作者。Dakhel等人扩展了此框架,加入仓库文本描述和问题跟踪数据,使能力画像更全面。在Stack Overflow和GitHub关联数据上,向量表示成功将Java后端开发者与相关技术问题匹配,准确率达91%。

开发者能力随时间演进,建模这种动态性对准确预测当前能力至关重要。Yan等人提出基于异构信息网络的时序模型,包含开发者、技能、问题、项目四类节点,节点间关系如"开发者回答问题"、"开发者参与项目"等边类型。使用随机游走生成节点序列,Word2Vec学习节点向量,然后通过时间衰减函数建模技能遗忘效应。能力评分公式为:

$$

\text{Expertise}(d, s, t) = \sum_{i} \alpha_i \cdot e^{-\lambda(t-t_i)} \cdot \text{score}(e_i)

$$

其中 ei 是开发者 d 在时间 ti 与技能 s 相关的事件(如回答问题、提交代码),αi 是事件权重,λ 是遗忘因子。这种动态建模在招聘任务上比静态方法准确率提升15%。

14.2 任务分配与推荐系统

智能任务分配将开发任务匹配给最合适开发者,考虑技能、负载、兴趣等多因素。Crowdtesting中的任务推荐面临数据稀疏和冷启动挑战。PTRec使用随机森林动态推荐任务,特征包括工人技能、历史表现、任务难度和上下文信息。通过在线学习更新模型,适应工人技能提升。在Topcoder数据上,该模型使任务完成率提升18%,早期缺陷检出率提升25%。

代码评审者推荐是典型任务分配场景。EARec同时考虑开发者专长和权威度,专长通过其在相关文件的历史贡献计算,权威度通过评审网络中的PageRank衡量。CORAL使用图卷积网络建模社会技术图,节点是开发者和代码组件,边是历史评审关系。GCN学习节点表示时同时考虑技能相似度和协作紧密度。在大规模微软项目上,CORAL推荐的评审者比传统方法发现更多缺陷。

Pull Request(PR)的评审者推荐更具挑战性,因为PR可能涉及多个文件和组件。Zhang等人提出基于超图的推荐系统HGRec,超边连接PR、相关文件和潜在评审者,允许一个PR有多个评审者。超图卷积操作传播信息,使每个PR获得综合评审者表示。在12个开源项目上,HGRec的Top-5推荐准确率超过90%,显著优于仅基于文件路径的基线。

14.3 团队形成与协作优化

复杂任务需要团队协作,形成高效团队是软件工程难题。团队形成问题可建模为组合优化:给定任务需求和开发者集合,选择子集最大化团队效能。效能函数通常包含技能覆盖、协作成本和成员兼容性。Yoda系统通过挖掘邮件列表和版本控制系统数据,识别经验丰富且积极互动新手的开发者作为导师,推荐给新人。这种方法在5个开源项目评估中,新开发者留存率提升30%。

兼容性建模考虑开发者间社交关系和技术互补性。Surian等人构建协作网络,节点是开发者,边权重是合作历史强度,使用带重启的随机游走推荐兼容协作者。在SourceForge数据上,推荐接受率达81%。Ye等人针对竞赛平台Kaggle,识别影响队友选择的三个因素:技能互补、社交联系和时间可用性,设计线性规划算法最大化协作意愿。该方法在Kaggle竞赛组队预测上准确率达78%。

团队技能覆盖确保团队具备完成任务所需的所有技能。将任务分解为技能需求集合

$$S = \{s_1, s_2, ..., s_k\}$$

每个开发者 d 拥有技能子集 Skills(d) 。团队 T 覆盖任务当且仅当

$$\bigcup_{d \in T} Skills(d) \supseteq S$$

TIPMerge推荐分支合并协作参与者,构建开发者变更历史、分支依赖关系图,计算知识覆盖度,推荐能互补知识的开发者组合,使联合知识覆盖率提升49.5%。

15 共性挑战与未来方向

15.1 数据质量与规模的双重困境

尽管软件工程数据呈爆炸式增长,高质量标注数据仍是稀缺资源。需求文档、架构设计等关键数据通常保密,开源社区的数据虽丰富但噪声大、不一致。构建大规模、多样化、高质量数据集是首要挑战。自动数据生成技术(如程序合成、变异测试)虽有进展,但生成数据与真实数据的分布差异影响模型泛化。

跨语言、跨项目泛化能力是实际部署的关键。不同编程语言的语法语义差异、编码风格多样性、领域特定模式使单一模型难以通用。虽然预训练模型提供了共享表示基础,但领域自适应仍需大量目标领域数据。元学习和少样本学习技术有望缓解这一问题,通过学习快速适应新领域的能力。

15.2 可解释性与可靠性需求

软件工程任务对模型可解释性要求极高。开发者需要理解模型建议的依据,才能信任并采纳。然而,深度学习模型的黑盒特性与此矛盾。注意力机制提供一定解释性,但其可靠性受质疑。对抗攻击研究表明,注意力权重可被操纵而不影响预测,削弱了可解释性主张。

形式化验证深度学习模型本身成为新兴方向。验证模型满足某些性质(如输出范围约束、输入输出单调性)对安全关键软件至关重要。然而,神经网络验证计算复杂度高,仅适用于小规模网络。开发高效验证算法或设计内在可验证的架构是重要研究方向。

15.3 与经典软件工程的融合

深度学习不应取代经典方法,而应互补。在符号执行中,学习模型提供路径选择启发式,但路径约束求解仍依赖成熟的SMT求解器。在程序验证中,学习模型生成候选不变式,但证明构建仍需形式化推理。混合系统结合两者优势,是当前最有效范式。

未来发展方向包括:神经符号计算,深度神经网络与传统符号推理深度融合;持续学习模型,适应软件演化而无需从头重新训练;联邦学习框架,在保护隐私前提下跨组织协作训练;人机协同系统,有效结合人类专家判断与模型建议。特别是大语言模型展现出的强大代码理解和生成能力,为自动化软件工程开辟了新可能性,但其幻觉问题、安全漏洞需审慎处理。

16 结论

深度学习已深刻改变软件工程研究与实践,在需求分析、代码生成、测试、缺陷管理等全生命周期任务中展现强大能力。表示学习、注意力机制、预训练范式是核心技术突破,使模型能够理解代码语义和结构。然而,数据稀缺、泛化困难、可解释性不足仍是制约广泛应用的主要障碍。未来研究应聚焦于构建高质量数据集、设计可信可解释的模型、深度融合经典软件工程方法。随着技术演进,深度学习有望成为软件开发的智能助手,但人类专家的领域知识和创造性思维仍不可或缺。软件工程社区需持续探索人机协作新模式,在利用AI提升效率的同时,确保软件质量、安全和可靠性。这一领域的跨学科特性要求研究者兼具深厚软件工程洞见和先进AI技术能力,推动软件工程进入智能化新时代。

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?