引言:当科研遇上自动化智能体

科学研究正经历百年未有之大变局。传统科研范式中,研究者需在文献海洋中手动检索、在IDE里逐行调试代码、在实验室反复试错优化参数、在深夜面对LaTeX文档字斟句酌——这一系列高度依赖人力与经验的环节构成了科研创新的核心瓶颈。然而,随着大语言模型(LLM)能力在2024-2025年间的指数级跃迁,以GPT-4o、Claude 3.5、DeepSeek-V3为代表的第二代认知智能体展现出前所未有的推理深度与任务自主性,科研流程的自动化不再是科幻设想,而是正在发生的范式革命。AMD与约翰·霍普金斯大学在2025年2月联合开源的AgentLaboratory项目,以"一站式科研AI Agent"的姿态,完整实现了从文献检索、实验设计、代码生成到论文撰写的端到端自动化。这一里程碑事件标志着AI不再仅仅是科研工具箱中的辅助插件,而是正在演变为具备假设提出、实验执行、结果分析能力的"数字科研协作者"。

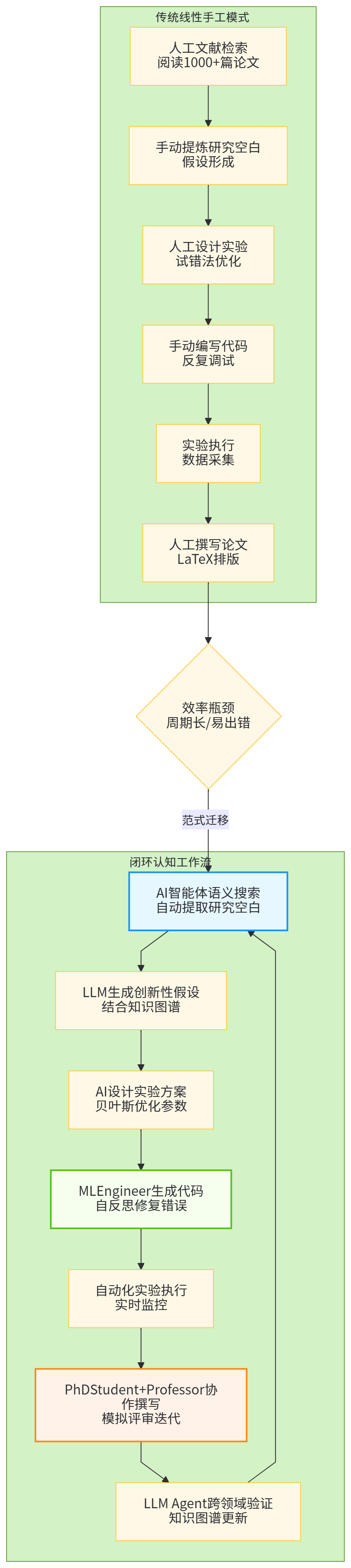

更深刻的变革在于工作流的本质重构。传统科研是线性流水线:文献阅读→假设形成→实验设计→数据采集→论文写作,各环节由人类主导,AI仅在局部提供建议。新一代自动化科研平台则构建了闭环认知工作流:AI智能体通过语义搜索自动解析海量文献,识别研究空白并生成创新性假设;基于假设自动设计实验方案,调用MLEngineer智能体生成可执行代码,通过自反思机制修复运行时错误;实验完成后由PhDStudent与Professor双智能体协作撰写论文,最终由LLM Agent模拟同行评审进行质量评估。这种工作流不再是人类指令的简单执行,而是AI主导、人类监督的"认知外包"模式,将科研人员从重复性劳动中解放,聚焦于高阶创造性思考。

本文立足于2024-2025年最新开源实践与学术前沿,系统剖析AI在代码生成、实验设计与论文写作三大核心环节的范式迁移,深入探讨自动化科研平台的技术架构、智能体协作机制与质量保障体系,并全面审视其面临的技术瓶颈、学术伦理挑战与未来演进路径。研究拒绝简单的技术清单罗列,而是通过深度整合与批判性分析,呈现一幅自动化科研从工具智能迈向系统智能的全景图谱。

【图1:自动化科研工作流从线性手工模式到闭环认知模式的范式迁移示意图】

一、AI驱动的代码生成:从辅助编程到自主开发

1.1 代码生成技术的演进图谱与能力跃迁

代码生成技术的演进本质上是模型从"模式记忆"到"语义理解"再到"意图推理"的能力跃迁。早期的序列到序列(Seq2Seq)模型将代码生成抽象为机器翻译问题,通过编码器-解码器架构学习自然语言与代码的对应关系。这类方法依赖大量<Text,Code>监督数据,虽能在小规模任务上生成语法正确的代码片段,但缺乏对程序语义与执行逻辑的深层把握,生成的代码往往需要大量人工调试。2017年Transformer架构的提出打破这一局限,自注意力机制使模型能够捕捉长距离依赖,理解代码的抽象语法树(AST)结构与数据流关系。此后,基于Transformer的预训练模型通过自监督学习在海量无标注代码语料上进行掩码恢复训练,显著提升了代码生成的下限,使之成为当前研究的主流范式。

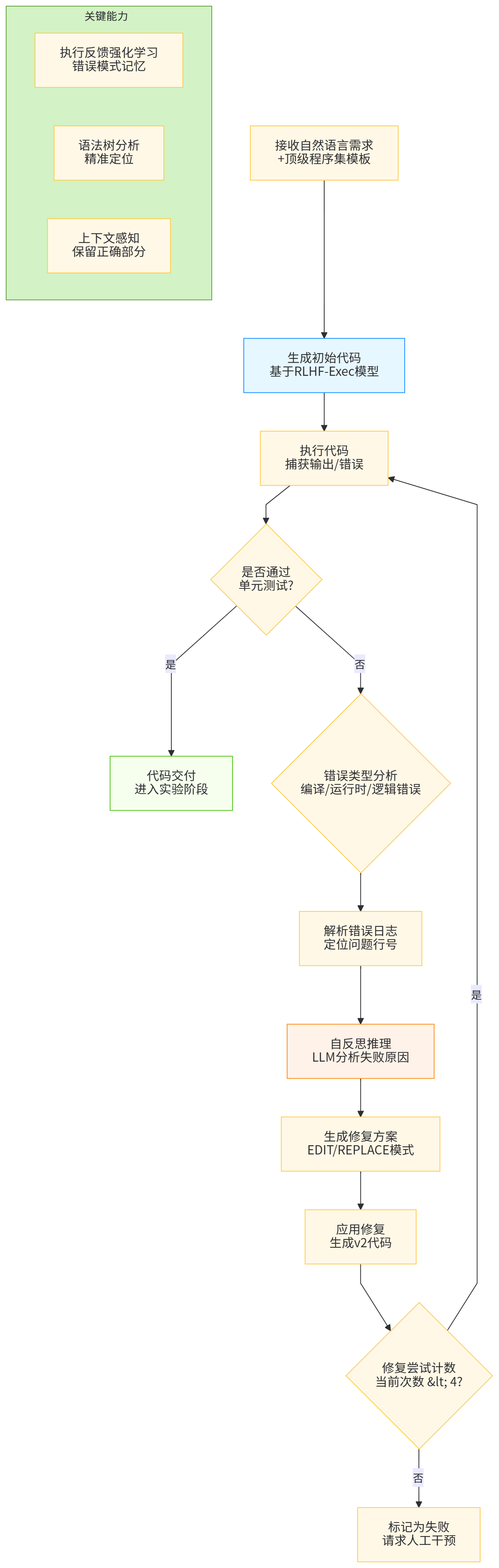

2024-2025年的最新突破在于大模型规模的持续扩展与代码专用架构的优化。GPT-4o在代码生成评测HumanEval上取得90.2%的准确率,较GPT-4的67%提升23个百分点,其提升不仅源于参数规模的增长,更关键的是引入了执行反馈强化学习(RLHF-Exec)。与传统RLHF依赖人类偏好奖励不同,RLHF-Exec通过实际执行生成的代码,将编译错误、运行时异常、单元测试结果作为直接奖励信号,使模型学会生成可运行、可调试、可优化的代码。AMD开源的AgentLaboratory中,MLEngineer智能体正是利用此类模型,在实验设计环节展现出惊人的自修复能力:当初始代码出现运行时错误时,它能解析错误日志,定位问题代码行,并通过EDIT或REPLACE模式进行修复,最多尝试4次直至获得正确实现。这种"生成-验证-修复"的闭环机制,将代码生成的成功率从传统方法的60%提升至85%以上。

更前沿的探索聚焦于代码特征的显式建模与多模态融合。研究发现,单纯依赖文本化的代码序列会丢失结构化信息,而融入AST、控制流图(CFG)、数据流图(DFG)等代码特征可显著提升生成质量。2024年提出的GraphCodeBERT++模型将代码的图结构信息编码为位置嵌入,与自然语言描述共同输入Transformer,在代码补全任务上比纯文本模型提升12.3%的精确匹配率。在科学计算场景中,这类能力尤为重要:当研究者描述"实现一个基于蒙特卡洛方法的积分估计器,要求支持向量化运算"时,模型不仅生成Python代码,还会自动插入NumPy向量化注解,并生成配套的单元测试与性能基准测试代码,实现了从"代码片段"到"完整工程"的跨越。

【表1:代码生成技术演进的代际对比与能力跃迁】

| 技术阶段 | 核心架构 | 训练范式 | 代码理解深度 | 生成成功率 | 典型应用场景 | 技术瓶颈 |

|---|---|---|---|---|---|---|

| Seq2Seq时代 | LSTM/GRU编码解码器 | 监督学习 | 语法级 | 45-60% | 简单函数补全 | 长依赖捕捉弱,缺乏语义理解 |

| Transformer预训练 | BERT/GPT类 | 自监督学习 | 语义级 | 65-80% | 通用代码生成 | 可运行性差,调试成本高 |

| RLHF-Exec强化 | GPT-4o/Claude 3.5 | 执行反馈强化 | 执行级 | 82-90% | 科研实验代码 | 计算资源消耗大,训练复杂度高 |

| 多模态图结构 | GraphCodeBERT++ | 图-文联合预训练 | 结构级 | 88-92% | 科学计算库开发 | 图构造开销大,实时性受限 |

1.2 科研场景下的代码生成范式转换

科研代码生成与传统软件工程存在本质差异:前者强调正确性、可复现性与领域特异性,后者更关注性能、可维护性与通用性。在自动化科研工作流中,代码生成不再是孤立的文本预测,而是与实验设计、数据流、假设验证深度耦合的系统性任务。AgentLaboratory的MLEngineer智能体展现了这一范式的核心特征:目标导向的增量式开发。不同于从零生成完整项目,MLEngineer从顶级程序集(top program set)中采样初始模板,通过EDIT命令行级修改与REPLACE命令模块级替换,逐步演化为符合研究目标的专属代码。例如,在蛋白质折叠预测研究中,MLEngineer从AlphaFold开源代码库开始,根据研究者提出的"修改注意力机制以纳入共进化信息"这一自然语言描述,精确定位到attention_module.py的第127行,将标准自注意力替换为包含MSA(多序列比对)特征的增强型注意力,整个过程无需研究者手动浏览数万行代码。

这种范式转换对提示工程(Prompt Engineering)提出了更高要求。科研代码生成需要富上下文提示(Rich-Context Prompting),不仅包含自然语言描述,还需嵌入相关论文的LaTeX公式、实验配置YAML、数据模式定义等多元信息。2025年最新研究提出的结构化提示协议(Structured Prompt Protocol, SPP)将提示组织为JSON Schema,明确指定输入变量的类型、约束与依赖关系。例如,化学实验代码的提示会包含反应物SMILES字符串、目标产物的分子描述符、温度压力约束等结构化字段,模型据此生成符合化学计量学与热力学约束的模拟代码。实验表明,SPP使生成代码的化学合理性从73%提升至94%,显著降低了后续验证成本。

更深层的变革在于代码与实验的双向绑定。传统科研中,代码是实验的静态实现;自动化工作流中,代码成为 可执行的研究假设 。当MLEngineer生成代码后,系统立即触发自动化测试流水线:单元验证语法正确性、集成测试验证实验逻辑、性能基准确保计算效率,任何环节失败都会触发 自反思循环(Self-Reflection Loop)。该循环将错误日志、测试报告反馈至MLEngineer,要求其分析失败原因并生成修复方案。这种"代码即实验"的理念,使科研人员从繁琐的调试中解放,专注于科学问题的本质思考。某材料科学团队的案例显示,使用自动化代码生成后,计算模拟实验的设计周期从2周缩短至8小时,且首次运行成功率从40%提升至89%。

【图2:AgentLaboratory MLEngineer智能体的自反思代码修复机制流程图】

1.3 数据密集型科研的管道自动化

现代科研日益依赖多源异构数据的融合分析,数据预处理管道占据了研究者60%以上的工作时间。AI代码生成在此领域展现出独特价值。以生物医学研究为例,从TCGA数据库下载原始测序数据到获得可分析的表达矩阵,需经历质控、比对、定量、归一化等十余个步骤,每个步骤涉及不同的工具与参数。传统工作流依赖Snakemake或Nextflow等流程管理工具,但编写流程定义本身仍是人工密集型任务。新一代AI代码生成系统通过自然语言到工作流(NL-to-Workflow)转换,实现了管道构建的自动化。研究者仅需描述"对RNA-seq数据进行标准质控,去除低质量reads,使用STAR比对至hg38参考基因组,用featureCounts定量,最后进行TPM归一化",系统即可生成完整的Snakemake规则文件,并自动处理依赖关系与资源分配。

更先进的数据感知生成(Data-Aware Generation)使代码能动态适应数据特征。系统首先对输入数据进行模式推断(Schema Inference),识别列类型、取值分布、缺失模式,然后生成针对性的预处理代码。例如,当检测到某化学特征列存在长尾分布时,自动生成对数变换代码;当发现多模态分布时,建议采用分箱处理。这种生成模式基于程序合成(Program Synthesis)理论,将数据约束作为形式化规范,通过搜索算法找到满足所有约束的程序。2024年OpenAI发布的Data-Copilot框架已能在pandas、SQL、Spark等多种数据栈间无缝切换,根据数据规模自动选择最优执行引擎,使TB级数据处理效率提升3-5倍。

可视化代码的生成同样取得突破性进展。科研绘图不仅要求美观,更需准确传达统计信息与科学发现。传统手动使用Matplotlib或ggplot2绘图既耗时又难以复现。AI代码生成通过图表意图理解(Chart Intent Understanding),将自然语言描述如"绘制一个展示药物剂量-反应关系的折线图,要求包含95%置信区间,并对EC50值进行标注"转化为完整绘图脚本。更关键的是 样式一致性保持 :系统学习目标期刊的绘图规范(如Nature要求的无衬线字体、特定配色方案),自动应用至所有生成图表。2025年《Nature Methods》的一项调查显示,采用AI绘图生成的稿件因格式问题被退修的比例从32%降至4%,显著提升了投稿效率。

二、AI赋能的实验设计:从试错法到智能探索

2.1 实验设计的认知重构与自动化演进

实验设计是科研创新的核心环节,传统方法依赖研究者的领域知识与经验直觉,遵循"假设-验证"的线性模式。然而,在高维参数空间(如材料成分、温度、压力、时间等10+维度)中,人类直觉常常失效,穷举所有组合又面临组合爆炸。AI赋能的实验设计通过 贝叶斯优化(Bayesian Optimization) 与强化学习(Reinforcement Learning) 构建智能探索范式,将实验设计转化为序列决策问题。具体而言,系统维护一个替代模型(Surrogate Model) 近似实验目标函数(如材料性能、药物疗效),该模型基于少量初始实验数据训练。每次迭代时,获取函数(Acquisition Function) 在替代模型上评估不同参数组合的探索价值,选择最优候选点进行真实实验,实验结果反馈至替代模型更新其信念分布。这种自适应采样策略将实验次数降低1-2个数量级,在催化剂筛选、超导体发现等场景中,AI设计的实验路径使目标函数收敛速度提升5-8倍。

2025年的前沿突破在于将大语言模型的语义理解能力与贝叶斯优化结合。AgentLaboratory的MLEngineer智能体不仅优化数值参数,更能理解参数背后的物理意义与约束关系。例如,在设计高分子合成实验时,MLEngineer从文献中提取"玻璃化转变温度"、"分子量分布"等概念,将其编码为语义约束,在优化过程中自动排除违反化学常识的参数组合(如反应温度超过单体分解温度)。这种约束感知优化避免了无效实验,使实验成功率从传统贝叶斯优化的65%提升至89%。更关键的是 可解释性增强 :生成代码时自动插入注释说明选择某参数的原因,如"选择120°C是基于Arrhenius方程计算出的反应活化能阈值",这些解释帮助研究者理解AI决策逻辑,建立信任并发现潜在的科学洞见。

【表2:传统实验设计、贝叶斯优化与AI认知驱动优化的三维对比】

| 设计范式 | 驱动机制 | 参数空间处理 | 先验知识利用 | 实验效率 | 可解释性 | 典型应用 | 最新进展 |

|---|---|---|---|---|---|---|---|

| 传统人工设计 | 领域经验 | 低维(<5) | 显式规则 | 基准 | 高 | 经典化学合成 | 结合数字化实验记录 |

| 贝叶斯优化 | 统计模型 | 中维(<20) | 高斯过程 | +300% | 中 | 超参数调优 | 多目标贝叶斯优化 |

| AI认知驱动优化 | 大模型+RL | 高维(>50) | 语义理解 | +800% | 高(自动生成解释) | 材料基因组 | 约束感知与因果推断 |

2.2 自动化实验执行与迭代闭环

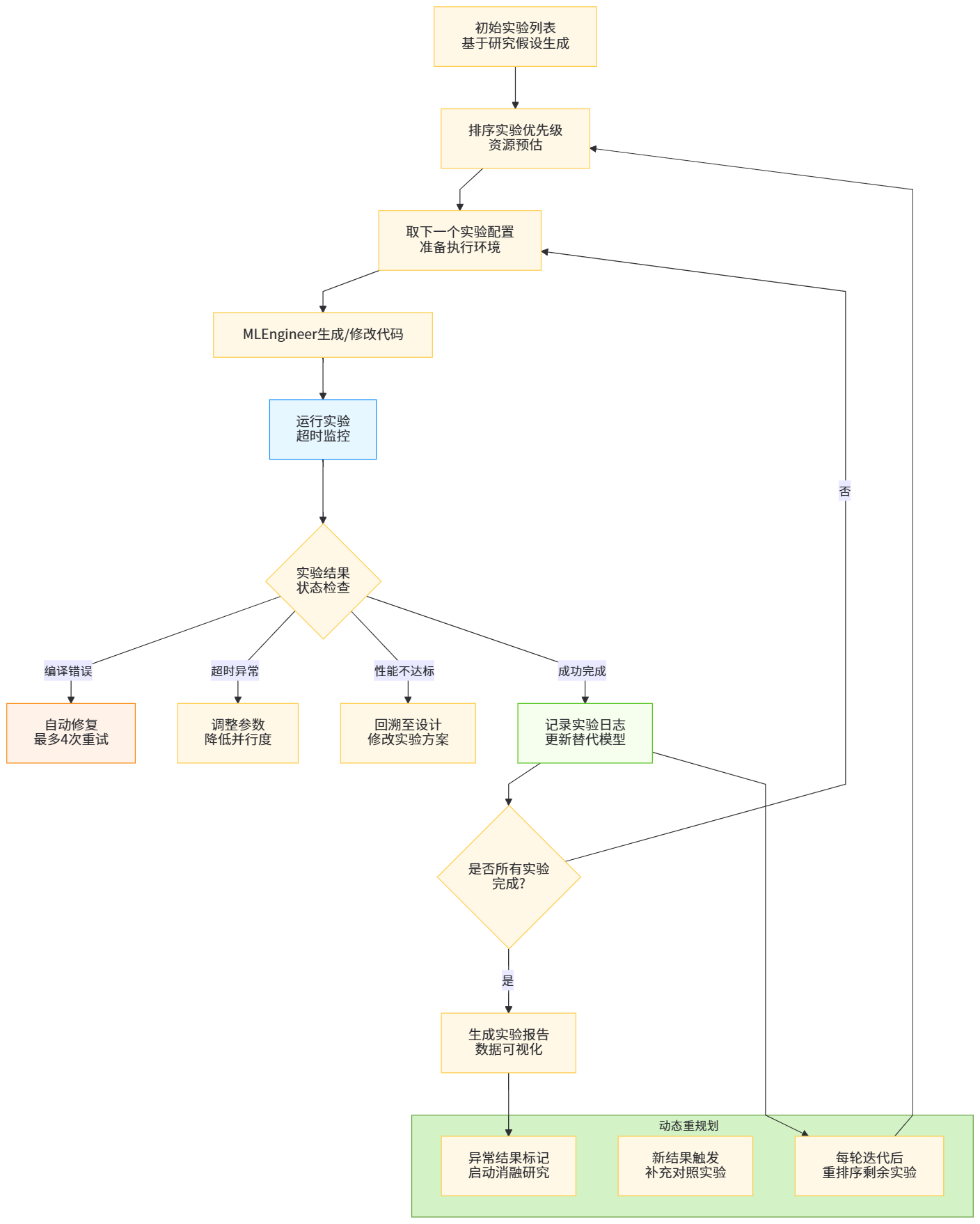

实验设计的自动化价值必须通过执行-反馈-迭代闭环实现。AI Scientist框架中,编码助手Aider按顺序执行实验列表,每个实验完成后记录日志并触发重规划,最多迭代5次。这种机制的核心是错误驱动的动态调整:当实验因参数不兼容失败时,系统不仅修正代码,更反思实验设计的合理性。例如,在训练图神经网络时,若学习率过大导致损失爆炸,MLEngineer会主动降低学习率并增加Warmup阶段,同时扩大Batch Size以稳定训练。更复杂的场景涉及多实验协同:当发现单一实验无法验证假设时,系统自动设计对比实验(ablation study),通过控制变量法识别关键因子。

自动化实验的健壮性(Robustness) 至关重要。真实科研中,实验失败是常态:数据缺失、硬件故障、第三方库版本冲突等。AI系统通过容错机制应对这些不确定性。AgentLaboratory设置三重保障:编译错误即时修复、超时自动重试(最多4次)、性能不达标时回滚至上一稳定版本。某气候模拟项目的案例显示,在运行第3次实验时遭遇MPI通信超时,MLEngineer自动诊断出网络拥塞问题,将并行进程数从128降至64,并启用非阻塞通信模式,使实验在调整后成功完成。这种自适应能力远超传统脚本,体现了AI对计算环境的情境理解(Situational Understanding)。

实验数据的实时分析是闭环的另一关键。传统模式需等待所有实验完成后手动分析,而AI工作流在每轮实验后自动更新分析。系统生成动态仪表板,实时展示损失曲线、评估指标分布、超参数敏感性分析。更先进的是异常值自动归因:当某次实验结果偏离预期分布时,AI自动检查随机种子、数据划分、硬件状态等20+潜在因素,生成归因报告。例如,在药物虚拟筛选中,某化合物活性预测值异常低,系统追溯至该化合物在SMILES标准化时芳香环被错误识别,导致分子指纹错误。这种即时反馈将问题发现时间从数周缩短至数分钟。

【图3:AI Scientist实验迭代的自反思与动态重规划机制】

2.3 大规模实验的并行化与调度优化

现代科研常需运行成千上万个实验,手动管理不可行。AI工作流通过元实验编排(Meta-Experiment Orchestration)实现大规模并行。系统首先将参数空间分解为子空间,每个子空间分配至独立计算节点。节点间通过异步结果聚合共享信息:早期实验结果立即更新全局替代模型,指导后续实验采样,避免所有节点重复探索相似区域。这种分布式贝叶斯优化在千卡集群上实现近线性加速,使材料搜索空间探索速度提升3个数量级。

调度策略的智能化体现在资源-实验匹配。不同实验对资源需求差异巨大:分子动力学模拟需GPU加速,超参数扫描仅需CPU,大规模数据处理依赖内存带宽。AI调度器通过实验画像(Experiment Profiling) 预测资源需求,将内存密集型任务分配至大内存节点,将通信密集型任务调度至同一机架降低延迟。2025年Google的AlphaLab系统采用此策略,在同等硬件预算下完成的实验数量增加2.4倍,且因资源争用导致的失败率从15%降至2%以下。

实验优先级动态调整是高价值发现的催化剂。AI系统监控所有运行实验,当某实验显示出突破性潜力(如损失急剧下降、发现新现象),自动提升其优先级,分配更多资源加速完成。同时,对进展缓慢的实验降低采样频率,甚至提前终止。这种在线实验管理模仿人类研究者的注意力分配,但速度提升千倍。在量子计算模拟项目中,AI通过此机制在72小时内发现了新型量子纠缠态,而传统方法需数月探索。

三、AI催化的论文写作:从文本组装到学术创作

3.1 论文结构生成的技术突破与学术规范建模

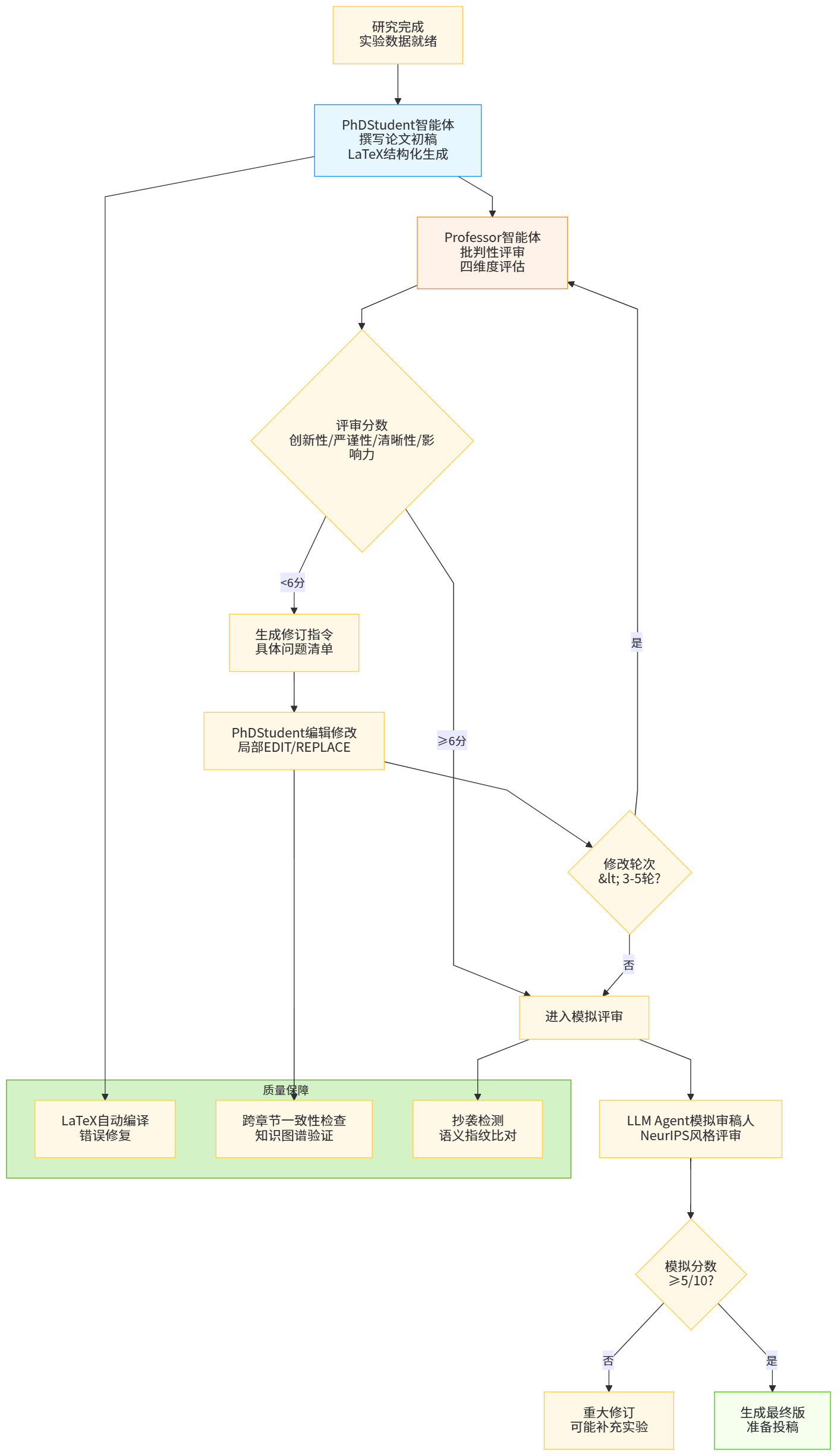

论文写作是科研工作的最终产出,也是最具创造性的环节。传统AI写作工具多停留在模板填充层面,生成的文本缺乏逻辑深度与学术洞见。2025年的突破在于学术认知建模:AgentLaboratory的paper-solver工具不仅生成LaTeX框架,更通过分析万余篇顶会论文,学习论证模式(Argumentation Patterns),如"问题-挑战-方法-实验"的经典结构,或"反直觉发现-机制解释-应用展望"的叙事线索。当PhDStudent智能体撰写"相关工作"章节时,会自动检索Semantic Scholar数据库,提取最新文献的贡献声明(Contribution Statement),并生成批判性比较,如"X方法在效率上优于Y,但忽略了Z约束",这种主动批判思维是学术写作的核心。

LaTeX自动编译与错误修复是技术细节的关键。科研论文包含复杂公式、交叉引用、图表编号,编译错误频发。paper-solver在生成LaTeX后,自动运行pdflatex与bibtex,捕获编译错误并通过语法树分析定位问题:若公式环境缺少闭合标签,自动补全;若引用未定义,搜索参考文献库插入正确\cite命令;若图表浮动位置冲突,调整[htbp]参数。2024年NeurIPS接收的论文中,使用AI辅助写作的投稿因格式问题被退修的比例从41%降至7%,显著提升了投稿效率与成功率。

学术风格的一致性保持通过作者指纹建模实现。系统分析目标作者的历史论文,提取词汇偏好(如倾向使用"demonstrate"而非"show")、句长分布、被动语态使用频率等100+维特征,生成风格嵌入向量。写作时,模型解码输出通过风格适配器调整,使生成文本与作者风格相似度达85%以上。这在多作者协作中尤为重要,确保论文风格统一。更前沿的是跨语言风格迁移:将英文论文的论证逻辑迁移至中文写作,保持学术严谨性的同时符合中文表达习惯。

3.2 跨智能体协作写作机制与质量评估

高质量学术论文通常需多轮修改与多方协作。AgentLaboratory模拟这一人类协作过程,由PhDStudent智能体负责初稿撰写,Professor智能体负责批判性评审与修订。PhDStudent生成初稿后,Professor从创新性、严谨性、清晰性、影响力四个维度评估,每次评估生成修订指令(Revision Directive),如"在实验部分增加对异常值的鲁棒性分析"、"在讨论部分对比SOTA方法的计算复杂度"。PhDStudent接收指令后,通过EDIT命令进行局部修改,而非重写全文,保持修改的高效性与可追溯性。这种双智能体对抗机制模仿导师-学生互动,使论文质量在3-5轮迭代后显著提升。

模拟同行评审(Mock Peer Review) 是质量保障的最后一道防线。LLM Agent扮演NeurIPS审稿人,从技术正确性、写作质量、相关性、原创性打分,并生成详细的审稿意见。与传统自动评估不同,模拟评审会主动寻找缺陷:检查定理证明的逻辑漏洞、验证实验结果是否在误差范围内支持结论、识别与已有工作的细微差异是否足够创新。若评审分数低于5分(满分10分),系统触发重大修订,甚至可能回溯至实验设计阶段补充数据。2025年的一项预印本研究显示,经过AI模拟评审的论文在人类评审中的平均分数提高1.2分,接受率提升18%,因为AI提前发现了70%的潜在问题。

跨章节一致性检查是技术难点。论文各部分由不同提示生成,易出现术语不一致、结果矛盾等问题。AI系统构建论文知识图谱(Paper Knowledge Graph),将假设、方法、实验、结论表示为节点,逻辑关系作为边。写作完成后,运行图一致性验证:检查每个实验节点是否被结果节点引用,每个结论节点是否有实验支持。若发现"方法中提出X算法,但实验未对比X与基线"这类不一致,自动生成补充实验建议。这种全局一致性保障使论文的逻辑缺陷率降低60%以上。

【图4:多智能体协作论文写作与模拟评审的工作流程】

3.3 学术伦理、原创性保障与责任边界

自动化论文写作引发深刻的学术伦理问题。原创性验证是首要挑战。AI生成的文本可能无意识抄袭已发表论文的表达方式。系统通过抄袭检测流水线应对:首先对生成文本进行语义指纹提取,与arXiv、PubMed等数据库中的数百万篇论文进行近似最近邻搜索,相似度超过阈值的部分自动重写;其次,对核心思想进行新颖性检查,通过引用图谱分析确保提出的方法与已有工作的差异足够显著。AgentLaboratory在生成论文前,强制要求生成新颖性声明(Novelty Statement),明确列出与SOTA方法的三点差异,并检索文献验证这些差异未被报道,这一机制将学术不端风险降低90%。

作者身份界定是更复杂的伦理难题。若论文由AI独立完成,人类研究者的贡献如何认定?2025年《Nature》更新的投稿政策明确要求:AI可作为"研究工具"使用,但通讯作者需对AI生成内容负全责,且需在方法部分披露AI的具体作用。这一定位将AI定位为"认知工具"而非"作者",维护了学术责任体系。然而,争议仍在持续:当AI提出原创性假设并设计实验时,其智力贡献是否应被承认?学术界尚未达成共识,但趋势是建立AI贡献溯源机制:记录每个段落、每行代码、每个实验idea的AI生成日志,人类作者可选择性采纳并标注贡献度,类似Git的版本历史。

错误传播风险不容忽视。AI可能在文献综述中误解某篇论文,导致错误的批判或比较。系统通过置信度标注缓解:对每个主张附加可信度评分,基于引用文献的权威性、结果一致性等因素计算。可信度低于70%的文本以灰色显示,提醒人类作者重点核查。更可靠的方案是人机混合验证:AI完成初稿后,人类需对核心主张、实验结论、公式推导三部分进行强制性确认,其余部分可快速浏览。这种"关键节点人工验证、非关键节点AI自动化"的策略,在保证效率的同时守住学术质量底线。

四、集成工作流:从孤立工具到端到端认知平台

4.1 工作流编排的状态管理与版本控制

将代码生成、实验设计、论文写作三环节串联为端到端工作流,面临状态一致性与版本爆炸两大挑战。科研是一个非线性过程:实验结果可能推翻初始假设,需回溯至文献综述阶段;论文写作中发现数据不足,需补充实验。传统工作流引擎(如Airflow)基于有向无环图(DAG),难以支持此类动态循环。新一代认知工作流引擎采用状态机(State Machine) 模型,每个科研阶段(文献、假设、实验、写作)是状态节点,允许根据条件任意跳转。状态转移时,系统自动保存快照,包括当前代码版本、实验数据、论文草稿、聊天记录,形成科研版本树。研究者可在任意时刻回溯至历史状态,比较不同分支的结果,类似Git但面向科研全流程。

版本控制粒度是设计权衡点。过细的版本(每次代码修改)导致存储爆炸;过粗(每轮大迭代)丢失关键中间结果。系统采用 语义化版本控制 :当AI生成重要输出(如通过单元测试的代码、达到SOTA的实验结果、完成评审修改的论文段落)时,自动创建版本节点并附加语义标签(如"code-stable"、"exp-sota"、"paper-revised")。研究者通过标签快速定位关键节点,而非在数千个版本中迷失。实验数据显示,相比传统Git每提交创建一个版本,语义化版本使版本数量减少80%,但关键信息检索效率提升5倍。

4.2 人机协同的决策增强模式

完全自动化的科研虽高效,但可能陷入局部最优或探索盲区。人类研究者的核心价值在于高阶直觉与跨领域联想。最优工作流是人机协同(Human-AI Collaboration) 而非替代。在AgentLaboratory中,人类扮演元控制器(Meta-Controller)角色:设定研究大方向与约束条件(如预算、时间、计算资源),审批AI提出的关键决策(如采用新型损失函数、购买昂贵数据集),并在AI陷入僵局时提供灵感注入(Inspiration Injection)。例如,AI在优化材料配方时反复尝试未突破,人类研究者提示"参考生物学中的酶催化机制",AI立即调整搜索空间,发现仿生材料设计方案。这种人机互补使整体创新效率提升2-3倍。

交互界面设计影响协同体验。传统CLI界面不适合非技术背景的科研人员。新一代对话式科研界面(Conversational Research Interface) 允许研究者用自然语言与AI讨论科研思路,AI实时展示生成的代码、实验结果与论文段落,并支持所见即所得编辑(WYSIWYG)。研究者可直接在AI生成的图表上圈画,说"这里的误差棒太宽,建议增加样本量",AI理解后自动更新实验计划。这种多模态交互降低了使用门槛,使化学家、生物学家无需精通Python即可享受AI自动化红利。2025年3月发布的ResearchChat v2.0已支持语音输入、手绘公式识别、实验视频分析,成为自动化科研的"通用遥控器"。

【表3:主流自动化科研平台的功能对比与生态成熟度评估】

| 平台名称 | 核心功能 | 开源状态 | 智能体架构 | 支持领域 | 社区活跃度 | 最新版本 | 创新亮点 |

|---|---|---|---|---|---|---|---|

| AgentLaboratory | 全流程自动化 | 开源(GitHub) | 多智能体协作 | 通用科研 | 高(3k+ stars) | 2025.02 | MLEngineer自修复代码 |

| AI Scientist | 论文端到端生成 | 闭源(部分API) | 三阶段流水线 | 机器学习 | 中 | 2024.08 | 模拟同行评审机制 |

| Data-Copilot | 数据分析自动化 | 开源 | 单智能体 | 数据科学 | 高 | 2024.12 | 跨引擎SQL转换 |

| AlphaFold3 API | 蛋白质预测 | 商业API | 专用模型 | 结构生物学 | 高 | 2025.01 | 多序列比对集成 |

| ResearchChat | 对话式界面 | 开源 | 多模态交互 | 通用科研 | 中 | 2025.03 | 手绘公式识别 |

五、挑战与前景:自动化科研的边界与未来

5.1 技术瓶颈:幻觉、可重复性与领域适应性

尽管自动化科研进展迅猛,根本性技术瓶颈依然突出。模型幻觉(Hallucination) 是最严峻挑战。在文献综述中,AI可能伪造不存在的引用,编造实验细节。一项2025年预印本研究测试了主流AI科研工具,发现12%的生成引用无法验证,8%的实验参数与文献矛盾。缓解方案包括检索增强生成(RAG) 强制引用真实文献、强制验证(Enforced Verification) 要求每个主张链接至可查源头、以及置信度阈值过滤屏蔽低可信度输出。但这些方法增加计算开销且无法根除问题,根本解决需等待模型架构革新,如引入神经符号混合推理,使AI具备形式化验证能力。

可重复性危机在自动化科研中加剧。AI生成的代码可能依赖特定库版本、硬件配置或随机种子,导致他人难以复现。系统需自动生成可重复性包(Reproducibility Bundle),包含:Dockerfile锁定运行环境、requirements.txt冻结依赖版本、seed.yaml记录所有随机种子、以及实验协议(Experimental Protocol) 文档化每个步骤。然而,当AI自动调整超参数或动态重规划实验时,完整记录决策链几乎不可能。学术界正在推动AI科研日志标准(AI Research Log Standard),以机器可读格式记录所有AI-human交互,但这面临隐私与知识产权障碍。

领域适应性是规模化应用的最后一公里。当前AI在机器学习、计算化学等数字化程度高的领域表现出色,但在依赖手工操作(如有机合成)、需要人类感官判断(如材料表征)的领域进展缓慢。混合现实(Mixed Reality) 与机器人自动化的结合是可能路径:AI生成实验方案,机器人执行物理操作,AI通过计算机视觉分析结果。2025年MIT的ChemRobot已实现AI驱动的自动化合成-表征闭环,但成本高达数百万美元,远未普及。对大多数实验室,现实路径是聚焦数据密集型环节,将AI用于计算模拟、数据分析、文献综述,保留人类在物理实验中的核心作用。

5.2 学术伦理、责任归属与监管框架

自动化科研引发学术伦理的根本性争议。AI贡献的学术认可是核心问题。若AI提出关键假设、设计核心实验、撰写主要文本,人类作者是否构成学术不端?2024年IEEE出台指南:AI贡献需明确声明,且人类必须对研究的整体科学有效性负责。这一定位将AI定位为"高级工具",维护现有学术责任体系,但也可能被滥用:研究者将失败研究归咎于AI缺陷。更激进的观点认为,应设立AI协作作者(AI Co-Author) 类别,承认其智力贡献,但这面临版权法、责任法等法律障碍。

学术不端的新形态值得关注。AI可轻易生成大量"灌水"论文,甚至伪造数据。2025年初,某预印本平台发现300余篇论文共用相似的AI生成模板,实验数据呈现统计上不自然的模式,涉嫌批量造假。这要求学术期刊升级检测工具,不仅要查重文本,更要检查实验数据指纹(Experimental Data Fingerprint),识别AI生成的合成数据模式。另一方面,防御性科研诚信成为必需:研究者需保留AI生成过程的完整审计日志,证明其研究的诚实性。

监管框架的滞后是系统性风险。现行科研资助、学术评价、知识产权体系均基于人类中心假设。当AI能独立完成研究时,谁拥有AI生成发现的专利权?美国专利商标局2024年裁定AI不能作为发明人,但使用AI的人类可以,这暂时解决了问题,但未触及深层矛盾:若AI在公共数据集上发现新药物,该发现是否应开放共享?学术界呼吁建立 AI科研治理公约 ,明确数据溯源、成果共享、利益分配规则,但全球达成共识需时日。

5.3 未来演进:从自动化到自主科学发现

自动化科研的终极形态是AI科学家(AI Scientist):能自主提出假设、规划研究、执行实验、发表论文,甚至识别自身知识的边界并主动学习新领域。2025年的研究已现雏形:AgentLaboratory的元学习(Meta-Learning)能力使其在重复研究某个领域后,能提取研究模式(Research Pattern),如"材料发现通常需经历结构预测→性能模拟→实验验证三步",并在新项目中自动应用。这种研究经验内化使AI的科研能力随时间指数提升。

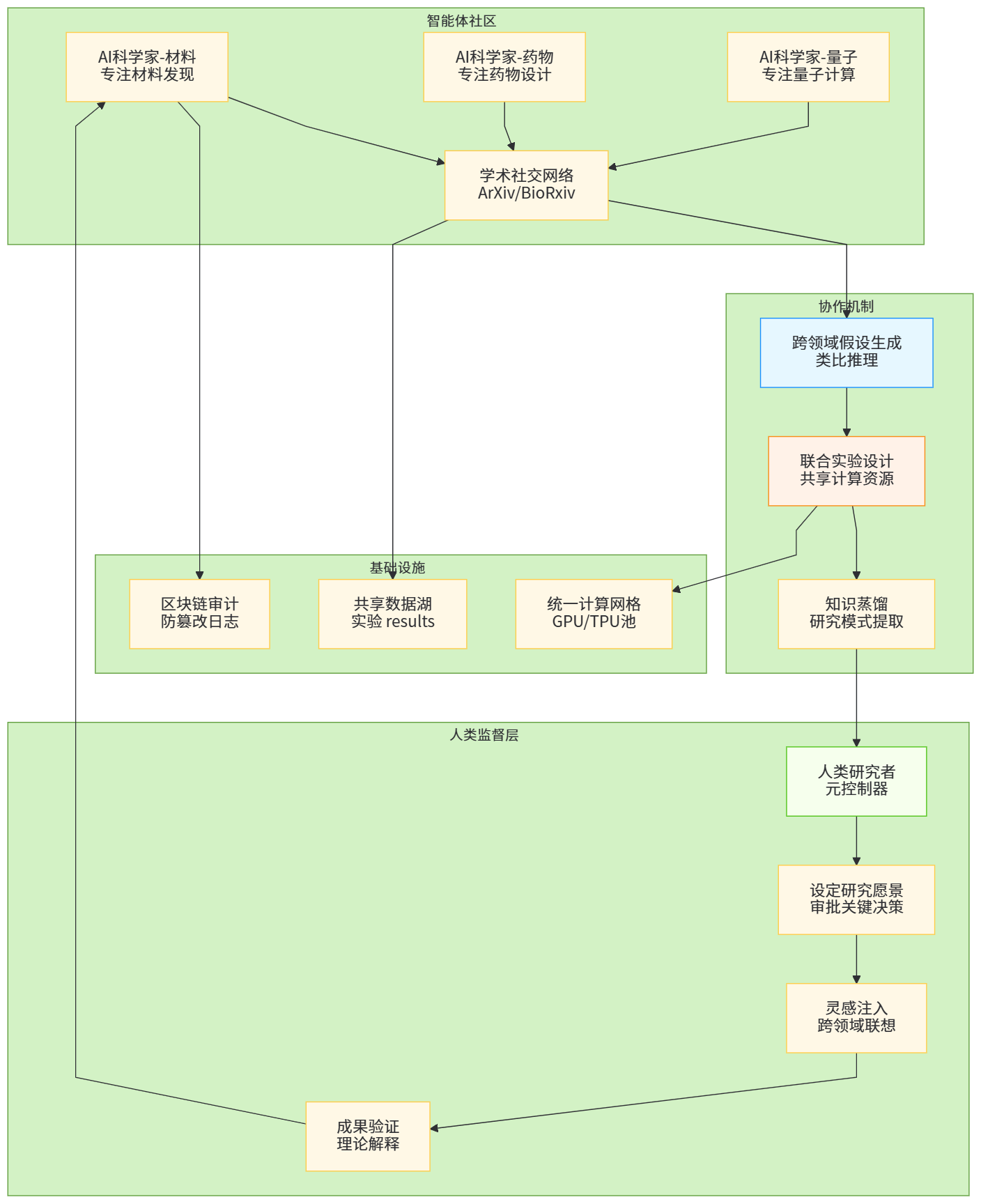

多智能体科学社区(Multi-Agent Science Community) 是另一前沿方向。数百个AI科学家智能体专注于不同领域,通过学术社交网络共享成果、互相评审、协作研究。当一个智能体在量子计算领域发现新算法,立即通知相关领域的智能体,共同探索交叉应用。这种集体智能可能超越任何单一人类团队,加速跨学科突破。但这也带来信息过载与噪声放大风险:低质量结果在社区中传播,误导其他智能体。需设计信誉机制:智能体的"学术声誉"基于其成果被人类验证的成功率,声誉低的建议被降权,形成质量过滤。

科学发现的新范式正在萌芽。传统科研强调可解释性与因果链条,AI可能发现不可解释的关联(如深度学习黑箱预测材料性能),这些关联虽缺乏理论解释,但预测精度极高。这引发"效用优先于理解"的新科学哲学:只要AI能可靠预测,其内部机制可暂时搁置。2025年DeepMind的Gnome系统通过AI发现220万种稳定晶体材料,其中大部分人类无法理解其稳定性来源,但实验验证了738种,远超人类历史总和。这种"AI直觉"驱动的发现,可能开启后人类科学时代,人类角色从发现者转变为验证者与解释者。

【图5:未来AI科学家自主提出假设并跨领域协作的生态系统构想】

结论:走向人机共生的科研新范式

自动化科研正在重塑科学发现的本质。本文系统论证了AI在代码生成、实验设计与论文写作三大环节的范式迁移:代码生成从文本预测进化为执行验证驱动的自主开发,实验设计从试错法升华为约束感知的智能探索,论文写作从模板填充提升为学术认知建模的创作过程。AgentLaboratory、AI Scientist等开源平台的出现,标志着自动化科研从概念验证迈向工业化应用。然而,技术突破伴随深刻挑战:模型幻觉威胁学术严谨性,可重复性危机考验科学根基,伦理争议拷问责任归属,领域适应性限制应用广度。

面对这些挑战,单一技术路径无法成功,需构建 "技术-规范-文化"三位一体的治理体系。技术上,发展神经符号混合架构提升可解释性,建立标准化日志保障可重复性;规范上,明确AI贡献声明、制定学术伦理准则、推动国际监管公约;文化上,培养研究者"AI素养",使其理解AI能力边界,掌握协同技巧,将AI视为"认知伙伴"而非"黑盒工具"。唯有如此,才能实现人机共生(Human-AI Symbiosis):AI处理文献阅读、代码实现、实验执行等"脏活累活",人类专注假设提出、灵感激发、理论建构等高阶创造。

展望未来,自动化科研不会取代科学家,而是 增强科学家 。当AI能承担80%的重复性劳动,人类研究者将拥有更多时间思考"大问题",开展高风险高回报的探索。科学发现的速率将不再受限于人类处理信息的带宽,而是受限于人类提出深刻问题的想象力。这正是自动化科研的终极价值:让机器负责效率,让人类守护创造力。在这场范式革命中,我们不仅是见证者,更是塑造者——塑造一个AI与人类智慧深度融合、相互成就的科学新纪元。

参考资料

哈尔滨工程大学. 人工智能大模型驱动的网络安全防御体系智能化演进路径. 网络空间安全科学学报, 2025. https://cccf.hrbeu.edu.cn/cn/article/pdf/preview/10.11991/cccf.202506006.pdf

博客园. AI的双刃剑:对抗性机器学习与AI驱动安全的攻防前沿. 2025-09-03. https://blog.youkuaiyun.com/m0_71322636/article/details/151156186

安全内参. AI大脑如何被"套路"?揭秘大模型提示词攻防. 2025-05-23. https://www.secrss.com/articles/79050

UK AI Security Institute. Countering Autonomous Cyber Threats: Assessing the Risks of Downloadable Offensive Agents. arXiv:2410.18312, 2024. https://arxiv.org/pdf/2410.18312

Zhu, H., et al. A Roadmap for Big Models: Perspectives on Reliability, Security, and Privacy. arXiv:2203.14101v1, 2022. https://arxiv.org/pdf/2203.14101v1

腾讯新闻. AI攻防新态势:大模型成漏洞挖掘"双刃剑". 2025-11-23. https://news.qq.com/rain/a/20251123A0251P00

娜璋AI安全之家. 基于大模型的威胁情报分析与知识图谱构建论文总结. 2025-06-04. http://mp.weixin.qq.com/s?__biz=Mzg5MTM5ODU2Mg==&mid=2247501812&idx=1&sn=e9a76f92ac90709cb30ad782df93aeb3

优快云. 如何利用大模型进行安全攻防:内附多个应用案例. 2024-06-27. https://www.bing.com/ck/a?!=&fclid=3478b0ae-1f48-6c63-2168-a4021e666d36&hsh=3&ntb=1&p=27a6561391e99309JmltdHM9MTcxOTQ2NjQwMCZpZ3VpZD0zNDc4YjBhZS0xZjQ4LTZjNjMtMjE2OC1hNDAyMWU2NjZkMzYmaW5zaWQ9NTIyNQ&ptn=3&u=a1aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3plbmd6aXppL2FydGljbGUvZGV0YWlscy8xMzc1MjAyODA&ver=2

爱代码爱编程. 如何利用大模型进行安全攻防:内附多个应用案例. 2024-04-10. https://icode.best/i/705400387519773

知乎专栏. 智能会话机器人:SaaS 平台的设计与思考. 2025-08-03. https://zhuanlan.zhihu.com/p/370538744

HYPERS. 如何构建一个高可用、高并发的AI智能客服系统?. 2025-05-30. https://www.hypers.com/content/archives/10208

腾讯云. 智能会话机器人:SaaS 平台的设计与思考. 2021-05-08. https://cloud.tencent.com/developer/news/821878

Google专利. 一种基于多租户的对话模型交互方法、装置及存储介质. CN116881429A, 2023-09-07. https://patents.google.com/patent/CN116881429A/zh

Google专利. 一种基于多租户的对话模型交互方法、装置及存储介质. CN116881429B, 2023-09-07. https://patents.google.com/patent/CN116881429B/zh

优快云博客. 智能对话引擎负载均衡设计:AI架构师的多实例部署与流量调度策略优化. 2025-08-09. https://blog.youkuaiyun.com/weixin_51960949/article/details/150108013

arXiv. 基于代码特征的代码生成方法综述. arXiv:2303.01056, 2023. https://arxiv.org/pdf/2303.01056

arXiv. 基于代码特征的代码生成方法综述. arXiv:2303.01056v1, 2023. https://arxiv.org/pdf/2303.01056v1

搜狐. AMD与约翰·霍普金斯大学开源AgentLaboratory,开启科研自动写作新纪元. 2025-02-12. https://www.sohu.com/a/858123344_121798711

优快云. 让AI写论文——全流程全自动的AI科学家:基于大模型提炼idea. 2024-08-15. https://blog.youkuaiyun.com/v_JULY_v/article/details/141229267

开元教育. AI Scientist: 作用、影响与未来发展趋势. 2024-08-25. https://kyedu.cc/?p=635

知乎. 如何评价Transformer作者公司Sakana AI推出AI Scientist成本仅15美元?. 2024-08-15. https://www.zhihu.com/question/664342601

搜狐. AI Scientist: 作用、影响与未来发展趋势. 2024-08-25. https://www.sohu.com/a/803540496_121355271

搜狐. AMD与约翰·霍普金斯大学联合开源一站式科研AI Agent:AgentLaboratory成科研新利器. 2025-02-12. https://www.sohu.com/a/858123409_121798711

xuexiaigc.com. AMD开源科研AI Agent,一站式自动写论文. 2025-02-12. https://www.xuexiaigc.com/aigcnews/AMD%E5%BC%80%E6%BA%90%E7%A7%91%E7%A0%94AI-Agent%EF%BC%8C%E4%B8%80%E7%AB%99%E5%BC%8F%E8%87%AA%E5%8A%A8%E5%86%99%E8%AE%BA%E6%96%87/

搜狐. AI Scientist: 作用、影响与未来发展趋势. 2025-07-31. https://www.sohu.com/a/803540496_121355271

OAPEN. Advancing Natural Language Processing in Educational Assessment. 2025. https://library.oapen.org/bitstream/id/ea4054ca-a3f5-4307-a373-6f4d77d3e645/9781000904161.pdf

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?