在网络上查找了很多搭建本地知识库的deepseek环境,步骤都不够详细,经过多次测试,反复验证,整理了完整的Ollama加Cherry配置的本地知识库的deepseek环境,并使用成功。

Cherry建立本地知识库非常简单,所以推荐Cherry。

分享给大家,希望对你有指导意义。

——————————————————————————————————————————

1.安装ollama,下载特别慢

如果下载慢,可以点击如下地址:链接: https://pan.baidu.com/s/1J45Lr2JnEKzH5NpocItfXA 提取码: xej8 ,--来自百度网盘

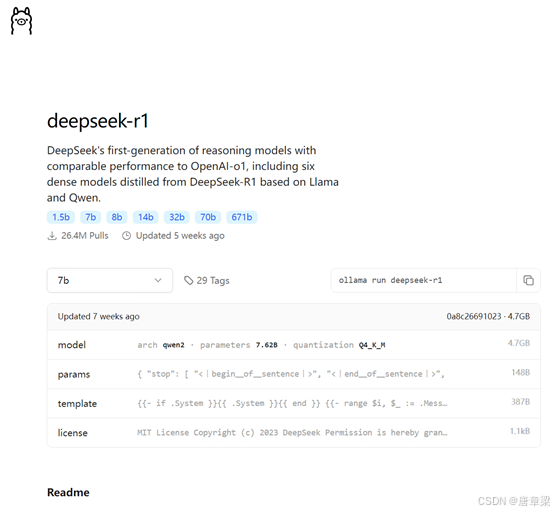

2.安装deepseek模型,建议选择14b以下的模型

本人选择了32b的,还能动,但是文字一个一个的蹦出来,实在感觉拖不动(电脑配置:CPU I7 13700HX/内存32GB/硬盘固态1Tb/4060RTX)

deepseek等模型选择

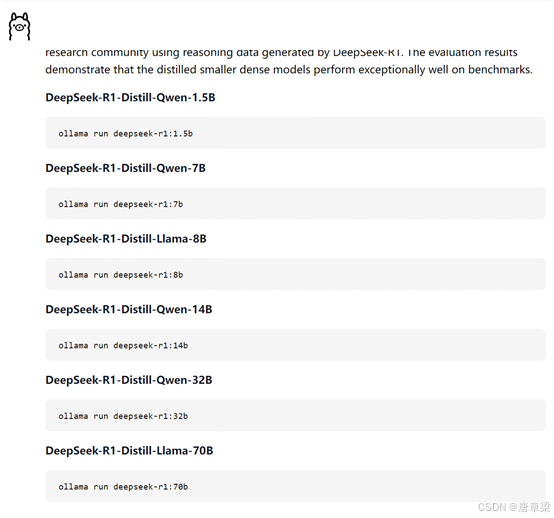

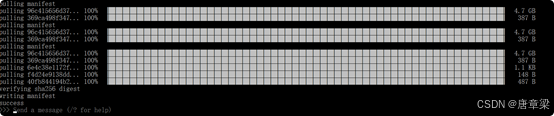

(1)参照下图选择不同的模型,复制执行命令到,命令窗口操作。

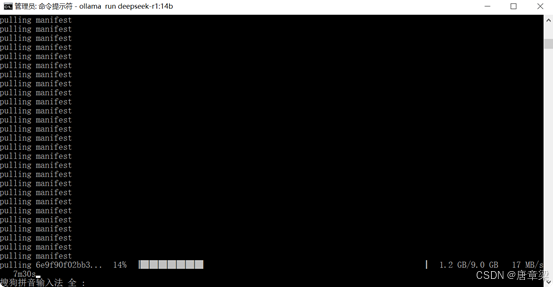

(2)CMD中,直接运行:ollama run deepseek-r1:7b

安装慢,需要等待较长时间,等安装完成,出现下图,可以对话的窗口,即显示安装完毕。

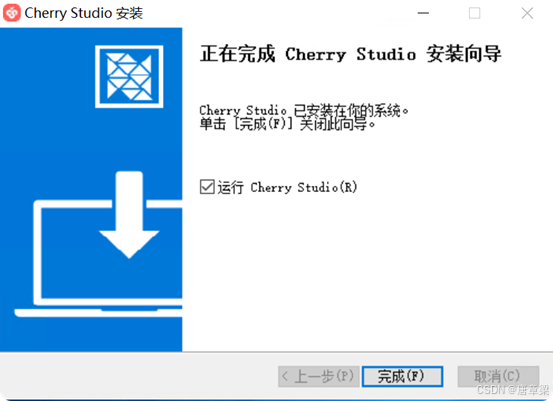

3.安装cherry

傻瓜式安装

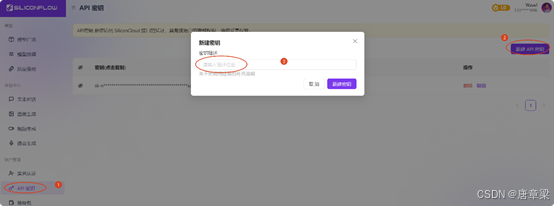

4.在硅基上申请API

硅基流动API【免费】

https://cloud.siliconflow.cn/models

(1)申请API,填入任意名字,即可生成

(2)复制API密钥;

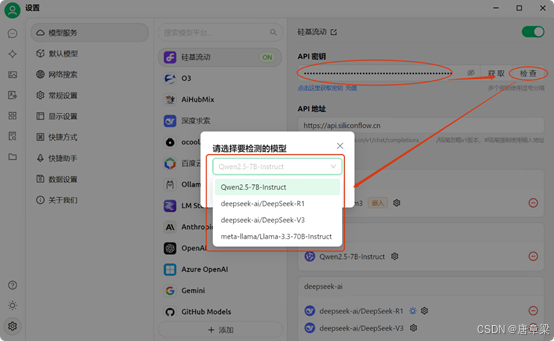

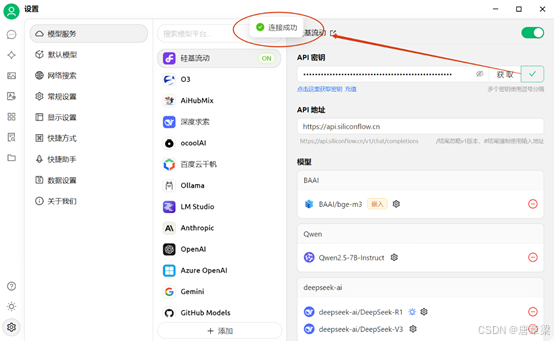

(3)填入api密钥,检查,并选择需要使用的模型;

(3)检查,连接成功。

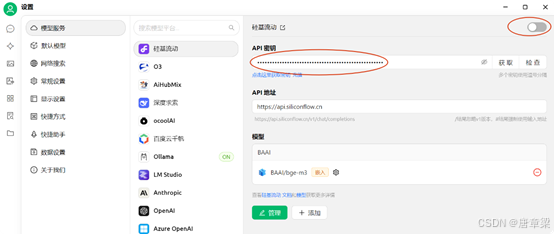

(4)关闭硅基链接【ON开关】

复制“密钥”,填在下图位置,在未添加完毕“本地知识库”前,不要关闭该开关,待添加完毕再关闭这个开关。

5.定义:本地知识库

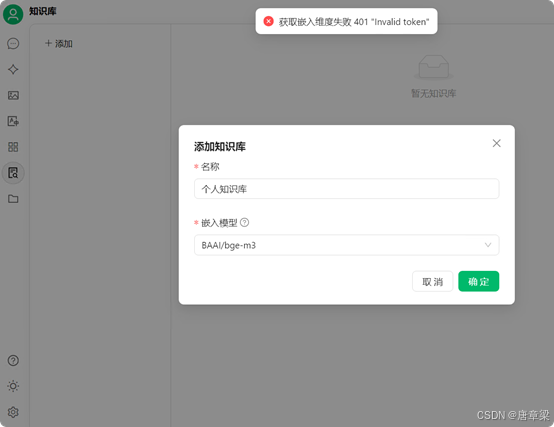

(1)本地知识库如果添加失败,或者看不到嵌入模型,一般是“硅基流动的API未添加”。

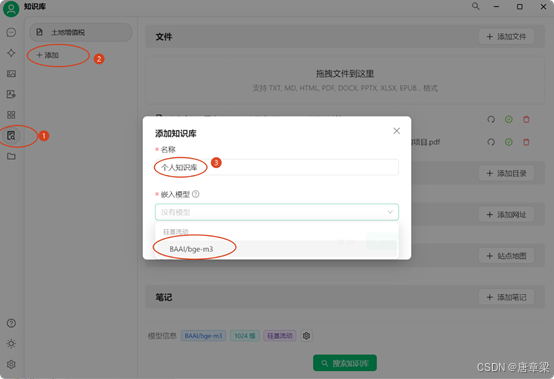

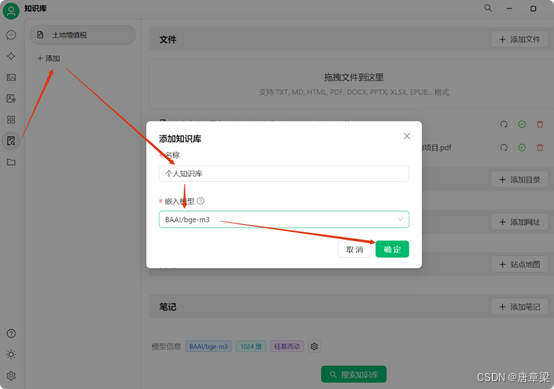

(2)进入知识库添加,界面

如果:硅基流动开关被关闭,这里选不到“嵌入模型”,如果选不到,先把“硅基流动”模型开关打开,选择完毕后,再关闭“硅基流动”的开关。

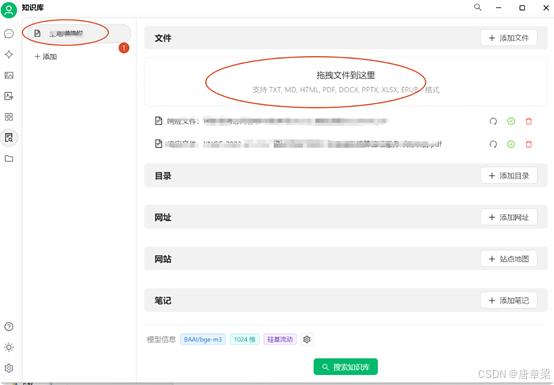

(3)添加“文档”,选中新建的知识库“文件夹名称”,在右边拖拽区域,将需要的文件拖进来,或者,“添加文件”增加进来。有些格式的文档系统不支持,选择添加时看不到,可以转换哈再添加。

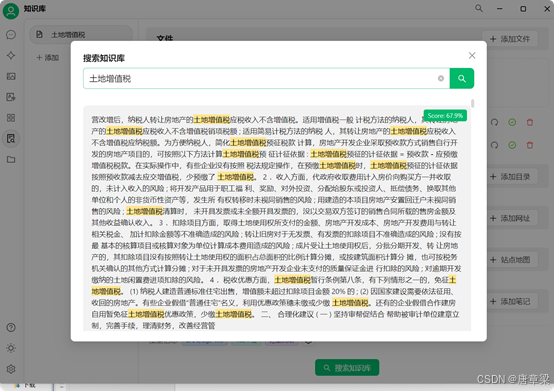

(4)测试本地知识库添加是否成功?输入知识库文档中有的特征词汇,即可检索到文档内容,这个标志着文档添加成功。

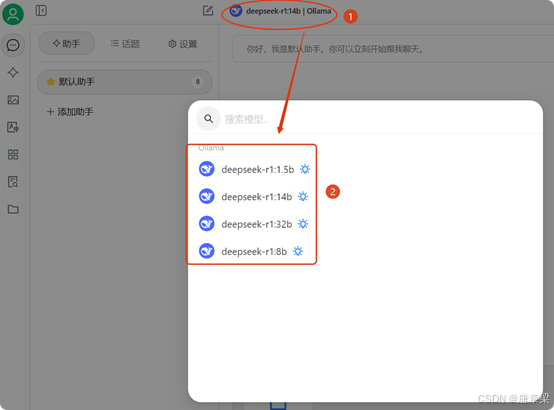

6.选择cherry模型

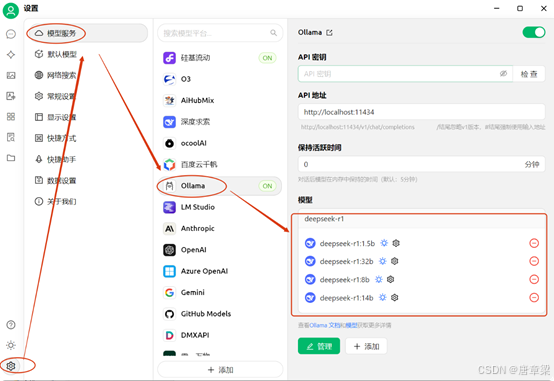

(1)选中:ollama——点管理——添加需要的模型,未添加的是有“+” 号的。

(2)可以添加多个,之后使用进行切换使用。未添加的后边有“加号”,已添加的是“-”。

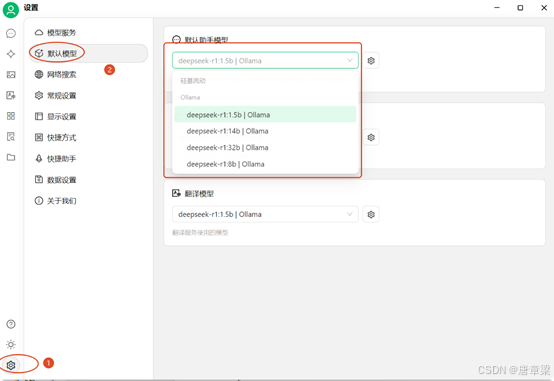

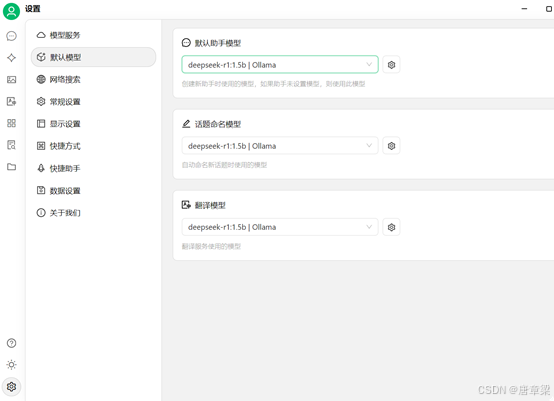

(3)设置默认模型:

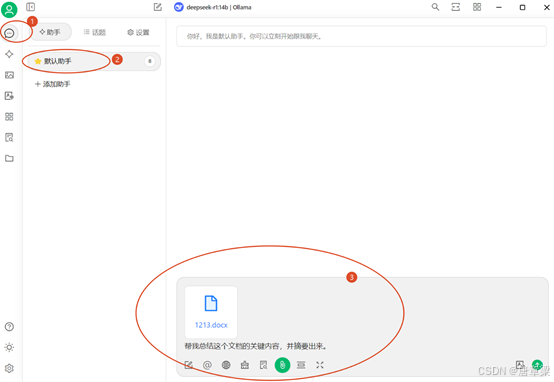

7.使用cherry,调用本地知识库,可以断开网络使用

可以选择不同模型

可以断开网络使用,将网络断开一样能用该模型说明全部安装配置正确。

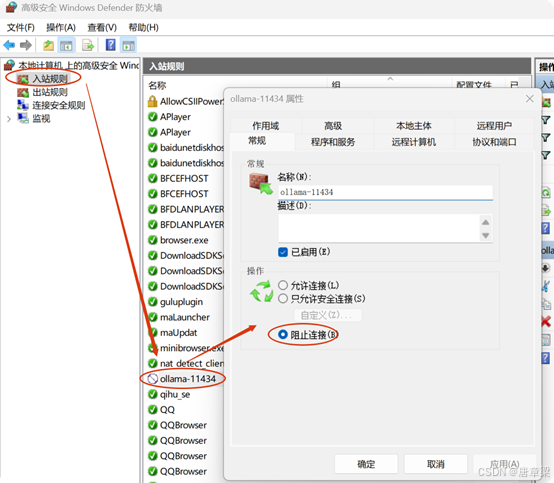

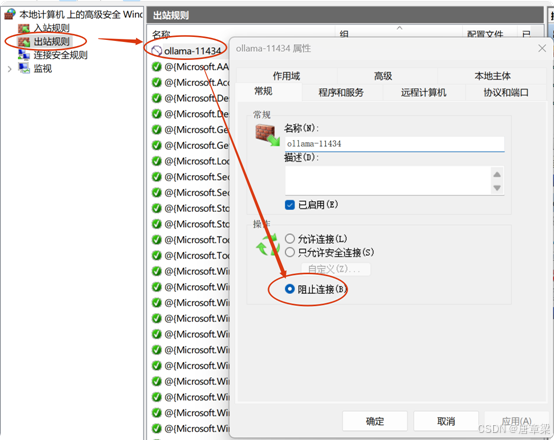

8.由于ollama已经被检测出11434端口有漏洞,因此建议,将防火墙的11434端口进出都禁用掉。【注意:下载完模型后再禁用,避免模型下不了。】

1524

1524

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?