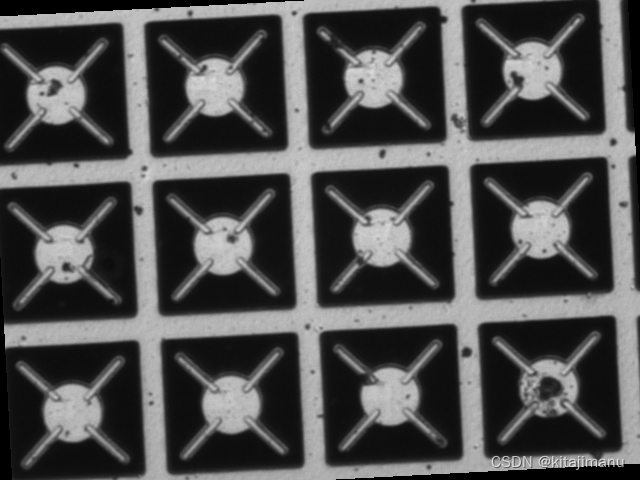

基于形状的模板匹配通常使用金字塔技术减少匹配时间,也就是从最顶层开始,提取出所有候选点,然后追溯至下一层对位置求精,依次反复,直到最底层。对于最顶层的候选点如何提取我们先看下面的例子。

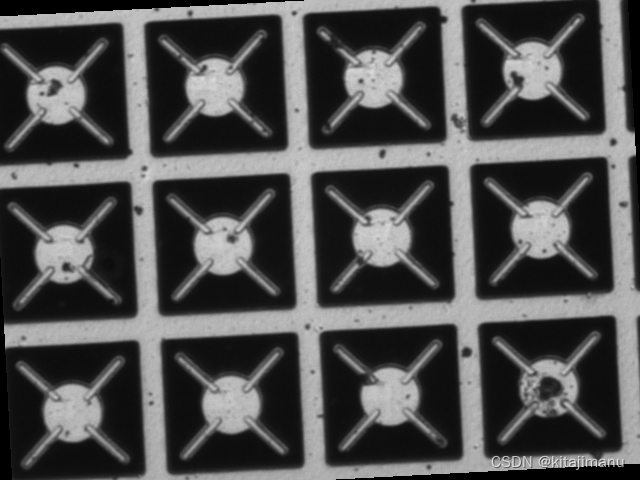

上面小图是模板图像,大图是待匹配图像,注意该模板是旋转对称的,每旋转90°都会原图案重合。首先在最顶层对所有角度进行匹配,结果如下:

由于太密集不太好看,我们截取其中的一个位置放大看一下,图中箭头起点(圆圈)表示匹配的位置,箭头终点的数字表示匹配分数,箭头方向表示匹配的角度,

基于形状的模板匹配采用金字塔技术降低匹配时间。在最顶层,通过匹配多个角度提取候选点,如0°、90°、180°、270°等。选择候选点时不仅要考虑最高分数,还需考虑不同角度的影响。具体做法是消除高分附近匹配,保留特定角度范围内的最优匹配。下层匹配结果显示,仅依赖最高分数可能不准确。后续将探讨圆形结构模板的候选点提取方法。

基于形状的模板匹配采用金字塔技术降低匹配时间。在最顶层,通过匹配多个角度提取候选点,如0°、90°、180°、270°等。选择候选点时不仅要考虑最高分数,还需考虑不同角度的影响。具体做法是消除高分附近匹配,保留特定角度范围内的最优匹配。下层匹配结果显示,仅依赖最高分数可能不准确。后续将探讨圆形结构模板的候选点提取方法。

基于形状的模板匹配通常使用金字塔技术减少匹配时间,也就是从最顶层开始,提取出所有候选点,然后追溯至下一层对位置求精,依次反复,直到最底层。对于最顶层的候选点如何提取我们先看下面的例子。

上面小图是模板图像,大图是待匹配图像,注意该模板是旋转对称的,每旋转90°都会原图案重合。首先在最顶层对所有角度进行匹配,结果如下:

由于太密集不太好看,我们截取其中的一个位置放大看一下,图中箭头起点(圆圈)表示匹配的位置,箭头终点的数字表示匹配分数,箭头方向表示匹配的角度,

1026

1026

9172

9172

3324

3324

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?