🚀 从 500 到 200:一次因“环境串扰”引发的微服务雪崩排查实录

嘿,各位奋斗在微服务一线的战友们!👋

你是否也曾遇到过这样的“灵异事件”:一套代码,昨天还好好的,今天突然就崩了?前端满屏飘红 500 Internal Server Error,后端日志却像谜语人一样,反复吟唱着 PrematureCloseException (连接过早关闭) 的魔咒?

别慌,你不是一个人在战斗!今天,我就要带大家复盘一次我亲身经历的、由 Nacos 环境串扰 引发的微服务“雪崩”事故,以及我们是如何一步步抽丝剥茧,最终让服务重获新生的。坐稳了,这趟排错之旅绝对干货满满!🎢

🚨 案发现场:一切从一个 500 错误开始

故事的开端平平无奇。我像往常一样,在我的 Mac 上启动了我们牛逼的“HX健康云”项目的所有微服务:网关 (hx-gateway)、认证中心 (hx-auth)、系统服务 (hx-system)… 一切看起来都那么祥和。

然而,当前端小伙伴打开登录页面,准备获取验证码时,灾难降临了:

Failed to load resource: the server responded with a status of 500

奇怪的是,不仅仅是登录接口,连最简单的获取验证码接口也崩了!这立刻让我警觉起来:问题可能出在一个非常基础的公共环节上。

🕵️♂️ 第一轮侦查:直击网关日志

作为所有请求的入口,网关 (hx-gateway) 的日志是我们的首要调查对象。果不其然,在茫茫日志海中,我发现了那个熟悉的魔鬼:

ERROR ... PrematureCloseException: Connection prematurely closed BEFORE response

翻译成人话就是:网关老哥给后端服务小弟(比如 hx-auth)打了个电话,说“有活儿!”,结果还没等小弟回话,电话线就断了。

这通常意味着后端服务小弟要么没上班(没启动),要么接电话的时候直接“猝死”了(崩溃了)。

🕵️♂️ 第二轮侦查:深入后端服务

我立刻把目光投向了认证服务 (hx-auth)。但奇怪的是,它的启动日志显示一切正常:

✅ 成功连接 Nacos (Naming and Configuration Service, 命名与配置服务)!

✅ 成功在 8001 端口启动!

✅ 打印出了 HX Health Cloud Auth 启动成功! 的胜利宣言!

难道是代码逻辑有问题?我检查了处理验证码和登录的 AdminAuthServiceImpl.java。这两个接口的共同点是,它们都需要操作 Redis (Remote Dictionary Server, 远程字典服务)。

初步推断:难道是 Redis 连接出了问题?

🕵️♂️ 第三轮侦查:基础设施大排查

我开始了一连串的基础设施“体检”:

-

检查 Redis 容器 🐳:

Portainer显示 Redis 服务已稳定运行 15 天。✅- 端口映射

6379:6379配置正确。✅ - 查看 Redis 日志,全是正常的持久化记录,没有任何报错。✅

-

检查网络连通性 🌐:

- 在我的 Mac 终端执行

nc -vz [公司服务器IP] 6379。 - 返回

succeeded!。✅ 网络是通的!

- 在我的 Mac 终端执行

-

检查配置 📝:

- 登录 Nacos 控制台,检查

redis.yml。 host,port,password都与我本地的配置一模一样。✅ 密码也是正确的!

- 登录 Nacos 控制台,检查

案情一度陷入僵局 🥶。网络通,服务在跑,配置正确… 到底是哪里出了问题?

💡 柳暗花明:网关日志里的“幽灵IP”

就在我百思不得其解时,我决定回头再仔细看看网关的启动日志。这一次,我发现了一个被忽略的致命细节:

# 网关从 Nacos 拉取 hx-auth 服务实例列表

INFO ... current ips:(2) service: DEFAULT_GROUP@@hx-auth -> [

{"ip":"192.168.31.142", "port":8001, ...}, // <-- 这是我本地Mac的IP (Internet Protocol, 互联网协议) 地址

{"ip":"172.19.0.7", "port":8001, ...} // <-- 这是个啥玩意儿?!👻

]

真相大白!

Nacos 的服务列表里,竟然有两个 hx-auth 实例!一个是我本地开发的,另一个 172.19.0.7 明显是 Docker 内部的 IP 地址。

我猛然想起——前几天为了给老板做演示,我在公司服务器上用 Docker Compose 启动过一整套服务!

问题的全貌瞬间清晰了:

- 一套 Nacos,两套环境:我的本地开发环境和老板的测试环境,共用了同一个 Nacos 的默认命名空间 (

public)。 - 注册表污染:两套环境的服务都往同一个“户口本”上登记,导致 Nacos 认为

hx-auth服务同时在两个地址上运行。 - 负载均衡“选择困难”:当我的本地网关想找

hx-auth时,Nacos 给了它两个选择。网关的负载均衡器(默认轮询)一会儿把请求发给我本地的服务,一会儿又发给那个它根本访问不了的 Docker 内部 IP。 - 连锁雪崩:

- 当请求被发往 Docker IP 时,连接超时 -> 网关报

PrematureCloseException。 - 当请求被发往我本地 IP 时,我本地的服务因为连不上 Redis(当时我还在怀疑是密码/防火墙问题)而崩溃 -> 网关同样报

PrematureCloseException。

- 当请求被发往 Docker IP 时,连接超时 -> 网关报

无论怎么走都是死路一条,最终导致了前端看到的持续性 500 错误。

🧐 深度剖析:为什么 IP 地址会不同?

这里引出了一个 Docker 网络和本地网络的基础知识点,非常值得探讨!

-

Docker 环境 (老板的测试环境) 🏢:

- 为什么 IP 不同? 因为每个 Docker 容器都是一个独立的虚拟“电脑”。为了让这些“电脑”能互相通信,Docker 的内部网络会给每一台都分配一个唯一的、不重复的内部 IP 地址(如

172.19.0.5,172.19.0.6…)。这就像一个公司里,每个员工的电脑都有不同的 IP 地址一样。

- 为什么 IP 不同? 因为每个 Docker 容器都是一个独立的虚拟“电脑”。为了让这些“电脑”能互相通信,Docker 的内部网络会给每一台都分配一个唯一的、不重复的内部 IP 地址(如

-

本地环境 (我的开发环境) 🏠:

- 为什么 IP 相同? 因为我所有的微服务都运行在 同一台物理“电脑” 上——我的 Mac。这台 Mac 在局域网中只有一个 IP 地址

192.168.31.142。 - 如何区分服务? 通过端口 (Port)。每个微服务进程都会监听一个不同的端口号(

8000,8001,8002…)。这就像一个家庭作坊里,虽然大家都在同一个地址,但每个人都有自己的内线分机号,这样才能准确地找到人。

- 为什么 IP 相同? 因为我所有的微服务都运行在 同一台物理“电脑” 上——我的 Mac。这台 Mac 在局域网中只有一个 IP 地址

一张图看懂区别:

| 环境 | 运行方式 | IP 地址 | 端口 | 比喻 |

|---|---|---|---|---|

| Docker | 多个隔离的容器 | 各自不同 | 可以相同或不同 | 🏢 公司里多个员工,每人一台电脑 |

| 本地 | 同一主机上的多个进程 | 全部相同 | 必须不同 | 🏠 一个家里多个工人,共用一个地址 |

这个根本性的差异,正是导致 Nacos 注册表混乱,并最终引发问题的核心原因之一。

🛠️ 最终修复:Nacos 命名空间,YYDS!

找到了病根,治疗就简单了。我采用了 Nacos 官方推荐的最佳实践——使用命名空间 (Namespace) 进行环境隔离。

-

创建新家 🏡:

- 登录 Nacos 控制台 -> 命名空间 -> 新建命名空间。

- 我创建了一个名为

dev-dgq的命名空间,专门给我自己用。 - 复制下生成的那一长串 命名空间ID。

-

搬家 🚚:

- 在我本地所有微服务(

hx-gateway,hx-auth…)的bootstrap.yml文件中,添加namespace配置:spring: cloud: nacos: discovery: namespace: 粘贴你复制的ID config: namespace: 粘贴你复制的ID

- 在我本地所有微服务(

-

复制家具 🛋️:

- 将默认

public空间下的所有配置文件(redis.yml等),全部复制一份到新的dev-dgq空间下。

- 将默认

-

重启大法 ✨:

- 重启我本地的所有微服务。

奇迹发生了!

所有服务都顺利启动,并稳稳地注册到了 dev-dgq 这个干净、独立的新家中。老板的测试环境继续留在 public 空间。两个世界,互不打扰。

我再次打开前端页面,点击获取验证码…

验证码图片出现了!

验证码图片出现了!

输入账号密码,点击登录…

登录成功,跳转到了首页!

登录成功,跳转到了首页!

那一刻,世界终于清静了。😌

总结与反思

这次排错之旅告诉我们:

- 环境隔离至关重要:在团队协作中,绝对不要让开发、测试、生产环境共用同一个 Nacos 命名空间。使用 Namespace 是成本最低、效果最好的隔离方案。

- 理解网络模型:清楚地知道你的服务是运行在 Docker 容器里还是本地物理机上,以及它们的 IP 和端口行为有何不同,是排查微服务网络问题的基础。

- 日志是你的眼睛:仔细、反复地阅读日志,特别是那些看起来正常的

INFO(Information, 信息) 日志,往往隐藏着魔鬼般的细节。 - 大胆假设,小心求证:从网络、配置、代码到环境,系统性地提出假设,并用工具(

nc,telnet,redis-cli)去验证,是排错的不二法门。

希望我的这次“踩坑”经历能给正在微服务道路上探索的你带来一些启发。记住,每一个让你头疼的 Bug (程序缺陷),都是一次让你变得更强的机会!

Happy Coding! 💻

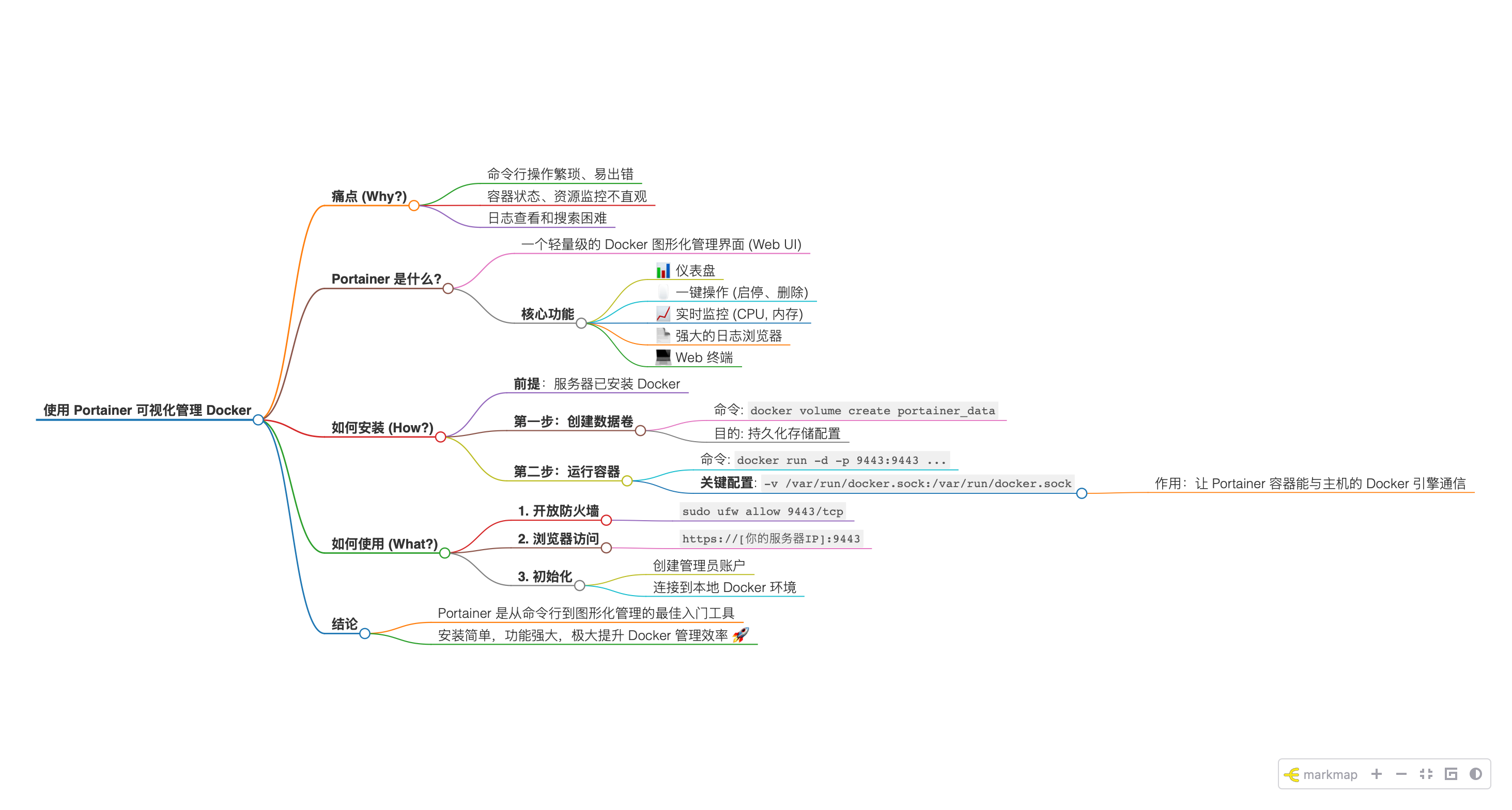

附录:图表与思维导图总结

📊 表格总结:排错关键点

| 步骤 | 现象 Symptoms | 工具/方法 Tools | 发现/结论 Findings |

|---|---|---|---|

| 1 | 😫 前端报 500 | 浏览器开发者工具 | 所有后端接口均失败 |

| 2 | 👻 网关报 PrematureCloseException | 查看网关日志 | 后端服务崩溃或网络不通 |

| 3 | 🤷♂️ 后端服务启动正常 | 查看 hx-auth 日志 | 排除服务自身启动问题 |

| 4 | ✅ 基础设施看似正常 | Portainer, nc, Nacos UI | Redis/网络/配置均无表面问题 |

| 5 | 💡 发现“幽灵IP” | 重读网关启动日志 | Nacos 注册表被 Docker 环境污染 |

| 6 | 🚀 解决问题 | Nacos 命名空间 | 实现开发/测试环境彻底隔离 |

🗺️ Mermaid 流程图:我的排错心路历程

🔄 Mermaid 时序图:环境串扰下的失败请求

🧩 更多 Mermaid 图表示例

状态图 (State Diagram): Nacos 中的服务实例状态

类图 (Class Diagram): 简化的服务发现关系

实体关系图 (Entity Relationship Diagram): Nacos 环境隔离模型

🧠 Markdown 思维导图:问题全景回顾

- 核心问题:微服务雪崩,前端全线500

- 表层症状

- 浏览器:所有后端接口请求均返回

500 Internal Server Error。 - 网关日志:反复出现

PrematureCloseException(连接过早关闭)。

- 浏览器:所有后端接口请求均返回

- 排错过程(一波三折)

- 怀疑1:后端服务崩溃

- 验证:查看

hx-auth日志。 - 结果:启动正常,排除。

- 验证:查看

- 怀疑2:基础设施问题 (Redis)

- 验证:

- 检查

Portainer中 Redis 容器状态、端口映射、日志。 - 使用

nc命令测试本地到服务器的网络连通性。 - 检查

Nacos上的redis.yml配置。

- 检查

- 结果:全部正常,陷入僵局。

- 验证:

- 突破口:重新审视日志

- 发现:

hx-gateway启动日志中,hx-auth服务名下竟有两个IP地址!- 一个是本地 Mac 的 IP (

192.168.x.x)。 - 另一个是 Docker 内部的 IP (

172.x.x.x)。

- 一个是本地 Mac 的 IP (

- 发现:

- 怀疑1:后端服务崩溃

- 根本原因:Nacos 环境串扰

- 背景:本地开发环境和服务器上的 Docker 测试环境,共用了同一个 Nacos 的

public命名空间。 - 后果:Nacos 注册表被污染,服务发现混乱,网关负载均衡时会错误地路由到无法访问的 Docker 内部 IP,导致连接失败。

- 背景:本地开发环境和服务器上的 Docker 测试环境,共用了同一个 Nacos 的

- 解决方案:环境隔离

- 最佳实践:使用 Nacos 命名空间 (Namespace)。

- 步骤:

- 在 Nacos UI (User Interface, 用户界面) 创建一个新的命名空间(如

dev-local)。 - 在本地所有微服务的

bootstrap.yml中配置新的namespaceID。 - 将所有配置文件从

public空间复制到新空间。 - 重启所有本地服务。

- 在 Nacos UI (User Interface, 用户界面) 创建一个新的命名空间(如

- 最终结果

- ✅ 本地开发环境与服务器测试环境彻底隔离。

- ✅ 服务注册和发现恢复正常。

- ✅ 问题解决,服务恢复

200 OK。

- 表层症状

155

155

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?