人工智能的发展正在迎来一个全新阶段:从被动响应到主动执行,从单一功能到协作网络。Agent(智能体)和MCP(Model Context Protocol,模型上下文协议)作为两项核心技术,正在重塑AI应用的基础架构。

本文将深入探讨Agent和MCP的底层实现原理、架构设计和开发框架。聚焦于技术细节、系统架构的设计考量,以及技术挑战。

通过本文将介绍:

-

Agent的核心架构模型和决策机制的底层实现

-

MCP协议的通信原理和安全机制

-

主流AI Agent框架的技术对比和性能分析

-

构建Agent系统的架构设计和案例

-

当前技术挑战的解决方案和前沿研究方向

Agent简介及框架概览

Agent优势包括提高生产力、降低成本、增强决策、提升用户体验。挑战如数据隐私、伦理问题、技术复杂性、资源需求。

当前流行的框架包括LangChain、LangGraph、CrewAI等,Analytics Vidhya的文章Top 7 Frameworks for Building AI Agents in 2025列出了七种框架,

https://www.analyticsvidhya.com/blog/2024/07/ai-agent-frameworks/

详见下表:

|

框架名称 |

关键焦点 |

优势 |

最适合场景 |

|---|---|---|---|

|

LangChain |

LLM驱动的应用 |

灵活性强,支持广泛外部集成 |

通用AI开发 |

|

LangGraph |

状态ful多Agent系统 |

处理复杂工作流,Agent协调 |

交互式、适应性强的应用 |

|

CrewAI |

角色扮演AI Agent |

模拟团队动态,协作解决问题 |

复杂组织任务模拟 |

|

MS Semantic Kernel |

企业AI集成 |

安全性、合规性,与现有系统集成 |

增强企业应用 |

|

MS AutoGen v0.4 |

多Agent对话系统 |

稳健性、模块化,对话管理 |

高级对话AI和任务自动化 |

|

Smolagents |

智能协作系统 |

轻量级、模块化、可定制 |

多样化AI应用和工作流 |

|

AutoGPT |

自主AI Agent |

灵活性、适应性学习,最小人工干预 |

自动化内容创建和任务管理 |

2. AI Agent的技术基础

2.1 Agent架构模型解析

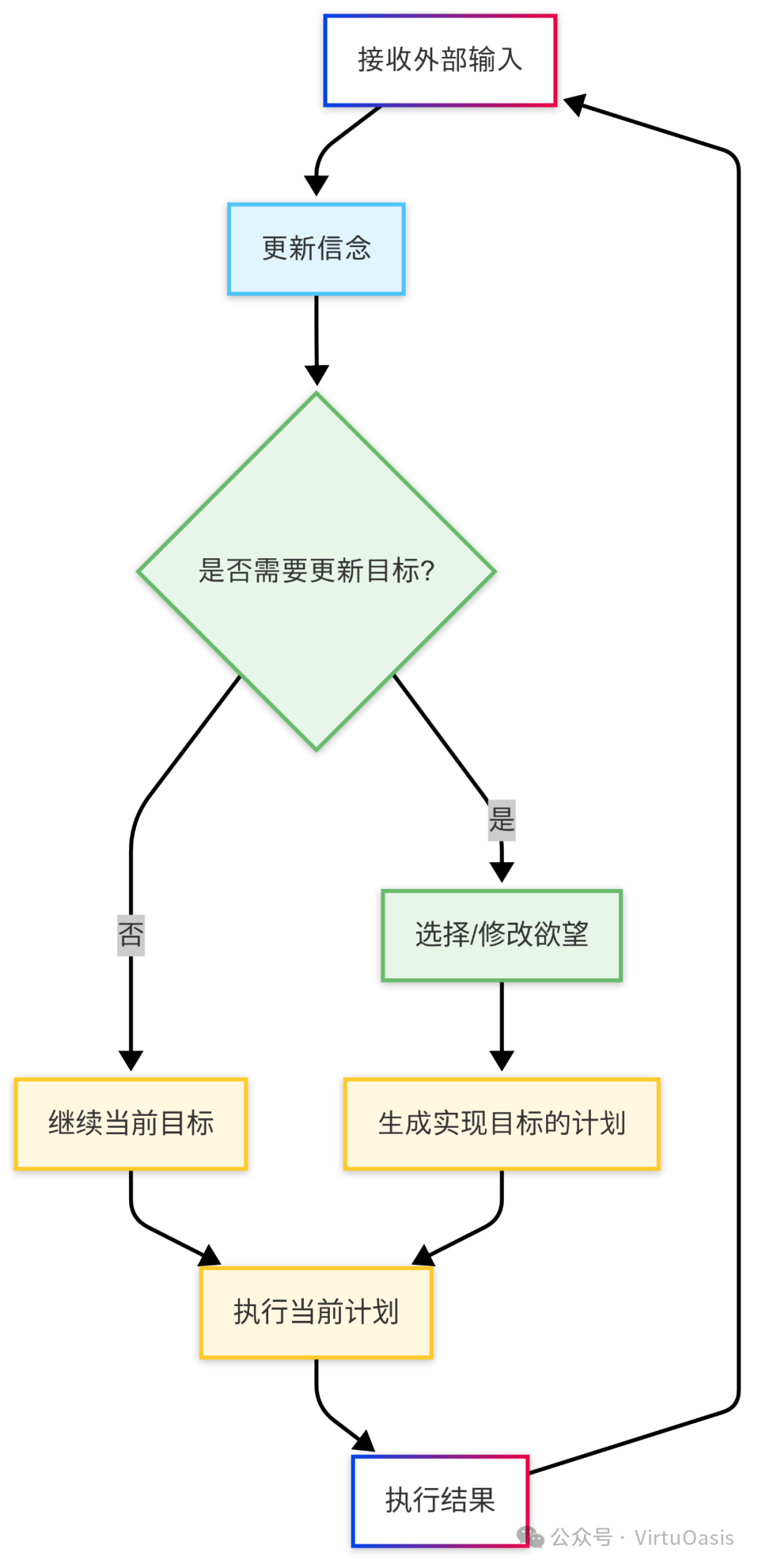

BDI (Belief-Desire-Intention)

BDI架构是AI Agent领域最具影响力的认知模型之一,它模拟了人类决策过程中的信念(Belief)、欲望(Desire)和意图(Intention)三个核心元素:

- 信念(Belief)

:Agent对环境状态的表示,相当于其知识库

- 欲望(Desire)

:Agent希望实现的目标或状态

- 意图(Intention)

:Agent当前选择执行的计划或行动

BDI模型的工作流程如下:

BDI架构的关键优势在于其明确的责任分离,使Agent决策过程更加透明且可解释。在现代AI Agent实现中,BDI常用于需要复杂推理和长期规划的场景,如虚拟助手、智能客服和自动化工作流。

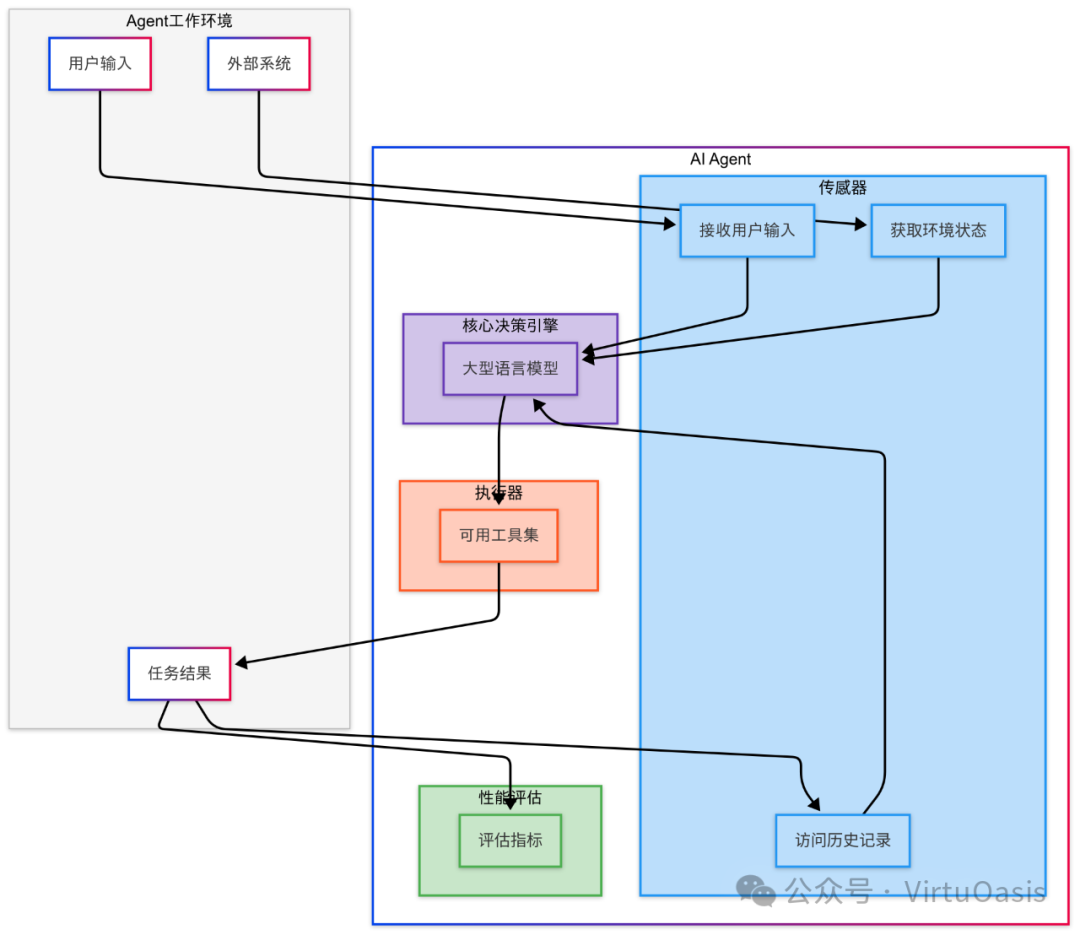

PEAS (Performance, Environment, Actuators, Sensors)

PEAS框架提供了一种系统化定义Agent的方法,通过明确:

- Performance(性能度量)

:评估Agent成功程度的标准

- Environment(环境)

:Agent操作的外部世界

- Actuators(执行器)

:Agent可执行的动作

- Sensors(传感器)

:Agent获取环境信息的渠道

PEAS框架在LLM驱动的Agent中的实现流程:

PEAS框架的价值在于它提供了设计和评估Agent的系统化方法,确保开发者明确定义Agent的目标、操作环境和交互方式。在企业应用中,PEAS特别适用于需要明确成功指标和系统边界的场景。

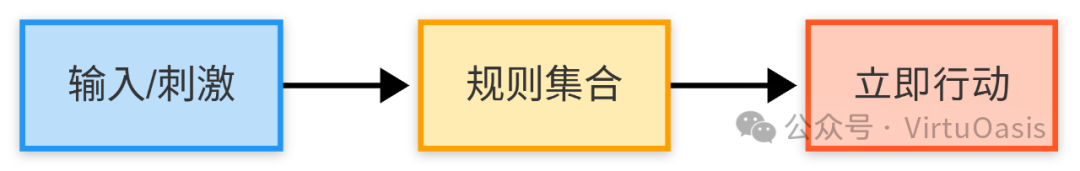

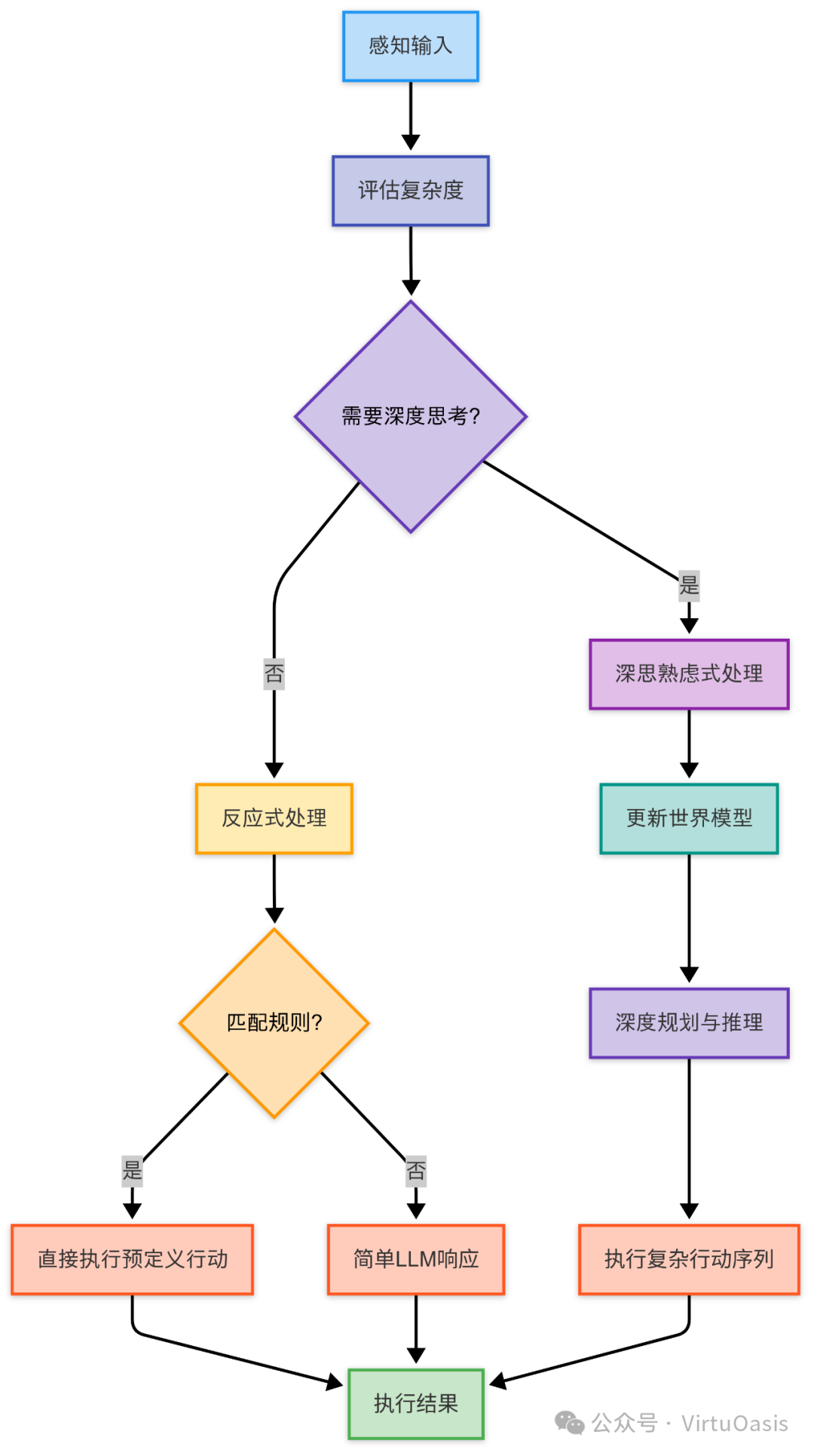

Reactive vs. Deliberative vs. Hybrid架构对比

Agent架构可以基于决策方式进行分类:

1. 反应式(Reactive)架构

反应式Agent直接将感知映射到行动,不维持内部状态,类似于刺激-响应模式:

优势:响应快速、简单高效、实现简单劣势:难以处理需要历史信息的任务,缺乏长期规划能力

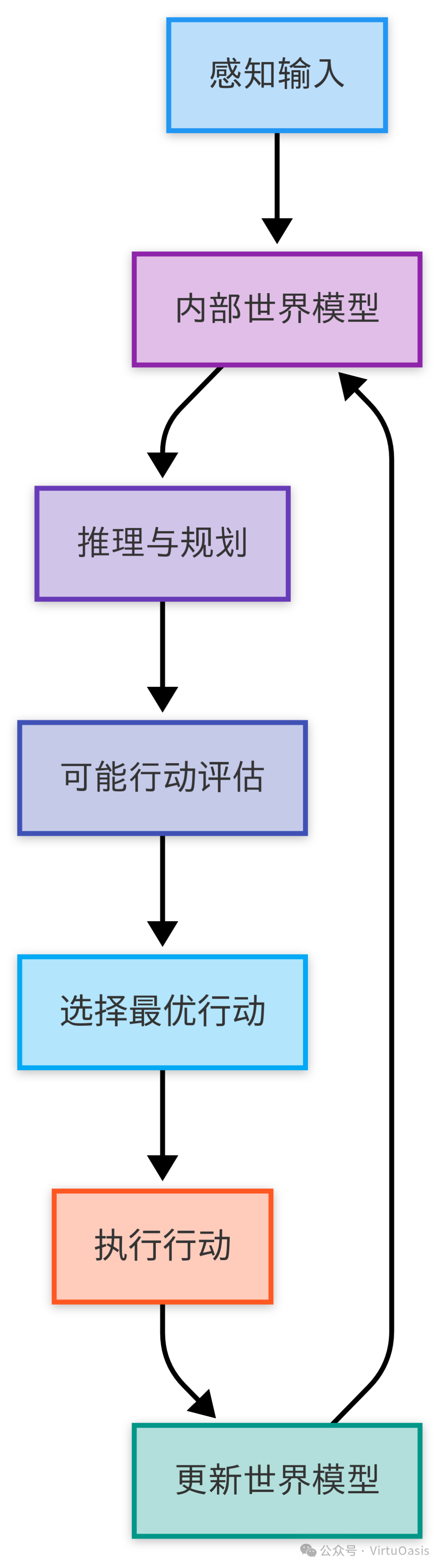

2. 深思熟虑式(Deliberative)架构

深思熟虑式Agent维护环境的内部模型,进行规划并在内部推演行动序列的结果:

优势:能够处理复杂任务,有长期规划能力

劣势:计算成本高,响应较慢,对环境模型准确度要求高

3. 混合(Hybrid)架构

现代AI Agent多采用混合架构,结合反应式和深思熟虑式方法的优点:

优势:兼顾响应速度和复杂任务处理能力,资源使用更高效

劣势:实现复杂度高,需要精心设计决策流程转换机制

在实际应用中,目前主流框架如LangChain、AutoGen等多采用混合架构,根据任务复杂度动态调整决策深度。随着任务复杂度增加,Agent会转向更深层次的推理和规划。

2.2 Agent决策机制

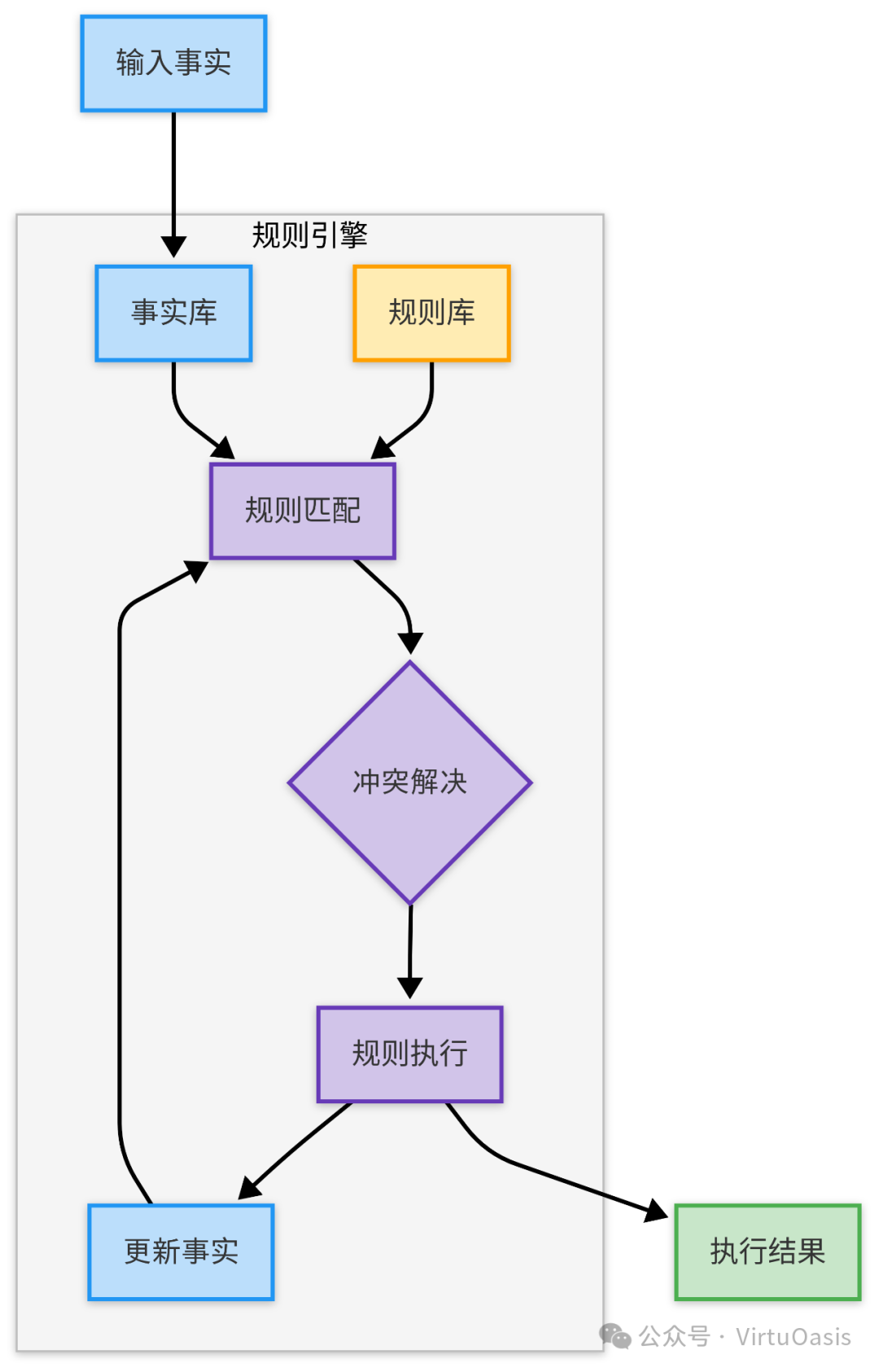

规则引擎与符号逻辑

早期Agent系统广泛采用基于规则的决策机制,这种方法在特定领域知识明确的场景下仍然有效。规则引擎通常由以下组件组成:

-

规则库(知识库)

-

推理引擎

-

工作内存

规则引擎基本工作流程:

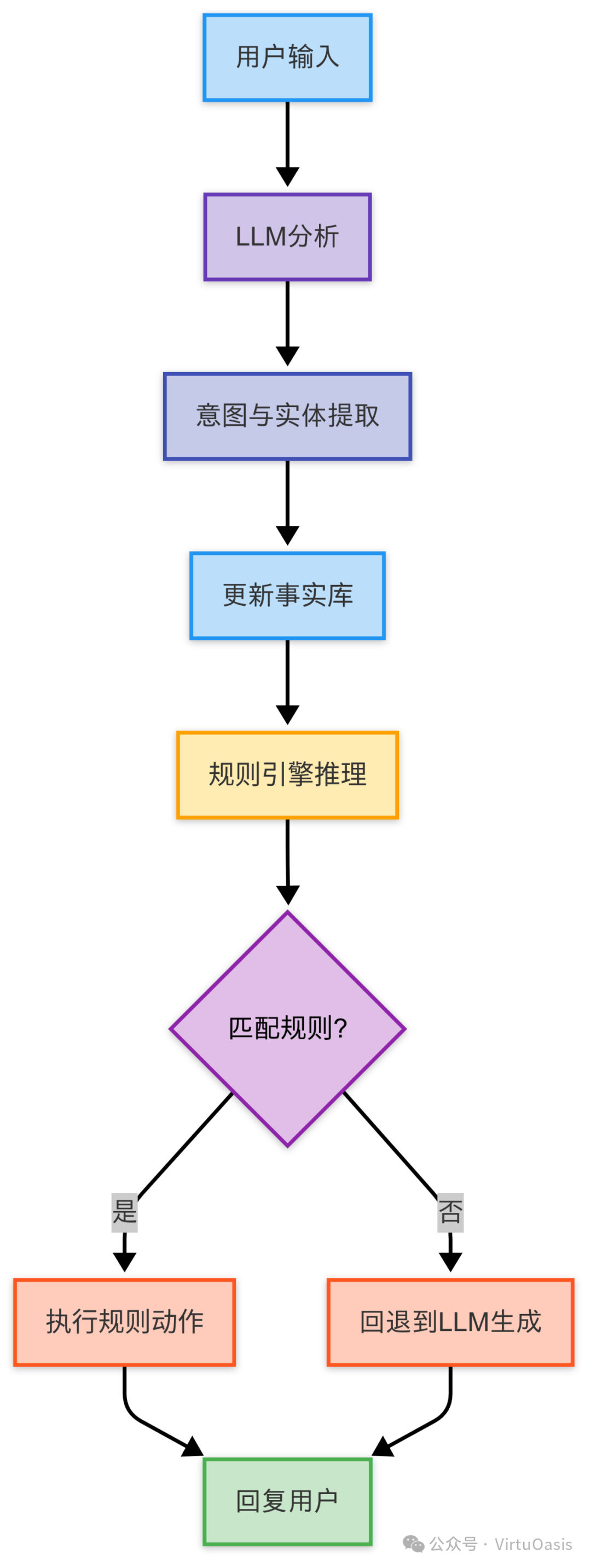

在现代LLM驱动的Agent中,规则引擎通常与LLM能力结合,创建混合推理系统:

规则引擎在需要确定性行为的场景(如合规检查、数据验证、流程自动化)中仍然是重要工具,可以与LLM驱动的Agent结合,提供更可控的行为保障。

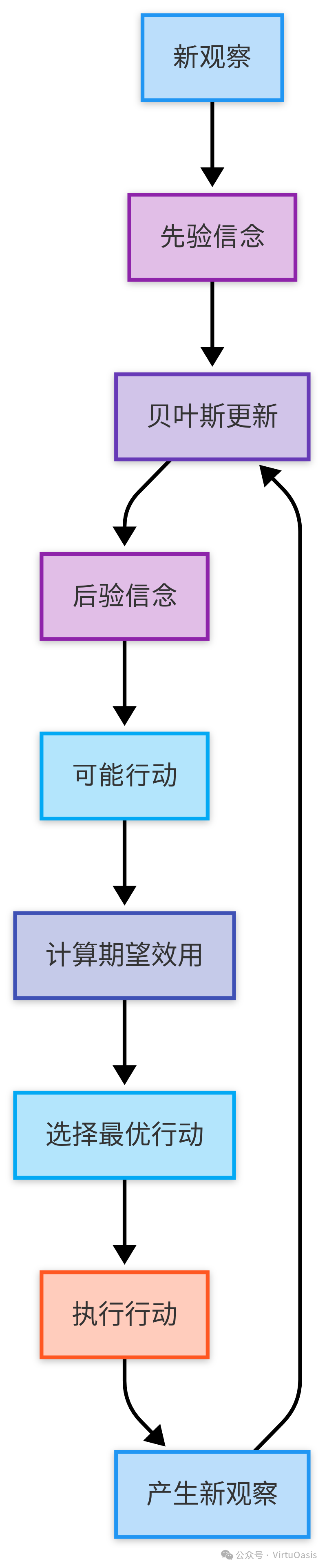

统计推理与概率模型

随着机器学习的发展,基于统计和概率模型的决策机制被广泛应用于Agent系统,特别是在处理不确定性时。这类决策通常基于:

-

贝叶斯网络

-

马尔可夫决策过程

-

概率规划模型

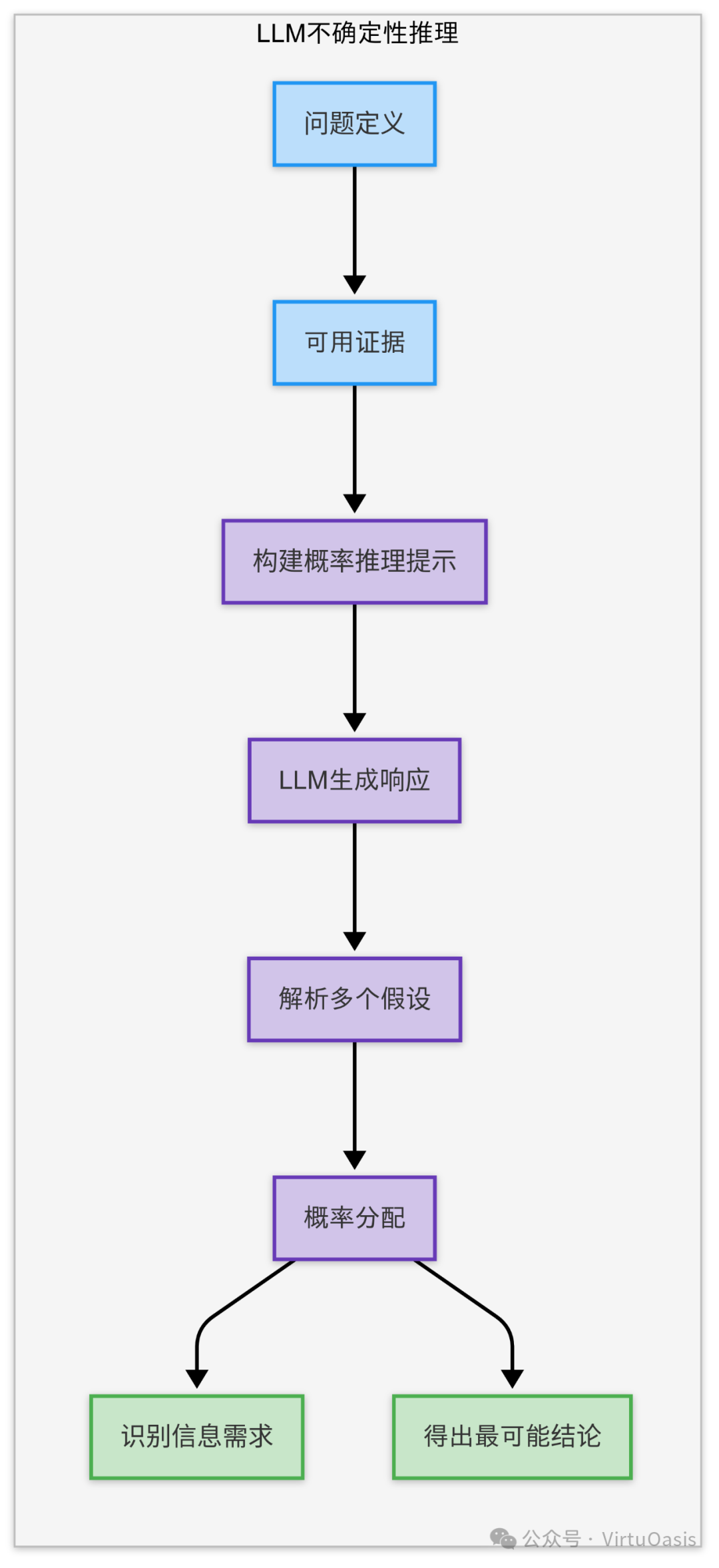

贝叶斯Agent决策流程:

在LLM驱动的Agent中,可以通过提示工程引导模型进行概率思考,处理不确定性:

这种方法让LLM在不确定性条件下进行结构化推理,为Agent决策提供概率框架。在实际应用中,这对处理模糊查询、风险评估和优先级确定特别有价值。

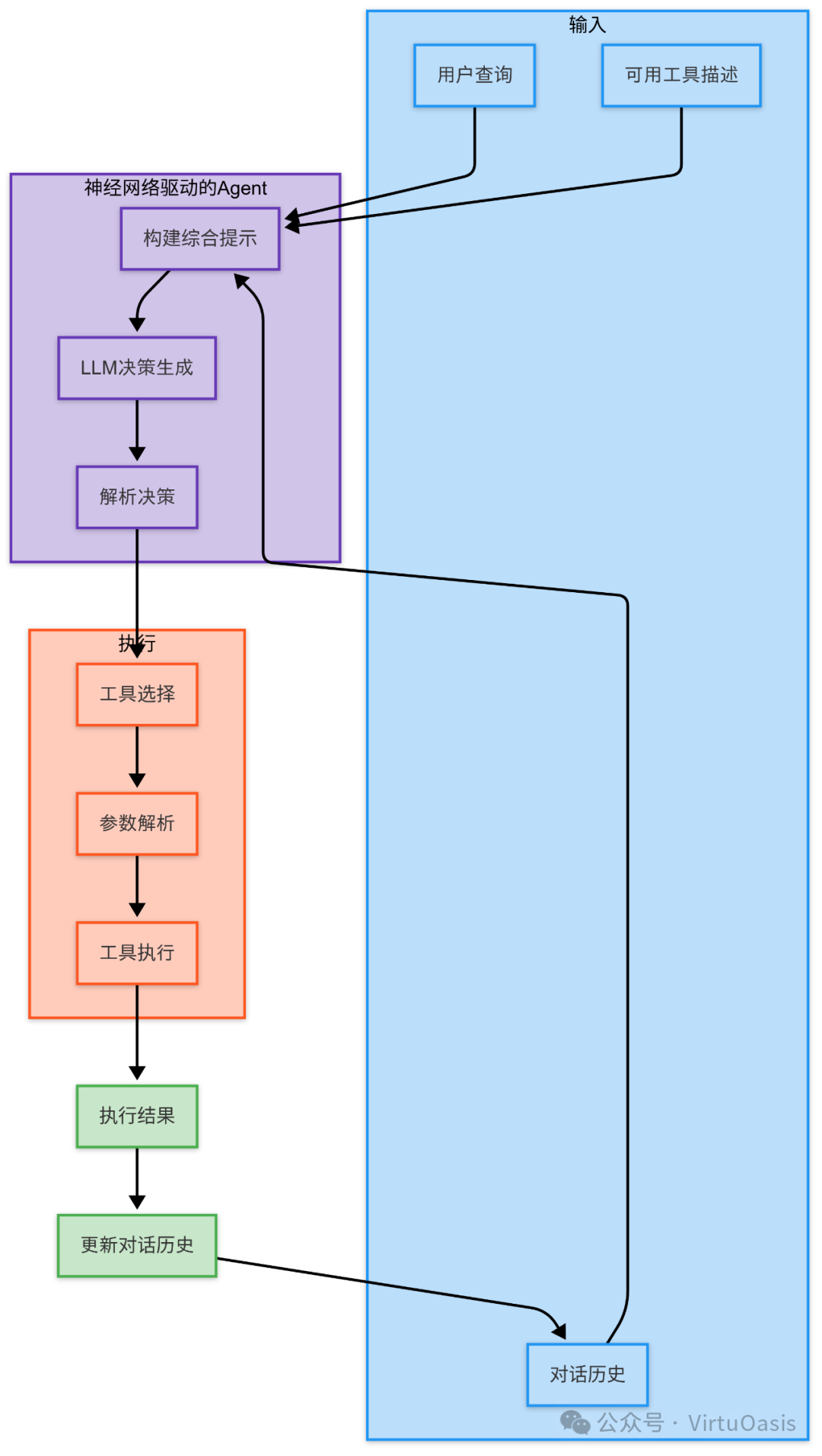

神经网络与深度学习决策

大型语言模型(LLM)的核心是基于Transformer架构的神经网络,为现代AI Agent提供了强大的推理和决策能力。LLM驱动的Agent工作流程:

当前LLM的强大之处在于它们能够从文本指令中学习并执行复杂任务,同时具备上下文理解和推理能力。这使得基于LLM的Agent能够处理各种各样的任务,从简单的信息检索到复杂的问题解决。

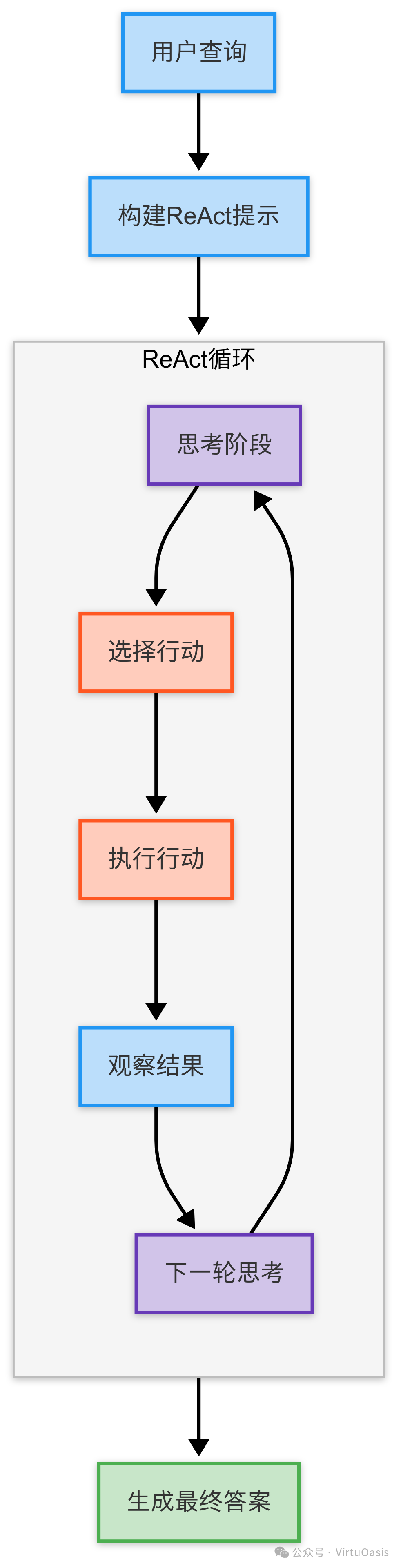

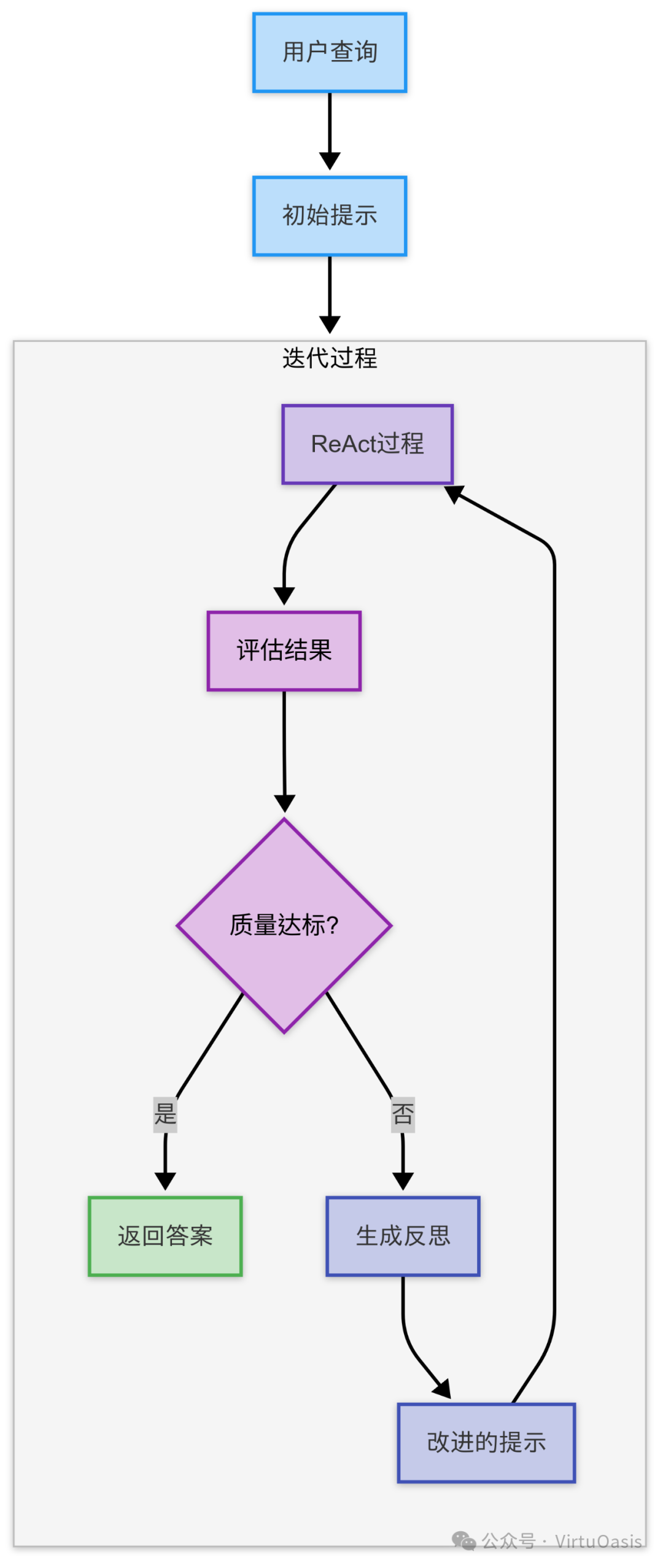

2.2.4 ReAct、Reflexion等思维框架解析

为了提升LLM驱动的Agent的推理能力,研究者开发了多种思维框架,其中最著名的是ReAct(Reasoning+Acting)和Reflexion。

ReAct框架流程:

Reflexion框架流程,在ReAct基础上增加反思机制:

这些思维框架显著提升了LLM Agent的问题解决能力,特别是在复杂推理和多步骤任务中。

实际应用表明,使用ReAct和Reflexion等框架的Agent在需要逻辑推理、事实查证和多步骤规划的任务中表现明显优于简单的提示工程。

除了这些框架,还有几种值得关注的思维增强技术:

- Chain-of-Thought (CoT)

引导模型展示思考过程

- Tree of Thoughts (ToT)

探索多个推理路径

- Self-Consistency

生成多个解决方案并选择最一致的

- Tool-augmented CoT

结合外部工具的思维链

这些技术组合使用时,可以构建出具有强大推理能力的Agent系统,能够处理从日常查询到专业领域问题的各种任务。

3. MCP技术详解

Anthropic的文章Introducing the Model Context Protocol

https://www.anthropic.com/news/model-context-protocol

Introducing the Model Context Protocol

Get started with the Model Context Protocol (MCP)

https://modelcontextprotocol.io/introduction

MCP(模型上下文协议)是2024年11月25日发布的开放标准,旨在连接AI助手与数据所在的系统,包括内容库、业务工具和开发环境。其目标是帮助前沿模型产生更相关、更优质的响应。文章提到,MCP解决了AI模型与数据源隔离的问题,传统方法需要为每个数据源定制实现,难以扩展,而MCP提供了一个统一的协议。

MCP允许AI代理通过服务器连接到外部数据源和工具,如搜索API、GitHub仓库或数据库。要使用MCP服务器(如通过Docker或NPX),首先需要选择合适的服务器并运行它。配置AI代理包括设置MCP客户端,加载服务器提供的工具,并将其转换为LLM可调用的函数。系统提示需明确告知LLM如何使用这些工具。最后,创建交互循环,让AI代理根据用户输入决定是否调用工具,并生成响应。

与传统API或RAG(检索增强生成)相比,MCP更高效。API需要为每个工具单独开发接口,而RAG需预先嵌入数据,计算资源密集。MCP支持的公司包括OpenAI和Anthropic,GitHub上有300多个开源服务器,显示其广泛采用。

MCP Server 使用流程

- 选择服务器

根据需求选择合适的MCP服务器。

- 运行服务器

使用Docker或NPX启动,设置必要凭证。

- 配置客户端

通过

StdioServerParameters指定启动命令,连接MCP客户端。 - 加载工具

使用MCP客户端获取服务器提供的工具。

- 工具转换

将工具转换为LLM可调用的函数(如JSON Schema)。

- 系统提示

在提示中明确工具用途,指导LLM使用。

- 交互实现

创建循环处理用户输入,允许工具调用。

MCP服务器案例分析

GitHub服务器

- 功能描述

允许AI代理与GitHub仓库交互,包括读取文件、创建问题等,需GitHub个人访问令牌。

- 使用场景

适用于代码审查、文档查找或自动化GitHub工作流。

- 使用步骤

-

登录GitHub,访问[[invalid url, do not cite])。

-

创建令牌,选择repo(私有仓库)或public_repo(公共仓库)范围。

- 获取个人访问令牌

- 运行服务器

-

Docker:docker run -i --rm -e GITHUB_PERSONAL_ACCESS_TOKEN=your_token mcp/githubNPX:npx -y @modelcontextprotocol/server-github,设置环境变量GITHUB_PERSONAL_ACCESS_TOKEN=your_token。

-

-

配置AI代理

-

server_params = StdioServerParameters(command="docker",args=["run", "-i", "--rm", "-e", "GITHUB_PERSONAL_ACCESS_TOKEN=your_token", "mcp/github"])mcp_client = Client(server_params)

-

加载工具并转换为LLM可调用的函数。

-

系统提示示例:

你是一个有帮助的助手,可以使用GitHub工具读取仓库文件或创建问题。

-

处理用户输入,允许LLM调用GitHub工具执行任务。

Google Maps服务器

提供基于Google Maps API的地理服务,例如位置搜索、路线规划和距离计算。工具包括`searchPlaces`、`getDirections`等。

使用场景:适合需要地理位置查询或导航的应用,例如旅行规划。

从零开始使用步骤:

1. 获取API密钥:

访问Google Cloud Console,创建项目。启用Google Maps API(Places API和Directions API)。生成API密钥(例如:`AIzaSyYourGoogleMapsAPIKey`)。

2. 运行服务器:

使用Docker:docker run -i --rm -e GOOGLE_MAPS_API_KEY=your_api_key mcp/google-maps或使用NPX:npx -y @modelcontextprotocol/server-google-maps

3. 配置AI代理:

- 安装Python的MCP库:- pip install mcp==1.1.2。- 设置MCP客户端:from mcp import StdioServerParameters, Clientserver_params = StdioServerParameters(command="docker",args=["run", "-i", "--rm", "-e", "GOOGLE_MAPS_API_KEY=your_api_key", "mcp/google-maps"])mcp_client = Client(server_params)tools = await mcp_client.get_available_tools()- 将工具转换为LLM可调用函数(例如JSON Schema格式)。- 设置系统提示:"你是一个助手,可以使用Google Maps工具搜索位置或规划路线。例如,使用searchPlaces查找地点,或getDirections计算路线。"

4. 测试交互:

- 用户输入:"从北京到上海怎么走?"

- AI代理通过`getDirections`工具调用Google Maps服务器,返回路线信息。

多MCP服务器集成案例- 团队旅行规划助手

一个团队需要规划一次从上海到杭州的出差旅行,AI代理需查找路线、记录偏好并通知团队。

- 目标

用户输入:"帮我们团队规划从上海到杭州的出差,记住我们喜欢高铁,并在Slack通知大家。"

- 实现步骤

1. 准备环境:

确保Docker或Node.js已安装。获取Google Maps API密钥和Slack Bot Token。

2. 运行多个MCP服务器:

Google Maps服务器:docker run -i --rm -e GOOGLE_MAPS_API_KEY=your_api_key mcp/google-mapsMemory服务器:docker run -i --rm mcp/memorySlack服务器:docker run -i --rm -e SLACK_BOT_TOKEN=your_slack_token mcp/slack

3. 配置AI代理:

设置多个MCP客户端:

from mcp import StdioServerParameters, Client# Google Maps客户端google_maps_params = StdioServerParameters(command="docker",args=["run", "-i", "--rm", "-e", "GOOGLE_MAPS_API_KEY=your_api_key", "mcp/google-maps"])google_maps_client = Client(google_maps_params)# Memory客户端memory_params = StdioServerParameters(command="docker",args=["run", "-i", "--rm", "mcp/memory"])memory_client = Client(memory_params)# Slack客户端slack_params = StdioServerParameters(command="docker",args=["run", "-i", "--rm", "-e", "SLACK_BOT_TOKEN=your_slack_token", "mcp/slack"])slack_client = Client(slack_params)# 获取所有工具google_tools = await google_maps_client.get_available_tools()memory_tools = await memory_client.get_available_tools()slack_tools = await slack_client.get_available_tools()all_tools = google_tools + memory_tools + slack_tools

将所有工具转换为LLM可调用函数。

设置系统提示:

你是一个团队旅行助手,可以使用Google Maps规划路线,Memory记住偏好,Slack发送通知。根据用户需求调用相应工具。

4. 交互流程:

- 用户输入:"帮我们团队规划从上海到杭州的出差,记住我们喜欢高铁,并在Slack通知大家。"- AI代理执行:1. 调用Google Maps的getDirections工具,查询上海到杭州的高铁路线(例如:G1234次列车,2小时)。2. 调用Memory的setKey工具,保存transport_preference: 高铁。3. 调用Slack的sendMessage工具,在#travel频道发送:"出差计划:上海到杭州,乘坐高铁G1234,约2小时。"- 返回给用户:"已规划从上海到杭州的高铁路线,耗时约2小时,已记住你们喜欢高铁,并在Slack通知团队。"

AI代理成功结合三个MCP服务器,完成了路线规划、偏好记录和团队通知,展示了多服务器协作的强大功能。

MCP服务器的定义和应用仍在快速发展中,2025年4月10日的当前阶段,社区已有超过1000个第三方服务器。

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

Agent与MCP技术原理及应用解析

Agent与MCP技术原理及应用解析

247

247

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?