目录

Step 5:从ModelScope下载GLM4-9b-chat模型权重

2.2 ModelScope 线上部署:零硬件门槛,免费算力可用

2.3 Ollama 框架部署:轻量高效,支持 Windows/Linux/Mac

2.4 vLLM 框架部署:高性能推理,吞吐量提升 24 倍

在国产大模型领域,阿里巴巴的 Qwen(通义千问)系列一直是标杆般的存在,凭借出色的性能长期稳居各大评测榜单前列。2024 年 9 月,阿里重磅推出 Qwen2.5 系列模型,不仅覆盖多参数规模与多任务场景,还在知识储备、代码能力、数学推理等核心维度实现全面升级。本文将从模型特性解析入手,手把手教你通过 ModelScope、Ollama、vLLM 等框架完成本地与线上部署,让你快速上手这款国产顶尖大模型。

一、Qwen2.5 模型:不止于 “升级” 的全方位突破

Qwen2.5 系列并非简单的版本迭代,而是构建了覆盖基础语言、代码、数学、多模态的完整模型体系,从参数规模到核心能力均实现跨越式提升,先通过核心信息快速了解它的 “硬实力”。

1.1 模型家族与参数规模

Qwen2.5 系列涵盖不同场景的专用模型,每种模型又提供多档参数选择,满足从移动端到企业级部署的多样化需求:

| 模型类型 | 参数规模 | 核心用途 |

|---|---|---|

| Qwen2.5(基础语言) | 0.5B、1.5B、3B、7B、14B、32B、72B | 自然语言理解、文本生成、多语言处理 |

| Qwen2.5-Coder(代码) | 1.5B、7B(32B ) | 代码生成、调试、编程语言理解 |

| Qwen2.5-Math(数学) | 1.5B、7B、72B | 数学推理、公式计算、科学问题求解 |

| Qwen2.5-VL(视觉语言) | 2B、7B、72B | 图文理解、跨模态生成 |

值得注意的是,本次 Qwen2.5 新增了3B 移动端模型和14B/32B 中等规模模型,其中 32B 版本性能甚至超越 Qwen2-72B,在 “性能 - 效率” 平衡上实现重大突破。

1.2 五大核心能力升级

相比 Qwen2 系列,Qwen2.5 的提升体现在每一个实用场景中,关键数据佐证其硬实力:

-

知识储备翻倍:预训练数据集从 7T tokens 扩展至 18T tokens,MMLU 基准测试中 72B 版本得分从 84.2 升至 86.1,覆盖 29 种语言,支持 128K 上下文长度(生成长文本达 8K tokens)。

-

代码能力跃升:Qwen2.5-72B-Instruct 在 LiveCodeBench 测试中得分从 32.2 升至 55.5,MBPP 得分从 80.2 升至 88.2,可高效生成 Python、Java 等多语言代码。

-

数学推理强化:整合链式推理(CoT)、程序推理(PoT)等方法,MATH 基准测试 72B 版本得分从 69.0 升至 83.1,甚至 1.5B 小模型也能与主流大模型竞争。

-

人类偏好对齐:Arena-Hard 测试得分从 48.1 飙升至 81.2,MT-Bench 得分从 9.12 升至 9.35,生成内容更符合人类表达习惯。

-

结构化数据适配:支持表格理解与 JSON 输出,指令跟随更精准,可自定义模型角色(如 “编程助手”“数学老师”)。

1.3 先体验再部署:线上快速测试

在正式部署前,可通过 Hugging Face Spaces 直接体验 Qwen2.5 的性能,无需配置环境:

二、部署实战:四大框架全流程指南

Qwen2.5 支持多种部署框架,不同框架适配不同场景(本地轻量部署、线上算力、高性能推理),以下为详细步骤,新手也能轻松跟随操作。

2.1 ModelScope 本地部署:适合开发者调试

ModelScope(魔搭社区)是阿里旗下的模型平台,提供便捷的本地化部署工具,步骤如下:

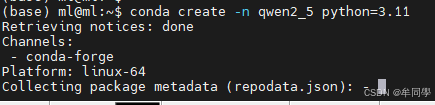

Step 1:创建 conda 虚拟环境

conda 可隔离依赖包,避免版本冲突,建议使用 Python 3.10+。(qwen2_5 是你想要给环境的名称, python=3.11 指定了要安装的 Python 版本。你可以根据需要选 择不同的名称或 Python 版本):

# 创建名为qwen2_5的环境,指定Python 3.11

conda create -n qwen2_5 python=3.11

# 激活环境

conda activate qwen2_5

# 查看所有环境(可选)

conda env list

#卸载环境,需要注意的是⽆法卸载当前激活的环境,建议卸载时先切换到base环境中再执⾏操作。

conda activate base

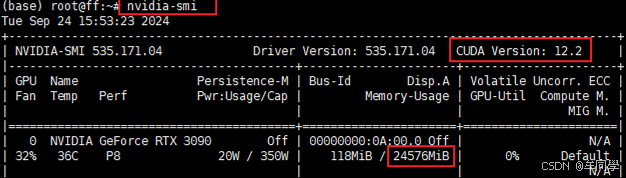

conda env remove --name qwen2_5Step 2:检查 CUDA 版本

需根据显卡支持的 CUDA 版本安装 PyTorch:

nvidia-smi # 查看CUDA版本(如输出12.2,需选择≤12.2的PyTorch)Step 3:安装 PyTorch 与依赖包

1、访问PyTorch 历史版本页

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

7528

7528

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?