原文链接:(更好排版、视频播放、社群交流、最新AI开源项目、AI工具分享都在这个公众号!)

1.1k Star!天工Skywork-13B:性能全面超越LLaMA2、0门槛商用、消费级显卡进行部署和推理!

🌟Skywork-13B-Base模型在3.2万亿个高质量多语言(主要是中文和英文)和代码数据上预训练,它在多种评测和各种基准测试上都展现了同等规模模型的最佳效果,包括Base、Chat、Math、MM模型及其量化版,支持用户在消费级显卡进行部署和推理。

Hello,大家好啊,我是Aitrainee,今天聊聊 国产开源大模型 :Skywork-13B。 去年 7 月,Meta 发布了

LLaMA2,以其强大的 性能和免费商用 的优势,迅速赢得了开发者和企业的喜爱。各个版本的 LLaMA2

微调成果不断涌现,让大模型领域的竞争局势快速变化。 很多人认为,这波开源攻势会削弱那些闭源大模型厂商的“ 护城河

”,让中小企业和开发者有了更经济实惠的选择。 不仅如此,国产大模型的开源力量也在加速追赶。然后,大模型开源仍面临 三大挑战 :

首先,中文数据的稀缺和珍贵使得训练高质量模型变得困难;其次,模型训练的细节往往不公开, 限制了

开发者对模型的深度理解和优化;最后,模型开源在商用方面面临诸多限制,使得企业在实际应用中遇到许多障碍。 而前不久,昆仑万维推出了 重磅开源项

** 目 ** :天工 Skywork-13B 系列。为什么说重磅呢?因为 Skywork-13B 在多个基准测试(如 C-Eval,MMLU)中

全面超越 了 LLaMA2-13B。 这次开源不仅包括 Skywork-13B-Base 模型、Skywork-13B-Math 模型,还有它们的

量化版模型 。更厉害的是,昆仑万维还开放了一个600GB、150B Tokens的 高质量中文语料数据集 「Skypile/Chinese-

Web-Text-150B」,而且 全面开放商用,开发者无需申请,零门槛 就能用上。

▲ Model Scope

一键直达:

• Skywork-13B 下载地址(Model Scope):https://modelscope.cn/organization/skywork• Skywork-13B 下载地址(Github):https://github.com/SkyworkAI/Skywork• 技术报告:https://arxiv.org/pdf/2310.19341.pdf

模型结构

Llama模型有三个主要特点:首先,它使用RMSNorm代替传统的Layernorm,以保持训练的 稳定性

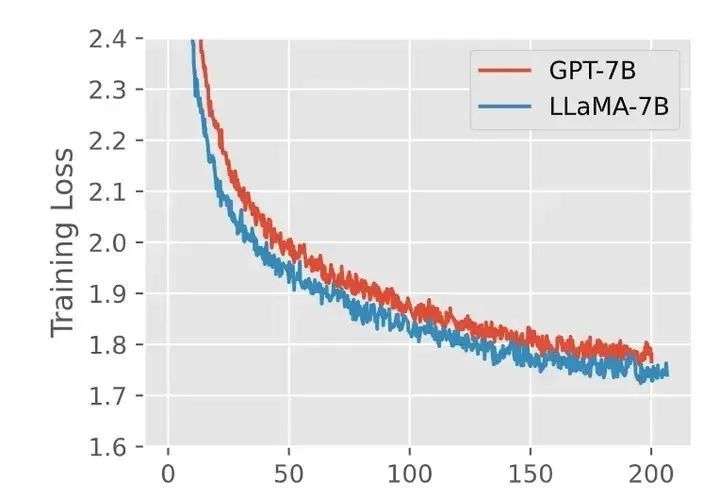

;其次,它使用SwiGLU激活函数而不是传统的ReLU;最后,它使用相对位置编码(RoPE等)而不是传统的绝对位置编码。实验结果表明,与GPT模型相比,

Llama模型不仅训练得更快,而且效果也更好。

▲ GPT-3结构和Llama结构训练对比(摘自知乎盐海)

下面对相关名词作通俗化的解释:

** 相对位置编码 ** (Rotary Position Embedding):这是一种用于编码输入序列中位置信息的方法。

想象一下,你在看一本书,每页的页码告诉你这个字在哪里。RoPE就像在模型里给每个字加了页码,让它知道每个字在什么位置。

** 均方根归一化 ** (Root Mean Square Normalization):这是一种归一化技术,用于调整神经网络层的输出。

想象你在做一道菜,所有的配料都需要精确的分量。RMSNorm就像一个称重工具,确保每个步骤的配料量都准确无误,这样菜品才会美味。

** SwiGLU(一种激活函数) ** : 结合了Swish和Gated Linear Units (GLU) 的特点。

想象你有一个聪明的开关,它能决定什么时候打开、什么时候关闭,以确保电流流动最有效。SwiGLU就是这样一个聪明的开关,帮助模型更好地处理信息。

**** Skywork-13B模型比Llama-2-13B模型更“瘦长”: ** ** 为了达到Llama2-13B的训练效率, ****

Skywork-13B ** ** 的 训练批次大小增加到Llama2-13B的四倍。由于计算机集群带 宽较低,所以需要更多的梯度累积来减少通讯开销。

根据之前的实验,当批次更大时, 增加网络层数

(即增加模型的复杂度)可以提高模型的表现。因此,模型的层数被增加到52层,同时减小每层的规模,使得模型的总体参数量和Llama2-13B差不多。

为了适应更大的数据批量, 学习率 被提高到Llama2-13B的两倍,这样可以确保训练时梯度的方差保持一致。

**** Skywork-13B ** ** 总共52层,虽然每层的一些参数(FFN Dim和Hidden Dim)比Llama-2-13B模型小,但

总的参数量 是一样的。

| 模型结构 | Llama-2-13B | Skywork-13B |

|---|---|---|

| 词表大小 | 32,000 | 65,536 |

| Hidden Dim | 5,120 | 4,608 |

| FFN Dim | 13,696 | 12,288 |

| Head Dim | 128 | 128 |

| Attention头数 | 40 | 36 |

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

432

432

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?