来源:晓飞的算法工程笔记 公众号,转载请注明出处

论文: Anytime Continual Learning for Open Vocabulary Classification

创新点

- 在线训练时,每个批次由新训练样本和类别平衡的存储样本组成。

- 在线学习每个标签的准确性,以有效对原始模型和调整后模型的预测进行加权。

- 损失修改以支持“以上皆非”(不在预设标签内)的预测,这也使开放词汇训练更加稳定。

- 中间层特征压缩,减少训练样本的存储并提高速度,同时对准确性的影响不大。

内容概述

论文提出了针对开放词汇图像分类的任意持续学习(AnytimeCL)方法,旨在突破批量训练和严格模型的限制,要求系统能够在任何时间预测任何一组标签,并在任何时间接收到一个或多个训练样本时高效地更新和改进。

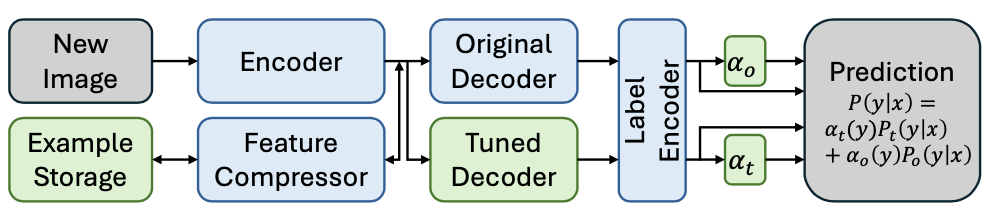

AnytimeCL基于一种动态加权机制,结合了部分微调的模型的预测与原始的模型的预测。当有新训练样本时,用存储的样本填充一个类别平衡的批次更新微调模型最后的Transformer块,然后更新对给定标签的调优和原始模型准确度的估计,最后根据它们对每个标签的预期准确度对调优模型和原始模型的预测进行加权。

此外,论文还提出了一种基于注意力加权的主成分分析(PCA)的训练特征压缩方法,这减少了存储和计算的需求,对模型准确度几乎没有影响。

AnytimeCL

论文旨在通过将微调模型与原始模型相结合来增强开放词汇图像分类器以学习目标任务。调优后的模型使用与原始模型相同的编码器,但包含一个可训练的解码器。

对于一幅图像 x x x ,调优模型和原始模型都生成所有候选标签的概率,分别表示为 P t ( y ∣ x ) P_t(y|x) Pt(y∣x) 和 P o ( y ∣ x ) P_o(y|x) Po(y∣x) ,最终概率通过在线类别加权(OCW)进行加权:

KaTeX parse error: Undefined control sequence: \label at position 19: …egin{equation} \̲l̲a̲b̲e̲l̲{eq:our_weighti…

在训练过程中,新样本被编码为中间特征(图像块的特征向量加上一个CLS标记),可以选择进行压缩并存储,以便在未来重复使用。

模型

原始模型是公开可用的CLIP ViT模型,该模型基于图像嵌入 e x e_{x} ex (CLS标记)与文本嵌入 e y e_{y}

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5880

5880

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?