前车碰撞预警——FCW,基于深度学习和单目摄像头测距的前车碰撞预警源码。 单目测距,多目标跟踪。 车辆检测,智能adas,FCW,价格只包括源码及设计文档讲解。 我使用的版本说明: gpu版本: anoconda:3-5.1.0 cuda:10.0 cudnn: cudnn-10.0-windows10-x64-v7.6.5.32 tensorflow-gpu: 1.14.0 opencv: 4.2.0 keras:2.2.5 cpu版本: anoconda:3-5.1.0 tensorflow: 1.14.0 opencv: 4.2.0 keras:2.2.5

在智能驾驶领域,前车碰撞预警(FCW)是一项至关重要的技术,它就像是给车辆安装了一双时刻警惕的眼睛,能提前感知潜在危险,为驾驶者争取宝贵的反应时间。今天就来聊聊基于深度学习和单目摄像头测距的FCW源码相关内容。

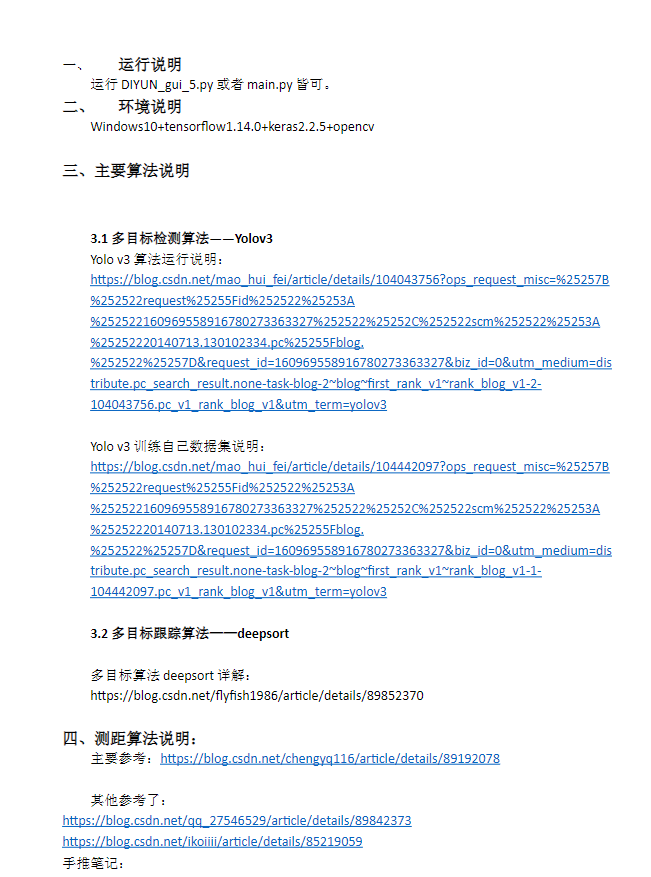

技术要点概述

这项技术主要涉及单目测距、多目标跟踪以及车辆检测,是智能adas系统的关键部分。单目测距利用单目摄像头获取的图像信息,通过算法来估算目标车辆与本车的距离。多目标跟踪则是在复杂的交通场景中,实时追踪多个车辆目标的运动轨迹。车辆检测就是识别出图像中的车辆。

版本说明的重要性

先说说版本问题,不同的软件版本之间可能存在兼容性差异,这在深度学习开发中尤为关键。

GPU版本

- anoconda:3 - 5.1.0:Anaconda作为一个强大的Python发行版,集成了众多科学计算库,为项目提供了基础的运行环境。

- cuda:10.0:CUDA是NVIDIA推出的并行计算平台和编程模型,利用GPU的并行计算能力加速深度学习模型的训练和推理。比如在训练复杂的神经网络模型时,使用CUDA能大幅缩短训练时间。以下是一个简单示意代码(实际深度学习训练代码会复杂得多):

import tensorflow as tf

# 假设已经构建好模型model

with tf.device('/GPU:0'):

model.compile(optimizer='adam', loss='categorical_crossentropy')

model.fit(x_train, y_train, epochs = 10, batch_size = 32)这里通过tf.device('/GPU:0')指定模型在GPU上运行,利用CUDA加速计算。

- cudnn: cudnn - 10.0 - windows10 - x64 - v7.6.5.32:cuDNN是NVIDIA针对深度神经网络的加速库,配合CUDA进一步提升深度学习性能。它针对卷积神经网络等常见操作进行了优化,使得计算更加高效。

- tensorflow - gpu: 1.14.0:TensorFlow是深度学习领域广泛使用的框架,GPU版本能充分利用CUDA和cuDNN的优势。

- opencv: 4.2.0:OpenCV用于处理摄像头图像,比如图像的读取、预处理等操作。以下代码展示如何使用OpenCV读取摄像头图像:

import cv2

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

if not ret:

break

cv2.imshow('Camera Feed', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()- keras:2.2.5:Keras是一个简洁的高级神经网络API,基于TensorFlow等后端运行,让构建和训练神经网络变得更加容易。例如构建一个简单的全连接神经网络:

from keras.models import Sequential

from keras.layers import Dense

model = Sequential()

model.add(Dense(64, activation='relu', input_dim = 100))

model.add(Dense(10, activation='softmax'))

model.compile(optimizer='rmsprop', loss='categorical_crossentropy', metrics=['accuracy'])CPU版本

- anoconda:3 - 5.1.0:同样提供基础环境。

- tensorflow: 1.14.0:CPU版本的TensorFlow在没有GPU的情况下也能运行深度学习模型,不过计算速度相对较慢。

- opencv: 4.2.0 和 keras:2.2.5:功能与GPU版本中的作用一致。

值得一提的是,此次提供的价格仅包含源码及设计文档讲解,对于想要深入研究FCW技术,从源码层面理解其实现原理的开发者来说,是个不错的机会。通过研究源码,可以进一步优化算法,提升FCW系统的性能,为智能驾驶的安全保障添砖加瓦。无论是单目测距的算法细节,还是多目标跟踪的逻辑实现,源码中都蕴含着无尽的探索空间。

456

456

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?