引言

在自动驾驶领域,多传感器融合技术是一种常见的方法,用于提高感知系统的准确性和鲁棒性。其中,BevFusion是一种流行的融合方法,可以将来自不同传感器的数据进行融合,生成具有丰富信息的鸟瞰图(BEV)表示。在本文中,我们将介绍如何使用OpenPCdet框架训练和测试多传感器融合BevFusion

环境搭建与数据准备

-

安装OpenPCDet: 确标Python环境,确保安装PyTorch及OpenPCDet。克隆仓库后,执行依赖安装。

-

nuScenes数据集: 从官方网站下载数据集,包含LiDAR、相机图像、雷达等多模态数据,为训练和评估准备。存放到相应的路径。

参考:nuscenes生成数据信息info

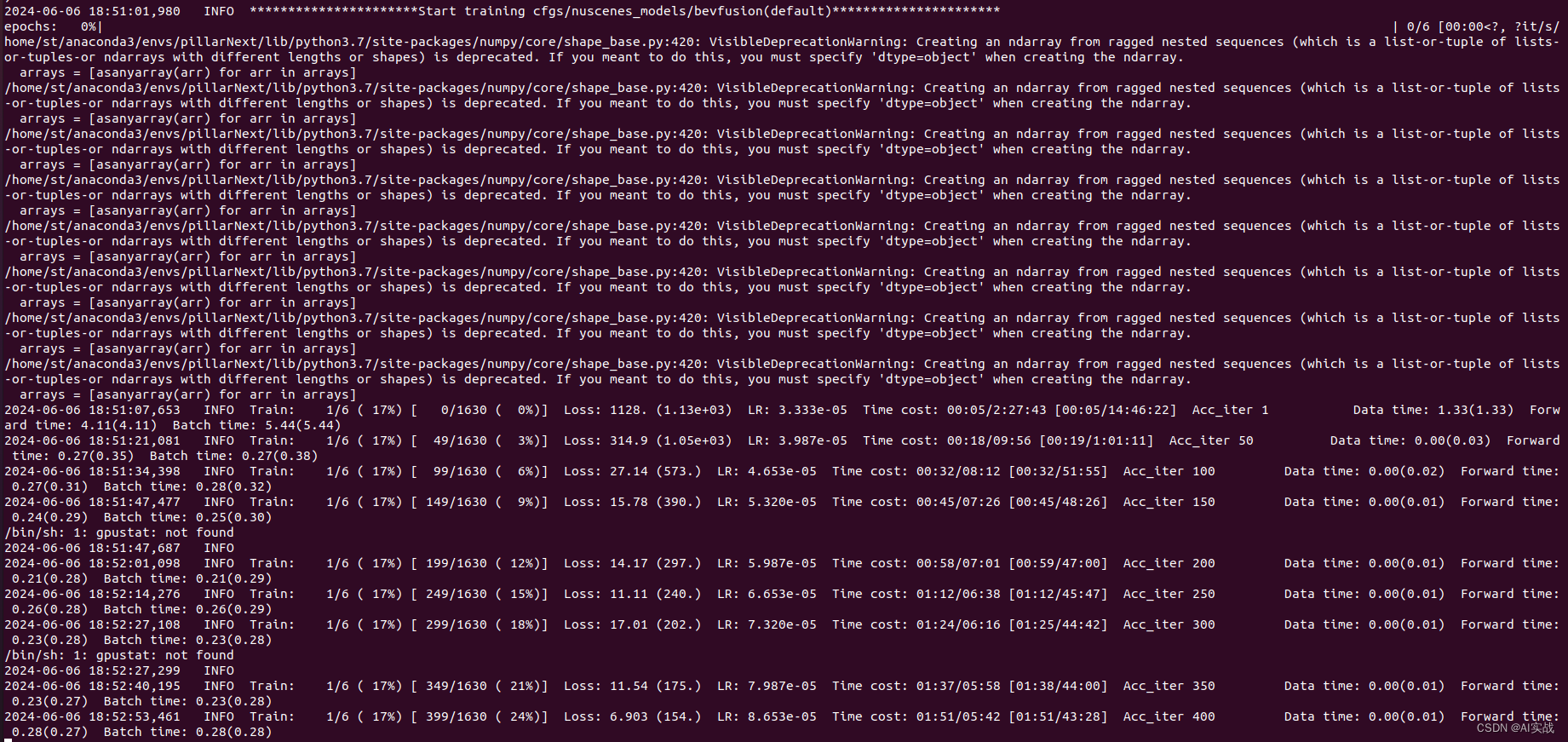

模型训练

#单个GPU

python train.py --cfg_file ./cfgs/nuscenes_models/bevfusion.yaml

#多GPU

sh scripts/dist_train.sh 3 --cfg_file ./cfgs/nuscenes_models/bevfusion.yaml模型测试

python test.py --cfg_file ./cfgs/nuscenes_models/bevfusion.yaml --batch_size 4 --ckpt ../checkpoints_office/cbgs_bevfusion.pth

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8570

8570

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?