有人会说:"小周,几天不见这么拉了,现在别说算法了,连code都不讲了,整上方法论了。"

我并没有拉!而且方法论很重要,尤其工程化的时候,你总得知道每种技术到底适合干啥,其实主要是现实中,我在项目里发现大家对这块其实并不是分的很清楚。

所以我来给大家捋一捋,因为这毕竟直接取决于你设计的解决方案是否能真正解决问题

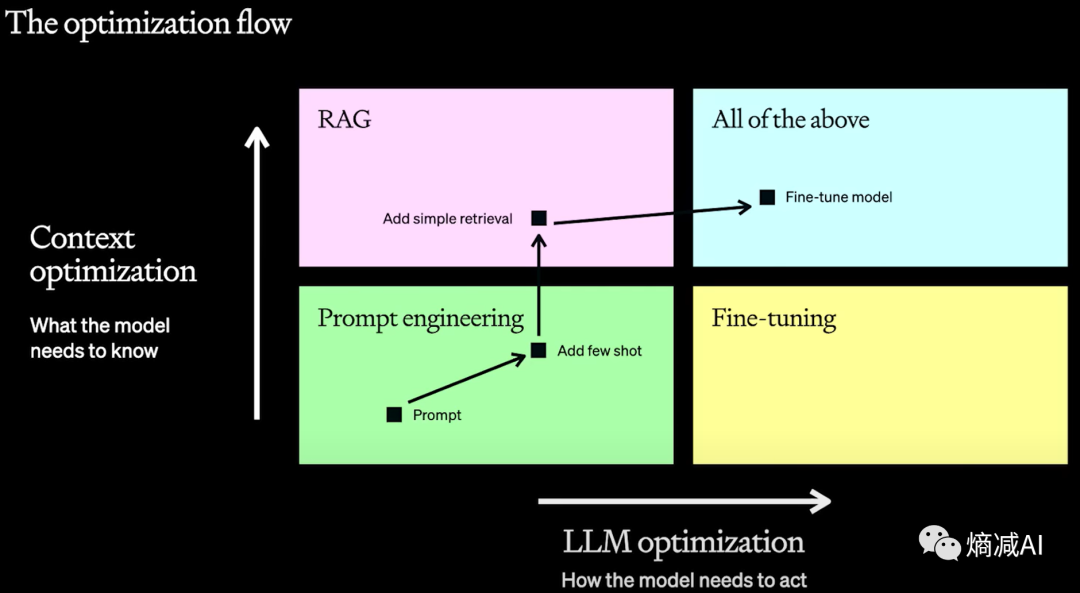

如上图所示,OpenAI把对于优化LLM返回结果分为两个方向,一个方向是横坐标系的对LLM 模型本身的优化,另一个是对你提供的Context的优化

-

在对LLM本身的优化上没啥可弄的,最后就只能走到Fine-tuning这一条路

-

在对本身的Context进行优化的方式,我们一般起手式是先prompt-engineering

-

prompt-engineering不好使了,我们会借助RAG来实现额外的能力和知识

我们先来把几个概念再捋一下

prompt-engineering

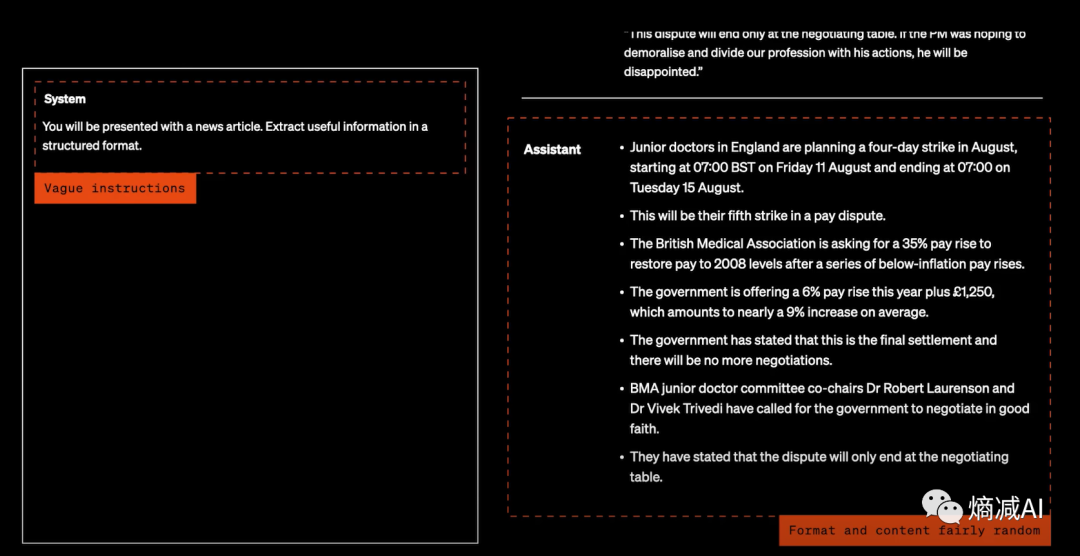

上图就是一个不清晰的prompt的典型,没有清晰的system message定义,得到的回应也是特别的随机,并且没有清晰的format

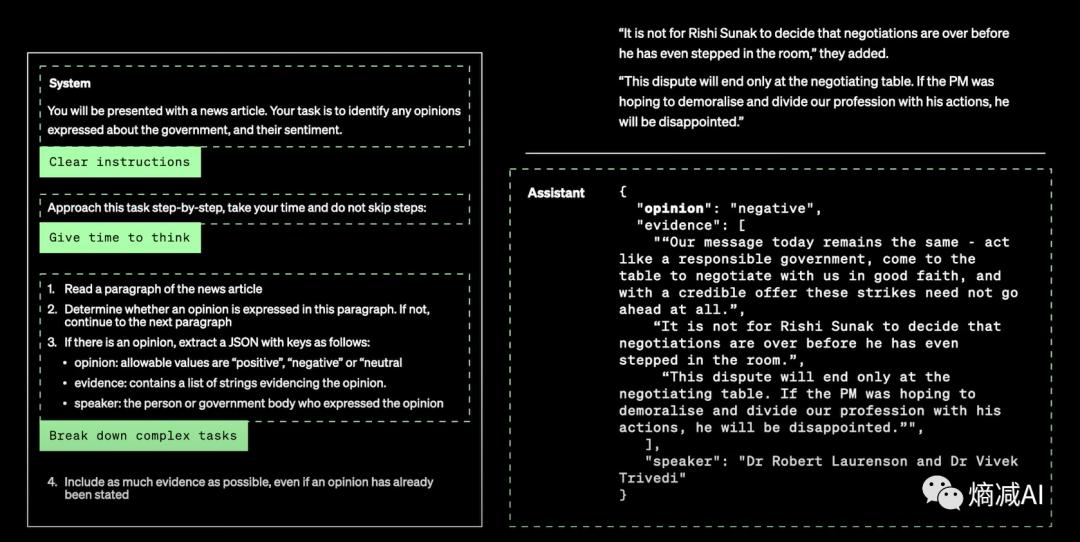

优化上面的prompt,从几个维度入手:

-

首先肯定是要指令变得更清晰

-

其次用COT的方式提问让它拆解复杂的任务

-

顺便告诉LLM你要什么样输出的回答格式

</

本文讨论了在自然语言处理中,如何通过prompt-engineering、Fine-tuning和RAG技术来优化LLM模型,强调了清晰的指令和context对解决问题的重要性,以及这些技术在解决复杂任务和知识生成中的作用。

本文讨论了在自然语言处理中,如何通过prompt-engineering、Fine-tuning和RAG技术来优化LLM模型,强调了清晰的指令和context对解决问题的重要性,以及这些技术在解决复杂任务和知识生成中的作用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1004

1004

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?