GELU(Gaussian Error Linear Unit,高斯误差线性单元)是一种结合了概率思想的激活函数,它通过输入值在高斯分布下的累积概率来动态决定激活程度,而非像ReLU那样进行简单的二值化门控。

下面的表格可以帮助你快速把握GELU的核心要点。

| 特性 | GELU (Gaussian Error Linear Unit) |

|---|---|

| 设计思想 | 概率化门控:将输入 ( x ) 乘以一个由 ( x ) 本身大小决定的“保留概率”,模拟随机正则化(如Dropout)的效果,但以确定性的方式实现。 |

| 数学特性 | 平滑性:在整个定义域内是连续、可导且平滑的,没有ReLU在 ( x=0 ) 处的突变。 |

| 与ReLU对比 | 更柔和的处理:对负值输入不会直接输出0,而是根据其大小给予一个平滑过渡的微小负激活,缓解了“神经元死亡”问题。 |

| 主要优势 | 训练更稳定、梯度流更佳、与Transformer架构(尤其是其中的Dropout正则化)协同效果好。 |

| 典型应用 | BERT、GPT系列等绝大多数现代Transformer模型。 |

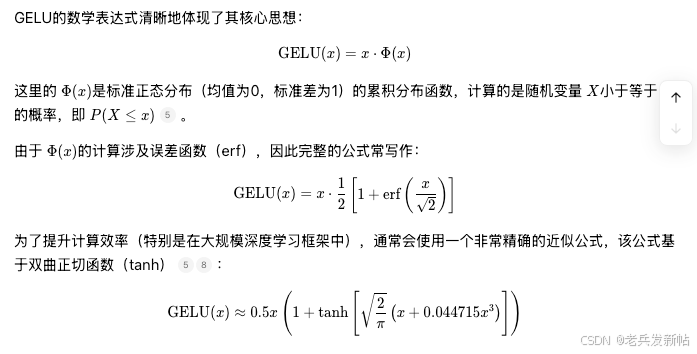

🔢 核心公式与计算

⚖️ 与ReLU的直观对比

理解GELU的一个好方法是将其与熟悉的ReLU函数进行比较:

| 输入 ( x ) 的情况 | ReLU 的输出 | GELU 的输出(近似) | 行为解读 |

|---|---|---|---|

| ( x ) 为很大的正数(如 ( x = 2 )) | ( 2 ) | ≈ 1.95 | 类似ReLU:两者都让正信号几乎完全通过。 |

| ( x ) 为很小的负数(如 ( x = -2 )) | ( 0 ) | ≈ -0.05 | 关键区别:ReLU直接“关闭”神经元。GELU则给予一个微小的负值,保留了部分信息流和梯度,有效防止神经元“死亡”。 |

| ( x ) 在0附近(如 ( x = 0.5 )) | ( 0.5 ) | ≈ 0.35 | 平滑过渡:GELU的激活是渐进的,而非ReLU的突然转折,这使得训练过程更稳定。 |

💡 为什么GELU在Transformer中表现出色?

GELU成为BERT、GPT等大模型首选激活函数,主要源于以下几点:

- 与Dropout的哲学契合:Transformer模型广泛使用Dropout进行正则化。GELU的设计理念本身就融合了这种随机性,它模拟了“根据输入重要性以一定概率保留或抑制神经元”的过程,这与Dropout的思想高度协同。

- 优异的梯度特性:GELU的平滑性保证了其在所有点上都有良好的梯度,避免了ReLU的硬边界导致的梯度问题(如 dying ReLU)。这有助于梯度在深层网络中更稳定地反向传播,从而提升训练效果。

- 强大的模型表达能力:由于对负值输入不是简单截断,GELU允许模型学习到更复杂、更细微的数据模式,这尤其适合自然语言处理中常见的复杂语义关系。

💻 实际应用与代码示例

在PyTorch等主流深度学习框架中,可以方便地使用GELU。以下是一个简单的实现示例,展示了精确计算和近似计算两种方式:

import torch

import torch.nn as nn

import math

class GELU(nn.Module):

def __init__(self, approximate=False):

super().__init__()

self.approximate = approximate

def forward(self, x):

if self.approximate:

# 使用近似计算,速度更快

return 0.5 * x * (1.0 + torch.tanh(

math.sqrt(2.0 / math.pi) * (x + 0.044715 * torch.pow(x, 3.0))

))

else:

# 使用精确计算

return 0.5 * x * (1.0 + torch.erf(x / math.sqrt(2.0)))

# 使用示例

gelu_layer = GELU(approximate=True) # 通常为平衡效率与精度,会选择近似模式

input_tensor = torch.tensor([-2.0, -1.0, 0.0, 1.0, 2.0])

output = gelu_layer(input_tensor)

print(output)

# 输出可能类似:tensor([-0.0454, -0.1587, 0.0000, 0.8413, 1.9545])

💎 总结

总而言之,GELU通过其平滑、概率化的门控机制,在保持ReLU主要优点的同时,有效克服了其关键缺陷,提供了更稳定的训练动态和更强大的模型表达能力。这使其特别适合Transformer这类复杂且深度的网络架构,成为现代大语言模型事实上的标准激活函数。

希望这些解释能帮助你透彻地理解GELU。如果你对它与Swish等其他激活函数的细微区别,或者在实际调参中的技巧感兴趣,我们可以继续深入探讨。

2294

2294

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?