VarifocalNet: An IoU-aware Dense Object Detector

Motivation

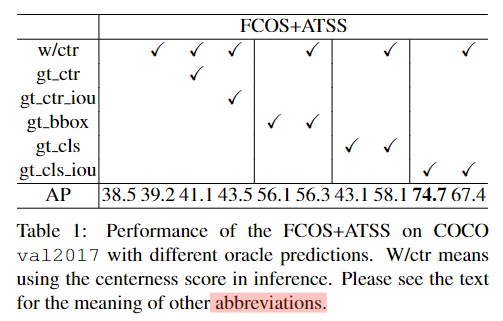

文中第三章作者基于FCOS+ATSS网络的实验结果是本文的动机,首先对这个实验中的每个AP逐一解析:

1 38.5:训练时没有centerness(ctr)分支

2 39.2:训练和测试时加入ctr分支,该方法设为baseline

3 41.1:基于baseline,把测试时的ctr换成label值,AP小幅提升0.9

4 43.5:基于baseline,把测试时的ctr换成预测框与gt框的iou,AP提升了4.3,比使用ctr高。

5 56.1:没有ctr分支,将测试时的bbox推理结果替换为gt bbox,分类结果仍是网络的预测结果

6 56.3:与上一个为对比实验,训练测试时多加入ctr,多引入的ctr只将AP提升了0.2。

7 43.1:没有ctr分支,将预测的分类结果替换为gt的类别标签,AP为43.1,只比实验1高4.6

8 58.1:与上一个为对比实验,多引入ctr分支,AP提升了15

9 74.7:没有ctr分支,将预测的分类结果替换为gt与预测框的IoU。

'''基于实验1,对比该实验和实验5,说明定位很准的框已经被预测

VarifocalNet是针对目标检测网络中分类与定位相关性低的问题提出的新方法。通过VarifocalLoss,星形边界框特征表达和精细化边界框调整,提高检测器的性能。实验表明,这种IoU感知的分类得分能有效避免高精度定位框被NMS误删,从而提升平均精度(AP)。

VarifocalNet是针对目标检测网络中分类与定位相关性低的问题提出的新方法。通过VarifocalLoss,星形边界框特征表达和精细化边界框调整,提高检测器的性能。实验表明,这种IoU感知的分类得分能有效避免高精度定位框被NMS误删,从而提升平均精度(AP)。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?