我们整天都讲着大模型,但我们对大模型到底了解多少?

思维误区

许多人都认为AI大模型系统是一种颠覆性的创新,然而从技术的角度来看并非如此。在过去的二十多年里,AI系统已经发展出了许多优秀的设计范式。正因如此,国内各大公司才能在短时间里实现文心一言和通义千问这类ChatGPT的平替。

大模型的本质:大模型技术的发展主要是为了实现从 AI 推荐内容,也就是 AIRC 到 AI 生成内容也就是AIGC的进化。进一步讲,还实现了从结构化内容生成到“多模态”内容生成的变革。

认知升级

“AI大模型将成为新一代应用平台”的观点,似乎已经成为各大公司的共识。

AI 大模型到底是什么

在过去的一年里,你可能经常听到各种名词,比如大模型、AI模型、生成式AI、AIGC、生成式AI大模型等等。实际上,在技术术语上并没有“大模型”这个说法。不过,由于它被广泛使用,大模型这个名字已经深入人心。虽然不必刻意纠正,但严谨一些:在学术分类上,我们无法找到“大模型”这个分类。

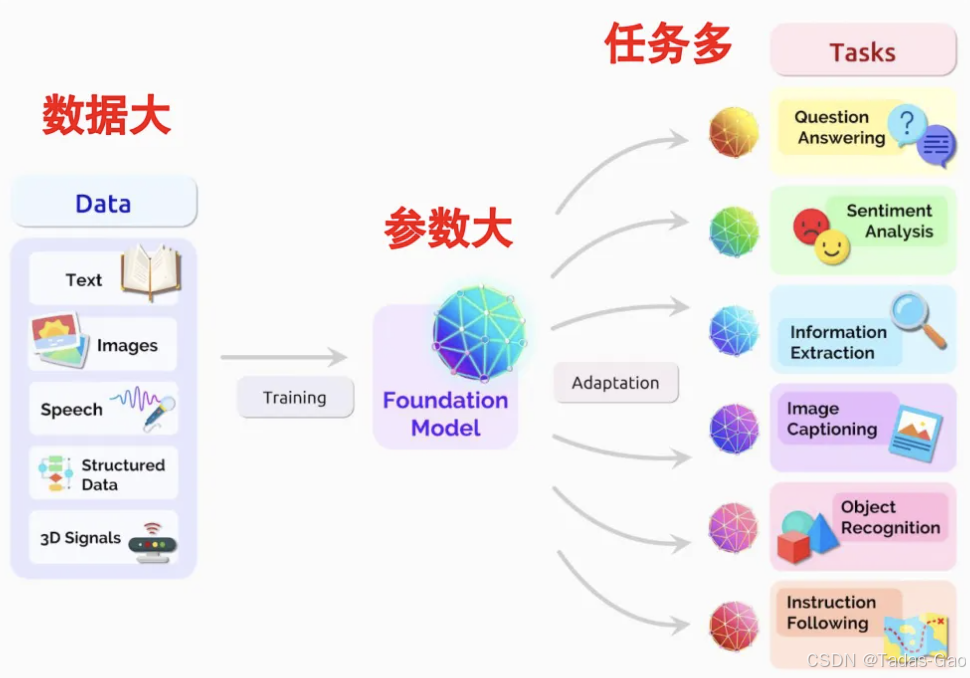

学术上更多更常用的术语是基础模型(foundation model或base model),在2021年8月,李飞飞和其他一百多位学者,联合发布了一份超过200页的研究报告 On the Opportunities and Risks of Foundation Models。在这篇文章中,AI专家们介绍了目前该类模型所面临的机遇和挑战,并一致将这些大模型称为基础模型(Foundation Models),所以通用的标准术语是基础模型而非大模型。

维基百科:基础模型是一种大型机器学习模型,通常在大量数据上进行大规模训练(通过自监督学习或半监督学习),以使它可以适应各类下游任务。

因此,到底什么样的模型才能叫大模型(基础模型)?需要兼顾参数量大(大型模型),训练数据量大(大量数据大规模训练)和迁移学习能力强(适应多种下游任务)几点才能够叫做基础模型,而不只是参数量大,就能够叫做基础模型。

总结:要的就是大和多。

更多的层级使神经网络更深入、更强大。更多的硬件可以加快训练过程,实现更大规模的网络部署。当然,还有更多的数据:更多的图像,更多的视频,更多的音频,更多的文本以及其他任何可能训练网络理解的内容。更多的一切。

另一个重要的定义就是AIGC,目前工业界普遍将AIGC(Artificial Intelligence Generated Content)称为生成式人工智能。目前全球热门的AIGC应用(如ChatGPT,Midjourney)几乎都是通过“大模型”的上下文学习、涌现和思维链等能力支撑实现的,所以大众和媒体往往会把这种“智能”和“大模型”技术建立一一映射的关系。因此讨论AIGC应用时,各类媒体往往会在“生成式人工智能”后面加上“大模型”,这也就是我们常听到的“生成式人工智能大模型”。

我简单解释一下涌现和思维链。所谓“涌现”,指的是在大模型领域,当模型突破某个规模时,性能显著提升,表现出让人惊艳、意想不到的能力。所谓思维链(Chain-of-thought,CoT)指的是通过一系列有逻辑关系的思考步骤,形成一个完整的思考,进而得出答案的过程。

大模型技术从哪里来的

在过去的二十多年里,随着AI系统的发展,模型一直在不断增大,所以“大模型”实际上是一个相对的概念。

刚刚提到的基础模型不是凭空出现的,故事还要从AI模型为什么热衷于追求“大”开始说起。在搜索、广告和推荐等内容分发领域兴起后,我们开始能够收集到大规模的有监督反馈数据,例如点击、点赞和购买等行为数据。市场也渐渐察觉,投入在人工智能技术上的投资,可以在商业上获得巨大的回报。因此,为了更好地记忆和监督海量数据中的信息,模型的参数规模开始急剧增长,模型变得越来越大。

随后,随着DeepMind AlphaGo的走红,AI领域进入了全面爆发的阶段。重要的AI应用,如AlphaZero和无人驾驶,能够以较低成本自动生成训练数据,训练数据的规模也发生了质的飞跃。在更大规模的训练数据基础上,以计算能力和存储成本的降低为有利条件,模型的参数规模再次急剧增加,模型变得更大了。

目前,以OpenAI GPT 3.0为里程碑的AI大模型正在使用全网的数据进行无监督训练,我们进入了一切皆为训练数据的时代。这使得模型可以获得几乎无限的训练数据。为了对如此规模的数据进行建模,模型参数的规模越大越好,因此模型变得越来越大了。

大模型的“大”是一个相对概念,是一个持续的过程。更大规模的训练数据需要模型具备更强的记忆、理解和表达能力。而为了拥有更强的记忆、理解和表达能力,模型则需要更大的参数量,也就是更大的模型。

所以模型为什么越来越“大”就很容易理解了:内因是身体的发育,也就是存储和算力的发展。外因是人类在知识量和共享度上的发展,互联网技术使得人类个体公开可查的学习资料,在本世纪内快速膨胀。

所以,大模型技术并不是突然出现,而是来源于之前人工智能几十年来的积淀,在此基础上的发展。

大模型技术为什么能火

首先,在近年的技术发展中,大型语言模型,特别是以GPT 3.0为代表的大模型,展现出了出色的涌现、思维链和上下文学习的能力,不再停留在“人工智障”的阶段,极大地提升了自然语言理解和生成的能力(BERT),然而,这只是其中的一个必要条件。

第二个必要条件是跨模态建模能力的发展。这让同一个模型能像人类一样同时理解和处理Excel、PPT、PDF、图像和视频等多种形式的数据。加持了这样的能力,算法生成的信息量从此发生质变,生成式人工智能发挥作用的舞台就更多了。

第三个必要条件是生成式模型的交互方式。生成式AI产品巧妙地利用了人类的惰性,通过新的交互方式,大大提高了产品的渗透率。这使得人们不断地使用ChatGPT,并逐渐产生了依赖。这也成为了当前AI大模型产业迅速发展的关键点。

然而,所有这些前提条件的实现,都依赖于存储和计算能力的持续发展,使模型能够容纳和记忆更大规模的数据。不过,以上只是生成式AI大模型兴起的一些必要条件,但其全面走红还涉及到资本和产业发展的需求等多个因素的综合效果。

大模型能做什么

由于大语言模型在训练数据上的多样性和数量的保证,以及大规模参数所造成的涌现和思维链能力,让它可以很好地应对如语言翻译、创意策划、文章创作和代码编写这类任务。

但是大模型技术本身也存在一些局限。比如训练数据存在时效性的问题,比方说GPT3.5只使用了2021年9月之前的数据进行训练,无法评判那之后的事实,同时大模型在因果推断方面也存在一些问题。

大模型还会出现“幻觉”,会一本正经地给你讲“林黛玉倒拔垂杨柳”的故事,当然这些既是问题,也是我们AI大模型架构的发展机遇。

可以看出,这个平台和之前我们熟悉的平台都不一样。你不是多了一个小助手,而是接近“全能”的专业大管家。

-

作为助理,他能帮你提前安排日程,完成差旅机票酒店的预定,或者根据会议相关的资料和人数帮你预定会议室,提前发放会议议程。

-

作为秘书:他能根据你的个人习惯,每天查询你关注领域的最新消息,为你整理专属版“参考消息”。或者每个周末整理你一周交给他的工作任务,为你生成工作周报。

-

作为“伴侣”,他甚至可以接入语音合成和语音识别的插件,以及数字人的插件,像一个真正的朋友一样和你进行视频对话。

这个能力将使ChatGPT成为当之无愧的新一代生态平台。毫无疑问大模型系统平台将成为强大的生产工具,擅长使用大模型平台的用户将极大地提升个人生产效率,和其他人拉开差距。用户和开发者的全部数据会汇集于此,形成强大的马太效应。

因此,国内互联网公司也在加紧构建属于自己的AI大模型系统平台和相应的应用生态。我们身处其中,也要做好长期投入的准备,一起迎接下一轮行业洗牌时刻的到来,大潮过后方知谁是英雄。

当前正处于第四次工业革命阶段,其核心特征是人工智能、物联网、大数据(关联)等技术的深度融合与智能化应用。

为什么这里说人工智能、物联网和大数据相互关联呢?

人工智能必然需要大量的数据输入,这就需要大数据。人工智能的终局既然是具身智能甚至 AGI,那么就离不开物联网,同时,物联网也会产生大量的数据,三者是互相关联互相促进的关系。

第四次工业革命(当前阶段):

-

核心特征:

-

智能化生产系统(工业4.0)

-

数据驱动的决策体系(预测分析)

-

跨领域技术融合(云计算+物联网+人工智能)

-

关于人工智能的发展,可以回顾一下:人工智能的发展历程-优快云博客

大模型的智能涌现可能成为第五代工业革命,特点是人工智能与人类之间的认知伙伴关系,大模型技术将从“原子弹”变成“茶叶蛋”,走进千行百业,这是当今人类最后的赌注。

所以,为了不被社会淘汰,赶上下一波浪潮,先物色一个电脑,没有 GPU 很多事情就无能为力了。可以回顾一下:个人开发者选 GPU 的简单方案-优快云博客

大模型的终局在哪里

结论:具身智能,这才是最终的野心。

当前大模型的能力,不同人有不同的看法。有些人不太高兴,因为担心它的代码能力会对工程师的工作造成威胁。另一些人的态度是不屑一顾,认为它只会说些不切实际的东西。还有一些人正在学习一些易上手、但欠缺深度的教程,用它建立知识库,自动化日常工作,觉得“小小GPT不过如此”,很容易就能“拿捏”它了。

不过,这一轮技术革命并不是冲着这“仨瓜俩枣”来的,未来所有数字化工作都可能被大模型技术颠覆。我们一起来看看这一轮技术革命的真正“终局”是什么样子。

我们未来所面临的终局形态,不只是一个能说会道的聊天机器人,而是“具身智能”的通用人工智能。所谓具身智能,就是像人一样能与环境交互感知,自主规划、决策、行动的机器人。

如何看终局?从发展过程来看,一起来看看 GPT 的发展。

GPT的诞生要归功于NLP的快速发展。从2018年到2021年,是第一代大语言模型(LLM)的“技术爆炸”期。人们逐渐学会了,如何使用海量的无标签数据,来训练这些“涌现”智能的大模型。随后,OpenAI采用强化学习技术,点亮了LLM的智能,ChatGPT由此横空出世。

首先,OpenAI推出了插件和联网功能,弥补了大型语言模型自身记忆的不足,这标志着LLM正式开始学习使用工具。

随后推出的函数功能,意味着LLM已经学会使用API来完成复杂任务,在此之前这可是后端工程师的主要工作。最后推出的代码编辑器,让LLM直接学会制造工具,这几乎动摇了所有工程师的饭碗。

虽然人类可以掌控使用工具的大模型,但令人既兴奋又担心的是,研究人员还找到了让LLM“思考”的方法。

当人类面临一个任务的时候,会怎么做?

首先,我们会思考任务的主要步骤有哪些,然后调取相关的资料,形成可行的方案,接着通过分工去执行具体的事项,最后汇总完成任务。对于智能体来说也是一样,只不过要将之前人类大脑的工作交给大语言模型(LLM)完成。

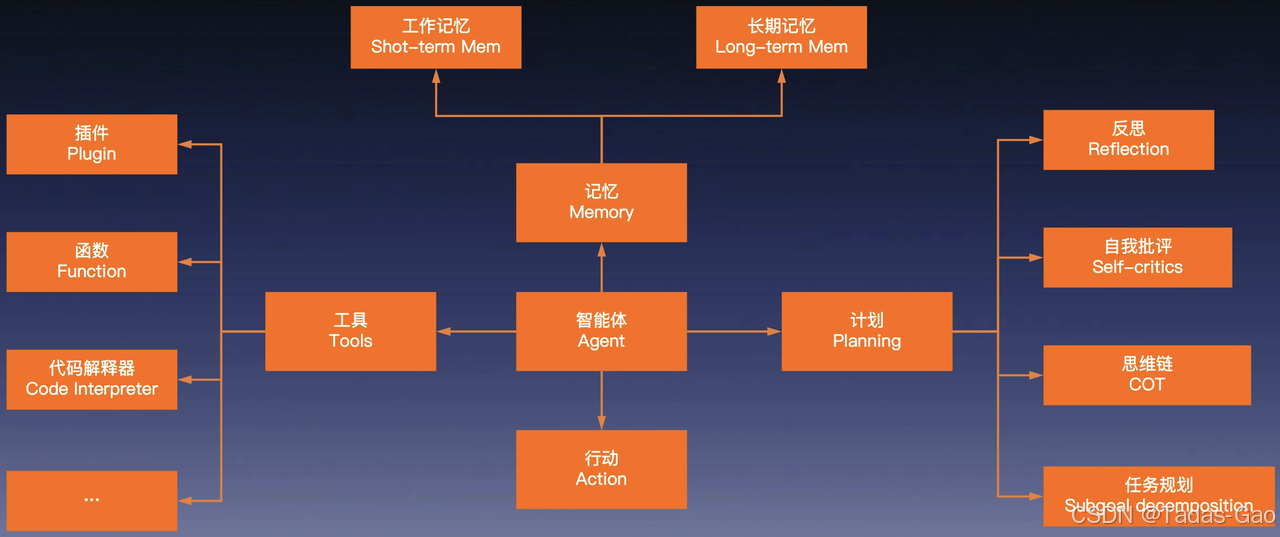

为了让智能体具备“自治”的能力,一般需要将计划、记忆和工具这三部分组合起来。

任务规划怎么做?

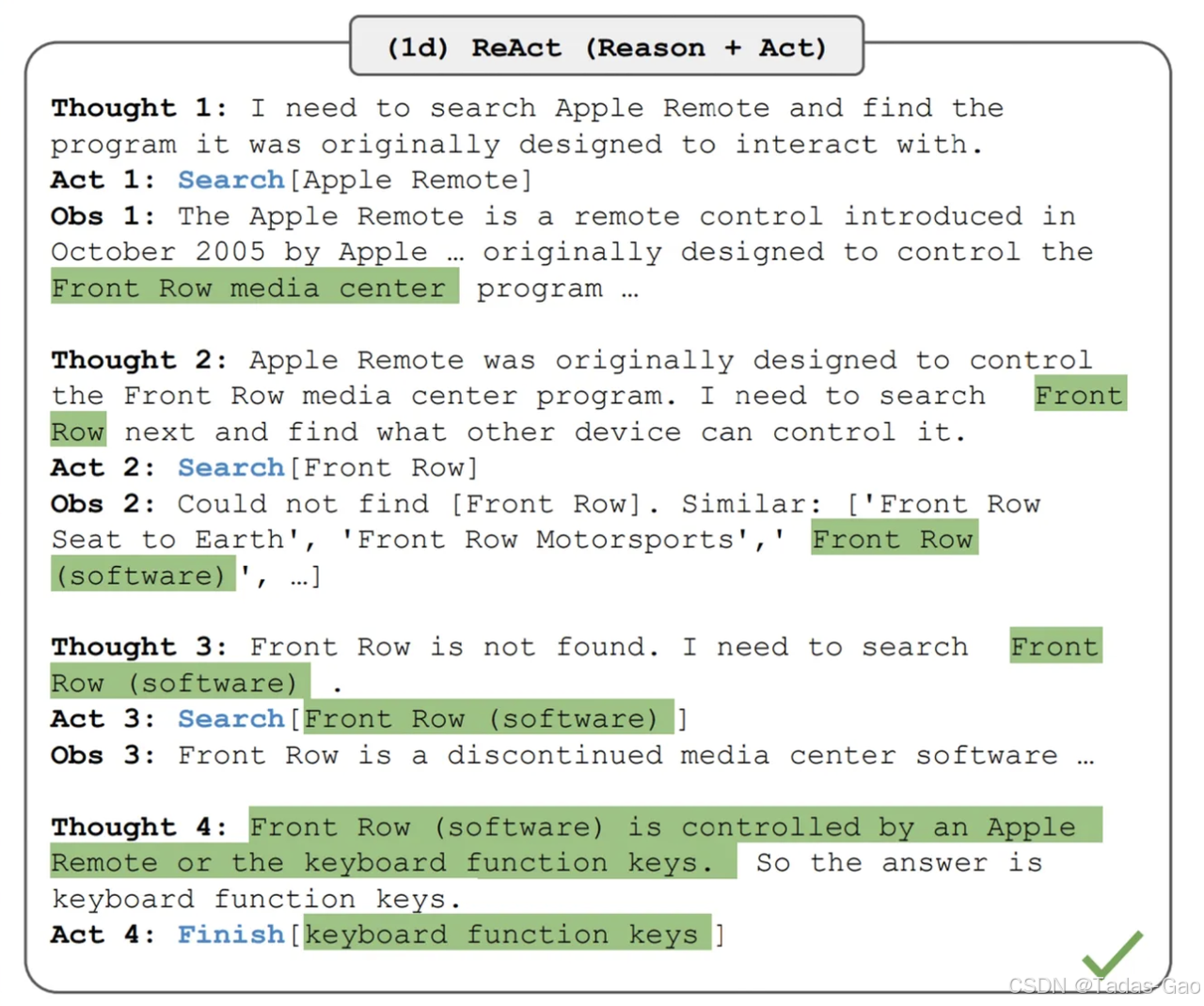

让LLM对自己的想法进行调整和反思,最经典的方法是ReAct,他有三个概念:

-

Thought:表示让大语言模型思考,目前需要做哪些行为,行为的对象是谁,它要采取的行为是不是合理的。

-

Act:也就是针对目标对象,执行具体的动作,比如调用API这样的动作,然后收集环境反馈的信息。

-

Obs:它代表把外界观察的反馈信息,同步给大语言模型,协助它做出进一步的分析或者决策。

在这个过程中,你要尽量唤醒LLM的相关知识,生成合理的计划,此时思维链技术(CoT)就非常重要了,它可以让LLM将任务分解为可解释的步骤。

记忆怎么做?

无论是在制定计划、使用工具或执行任务的过程中,LLM都需要外部信息的帮助来辅助进行思考。为了更好地让 LLM 拥有记忆力,我们不妨先参考一下人类是如何记忆的。

在神经科学研究中,人类的记忆可分为感觉记忆、短期记忆和长期记忆三种类型。

-

感觉记忆,是人体接收到外部信号以后,瞬间保留的视觉、听觉、触觉的记忆片段,在AI系统中类似于高维嵌入表示,也就是我们常说的“Embedding”。

-

短期记忆,是你当前意识中的信息,在LLM中类似于提示词(Prompt)中的所有信息。

-

长期记忆,包含了你能回忆的所有信息,在LLM中类似于外部向量存储。

LLM能“消化”的,只有提示词(Prompt)中的短时记忆,所以你只需要在长期记忆中选择最重要的内容放入提示词,这里我给出一张图方便你理解这个过程。

-

首先,LLM在得到任务后,会帮助你制定记忆唤醒方案。

-

然后,AI系统执行该方案,生成相关的查询指令,从外部数据中查询数据。

-

最后,我们将这些数据交给 LLM 来判断是否已获得足够完成任务的数据。如果没有,LLM 会生成新的唤醒方案,并循环这个过程。

现在,LLM不但能制定任务规划,还能调取外部知识了。仅这两个能力足以让它自动化地完成很多脑力工作了。

怎么让大模型用工具?

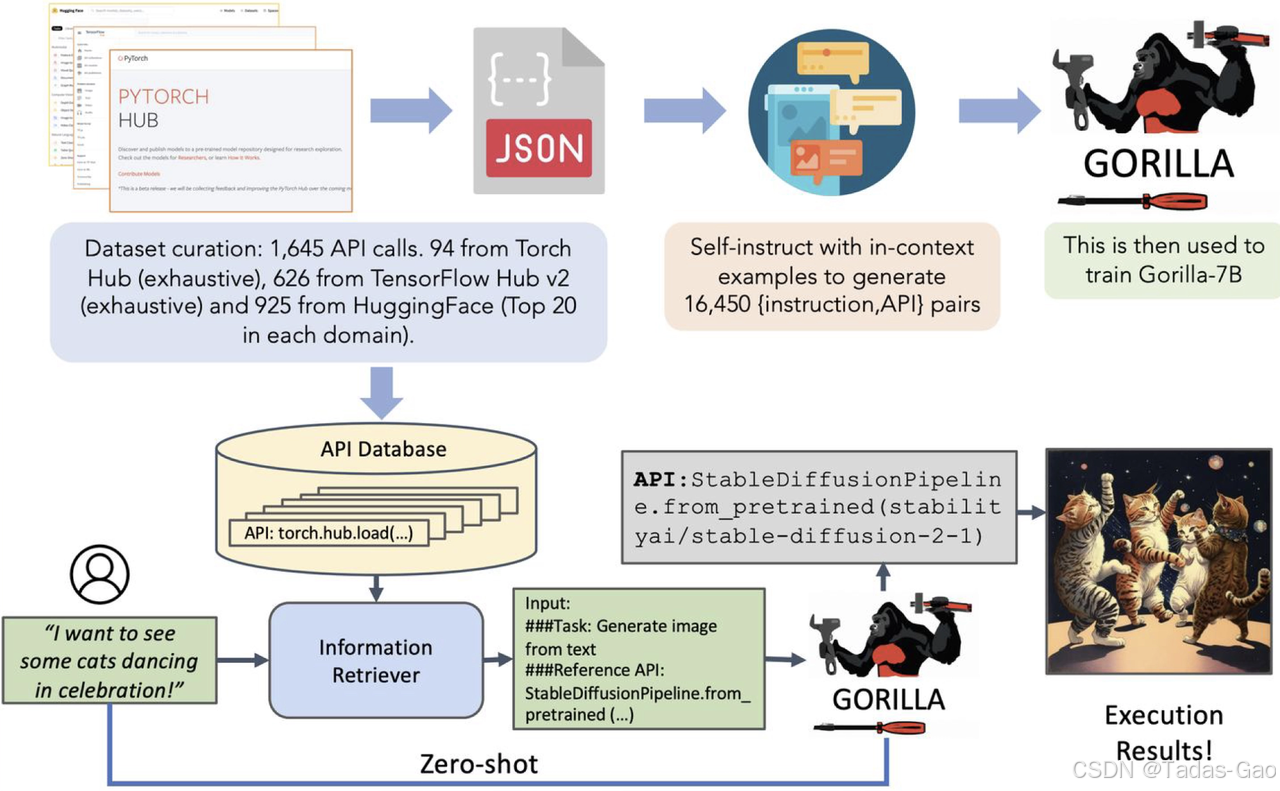

要让 LLM 学会使用工具,首先需要让它认识工具,比如让LLM学会理解API的调用注释,这是Plugin和Function等功能的基础。

下图展示了Gorilla教会LLM使用API的全过程。

-

首先,我们使用大量API调用代码和文档作为语料,训练一个可以理解API的大语言模型。

-

然后,AI系统还将对这些API进行向量化操作,将它们存储在向量数据库中作为外部记忆。

-

随后,当用户发起请求时,AI系统会从外部记忆中,获取跟请求相关的 API 交给 LLM。

-

最后,LLM 组合串联这些 API 形成代码,并执行代码,完成API的调用,生成执行结果。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?