智能体AI行业蓬勃发展,产值超过 52 亿美元,预计到 2034年将达到2000亿美元。我们正进入一个AI将像互联网一样普及的时代,但其根基存在严重缺陷。当今的AI革命依赖庞大且耗能的大语言模型(LLM),面向智能体AI的小语言模型(SLM)拥有独特的优势,可以解决这一问题。虽然LLM接近人类的能力令人印象深刻,但对于某些特定任务往往显得大材小用,好比用大锤砸核桃。结果如何?成本高昂、能源浪费严重、创新受阻,而面向智能体AI的SLM克服的正是这种挑战。

但还有更好的方法。英伟达的研究论文《小语言模型是智能体AI的未来》揭示了SLM如何提供了一条更智能化、更可持续的出路。不妨深入探讨为什么更小常常更好以及SLM如何重塑AI的未来。

为何选择SLM?

在理解为什么SLM是正确的选择之前,不妨先来了解一下SLM究竟是什么。该论文将其定义为一种语言模型,能够部署在常见的消费电子设备上,以足够低的延迟进行推理,从而能够切实处理单个用户的智能体请求。截至2025年,这通常包括参数数量不足100亿的模型。

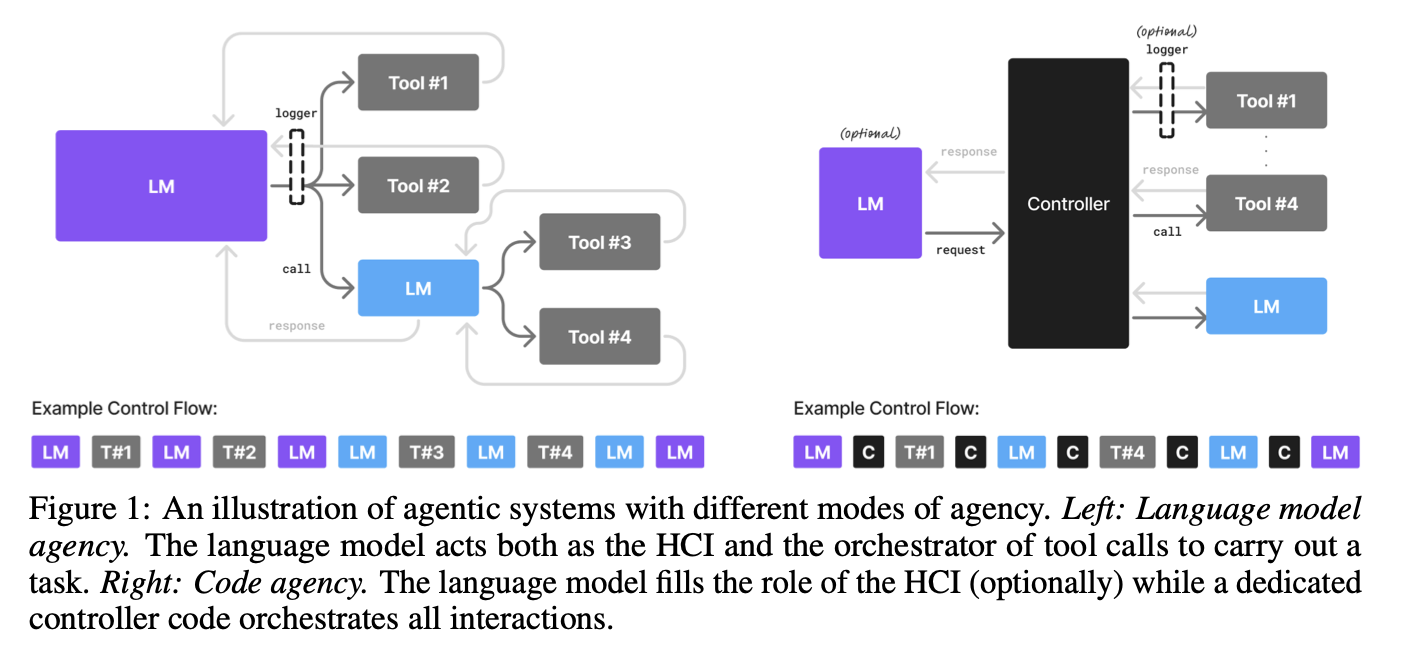

图片来源:英伟达研究论文

论文作者认为,SLM不仅是LLM的可行替代方案,而且在许多情况下,它们是更优的选择。他们基于以下三大支柱提出了令人信服的理由:

- SLM足够强大

- SLM更经济

- SLM更灵活

不妨逐一分析这些理由。

SLM的惊人“威力”

人们很容易认为SLM不如大模型强大。毕竟,“越大越好”这个口号多年来一直是AI界的驱动力。但最近的进展表明,情况不再如此。

精心设计的SLM如今在执行各种任务时能够达到甚至超越大语言模型的性能。论文重点介绍了几个例子,包括如下:

- 微软的Phi系列:Phi-2模型仅包含27亿个参数,其常识推理和代码生成得分与包含 300亿个参数的模型相当,同时运行速度提高了约15倍。Phi-3小模型(包含70亿个参数)的表现更出彩,其语言理解、常识推理和代码生成得分可媲美规模大其10倍的模型。

- 英伟达的Nemotron-H系列:这些混合Mamba-Transformer模型的参数规模从20亿到90亿不等,其指令跟踪和代码生成精度可与密集的300亿参数LLM相媲美,而推理成本却只是其一小部分。

- Hugging Face的SmolLM2系列:这一系列紧凑语言模型的参数规模从1.25亿到17亿不等,其性能可与同一代140亿参数模型,甚至两年前的700亿参数模型相媲美。

这些只是几个例子,但传达的讯息很明确:就性能而言,规模并非一切。借助现代训练技术、提示和智能体增强技术,SLM大有作为。

小型化的“经济”效益

这是SLM真正引人注目的地方。在这个精打细算的世界,SLM的经济优势不容忽视。

- 推理效率:在延迟、能耗和FLOP方面,部署一个拥有70亿个参数的SLM比部署一个拥有700亿到1750亿个参数的LLM便宜10到30倍。这意味着你可以获得大规模的实时智能体响应,无需花费巨资。

- 微调敏捷性:需要添加新的行为或修复错误?使用SLM,你可以在数小时内完成,而不是数周。这便于快速迭代和适应,这在当今快节奏的世界至关重要。

- 边缘部署:SLM可以在消费级GPU上运行,这意味着你可以进行实时离线的智能体推理,拥有更低的延迟和更强的数据控制能力。这为设备端AI开辟了全新的无限可能。

- 模块化系统设计:你可以结合使用多个小型专用SLM来处理不同的任务,无需依赖单个庞大的LLM。这种类似积木的方法成本更低、调试速度更快、部署更轻松,并且更符合现实世界中智能体的多样性操作。

综上所述,SLM的经济效益毋庸置疑。它们比大模型更便宜、更快速、更高效,对于任何想要构建经济高效、模块化且可持续的AI智能体的组织来说,它们是明智之选。

为什么一种“尺寸”无法适应所有场景?

世界并非千篇一律,我们要求AI智能体执行的任务也并非千篇一律。这时候SLM的灵活性大放异彩。

由于SLM规模更小、训练成本更低,你可以为不同的智能体例程创建多个专门的专家模型。这使你能够:

- 适应不断变化的用户需求:需要支持新的行为或输出格式?没问题。只需对新的SLM进行微调。

- 遵守不断变化的法规:借助SLM,你可以轻松适应不同市场的新法规,无需重新训练庞大的单体模型。

- 推动AI大众化:通过降低进入门槛,SLM有助于推动AI大众化,让更多的人和组织参与到语言模型的开发中。这将带来一个更加多元化、创新的AI生态系统。

未来之路:克服采用障碍

既然SLM的优点如此明显,我们为何仍然对LLM如此痴迷?论文指出了采用面临的三大障碍:

- 前期投入:AI行业已在集中式LLM推理基础设施上投入了数十亿美元,也不会在一夜之间放弃这笔庞大的投入。

- 通用基准:AI社区历来专注于通用基准,这导致人们偏向更庞大、更通用的模型。

- 缺乏意识:SLM的市场营销和媒体关注度远不及LLM,这意味着许多人根本不知道它们的潜力。

但这些并非不可逾越的障碍。随着SLM的经济效益越来越广为人知,以及支持SLM的新工具和基础设施日益开发,可以预见人们将逐渐从LLM转向以SLM为中心的方法。

LLM到SLM的转换算法

论文甚至提供了实现这一转变的路线图,即将智能体应用程序从LLM转换为SLM的六步算法:

- 使用数据安全收集:记录所有非HCI智能体调用,以捕获输入提示、输出响应及其他相关数据。

- 数据筛选和过滤:清除所有敏感数据,并准备用于微调的数据。

- 任务聚类:识别请求或内部智能体操作的重复模式,以定义适合SLM专业化的任务。

- SLM 选择:根据SLM的功能、性能、许可和部署占用空间,为每个任务选择最佳的SLM。

- 专业化 SLM微调:根据特定任务的数据集对所选择的SLM进行微调。

- 迭代和改进:使用新数据不断重新训练SLM和路由模型,以保持性能,并适应不断变化的使用模式。

这是一个切实可行的计划,任何组织都可以用来立即开始享受SLM的优势。

结论

AI革命已然到来,但使用能耗密集型的LLM无法实现可持续的规模化发展。未来将建立在面向智能体AI的SLM之上——设计小巧、高效且灵活。英伟达的研究论文既是一记警钟,又是一份路线图,质疑了业界对LLM的执念,同时证明了面向智能体AI的SLM能够以极低的成本提供相当的性能。这不仅仅侧重技术,更侧重打造一个更可持续性、公平、创新的AI生态系统。面向智能体AI的SLM这波即将到来的浪潮甚至会推动硬件创新,英伟达据称在开发专门针对这些紧凑小模型经过优化的专用处理单元。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

1809

1809

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?