📋 前置准备

1. 操作系统要求

-

Windows 10/11(64位)

-

macOS 11 Big Sur 或更新版本

-

Linux(Ubuntu 20.04/CentOS 8 或更新版本)

2. 硬件要求

-

最低配置:8GB内存 + 20GB硬盘空间

-

推荐配置:16GB内存 + NVIDIA显卡(显存4GB以上)

📥 第一步:安装Ollama框架

Windows用户

-

访问官网下载页

-

点击"Download for Windows"按钮

-

双击下载的

OllamaSetup.exe文件 -

一直点击"下一步"直到安装完成

macOS用户

# 打开终端执行以下命令(需安装Homebrew) /bin/bash -c "$(curl -fsSL https://ollama.com/install.sh)"

或

解压下载好的文件

双击打开,点击默认按钮——移动到应用程序目录下

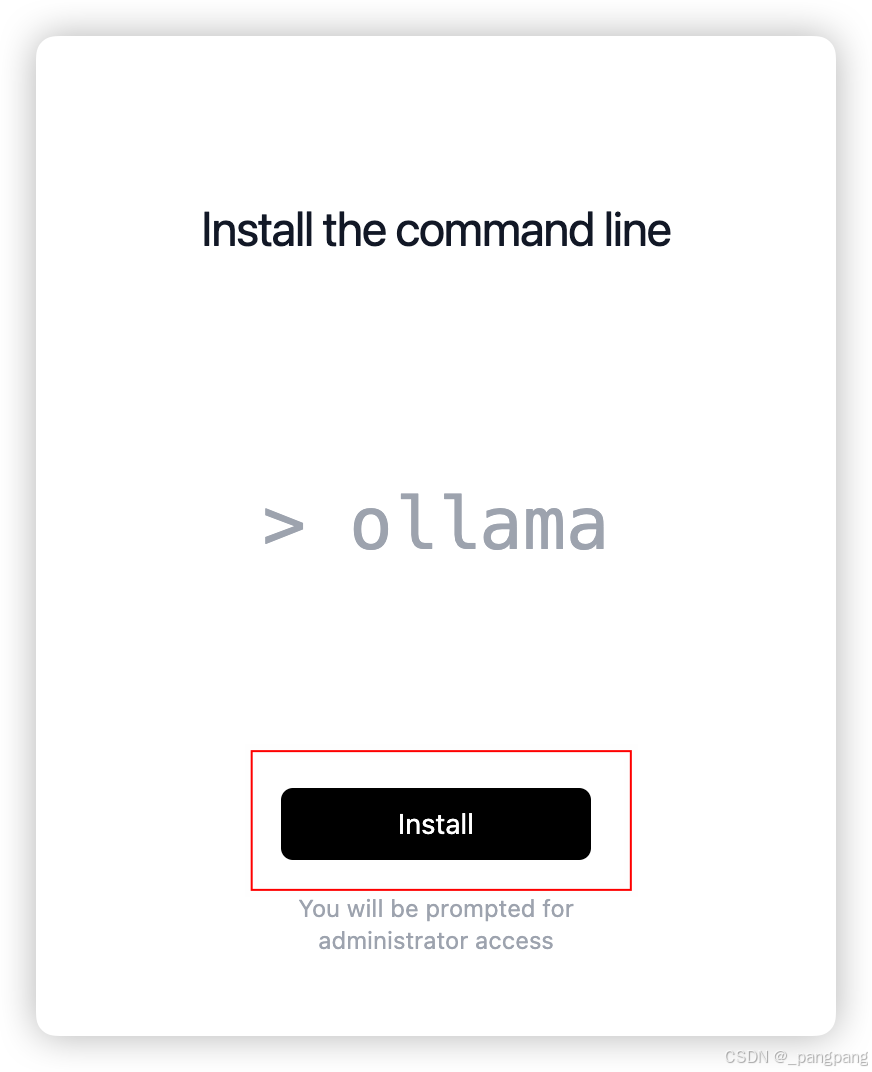

进入欢迎界面

点击下载命令行工具,需要输入电脑开机密码(后续可通过终端命令行进行提问)

Linux用户

# Ubuntu/Debian curl -fsSL https://ollama.com/install.sh | sh # CentOS/RHEL sudo yum install ollama -y

⚙️ 第二步:配置运行环境

验证安装是否成功

ollama --version # 看到版本号(如:ollama version 0.1.14)表示安装成功

启动后台服务(重要!)

# Windows用户双击桌面图标自动启动 # macOS/Linux用户进入“终端”执行: ollama serve

🚀 第三步:下载DeepSeek-R1模型

选择模型版本(根据电脑配置选择)

| 模型大小 | 内存要求 | 推荐显卡 |

|---|---|---|

| 7B | 8GB | 无要求 |

| 14B | 16GB | RTX 3060 |

| 32B | 32GB | RTX 4090 |

| 1.5B |

执行下载命令(以7B版本为例)

ollama run deepseek-r1:7b

下载过程演示

# 会看到类似以下进度条 pulling manifest... pulling 00e1317cbf74... ▕██████████████████▏ 4.6 GB/4.6 GB pulling 8c17c2ebb0ea... ▕██████████████████▏ 12 KB/12 KB verifying sha256 digest... writing manifest... success

🧪 第四步:测试模型运行

基础测试命令

# 输入对话指令 >>> 你好,请介绍一下你自己

预期成功响应

您好!我是由深度求索(DeepSeek)开发的智能助手DeepSeek-R1,擅长逻辑推理和复杂问题解答...

实际终端效果(Mac)

🛠️ 第五步:进阶使用技巧

1. 持续对话模式

ollama run deepseek-r1:7b --verbose # 输入多轮对话后按Ctrl+D退出

2. 本地API调用

curl http://localhost:11434/api/generate -d '{

"model": "deepseek-r1:7b",

"prompt": "中国的首都是哪里?"

}'

❌ 常见问题排查

Q1:下载模型时卡住不动

-

检查网络是否正常

-

尝试重启Ollama服务:

ollama serve restart

Q2:运行时提示显存不足

-

换用更小的模型版本(如从14B改为7B)

-

添加

--num-gpu 1参数限制GPU使用

Q3:中文显示乱码

-

终端设置为UTF-8编码

-

Windows用户建议使用Windows Terminal

📌 注意事项

-

首次运行需要下载约5-20GB数据(取决于模型版本)

-

建议保持电脑接通电源运行

-

复杂问题响应可能需要10-30秒时间

完成以上步骤后,您已成功在本地部署了DeepSeek-R1人工智能模型!可通过命令行或开发API进行调用。

3371

3371

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?