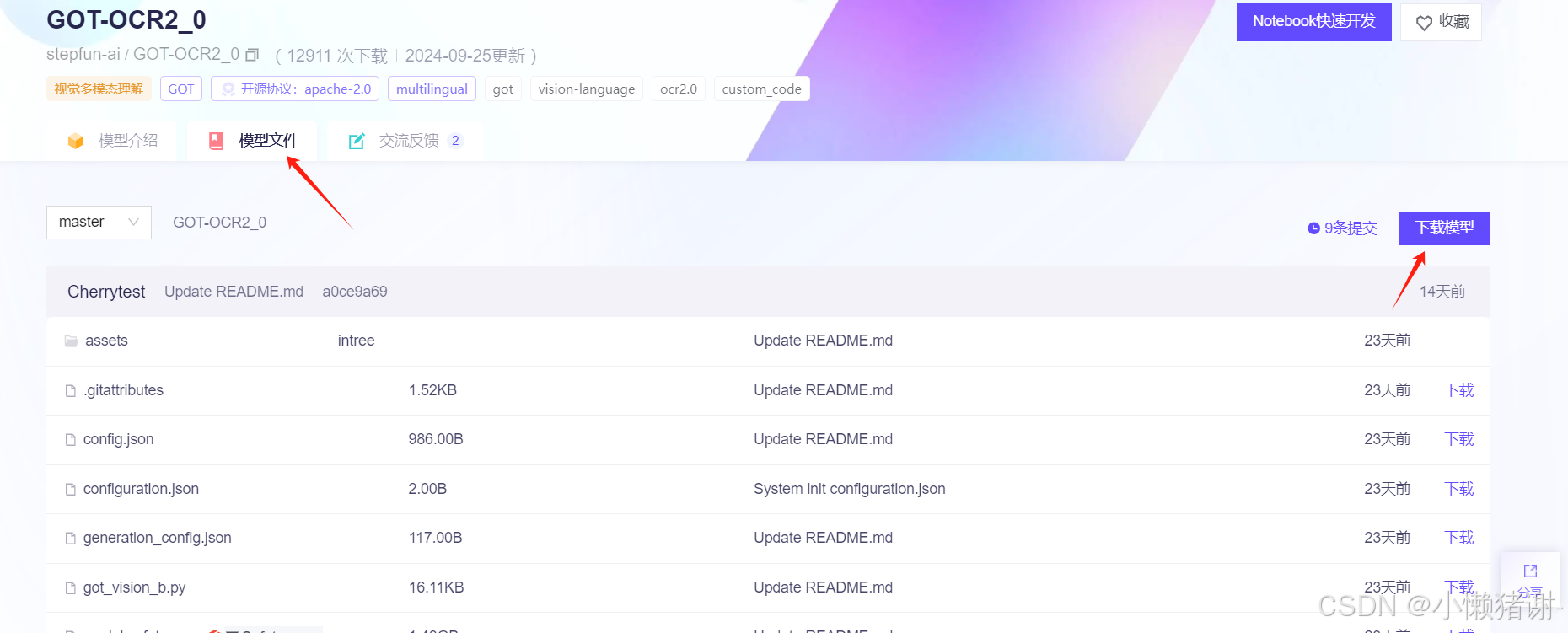

首先在modelscope

中选择自己想要的模型,因为要下载到本地运行,所以需要考虑自己的gpu能带动多少b的模型,不然就会出现“CUDA OUT OF MEMORY” 的错误

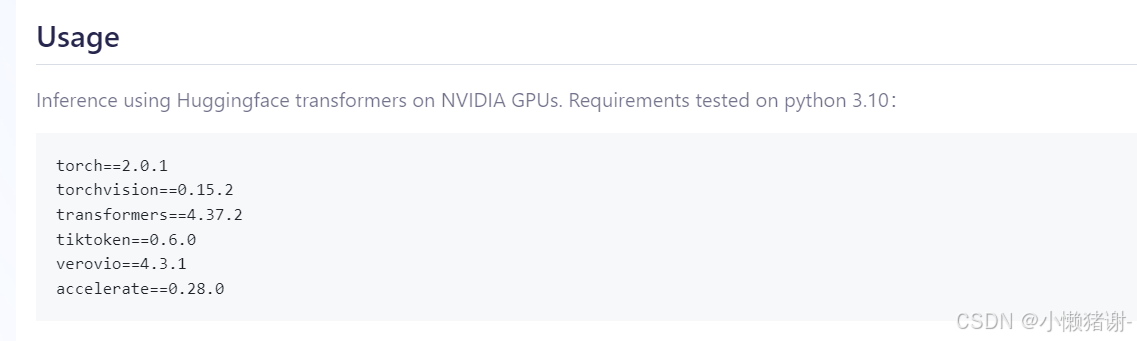

然后点击想要的模型,最好新建一个conda环境。来下载usage这里的package

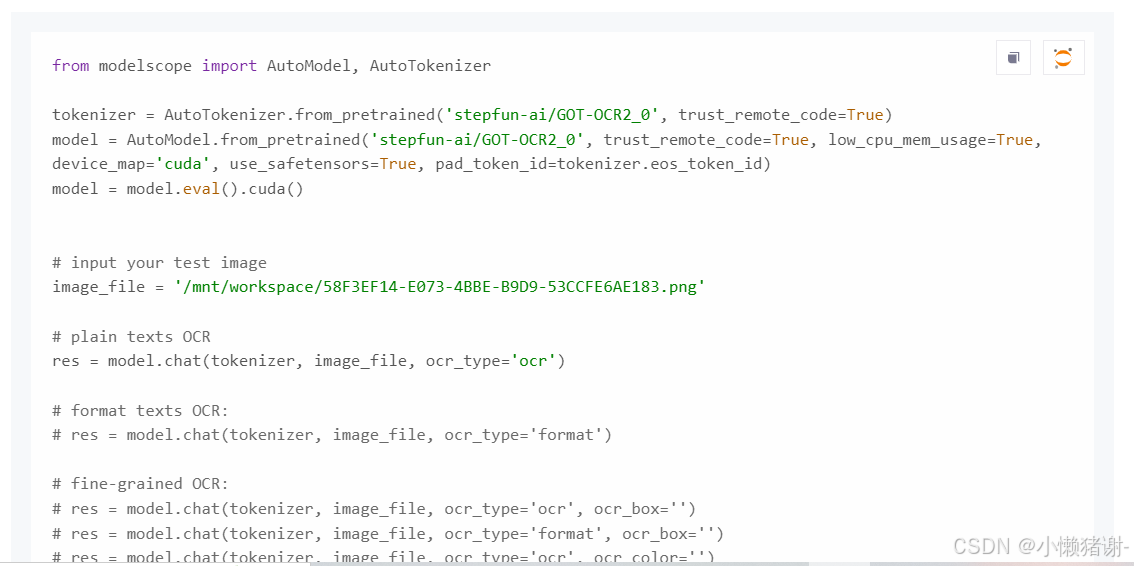

下面这个python文件是用来调用LLM的,如果在本地下载好了model的话,需要把这里的model = AutoModel.from_pretrain()这里的地址改一下,改成本地LLM所在的地址。

然后下载模型:这里用git下载最好了。就是看不到进度条……

然后再调试一下python文件就行了。

182

182

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?