论文地址:https://arxiv.org/pdf/1709.01134v1.pdf

这篇论文主要篇幅都花在实验上,对于wrpn的具体原理等并未详细介绍。下面简单介绍笔者对该论文的理解。

主要内容

该论文最大贡献就是在不影响网络精度的前提下,对于激活层的量化。

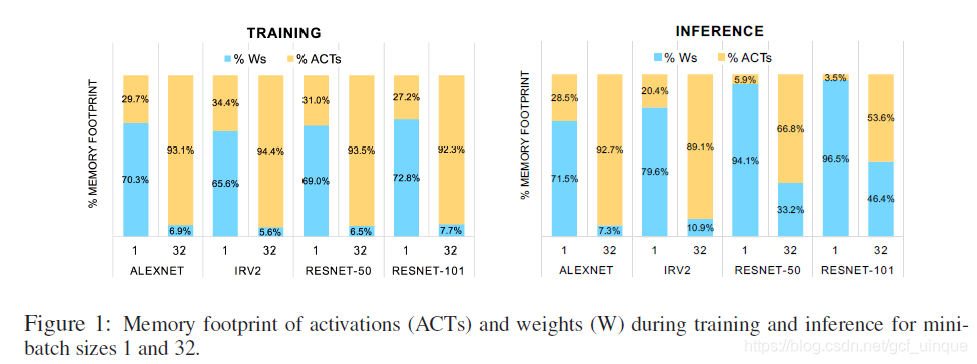

如下图所示,使用minibatch时,随着batch数量的增加,激活层占用的内存显著增加。所以,作者提出了激活层量化的wrpn方法。

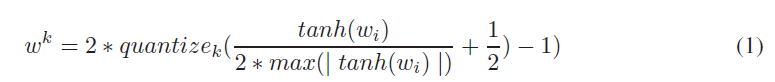

DoReFa的k位权重量化公式:

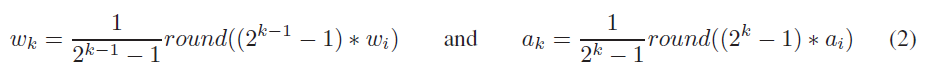

而WRPN则是在此基础上提出更简单的量化公式:

其中,权重是带符号的,故此留一位作为符号位(k-1);而激活值则是无符号的。

需要注意的是,事先要将权重限制在[-1,1],将激活值限制在[0,1],具体方法不限(如Tensorflow中的tf.clip_by_val函数)。

wrpn是作者通过大量实验总结所得出的,按照笔者的理解,就是增加特征图的同时降低精度,使得整体的复杂性比原本网络小得多,而且由于特征图的增加,量化后整个网络的精度反而不会降低多少。

这种方法还需要更多的实验结果进行支撑,有兴趣的可以尝试。

本文探讨了WRPN技术,一种在不牺牲网络精度的情况下,实现激活层量化的高效方法。通过对权重和激活值的量化,WRPN有效减少了内存占用,尤其是在使用minibatch时。论文提出了一种更简单的量化公式,适用于有符号权重和无符号激活值,并通过增加特征图同时降低精度,实现了整体复杂性的减少,同时保持了网络的高精度。

本文探讨了WRPN技术,一种在不牺牲网络精度的情况下,实现激活层量化的高效方法。通过对权重和激活值的量化,WRPN有效减少了内存占用,尤其是在使用minibatch时。论文提出了一种更简单的量化公式,适用于有符号权重和无符号激活值,并通过增加特征图同时降低精度,实现了整体复杂性的减少,同时保持了网络的高精度。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?