面向能源系统深度强化学习算法的性能比较 最优调度(代码)

# 面向能源系统深度强化学习算法性能比较之最优调度

在能源系统领域,随着智能化需求的不断提升,深度强化学习(DRL)算法在实现最优调度方面发挥着愈发关键的作用。不同的深度强化学习算法在性能上各有千秋,深入比较它们对于构建高效、稳定的能源调度系统至关重要。

## 深度强化学习算法在能源系统最优调度中的应用 深度强化学习结合了深度学习强大的特征提取能力和强化学习的决策优化机制。在能源系统中,我们通常将能源的分配、存储、消耗等状态作为环境状态输入给智能体,智能体基于当前状态采取动作(如调整发电功率、控制储能设备充放电等),然后根据环境反馈的奖励信号来不断优化策略,以达到最优调度的目标。

## 常见深度强化学习算法示例与性能考量 ### Q - Learning 算法 Q - Learning是一种经典的无模型强化学习算法。它通过维护一个Q表来记录在每个状态下采取每个动作的预期累计奖励。以下是简化的Q - Learning伪代码示例:

# 初始化 Q 表,Q[state][action]

Q = {}

for state in all_states:

Q[state] = {}

for action in all_actions:

Q[state][action] = 0

# 学习参数

alpha = 0.1 # 学习率

gamma = 0.9 # 折扣因子

num_episodes = 1000

for episode in range(num_episodes):

state = initial_state()

while not is_terminal(state):

# 选择动作,这里采用 ε - greedy 策略

if random.random() < epsilon:

action = random.choice(all_actions)

else:

action = max(Q[state], key=Q[state].get)

next_state, reward = take_action(state, action)

# 更新 Q 表

Q[state][action] = (1 - alpha) * Q[state][action] + alpha * (reward + gamma * max(Q[next_state].values()))

state = next_state

**代码分析**:首先初始化了Q表,它存储了状态 - 动作对的价值。在每一轮episode中,智能体从初始状态开始,根据ε - greedy策略选择动作,执行动作后得到下一个状态和奖励,然后依据Q - Learning的更新公式来更新Q表。这个算法简单直观,但在大规模状态空间下,Q表会变得非常庞大,导致存储和计算效率低下。

### Deep Q - Network(DQN)算法 DQN将深度学习引入强化学习,用神经网络来近似Q函数,从而解决了Q - Learning在大规模状态空间下的问题。下面是一个简单的DQN代码框架(基于PyTorch):

import torch

import torch.nn as nn

import torch.optim as optim

# 定义 Q 网络

class QNetwork(nn.Module):

def __init__(self, state_dim, action_dim):

super(QNetwork, self).__init__()

self.fc1 = nn.Linear(state_dim, 128)

self.fc2 = nn.Linear(128, 128)

self.fc3 = nn.Linear(128, action_dim)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

return self.fc3(x)

# 初始化网络、优化器等

state_dim = 10

action_dim = 5

q_network = QNetwork(state_dim, action_dim)

target_network = QNetwork(state_dim, action_dim)

optimizer = optim.Adam(q_network.parameters(), lr=0.001)

criterion = nn.MSELoss()

# 训练循环

num_episodes = 1000

for episode in range(num_episodes):

state = initial_state()

state = torch.FloatTensor(state).unsqueeze(0)

while not is_terminal(state):

# 选择动作

with torch.no_grad():

q_values = q_network(state)

action = torch.argmax(q_values).item()

next_state, reward = take_action(state, action)

next_state = torch.FloatTensor(next_state).unsqueeze(0)

reward = torch.FloatTensor([reward])

# 计算目标值

with torch.no_grad():

target_q = reward + gamma * torch.max(target_network(next_state))

current_q = q_network(state)[0][action]

loss = criterion(current_q, target_q)

optimizer.zero_grad()

loss.backward()

optimizer.step()

state = next_state

# 定期更新目标网络

if episode % target_update_freq == 0:

target_network.load_state_dict(q_network.state_dict())

**代码分析**:首先定义了Q网络,它是一个简单的全连接神经网络,接收状态作为输入,输出每个动作的Q值。在训练过程中,通过当前网络计算当前状态下采取动作的Q值,同时通过目标网络计算目标Q值,两者的均方误差作为损失进行反向传播优化。DQN通过经验回放和目标网络机制,使得学习过程更加稳定,能处理复杂的状态空间,但它依然存在一些局限性,比如对超参数敏感等。

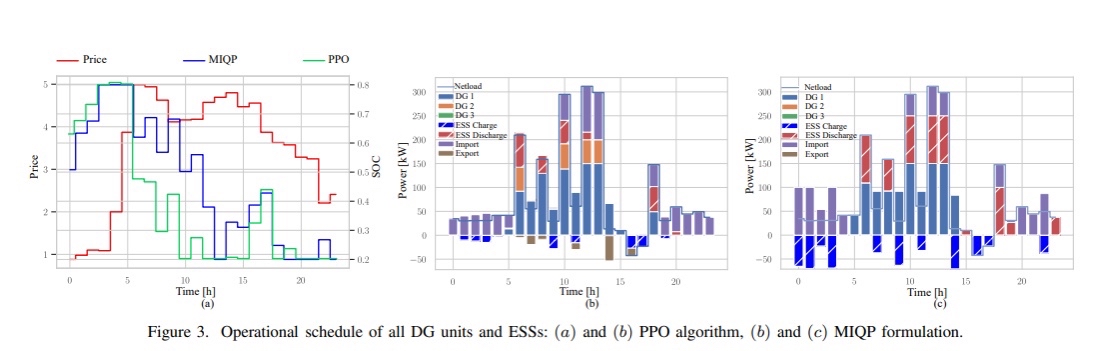

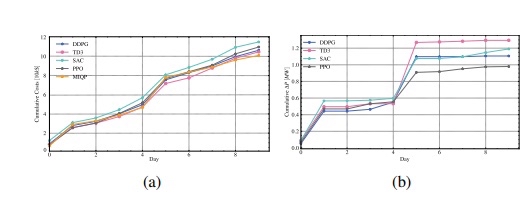

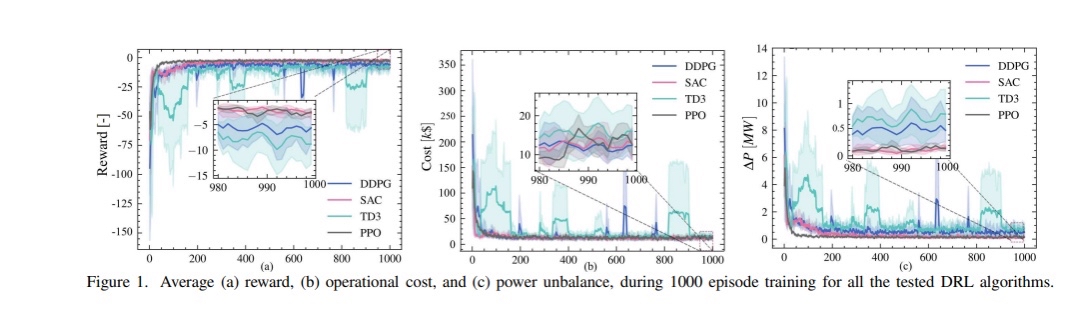

## 在能源系统最优调度中的性能比较 在能源系统最优调度场景下,不同算法性能差异明显。Q - Learning虽然原理简单,但由于需要存储庞大的Q表,在能源系统这种状态空间复杂的场景下,扩展性较差。而DQN能够有效处理高维状态空间,但训练过程容易出现不稳定,且收敛速度受超参数影响较大。

在实际应用中,我们需要根据能源系统的具体特点(如规模大小、状态变量的复杂程度等)来选择合适的深度强化学习算法,以实现最优调度,提升能源利用效率。通过不断地对比和优化算法,我们能够推动能源系统向更加智能、高效的方向发展。

以上只是对面向能源系统深度强化学习算法性能比较在最优调度方面的一个初步探讨,实际应用中还有更多的算法和细节值得深入研究。

深度强化学习在能源系统中的应用与性能比较

一、引言

随着人工智能技术的飞速发展,深度强化学习(Deep Reinforcement Learning,简称DRL)在多个领域展现出了强大的潜力。尤其在能源系统中,深度强化学习算法的应用逐渐成为研究的热点。本文将就面向能源系统的深度强化学习算法的性能进行比较,并特别关注最优调度方面的应用。

二、能源系统中的深度强化学习

在能源系统中,深度强化学习算法可以用于优化电力、热力、水力等能源的调度和分配。通过学习历史数据和实时数据,DRL可以自动地做出决策,以实现能源的高效利用和系统的稳定运行。

三、深度强化学习算法比较

在面向能源系统的深度强化学习中,有多种算法被广泛研究和应用。这里我们选择几种典型的算法进行比较。

1. 基于值函数的深度Q网络(DQN) DQN是一种经典的深度强化学习算法,通过逼近值函数来指导决策。在能源系统中,DQN可以用于电力负荷预测和调度优化。其优点是训练过程相对简单,但可能存在收敛速度慢的问题。

2. 基于策略的演员-评论家(Actor-Critic)算法 Actor-Critic算法通过分离策略网络和价值网络来指导决策。在能源系统中,Actor-Critic可以用于实时调度和优化,具有较好的收敛速度和决策准确性。

3. 优化器感知的RL算法 优化器感知的RL算法是一种新兴的DRL方法,结合了传统优化方法和深度学习的优势。在能源系统中,该方法可以快速找到最优调度方案,并具有良好的鲁棒性。

四、最优调度代码片段

下面是一个简单的基于Actor-Critic算法的最优调度代码片段:

# 定义策略网络和价值网络的结构

actor_model = ... # 使用神经网络定义策略网络结构

critic_model = ... # 使用神经网络定义价值网络结构

# 初始化DRL算法的参数和模型

optimizer = ... # 定义优化器,如Adam等

... # 其他初始化参数和设置

# 开始训练过程

for epoch in range(num_epochs):

# 训练策略网络和价值网络

for batch in data_loader: # 假设data_loader是包含训练数据的迭代器

... # 更新策略网络和价值网络的参数,使用Actor-Critic算法的更新规则

# 评估模型性能,如计算调度方案的准确性等指标

... # 评估代码逻辑

# 输出训练进度和性能指标等信息

print("Epoch {}, Loss: {:.4f}, Accuracy: {:.2f}%".format(epoch, loss_value, accuracy))

... # 其他日志记录或性能分析代码

五、总结与展望

本文对面向能源系统的深度强化学习算法进行了简要的比较和介绍,重点探讨了最优调度方面的应用和典型代码片段。随着人工智能技术的不断发展,深度强化学习在能源系统中的应用将更加广泛和深入。未来研究将关注如何进一步提高算法的性能和鲁棒性,以及如何将DRL与其他优化方法相结合,以实现更高效的能源管理和调度。

6482

6482

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?