大模型DPO强化学习微调验证过程

💪 为什么必须进行强化学习验证

1. 证明微调有效性

科学验证必要

- 证明投入值得:DPO训练消耗了时间和算力资源,必须证明确实有提升

- 避免自欺欺人:仅看loss曲线下降不足以说明实际应用效果

- 数据支撑决策:为后续优化方向提供明确的数据依据

2. 发现具体改进点

细致效果分析

- 语言风格变化:原始模型偏技术性,DPO后更加亲和温暖

- 专业性提升:能够给出更具体、更实用的专业建议

- 服务意识增强:主动提供额外的贴心提示和后续引导

3. 质量控制保证

防止负面效应

- 确保基础能力未退化:验证微调没有损害模型的基本推理能力

- 检查过拟合风险:确保模型没有只记住训练数据而失去泛化能力

- 发现潜在问题:及时发现可能的偏见或错误倾向

4. 业务价值验证

商业效果评估

- 转化率预期:更专业贴心的回答预期能提升客户转化率

- 客户满意度:温暖专业的服务体验有助于提升客户满意度

- 运营成本优化:AI处理更多专业咨询,减少人工客服压力

📊 验证结果的应用价值

通过系统性的验证,我们能够:

- 量化微调效果:用具体案例证明DPO训练的价值

- 识别优化方向:发现哪些方面还需要进一步改进

- 建立评估标准:为后续类似项目提供评估方法论

- 支撑业务决策:为模型上线和推广提供数据支撑

顶级技术资源聚合

- 免费获取市面稀缺内容:部分免费课程资源对标万元级付费培训(二次源码开发,公开课价值含量都非常高

- 大厂技术总监级导师研发:提供一线工程经验与架构设计思维

😰 DPO强化学习验证的难度

1. 技术实现难度

内存管理挑战

def clear_memory(self):

"""需要频繁清理GPU内存避免OOM"""

if self.current_model:

del self.current_model

del self.current_tokenizer

gc.collect()

torch.cuda.empty_cache()

模型兼容性问题

- Flash Attention兼容性问题需要降级到eager模式

- 不同模型的tokenizer和生成配置差异

- 设备映射和精度配置的复杂性

2. 评估标准主观性

缺乏客观指标

- 专业性、温暖度、实用性等很难量化

- 需要人工判断"哪个回答更好"

- 不同评估者可能有不同偏好

评估工作量大

- 每个问题需要逐一对比两个回答

- 需要具备相关专业知识才能准确评估

- 大量样本评估耗时耗力

3. 资源消耗高

计算资源需求

- 需要重复加载两个大模型进行推理

- 每个问题都要运行两次生成过程

- GPU内存需求较大,处理速度相对较慢

🔍 DPO强化学习验证方法

1. A/B对比测试法

文档中采用了ModelComparator序列化模型对比器的方法:

# 核心对比逻辑

对比方案:

- 模型A:原始微调模型 (/root/autodl-tmp/FT-Qwen3-4B)

- 模型B:DPO强化微调模型 (/root/autodl-tmp/FT-Qwen3-4B_DPO)

- 测试数据:随机抽取10个专业儿童服装咨询问题

- 输出格式:JSONL格式,包含问题和两个模型的回答

2. 实际场景验证法

验证数据来源:使用真实的儿童服装专业咨询场景

- 专业尺码建议问题

- 儿童安全专业知识问题

- 儿童行为习惯匹配问题

- 季节性专业搭配问题

- 儿童心理与偏好问题

基础数据准备

import json

import random

import time

from openai import OpenAI

from concurrent.futures import ThreadPoolExecutor

# 配置

API_KEY = "个人deepseek apikey"

client = OpenAI(api_key=API_KEY, base_url="https://api.deepseek.com")

# 儿童服装专业场景(容易出微调效果的)

question_templates = {

"专业尺码建议": [

"我家宝宝{age}个月,{height}cm,{weight}斤,现在是{season},这件{item}选什么码合适?会不会买大了?",

"孩子{age}岁,比同龄人{size_diff}一些,平时{brand}牌子穿{size}码,你们家这件{item}建议选什么码?",

"双胞胎宝宝,一个{weight1}斤一个{weight2}斤,都{age}岁,这款{item}怎么选码?",

],

"儿童安全专业知识": [

"这件{item}的拉链是什么材质?会不会划伤宝宝皮肤?有没有防夹设计?",

"宝宝{age}个月,正在长牙期,这件衣服的纽扣会不会被咬掉?安全吗?",

"孩子有异位性皮炎,这个面料的pH值是多少?会刺激皮肤吗?",

"这件{item}符合GB31701-2015标准吗?甲醛含量多少?",

],

"儿童行为习惯匹配": [

"我家宝宝{age}岁,特别爱在地上爬,这件{item}耐脏吗?膝盖部分会不会很快磨破?",

"孩子{age}岁,还不会自己上厕所,这件{item}方便脱吗?松紧带会不会勒肚子?",

"宝宝{age}个月,正在学走路,经常摔倒,这件{item}的面料厚度够保护吗?",

"孩子特别好动,上蹿下跳的,这件{item}的接缝结实吗?会不会开线?",

],

"季节性专业搭配": [

"现在{season},温度{temp}度,孩子{age}岁,这件{item}里面需要穿什么?怎么搭配不会热?",

"马上要{next_season}了,这件{item}能穿到什么时候?需要买大一码为明年准备吗?",

"孩子{age}岁,{season}去{place}旅游,这套{item}搭配合适吗?需要带什么备用衣服?",

],

"儿童心理与偏好": [

"我家{gender}宝{age}岁,特别喜欢{character},不喜欢{dislike},这件{item}的设计孩子会喜欢吗?",

"孩子{age}岁,刚上幼儿园,比较内向,这件{item}的颜色会不会太{color_type}?",

"宝宝{age}个月,对声音很敏感,这件{item}的装饰会不会有声音?会影响睡觉吗?",

]

}

# 专业变量池(更具体、更专业)

variables = {

"age": ["6个月", "10个月", "1岁", "1岁半", "2岁", "3岁", "4岁", "5岁"],

"height": ["70", "75", "80", "85", "90", "95", "100", "105", "110"],

"weight": ["16", "18", "20", "22", "24", "26", "28", "30", "32"],

"season": ["春天", "夏天", "秋天", "冬天", "换季"],

"next_season": ["夏天", "秋天", "冬天", "春天"],

"item": ["连体衣", "分体睡衣", "外出服", "家居服", "防踢被", "爬服"],

"size_diff": ["偏瘦", "偏胖", "偏高", "偏矮"],

"brand": ["优衣库", "Gap", "Zara", "HM", "Carter's"],

"size": ["80", "90", "100", "110", "120"],

"weight1": ["20", "22", "24"],

"weight2": ["18", "21", "23"],

"temp": ["15-20", "20-25", "25-30", "10-15"],

"place": ["海边", "山区", "北方", "南方", "国外"],

"gender": ["男", "女"],

"character": ["小猪佩奇", "汪汪队", "冰雪奇缘", "超级飞侠"],

"dislike": ["太花哨的图案", "硬质装饰", "紧身设计"],

"color_type": ["鲜艳", "暗淡", "成熟"]

}

def generate_question():

category = random.choice(list(question_templates.keys()))

template = random.choice(question_templates[category])

question = template

for var, values in variables.items():

if f"{{{var}}}" in question:

question = question.replace(f"{{{var}}}", random.choice(values))

return question, category

def batch_generate_response(questions_batch):

# 针对不同类别使用专业的system prompt

system_prompts = {

"专业尺码建议": "你是资深的儿童服装尺码专家,有10年经验。要考虑儿童生长发育特点、季节因素、品牌差异,给出精准的尺码建议和理由。",

"儿童安全专业知识": "你是儿童用品安全专家,熟悉国标GB31701-2015,了解各种材质和工艺的安全性,要给出专业的安全评估。",

"儿童行为习惯匹配": "你是儿童发展心理学专家,了解各年龄段儿童的行为特点和生理需求,能根据孩子习惯推荐合适的服装功能。",

"季节性专业搭配": "你是儿童服装搭配师,精通不同季节、地区、温度下的儿童穿搭,能给出实用的搭配方案。",

"儿童心理与偏好": "你是儿童心理专家,了解不同年龄段孩子的心理特点和审美偏好,能推荐符合儿童心理需求的服装。"

}

combined_prompt = "请为以下专业的儿童服装咨询问题分别给出详细专业的回答,体现你的专业知识和经验,每个回答用\"---\"分隔:\n\n"

categories = []

for i, (question, category) in enumerate(questions_batch, 1):

combined_prompt += f"{i}. {question}\n"

categories.append(category)

# 使用第一个问题的类别作为主要专业方向

main_category = categories[0]

try:

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": system_prompts[main_category]},

{"role": "user", "content": combined_prompt}

],

temperature=0.7,

max_tokens=2000

)

full_response = response.choices[0].message.content.strip()

answers = full_response.split("---")

cleaned_answers = []

for answer in answers:

cleaned = answer.strip()

if cleaned.startswith(("1.", "2.", "3.", "4.", "5.")):

cleaned = cleaned[2:].strip()

cleaned_answers.append(cleaned)

return cleaned_answers[:len(questions_batch)]

except Exception as e:

print(f"批量API调用失败: {e}")

return [f"抱歉,这个问题比较专业,建议您联系我们的儿童服装专家客服获得详细解答。" for _ in questions_batch]

# 其余代码保持不变...

def process_batch(batch_questions):

answers = batch_generate_response(batch_questions)

results = []

for (question, category), answer in zip(batch_questions, answers):

sample = {

"instruction": "作为专业的儿童服装顾问,请根据儿童发育特点、安全标准、行为习惯等专业知识回答问题。",

"input": question,

"output": answer

}

results.append(sample)

return results

# 生成数据的代码保持不变...

print("生成专业儿童服装问题中...")

all_questions = []

used_questions = set()

while len(all_questions) < 150:

question, category = generate_question()

if question not in used_questions:

used_questions.add(question)

all_questions.append((question, category))

print(f"生成了{len(all_questions)}个专业问题")

# 批量处理

print("开始批量生成专业回答...")

batch_size = 5 # 专业问题复杂,减少批次大小

all_data = []

with ThreadPoolExecutor(max_workers=2) as executor:

futures = []

for i in range(0, len(all_questions), batch_size):

batch = all_questions[i:i+batch_size]

future = executor.submit(process_batch, batch)

futures.append(future)

for i, future in enumerate(futures):

try:

batch_results = future.result(timeout=45)

all_data.extend(batch_results)

print(f"完成批次 {i+1}/{len(futures)}, 已生成 {len(all_data)} 条专业数据")

except Exception as e:

print(f"批次 {i+1} 处理失败: {e}")

time.sleep(0.5)

print("专业数据生成完成!")

# 保存文件

random.shuffle(all_data)

train_data = all_data[:130]

test_data = all_data[130:150]

with open('train.jsonl', 'w', encoding='utf-8') as f:

for item in train_data:

f.write(json.dumps(item, ensure_ascii=False) + '\n')

with open('test.jsonl', 'w', encoding='utf-8') as f:

for item in test_data:

f.write(json.dumps(item, ensure_ascii=False) + '\n')

print(f"训练集: train.jsonl ({len(train_data)}条)")

print(f"测试集: test.jsonl ({len(test_data)}条)")

点击加入 -> 赋范空间社区 :

带你攻克LLM工业级全栈技术开发!10+工业级方案,还有更多持续更新Agent、模型微调、RAG、MCP、多模态等课程

微调结果对比

对比方案设计

import json

import random

import torch

import gc

from datetime import datetime

from typing import List, Dict

from tqdm import tqdm

class ModelComparator:

"""序列化模型对比生成器"""

def __init__(self, data_path: str, model_a: str, model_b: str,

sample_size: int = 10, output_file: str = "comparison.jsonl"):

self.data_path = data_path

self.model_a_path = model_a

self.model_b_path = model_b

self.sample_size = sample_size

self.output_file = output_file

self.current_model = None

self.current_tokenizer = None

def load_questions(self) -> List[Dict]:

"""加载并随机抽样问题"""

print(f"加载数据: {self.data_path}")

samples = []

with open(self.data_path, 'r', encoding='utf-8') as f:

for line in f:

try:

samples.append(json.loads(line.strip()))

except json.JSONDecodeError:

continue

selected = random.sample(samples, min(self.sample_size, len(samples)))

print(f"抽取 {len(selected)} 个样本")

return selected

def format_question(self, sample: Dict) -> str:

"""格式化问题文本"""

instruction = sample.get("instruction", "")

input_text = sample.get("input", "")

if input_text:

return f"{instruction}\n\n{input_text}"

return instruction

def clear_memory(self):

"""清理GPU内存和垃圾回收"""

if self.current_model:

del self.current_model

del self.current_tokenizer

self.current_model = None

self.current_tokenizer = None

gc.collect()

if torch.cuda.is_available():

torch.cuda.empty_cache()

def load_model(self, model_path: str):

"""加载模型 - 简化版本,避免Flash Attention错误"""

from transformers import AutoTokenizer, AutoModelForCausalLM

import warnings

# 屏蔽警告

warnings.filterwarnings("ignore", category=UserWarning)

self.clear_memory()

print(f"加载模型: {model_path}")

# 加载tokenizer

self.current_tokenizer = AutoTokenizer.from_pretrained(

model_path,

trust_remote_code=True,

use_fast=False

)

# 加载模型 - 直接使用eager attention,避免Flash Attention

self.current_model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.bfloat16,

device_map="auto",

trust_remote_code=True,

low_cpu_mem_usage=True,

attn_implementation="eager" # 直接使用eager,不尝试flash_attention_2

)

self.current_model.eval()

print("模型加载完成")

def generate_answer(self, question: str) -> str:

"""生成回答 - 修复生成配置警告"""

try:

# 构建对话格式

messages = [{"role": "user", "content": question}]

text = self.current_tokenizer.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

# 编码

inputs = self.current_tokenizer(

text,

return_tensors="pt",

truncation=True,

max_length=2048

).to(self.current_model.device)

# 生成 - 修复配置

with torch.no_grad():

outputs = self.current_model.generate(

**inputs,

max_new_tokens=512,

do_sample=True, # 改为True

temperature=0.7, # 配合do_sample=True

top_p=0.9,

pad_token_id=self.current_tokenizer.eos_token_id,

eos_token_id=self.current_tokenizer.eos_token_id

)

# 解码

response = self.current_tokenizer.decode(

outputs[0][inputs['input_ids'].shape[-1]:],

skip_special_tokens=True

).strip()

return response

except Exception as e:

return f"生成失败: {str(e)}"

def run_comparison(self):

"""执行模型对比流程"""

print("开始模型对比")

questions = self.load_questions()

results = []

for i, sample in enumerate(tqdm(questions, desc="处理中")):

question = self.format_question(sample)

print(f"\n问题 {i+1}: {question[:50]}...")

# 模型A生成

self.load_model(self.model_a_path)

answer_a = self.generate_answer(question)

print("模型A完成")

# 模型B生成

self.load_model(self.model_b_path)

answer_b = self.generate_answer(question)

print("模型B完成")

# 保存结果

result = {

"question": question,

"answer_A": answer_a,

"answer_B": answer_b,

"best_answer": ""

}

results.append(result)

self.save_results(results)

self.clear_memory()

print(f"\n完成! 生成 {len(results)} 个对比")

return results

def save_results(self, results: List[Dict]):

"""保存到JSONL文件"""

with open(self.output_file, 'w', encoding='utf-8') as f:

for result in results:

f.write(json.dumps(result, ensure_ascii=False) + '\n')

def main():

"""主函数"""

# 全局屏蔽警告

import warnings

warnings.filterwarnings("ignore")

config = {

"data_path": "/root/train.jsonl",

"model_a": "/root/autodl-tmp/FT-Qwen3-4B",

"model_b": "/root/autodl-tmp/FT-Qwen3-4B_DPO",

"sample_size": 10,

"output_file": "comparison3.jsonl"

}

comparator = ModelComparator(**config)

results = comparator.run_comparison()

# 预览

if results:

print(f"\n预览:")

sample = results[0]

print(f"问题: {sample['question'][:80]}...")

print(f"回答A: {sample['answer_A'][:80]}...")

print(f"回答B: {sample['answer_B'][:80]}...")

if __name__ == "__main__":

main()

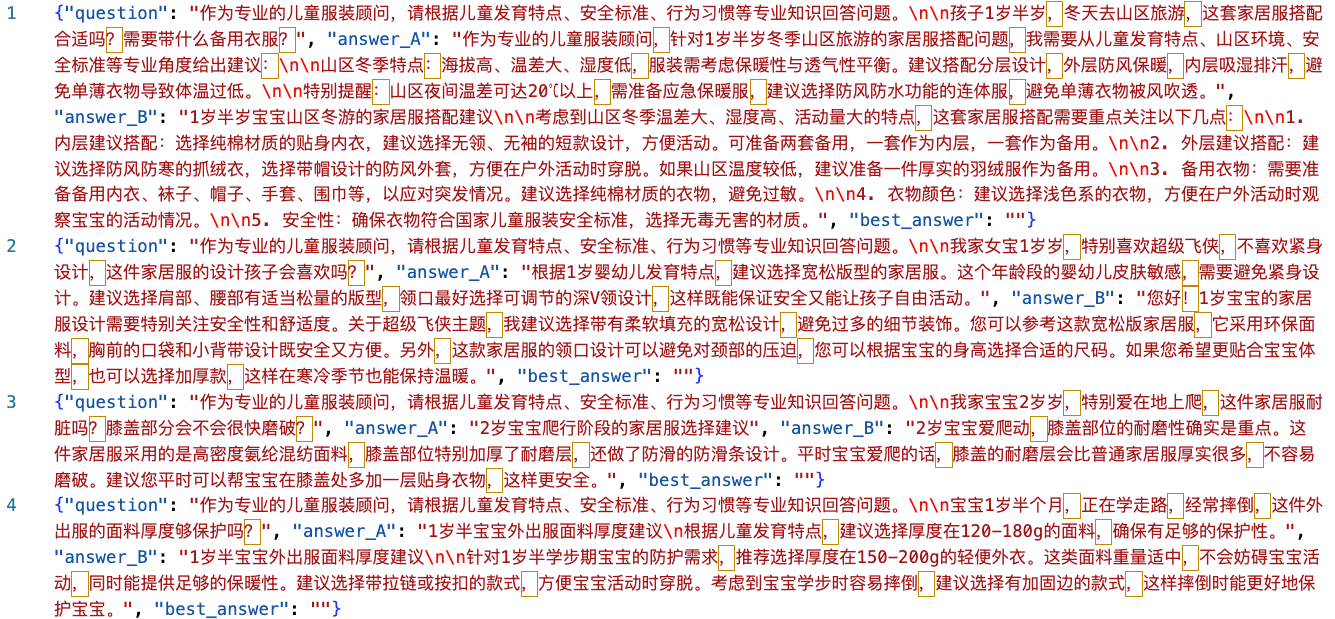

预览:

问题: 作为专业的儿童服装顾问,请根据儿童发育特点、安全标准、行为习惯等专业知识回答问题。

孩子1岁半岁,冬天去山区旅游,这套家居服搭配合适吗?需要带什么备用衣服?...

回答A: 作为专业的儿童服装顾问,针对1岁半岁冬季山区旅游的家居服搭配问题,我需要从儿童发育特点、山区环境、安全标准等专业角度给出建议:

山区冬季特点:海拔高、温差大、...

回答B: 1岁半岁宝宝山区冬游的家居服搭配建议

考虑到山区冬季温差大、湿度高、活动量大的特点,这套家居服搭配需要重点关注以下几点:

1. 内层建议搭配:选择纯棉材质的...

点击加入 -> 赋范空间社区 :

带你攻克LLM工业级全栈技术开发!10+工业级方案,还有更多持续更新Agent、模型微调、RAG、MCP、多模态等课程

DPO微调效果验证方法

DPO微调效果验证方法

129

129

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?