偏置及权重

代码分解与解释

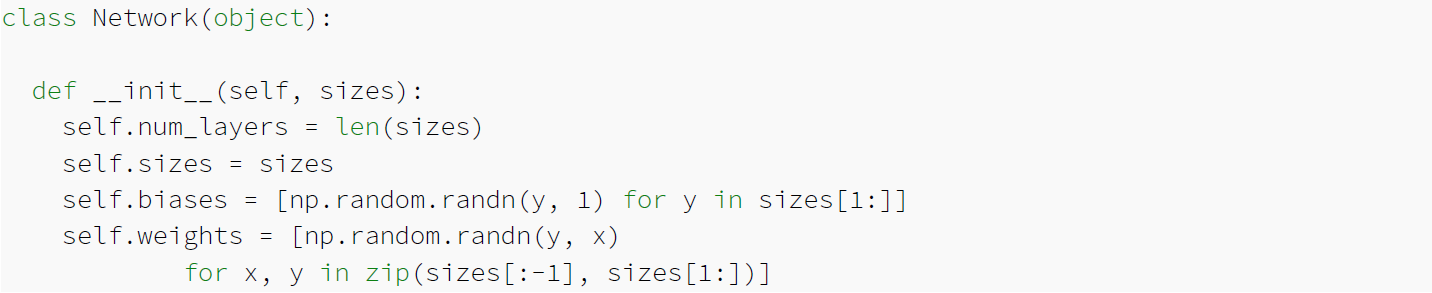

1. __init__(self, sizes)

这个方法是类的构造函数,用于初始化神经网络。

-

** 参数

sizes** : 是一个列表,表示神经网络每一层的神经元数量。-

例如,如果

sizes = [3, 5, 2],表示:- 输入层有 3 个神经元,

- 隐藏层有 5 个神经元,

- 输出层有 2 个神经元。

-

-

**

self.num_layers** : 表示网络的层数,等于sizes 的长度。- 例如,

sizes = [3, 5, 2],则self.num_layers = 3。

- 例如,

-

**

self.sizes** : 保存传入的sizes。

2. 初始化偏置(biases)

self.biases = [np.random.randn(y, 1) for y in sizes[1:]]

- 偏置是神经网络每一层的可训练参数,用来调整神经元的输出。

-

np.random.randn(y, 1) 生成一个形状为(y, 1) 的随机数矩阵(标准正态分布),表示该层神经元的偏置。 -

sizes[1:] 表示从第二层(隐藏层或输出层)开始每一层的神经元数量,因为输入层没有偏置。

例如,sizes = [3, 5, 2]:

- 第一个隐藏层有 5 个神经元,偏置形状为

(5, 1)。 - 输出层有 2 个神经元,偏置形状为

(2, 1)。

最终,self.biases 是一个包含多个偏置矩阵的列表。

3. 初始化权重(weights)

self.weights = [np.random.randn(y, x) for x, y in zip(sizes[:-1], sizes[1:])]

-

权重是神经网络中连接两层神经元的参数,用来对输入进行加权求和。

-

zip(sizes[:-1], sizes[1:]) 生成了相邻两层的神经元数对。例如,sizes = [3, 5, 2],则zip(sizes[:-1], sizes[1:]) = [(3, 5), (5, 2)]。 -

np.random.randn(y, x) 生成一个形状为(y, x) 的随机权重矩阵,其中:-

x 是上一层的神经元数, -

y 是当前层的神经元数。

-

例如,sizes = [3, 5, 2]:

- 第一个权重矩阵的形状为

(5, 3),连接输入层和隐藏层。 - 第二个权重矩阵的形状为

(2, 5),连接隐藏层和输出层。

最终,self.weights 是一个包含多个权重矩阵的列表。

举例说明

定义一个神经网络

假设我们想定义一个具有 3 个输入神经元、5 个隐藏神经元和 2 个输出神经元的网络:

# 导入 NumPy

import numpy as np

# 定义网络

sizes = [3, 5, 2]

net = Network(sizes)

# 查看偏置和权重

print("Number of layers:", net.num_layers) # 输出层数

print("Biases shapes:")

for bias in net.biases:

print(bias.shape)

print("\nWeights shapes:")

for weight in net.weights:

print(weight.shape)

输出结果

Number of layers: 3

Biases shapes:

(5, 1)

(2, 1)

Weights shapes:

(5, 3)

(2, 5)

解释:

-

神经网络有 3 层(输入层、隐藏层、输出层)。

-

偏置矩阵:

- 隐藏层偏置的形状为

(5, 1)。 - 输出层偏置的形状为

(2, 1)。

- 隐藏层偏置的形状为

-

权重矩阵:

- 输入层到隐藏层的权重矩阵形状为

(5, 3)。 - 隐藏层到输出层的权重矩阵形状为

(2, 5)。

- 输入层到隐藏层的权重矩阵形状为

在神经网络中,偏置的形状是指每一层的偏置矩阵的维度(即矩阵的行数和列数)。偏置用于调整神经元的线性组合结果,从而提升模型的表达能力。

偏置形状由该层的神经元数量决定,因为每个神经元都会有一个对应的偏置值。

偏置的作用

在神经网络的每一层,每个神经元的输出是输入的加权和再加上一个偏置值,然后通过激活函数进行非线性变换:

z=W⋅x+bz = W \cdot x + bz=W⋅x+b其中:

- WWW:权重矩阵,表示两层之间的连接权重。

- xxx:上一层的输出(或输入)。

- bbb:偏置,通常是一个列向量,给每个神经元加上一个偏移值。

偏置的形状决定了其如何匹配神经元的数量。

偏置形状的确定

偏置的形状规则:

-

对于每一层神经网络的神经元,偏置是一个列向量,其维度是 (n,1)(n, 1)(n,1),其中:

- nnn 是该层的神经元数量。

为什么偏置是列向量?

- 在神经网络的计算中,偏置需要加到加权求和的结果上,而加权求和结果通常是一个列向量。

- 偏置列向量与每个神经元一一对应,使得每个神经元都有一个独立的偏移值。

举例说明

假设我们有一个神经网络,其中每一层的神经元数量为 [3, 5, 2](分别是输入层、隐藏层和输出层)。

偏置的形状

-

隐藏层有 5 个神经元,所以偏置的形状为 (5,1)(5, 1)(5,1):

b隐藏层=[b1b2b3b4b5] b_{\text{隐藏层}} = \begin{bmatrix} b_1 \\ b_2 \\ b_3 \\ b_4 \\ b_5 \end{bmatrix} b隐藏层=b1b2b3b4b5

-

输出层有 2 个神经元,所以偏置的形状为 (2,1)(2, 1)(2,1):

b输出层=[b1b2] b_{\text{输出层}} = \begin{bmatrix} b_1 \\ b_2 \end{bmatrix} b输出层=[b1b2]

输入层没有偏置,因为输入层只是数据的传递,不做计算。

代码演示

假设我们用 numpy 初始化一个神经网络的偏置,形状由神经元数量决定:

import numpy as np

# 假设每层的神经元数量

sizes = [3, 5, 2] # 输入层: 3, 隐藏层: 5, 输出层: 2

# 初始化偏置

biases = [np.random.randn(y, 1) for y in sizes[1:]]

# 查看偏置的形状

for i, bias in enumerate(biases):

print(f"Layer {i + 1} bias shape: {bias.shape}")

输出结果:

Layer 1 bias shape: (5, 1)

Layer 2 bias shape: (2, 1)

解释:

- 第一层偏置(隐藏层)对应 5 个神经元,形状为 (5,1)(5, 1)(5,1)。

- 第二层偏置(输出层)对应 2 个神经元,形状为 (2,1)(2, 1)(2,1)。

偏置与权重的对比

| 属性 | 偏置 (bbb) | 权重 (WWW) |

|---|---|---|

| 形状 | (n,1)(n, 1)(n,1),nnn是神经元数 | (n,m)(n, m)(n,m),mmm是上一层神经元数,nnn是当前层神经元数 |

| 作用 | 调整神经元的输出值 | 决定输入和当前层之间的加权关系 |

| 是否唯一 | 每个神经元有一个偏置 | 每个输入到当前层的连接都有一个权重 |

3473

3473

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?