一、 聊天机器人简介

1. 什么是聊天机器人

- 基本定义:一个用来模拟人类对话或聊天的程序

- 关键问题:机器如何判断一条输入句子的合理性?机器的回复是否是人类可以理解的或者是人类习惯在日常生活中习惯表达的?

- 主要应用:客服支持、智能助手、社交互动、教育学习

- 解决方法:利用自然语言处理、机器学习等技术。

2. 聊天机器人特点

- 自然语言理解(NLP):能够理解用户输入自然语言,并从中提取意图和关键信息。

- 对话管理:通过对话引擎维持对话的连贯性,根据上下文生成合适的回答。

- 个性化交互:可以根据用户的历史记录和偏好提供定制化的回答。

- 多功能性:除了聊天,还可以执行任务,如查询信息、预订服务、提供帮助等。

3. 聊天机器人应用场景

- 客户服务:在电商、金融等领域,自动解答用户问题,提供24*7的客户支持。

- 娱乐:一些聊天机器人可以与用户进行趣味对话,提供娱乐体验。

- 教育:用于语言学习、知识问答等教育场景。

- 智能家居:控制家电设备,如灯光、空调等。

- 医疗健康:提供健康咨询、预约挂号等服务。

4. 常见的聊天机器人

• DeepSeek:由杭州深度求索人工智能基础技术研究有限公司研发,其核心优势在于性能卓越、低成本开发和开源策略

• Kimi智能助手:由月之暗面科技有限公司开发,支持超长上下文(最高200万汉字),适合长文本处理和复杂对话。

• 通义千问:阿里云推出的人工智能助手,适合办公场景,提供高效的信息处理能力。

• 讯飞星火:科大讯飞出品,支持语音输入和语音朗读回复,适合语音交互场景。

• 豆包:字节跳动推出,支持抖音和今日头条的内容信息获取,适合内容创作和信息检索。

5. 常见搭建聊天机器人方式

① 使用无代码平台搭建

② 使用开源框架搭建

③ 基于大预言模型的集成

5.1 使用无代码平台搭建

无代码平台允许用户通过可视化界面快速创建聊天机器人,无需编程基础。

例如,扣子(Coze)是一个由字节跳动开发的智能体应用开发平台,支持集成多种大语言模型(如DeepSeek),并可以快速接入微信公众号。

搭建步骤:

- 注册并登录平台:访问扣子官网,使用抖音或飞书扫码登录。

- 创建应用:填写智能体名称、功能介绍和图标。

- 配置机器人:

▪ 选择模型(如DeepSeek或其他大模型)

▪ 添加插件(如联网、绘画等)

▪ 编写开场白并测试对话效果 - 接入平台:将机器人接入微信公众号或其他平台,配置必要的参数(如AppID)

5.2 使用开源框架搭建

如果你有一定的编程基础,可以使用开源框架(如ChatterBot和Web框架(如Flask)来开发聊天机器人。

其中,ChatterBot是一个开源的Python库,用于创建聊天机器人。它通过机器学习技术来生成对话内容,能够根据用户输入自动学习和生成回答。

ChatterBot库对话生成能力有限,生成文本可能不够自然,大模型出来之前使用较多

搭建步骤:

- 安装必要的库:安装Flask和ChatterBot。

- 编写代码:创建一个Flask应用,集成ChatterBot并训练模型。

- 创建前端界面:使用HTML和JavaScript创建一个简单的聊天界面

- 部署应用:将应用部署到服务器,如Heroku或本地服务器。

5.3 基于大预言模型的集成

如果你希望使用更强大语言模型(如DeepSeek或QWen),可以通过本地部署或云服务快速搭建聊天机器人。

适合有一定技术能力的企业,需要高度定制化功能的聊天机器人。

适合大模型出来后有更好对话效果场景,目前企业纷纷采用方式。

搭建步骤:

- 部署模型:使用Ollama部署QWen或DeepSeek。

- 配置机器人:通过Ollama的API配置聊天机器人,设置模型、对话历史等参数。

- 接入微信或其他平台:使用Gewcchat框架将机器人接入微信。

5.4 搭建聊天机器人3种方式区别

- 如果需求简单且希望快速上线,优先选择无代码平台。

- 如果需求复杂,需要高度定制化功能,建议选择开源框架。

- 如果需要高质量的对话体验且预算充足,可以选择基于大语言模型的集成。

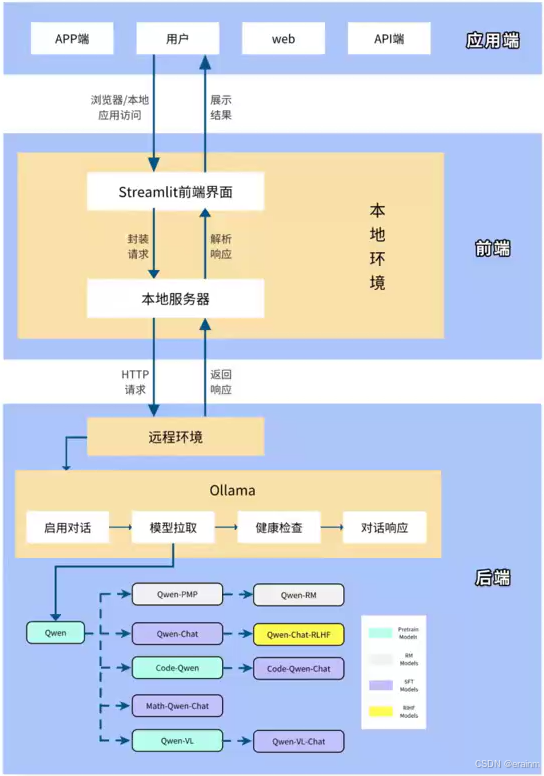

6. 聊天机器人架构

前端界面:Streamlit框架

- 特点:使用Streamlit框架搭建用户界面,提供简洁、交互式的Web应用。

- 技术细节:

◦ Streamlit是一个基于Python的开源框架,适合快速开发数据科学和机器学习相关的Web应用。

◦ 你通过Streamlit创建了一个用户界面,包括输入框、发送按钮和对话展示区域。

◦ 用户可以通过网页与聊天机器人进行实时对话。

后端模型:Ollama平台的Qwen/DeepSeek模型

- 特点:基于Ollama平台部署Qwen, DeepSeek模型作为后端核心,提供自然语言处理和对话生成能力。

- 技术细节:

◦ Ollama是一个开源的AI模型部署平台,支持多种大语言模型(LLM)。

◦ Qwen是一个高性能的语言模型,能够处理和生成自然语言文本。

◦ 通过后端服务调用Qwen模型,将用户输入传递给模型,并获取模型的回复。

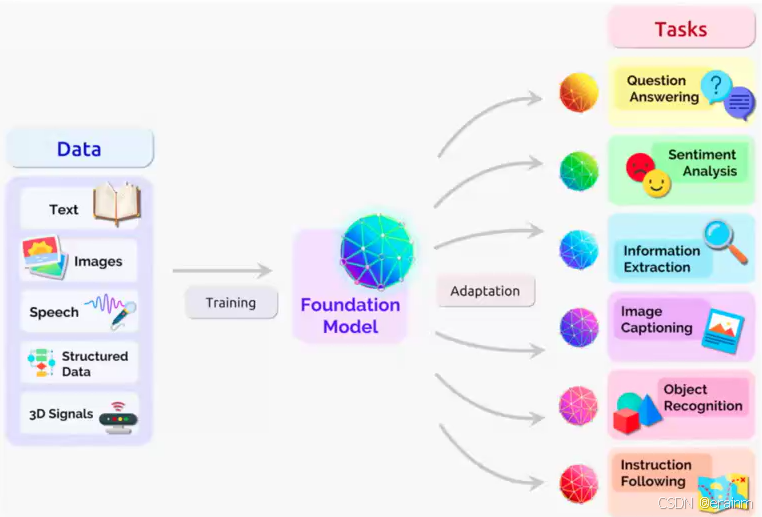

二、 大模型简介

1. 大模型分类

大模型分类方式多样,涵盖了从框架、应用场景到训练目的等多个维度。选择合适的大模型需要综合考虑任务需求、数据规模、计算资源等因素。

常见有:

- 自然语言处理模型

- 计算机视觉(CV)模型

- 语音模型

- 多态模型

1.1 自然语言处理模型

自然语言大模型(Large Language Models, LLMs)是基于深度学习的模型,旨在理解和生成人类语言。它们通过大规模文本数据的训练,能够执行多种自然语言处理(NLP)任务,如专注于文本生成、理解、翻译等任务。

举例:GPT系列(OpenAI)、BERT(Google)、T5(Google)

1.2 计算机视觉(CV)模型

视觉大模型(Large Visual Models)核心是通过大规模数据和复杂模型架构,实现对图像和视频的深度理解和生成。与传统计算机视觉模型相比,视觉大模型具有更强的泛化能力和多任务适应性,能够处理复杂的视觉任务,如图像分类、目标检测、语义分割、图像生成等。

举例:Stable Diffusion、Vision Transformers(ViT)、DALL·E(OpenAI)、CLIP(OpenAI)

1.3 语音大模型

语音大模型是基于深度学习技术构建的人工智能模型,主要用于处理语音相关的任务,如语音识别(ASR)、语音合成(TTS)、语音翻译等。近年来,随着深度学习和大规模数据训练的发展,语音大模型在性能和功能上取得了显著进展,能够支持多语言、多场景的复杂任务。

举例:Whisper(OpenAI)、WaveNet(DeepMind)、讯飞星火

1.4 多模态模型

多模态模型是一种能够同时处理多种数据模态(如文本、图像、音频、视频等)的人工智能模型。它的核心在于跨模态融合,即将不同模态的数据表示映射到同一空间,以便模型能够理解和生成跨模态的内容。

举例:GPT-4(支持多模态)、Flamingo(DeepMind)、BLIP、KOSMOS(微软)

2. 大模型应用场景

- 智能客服与对话系统:用于构建聊天机器人、虚拟助手,提供24*7的客户支持。目前大模型最广泛应用。

- 文本生成:生成文章、故事、代码、营销文案等。

- 机器翻译:实现多语言之间的高质量翻译。

- 问答系统:提供精准的问答服务,如技术支持。

- 图像分类与识别:识别图像中的物体、场景或人脸。

- 目标检测与跟踪:用于自动驾驶、安防监控等场景。

3. 私有大模型部署

为什么需要私有大模型部署:

- 定制化与自主控制:允许高度定制和完全自主控制,灵活性更高,且不依赖外部网络,适合特定场景需求;

- 性能与延迟:减少数据传输时间,提供低延迟和稳定性能,适合需要实时响应的应用场景;

- 数据隐私与安全:确保敏感数据不离开内部网络,避免云服务可能带来的数据泄露风险,尤其适合有严格合规要求的行业;

- 成本控制:长期来看,本地部署可能比持续支付云服务费用更经济,且允许根据需求灵活调整硬件资源.

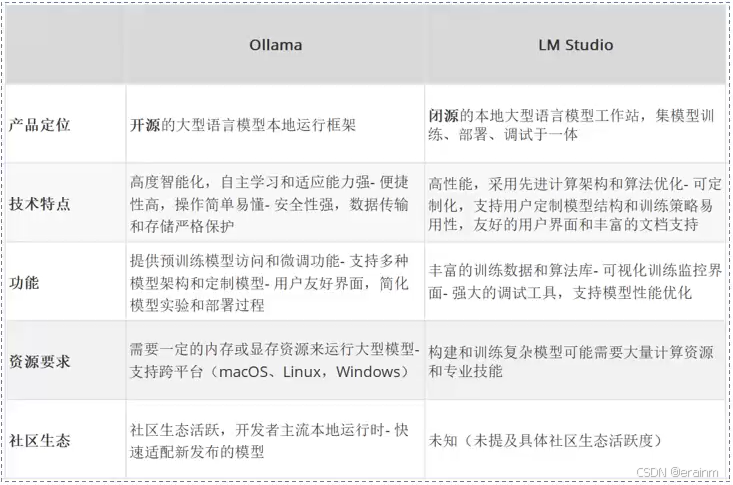

4. 私有大模型解决方案

随着AI的发展,越来越多的开发者投入到大模型开发中,他们期望能自身笔记本上运行大模型,以便开发。

越来越多的企业积极改造自身产品,融入AI技术,他们期望能私有化大模型以保证数据安全。这些诉求直接推动社区出现了两个这方面的产品Ollama和LMstudio。

三、 Ollama

1. Ollama介绍

ollama:是一款旨在简化大型语言模型本地部署和运行过程的开源软件。

ollama提供了一个轻量级、易于扩展的框架,让开发者能够在本地机器上轻松构建和管理LLMs(大型语言模型)

通过ollama,开发者可以导入和定制自己的模型,无需关注复杂的底层实现细节。

网址:ollama官网

2. Ollama特点

- 简单易用:提供命令行工具和API,支持快速本地部署主流大语言模型(如Llama 2、Mistral等),适合开发者和研究人员快速上手。

- 高效轻量:占用资源少,支持GPU加速和量化技术,能够在本地高效运行,降低对计算资源的依赖。

- 灵活管理:支持通过Modelfile自定义模型参数,允许热加载和切换模型,并可从Hugging Face等平台导入自定义模型。

- 隐私安全:本地化部署确保数据不上传云端,适合对隐私和安全性要求高的场景,如医疗、金融等领域。

3. Ollama安装(Windows)

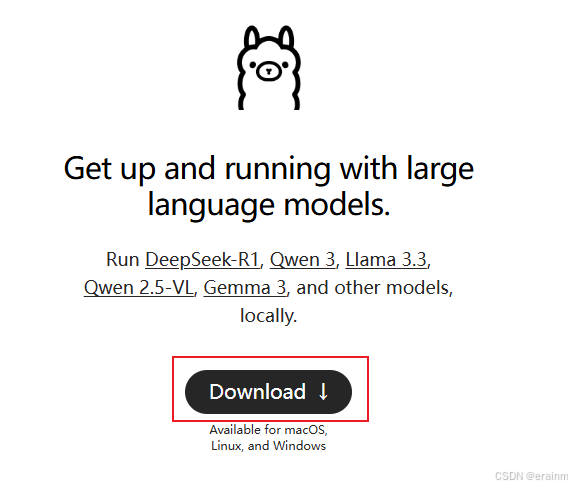

① 官网下载,打开ollama官网: ollama官网,直接点击Download下载

② 下载后直接双击安装

③ win + R 打开终端,输入cmd

④ 命令窗口输入:ollama -v,查看是否安装成功,成功则会显示ollama版本

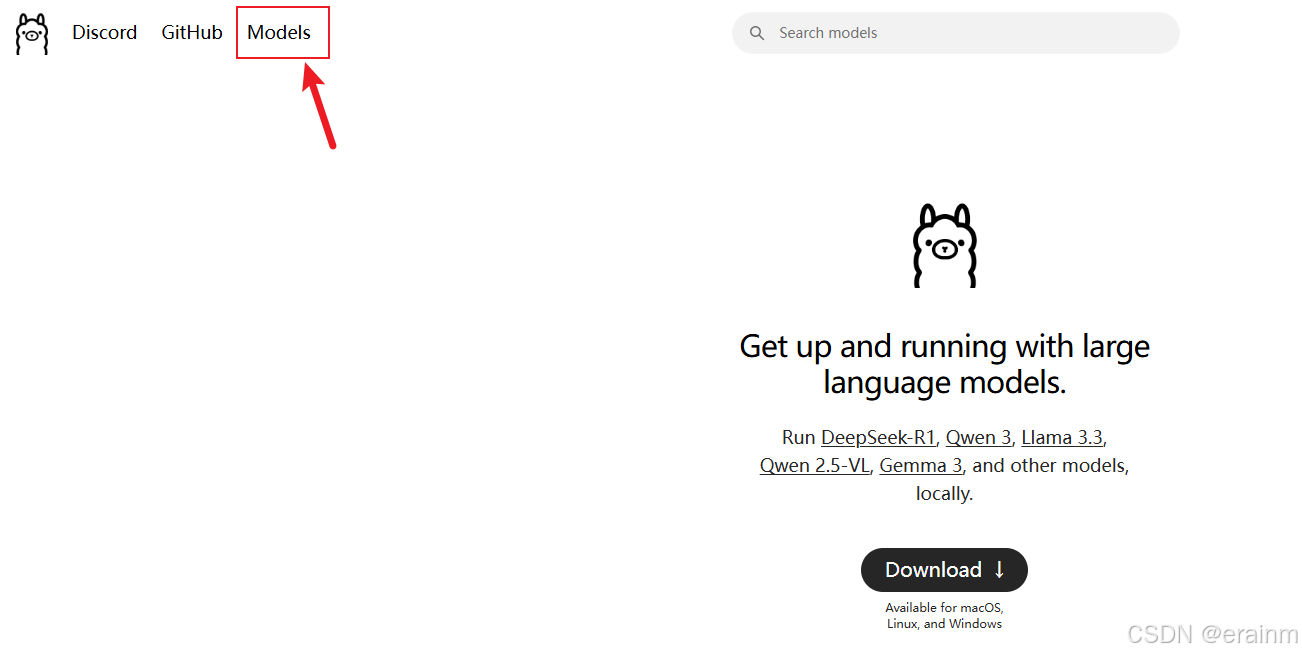

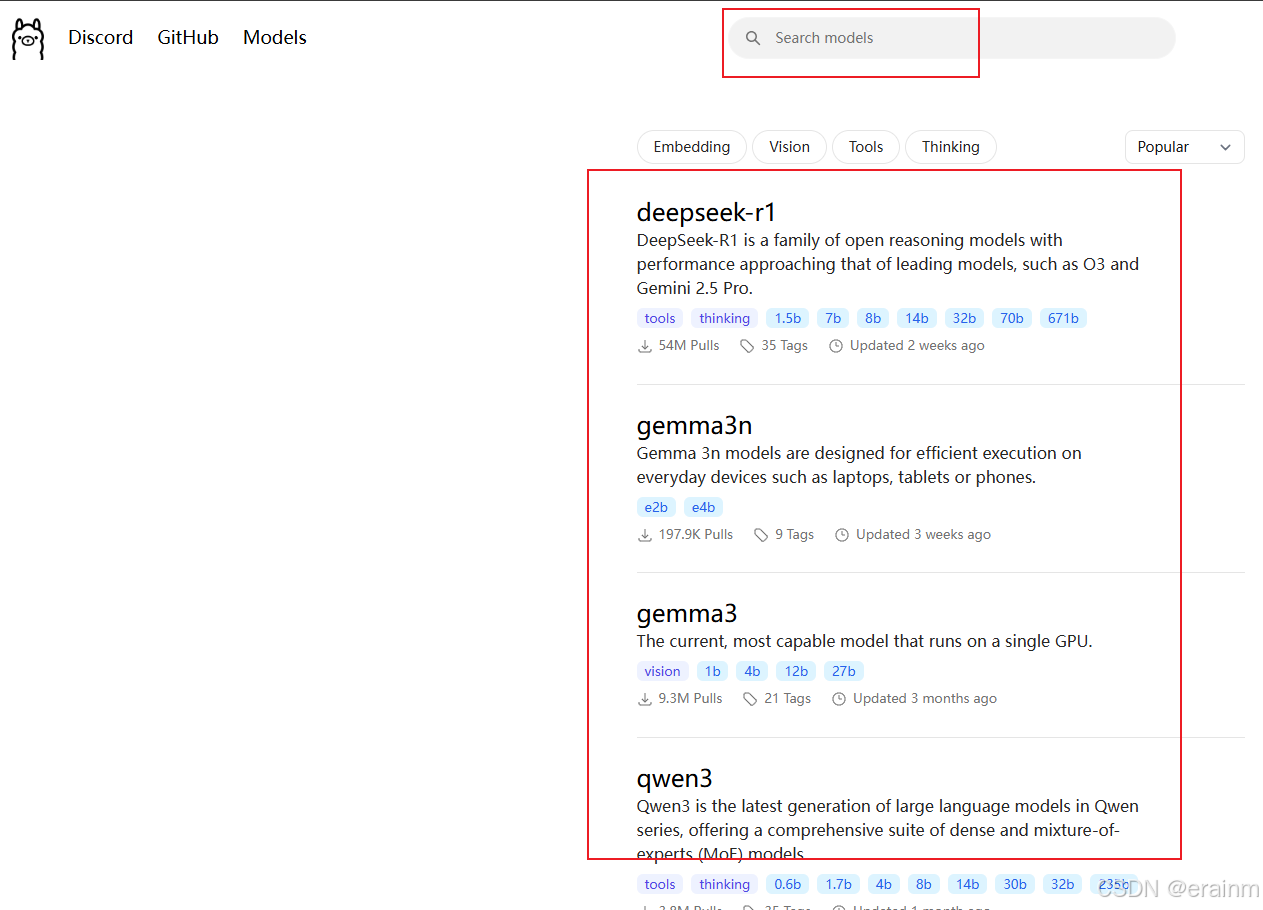

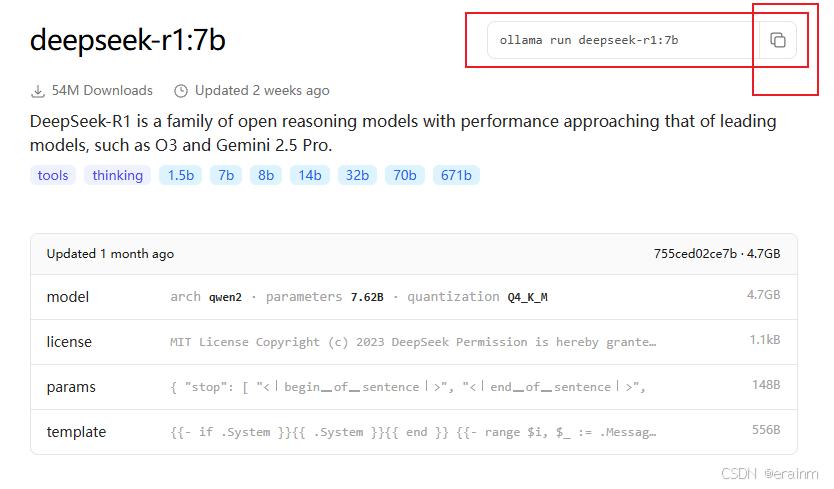

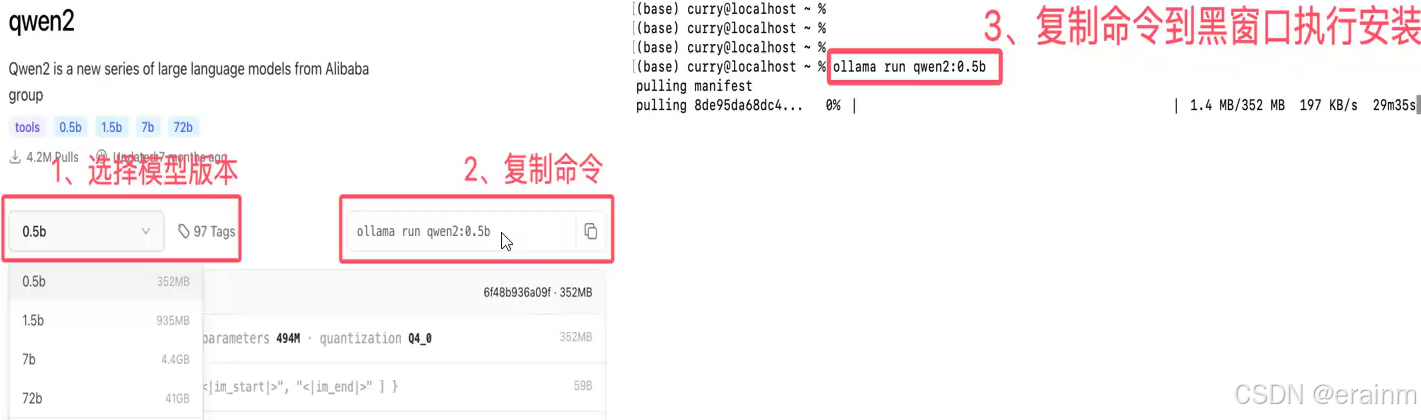

3.1 模型查找

3.2 使用模型

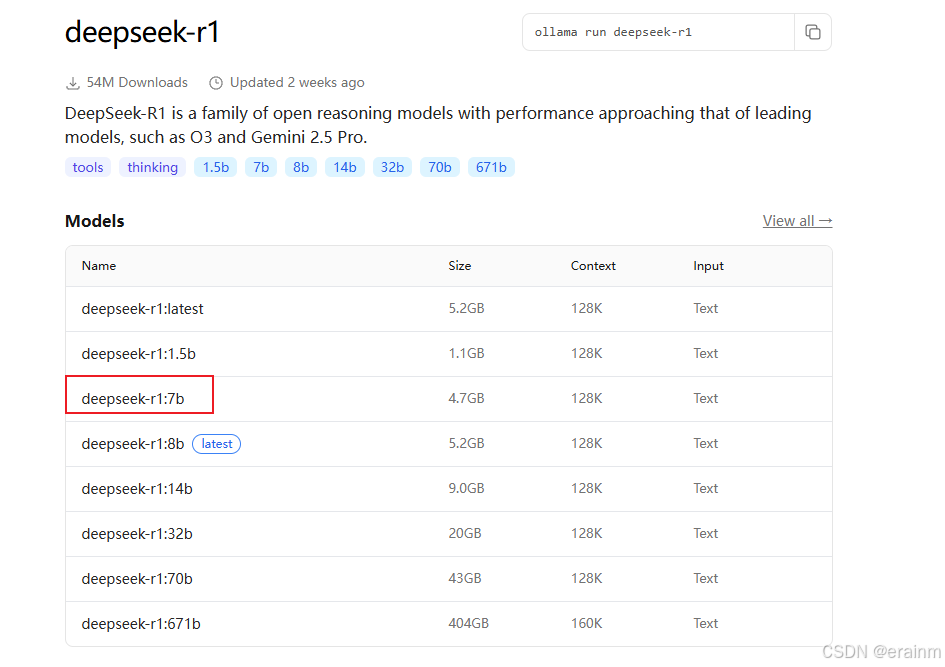

找到模型后,点击进入模型(选择具体模型点击进去)

复制命令

进入windows命令窗口,粘贴执行(首次需要下载模型,可能会慢,默认下载到C盘)

默认安装位置:C:\User\电脑名.ollama\models下

3.3 修改Ollama下载模型路径

- 创建新路径(假设F盘,F:\my_ollama_models)

- 按如下步骤新建ollama路径环境变量

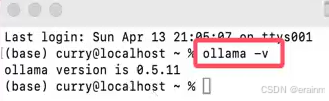

4. Ollama安装(Mac)

-

下载Mac版Ollama安装包,双击解压后,直接安装即可

-

打开终端,输入ollama -v命令,查看是否安装成功

-

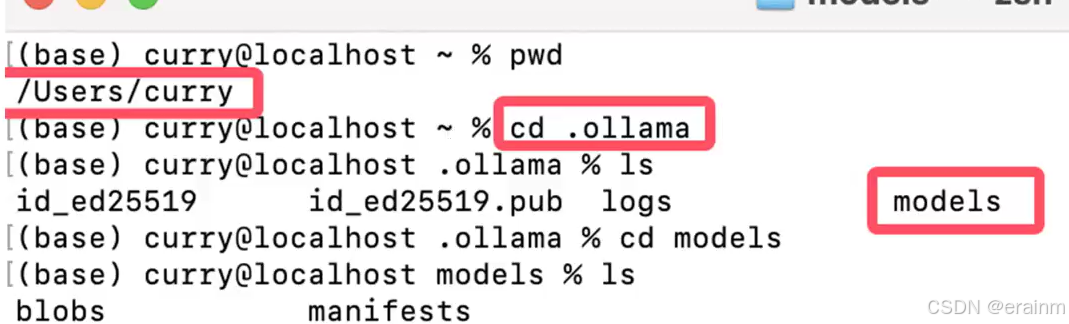

安装部署大模型

-

默认路径:~/.ollama/models

5. Ollama安装(Linux)

- 下载Linux版Ollama

- 客户端上传下载好的ollama-linux-amd64.tgz包到linux系统指定位置(假设:/root/resource)

- cd 进入 ollama包所在位置,使用tar解压到/user目录

cd /root/resource

tar -zxvf ollama-linux-amd64.tgz -C /user

- 解压后,查看Ollama版本,看是否安装成功

ollama -v

# 会有警告,后续再配置

- 执行vim命令,打开ollama.service文件,将以下内容复制进去

vim /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

[Install]

WantedBy=default.target

- 执行命令,让服务生效,并设置开机自启

# 修改后重新加载

[root@ ~]# systemctl daemon-reload

# 设置开机自启

[root@ ~]# systemctl enable ollama

# 重启ollama服务

[root@ ~]# systemctl start ollama

# 重新查看ollama版本,会正常展示

[root@ ~]# ollama -v

- 复制模型命令到linux中执行

[root@ ~]# ollama run deepseek-r1:7b

- Linux默认安装模型路径

/root/.ollama/models - linux系统开启ollama远程访问

- 添加环境变量

在etc/profile增加环境变量

# 添加以下配置

export OLLAMA_HOST=0.0.0.0:11434

export OLLAMA_ORIGINS=*

# 生效环境变量

[root@ ~]# source /etc/profile

- 添加服务变量

修改服务文件/etc/systemd/system/ollama.service

[root@ ~]# vim /etc/systemd/system/ollama.service

# 添加以下配置

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_ORIGINS=*"

[Install]

WantedBy=default.target

- 重新加载并重启服务

# 修改后重新加载

[root@ ~]# systemctl daemon-reload

# 重启ollama服务

[root@ ~]# systemctl start ollama

- 关闭防火墙

# 关闭防火墙

[root@ ~]# systemctl stop firewalld

6. Ollama指令详解

- run:运行模型

- show:显示模型信息

- pull:下载模型

- list:查看本地下载的模型

- ps:查看运行的模型

- cp:复制模型

- rm:删除mox

6.1 Ollama对话指令

基本指令:

- /? : 查看支持的指令

- /bye:退出对话

- /show:显示模型信息

- /? shortcuts:查看快捷键

- “”“”“” :多行输入指令

对话调整指令:

- /set:设置对话参数

- /clear:清理上下文

模型调整指令:

- /load:动态切换模型

- /save:存储模型

四、 基于工具调用本地模型

1. Apifox工具调用本地大模型

1.1 Apifox工具简介

Apifox是一款集API设计、开发、测试于一体的协作平台,旨在提升开发团队的API开发效率。它结合了Postman、Swagger、Mock.js等工具的功能,提供一体化的解决方案,适用于前端、后端和测试人员。

Apifox官网

官网直接下载安装即可

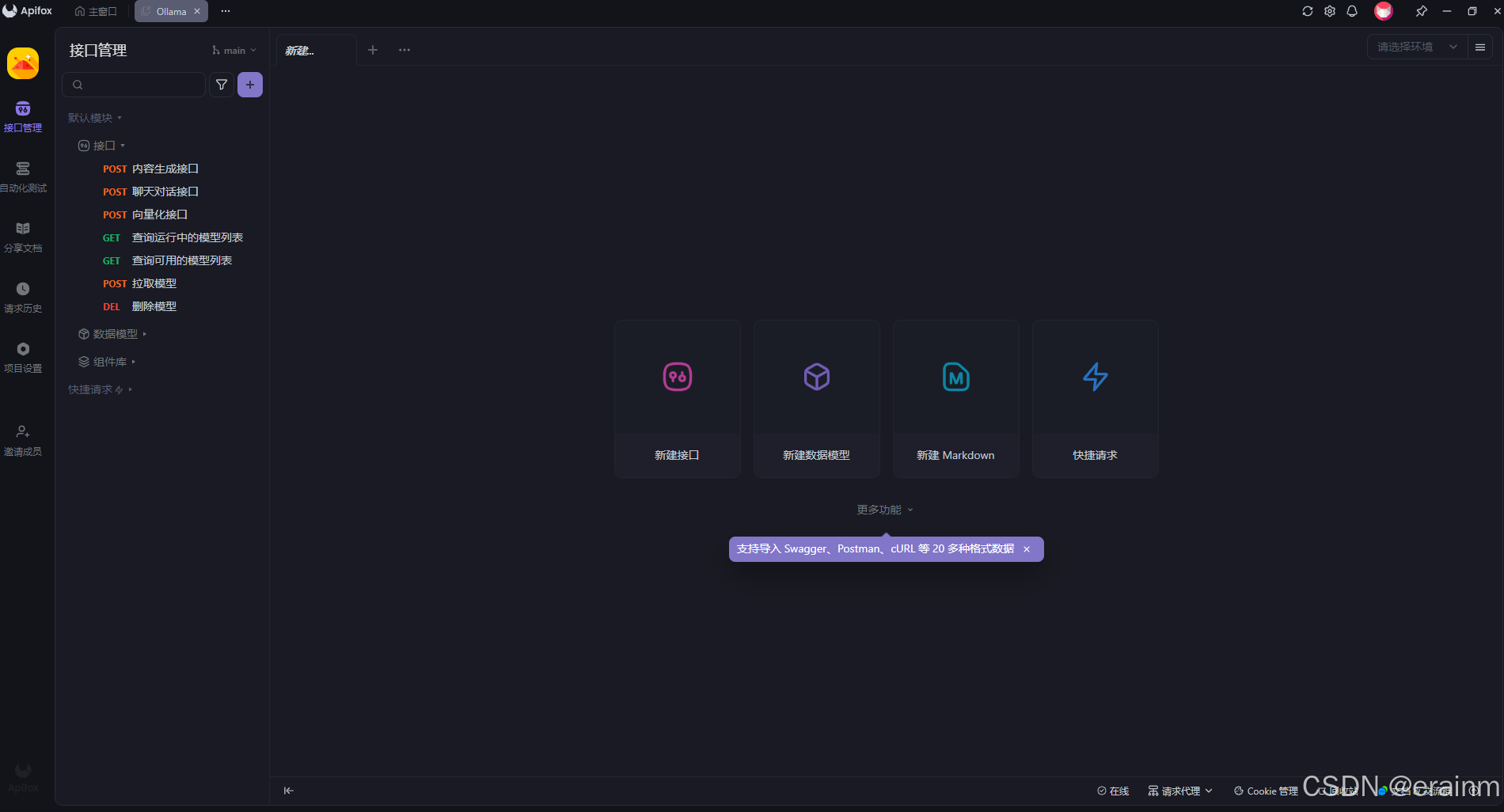

1.2 Apifox工具使用

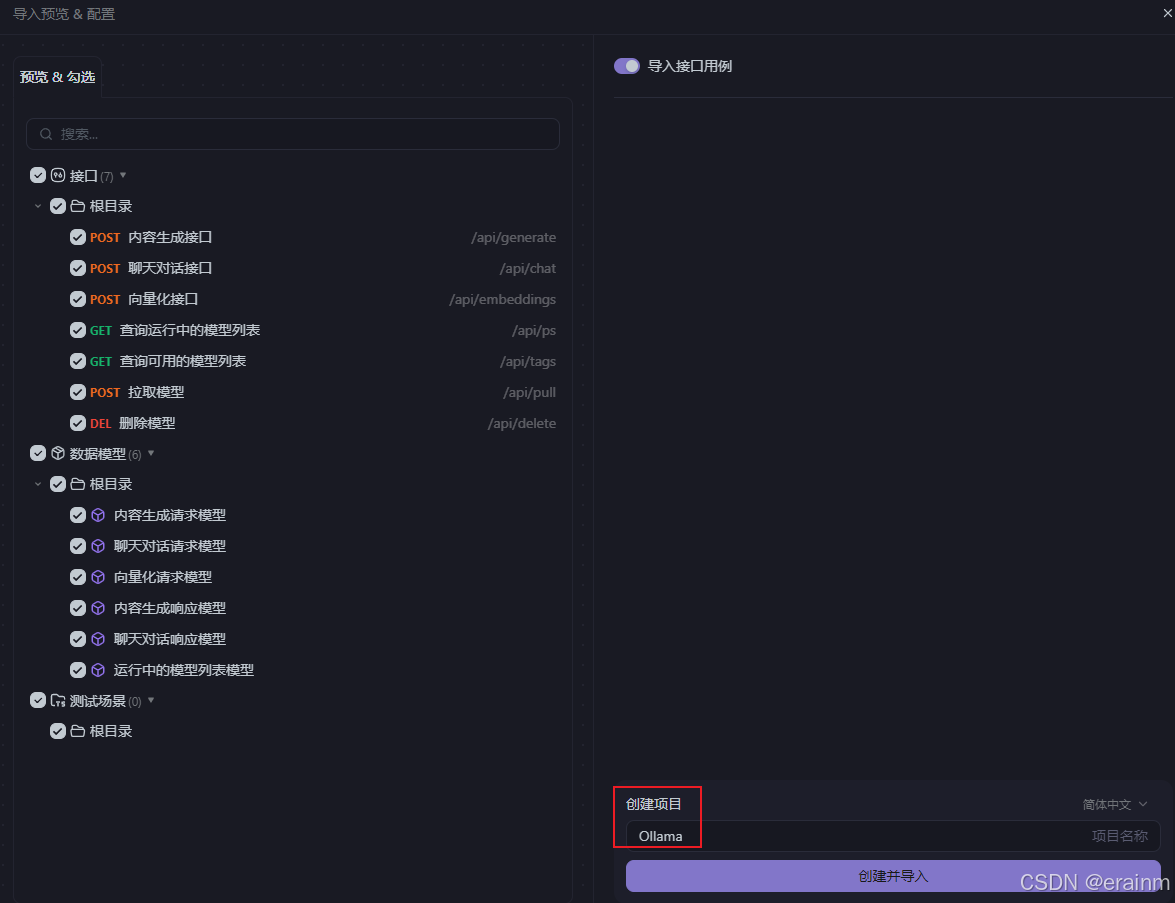

- 导入配置(也可以自己配置,我这里直接导入)

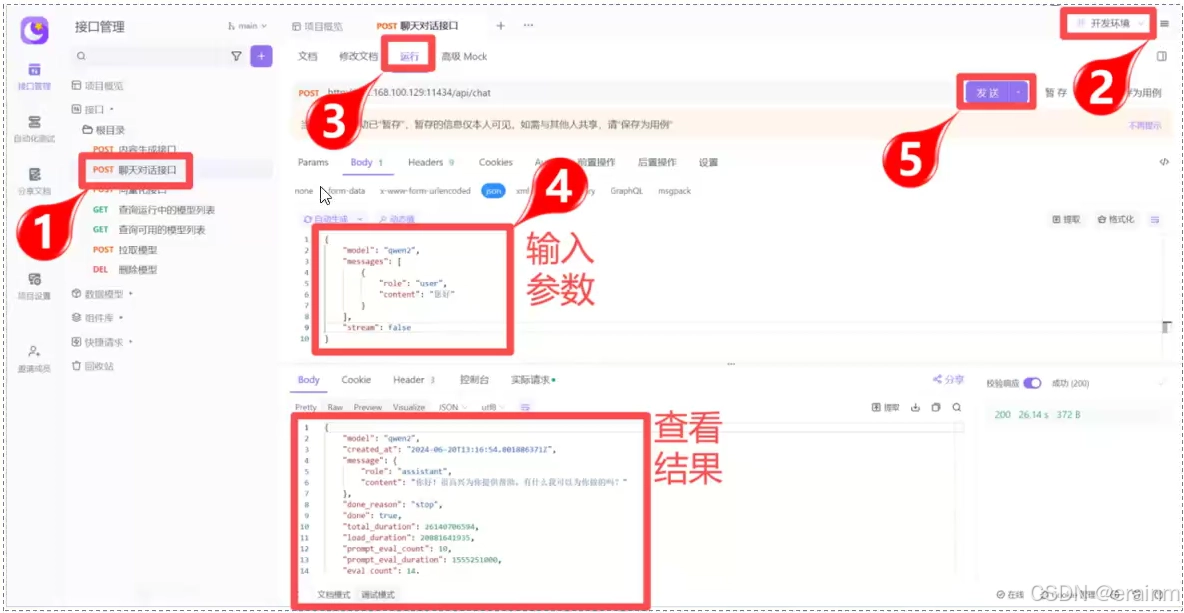

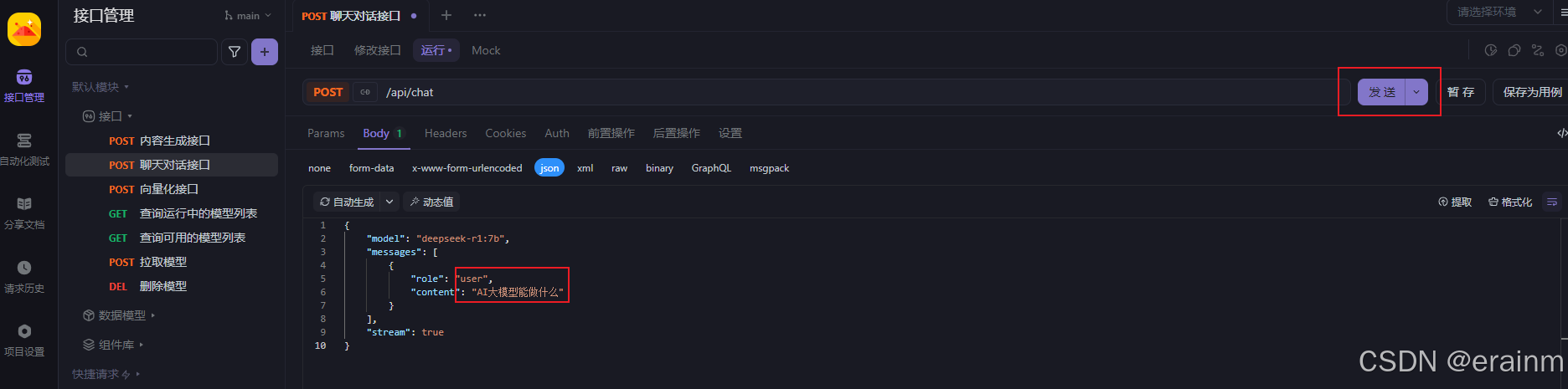

1.3 Apifox调用私有大模型

-

配置ollama大模型服务器地址

-

输入请求问题,发送,获取响应结果

2. Chatbox工具调用本地大模型

2.1 Chatbox简介

Chatbox是一款基于OpenAI API的开源跨平台智能对话工具,支持Windows、macOS和Linux系统。它旨在为用户提供便捷的AI对话体验,同时具备强大的功能扩展性和灵活性。

官网:Chatbox官网

Chatbox是一款功能强大、易于使用的开源AI工具,适合开发者、学生、办公人员等多种用户群体。

- 下载安装:访问Chatbox官网,下载并安装适合您操作系统的安装包(Windows、macOS或Linux)。

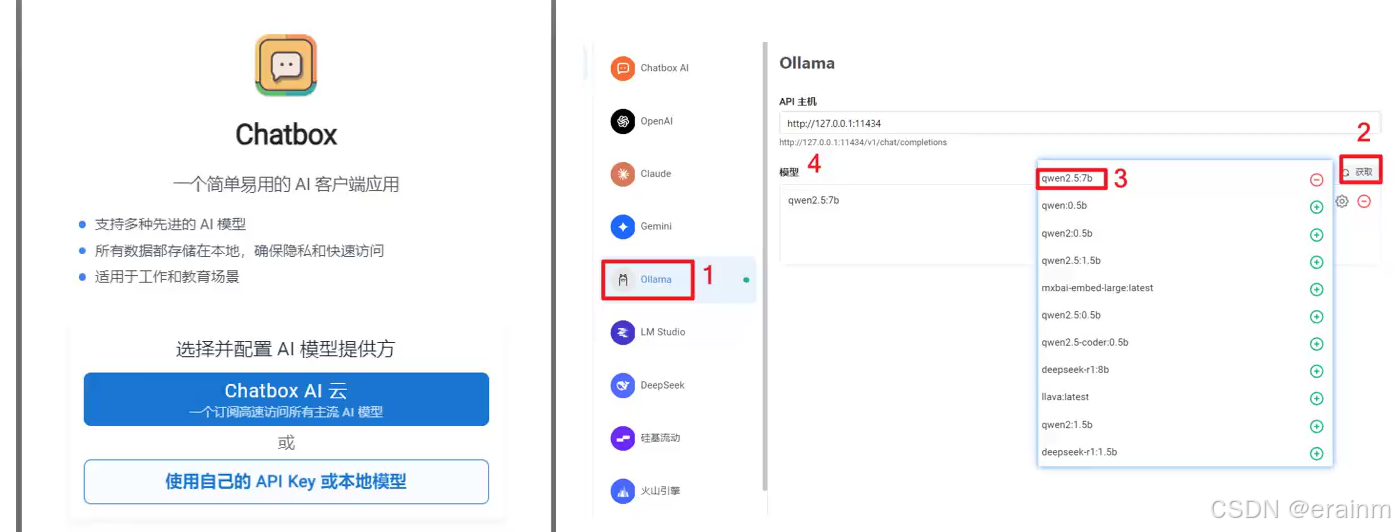

- 配置API:打开Chatbox,进入设置菜单。选择ollama中本地部署的模型,并保存配置。

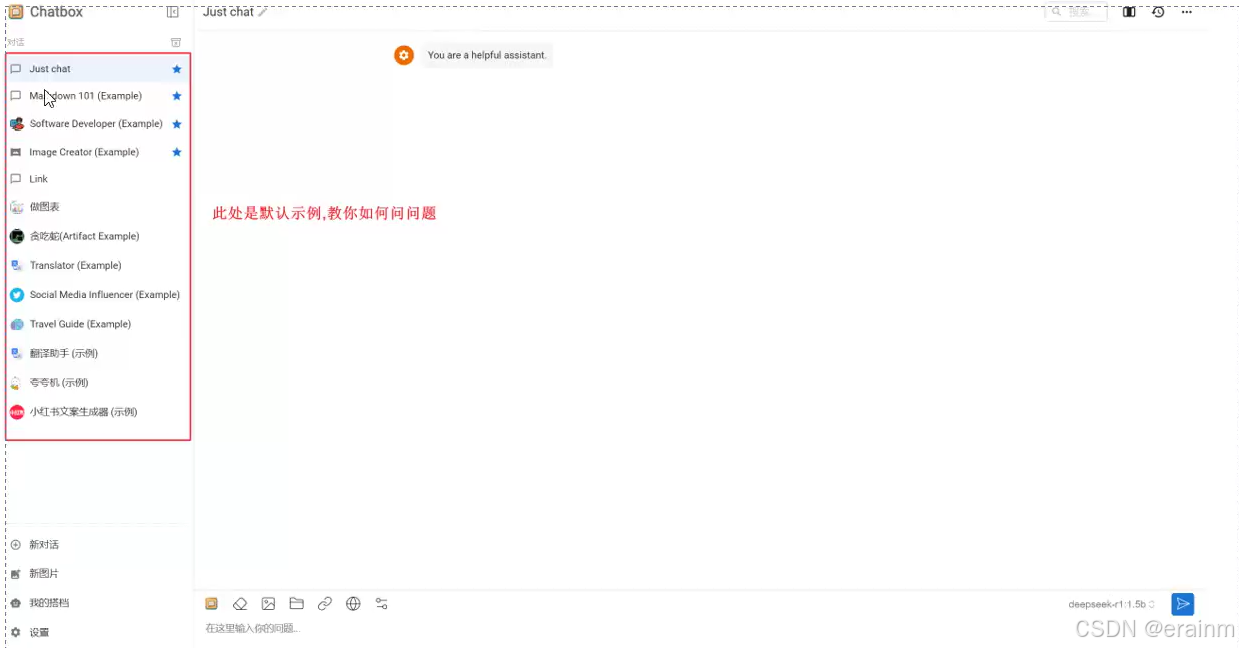

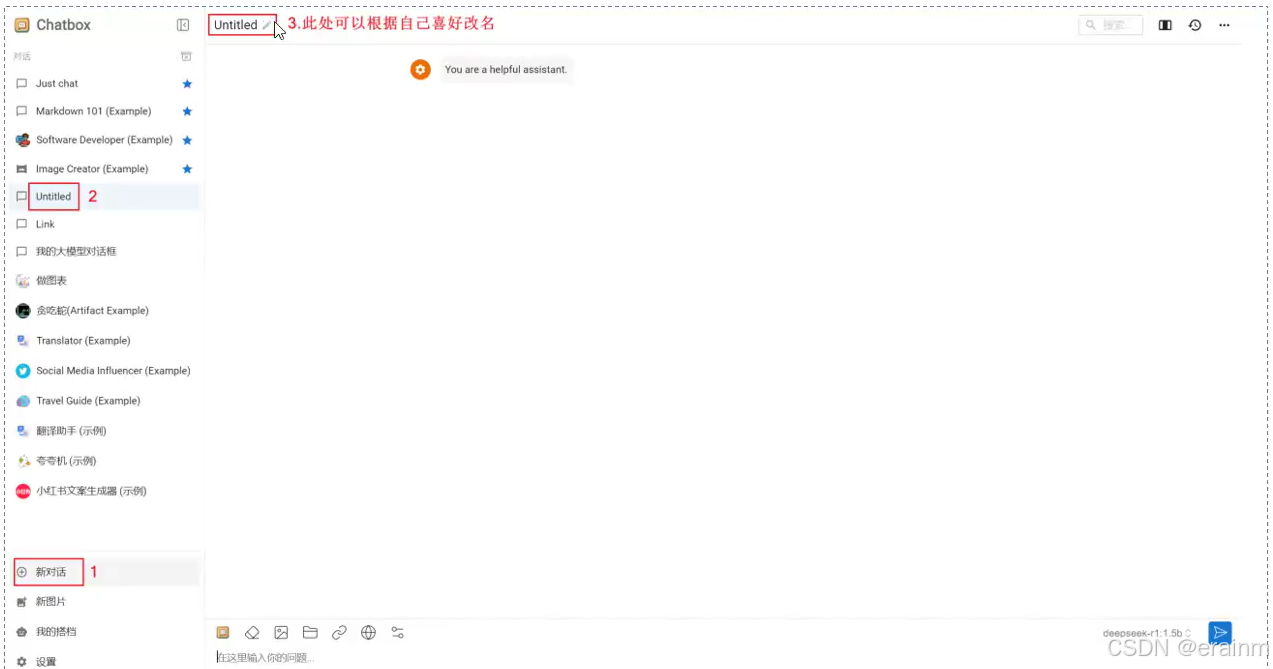

- 开始对话:主界面,创建对话窗口,在输入框中输入问题或指令。

- 保存和退出:聊天记录会自动保存到本地。

下载后直接安装。

2.2 Chatbox设置本地大模型

打开软件,选择ollama本地服务器中的大模型

2.3 Chatbox聊天机器人对话

266

266

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?